准备活动:需要scala和spark安装包

0.1-进入scala官网,找到all releases选项,点击进入

the scala programming language (scala-lang.org)

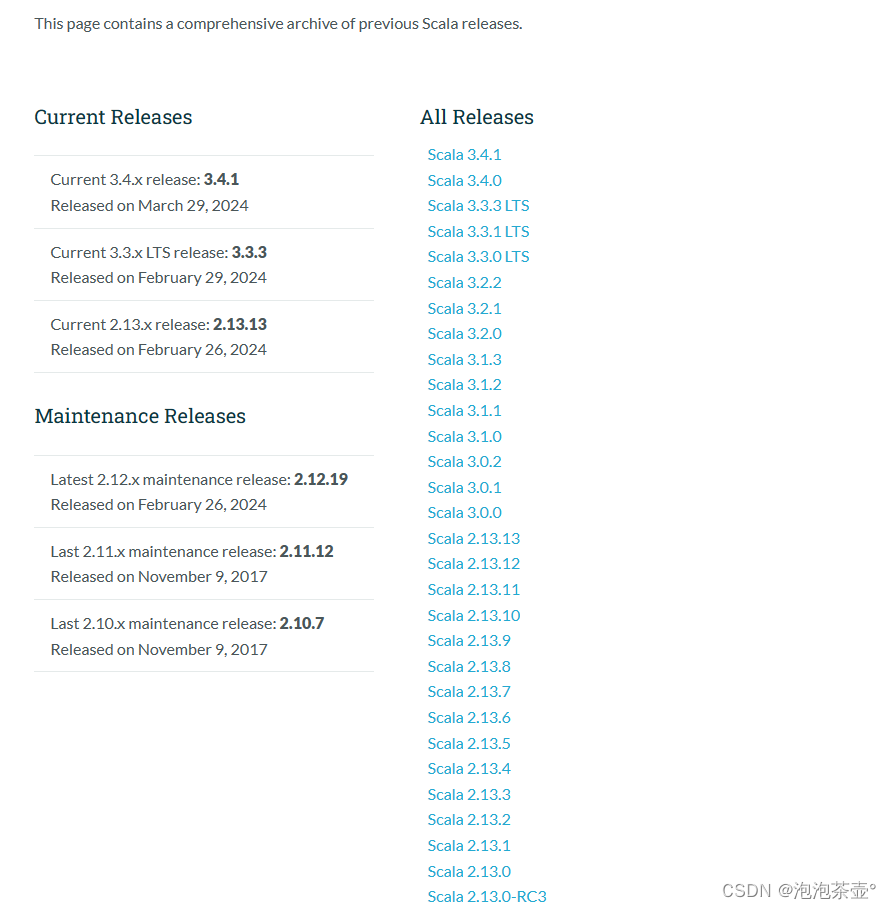

0.2-选择你需要的版本下载

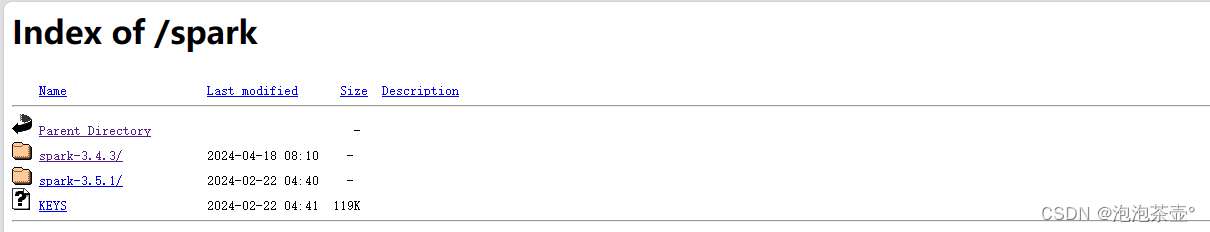

0.3-进入spark官网,下载你需要的版本

https://dlcdn.apache.org/spark/

准备活动完毕,系好安全带准备发车了!!!

scala安装教程

1.下载压缩包并解压到module文件夹

[root@master opt]# tar -zxvf /opt/software/scala-2.13.13.tgz -c /opt/module/

[root@master opt]# cd /opt/module/

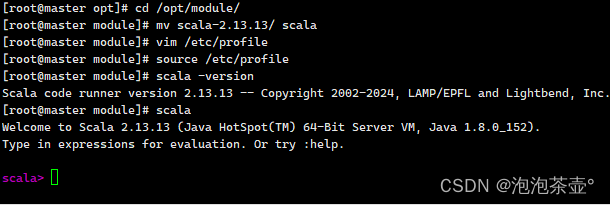

2.修改名字

[root@master module]# mv scala-2.13.13/ scala

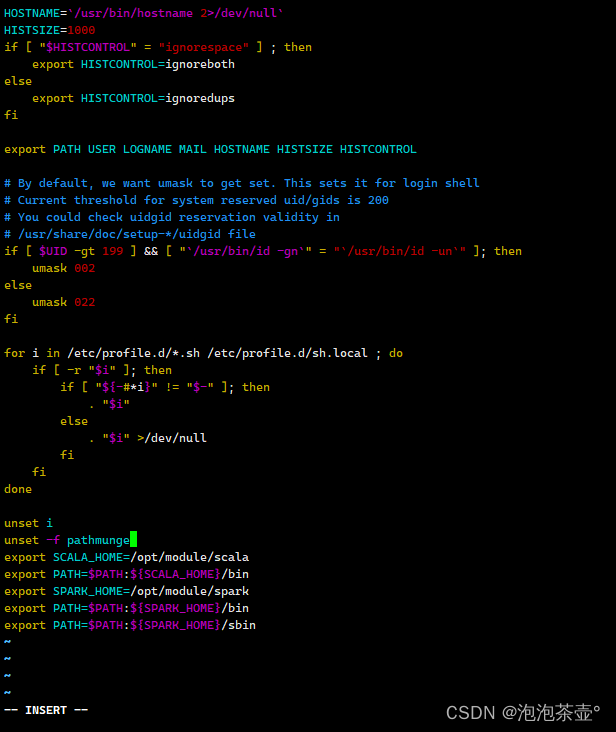

3.修改配置文件

[root@master module]# vim /etc/profile

在文档底部插入:

export scala_home=/opt/module/scala

export path=$path:${scala_home}/bin

4.验证配置

[root@master module]# source /etc/profile

5.查看scala版本

[root@master module]# scala -version

scala code runner version 2.13.13 -- copyright 2002-2024, lamp/epfl and lightbend, inc.

[root@master module]# scala

welcome to scala 2.13.13 (java hotspot(tm) 64-bit server vm, java 1.8.0_152).

type in expressions for evaluation. or try :help.

scala>

spark安装教程

**********注意安装包的解压路径*********

解压安装包

[root@master software]tar -zxvf spark-3.4.2-bin-hadoop3.2.tgz -c /opt/module/

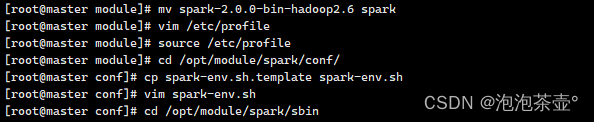

修改名字为spark

[root@master module]# mv spark-2.0.0-bin-hadoop2.6 spark

修改配置文件

[root@master module]# vim /etc/profile

在文档底部插入

export spark_home=/opt/module/spark

export path=$path:${spark_home}/bin

export path=$path:${spark_home}/sbin

验证配置文件

[root@master module]# source /etc/profile

进入目录备份文件

[root@master module]# cd /opt/module/spark/conf/

[root@master conf]# cp spark-env.sh.template spark-env.sh

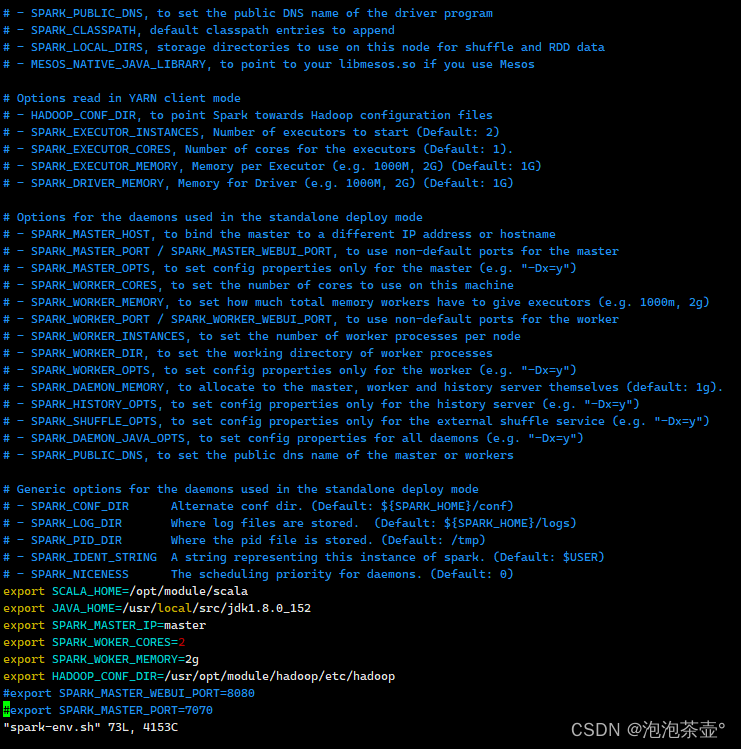

修改配置文件

**********注意java的安装路径*********

[root@master conf]# vim spark-env.sh

export scala_home=/opt/module/scala

export java_home=/usr/local/src

export spark_master_ip=master

export spark_woker_cores=2

export spark_woker_memory=2g

export hadoop_conf_dir=/usr/opt/module/hadoop/etc/hadoop

#export spark_master_webui_port=8080

#export spark_master_port=7070

[root@master conf]# cd /opt/module/spark/sbin

[root@master sbin]# ./start-all.sh

![]()

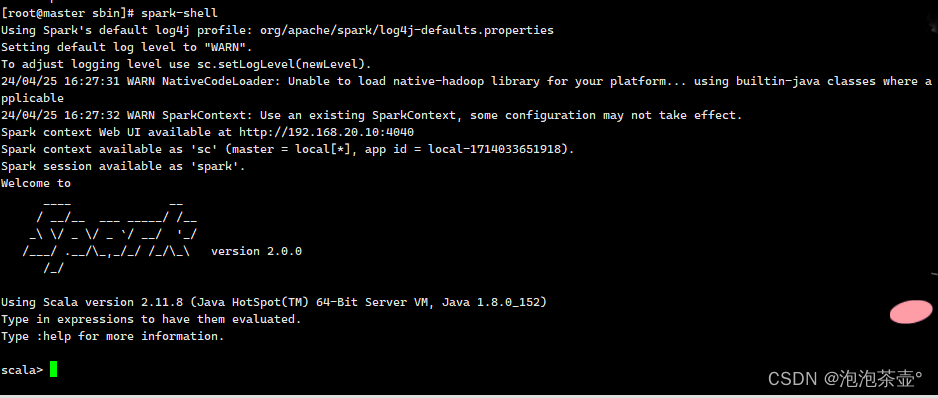

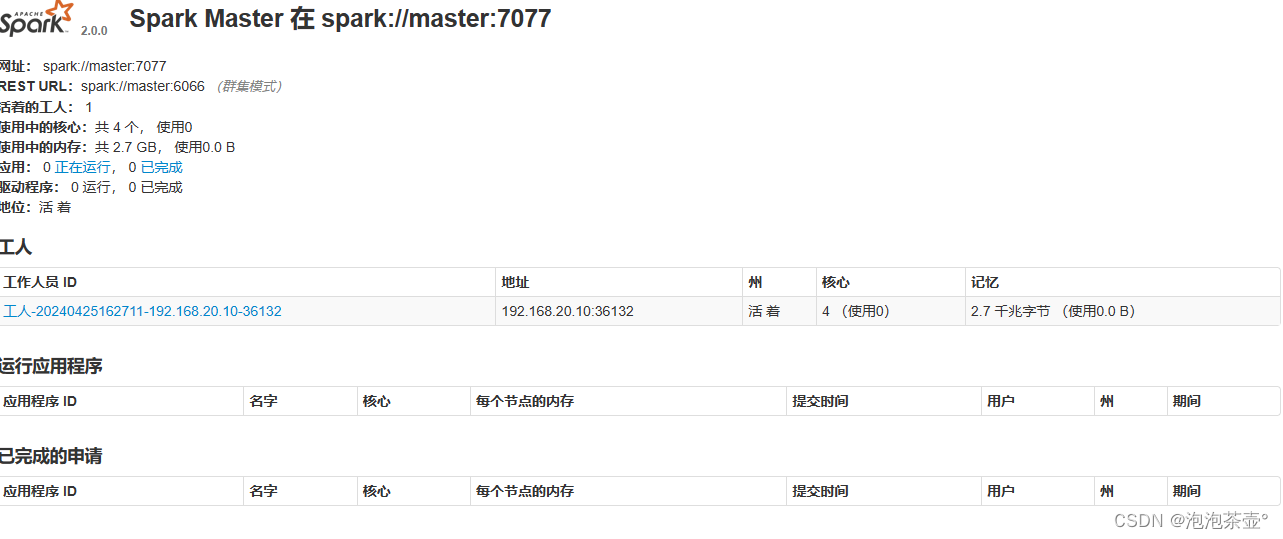

验证

完全验证

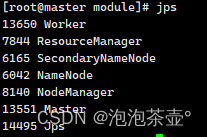

jps验证

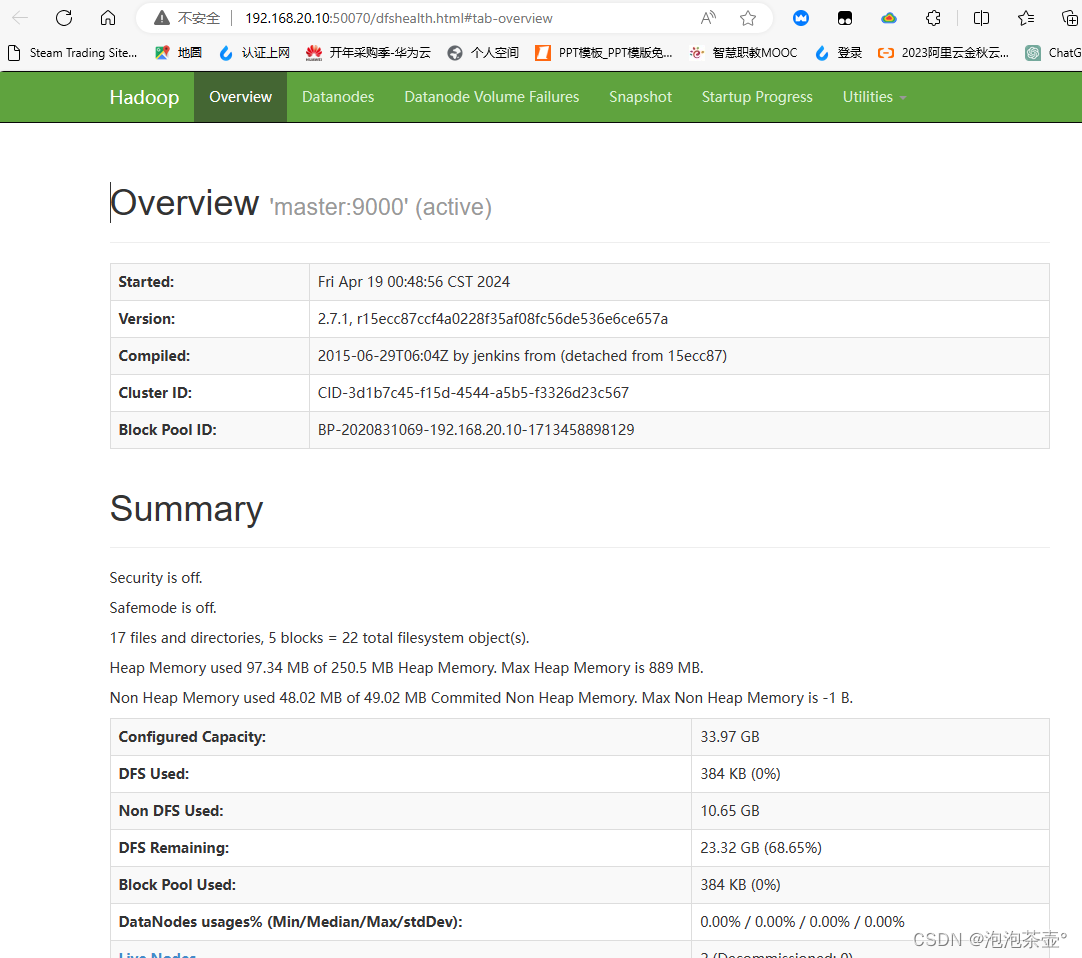

50070端口验证

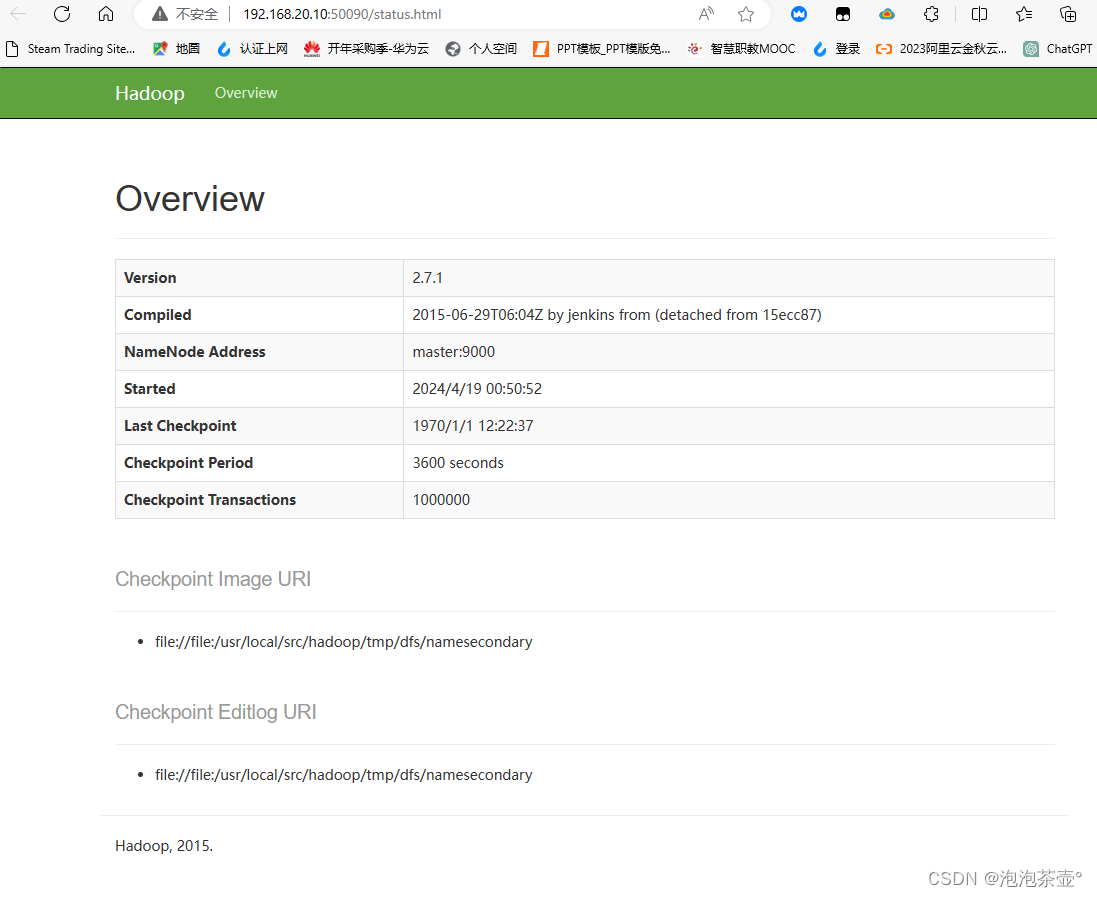

50090端口验证

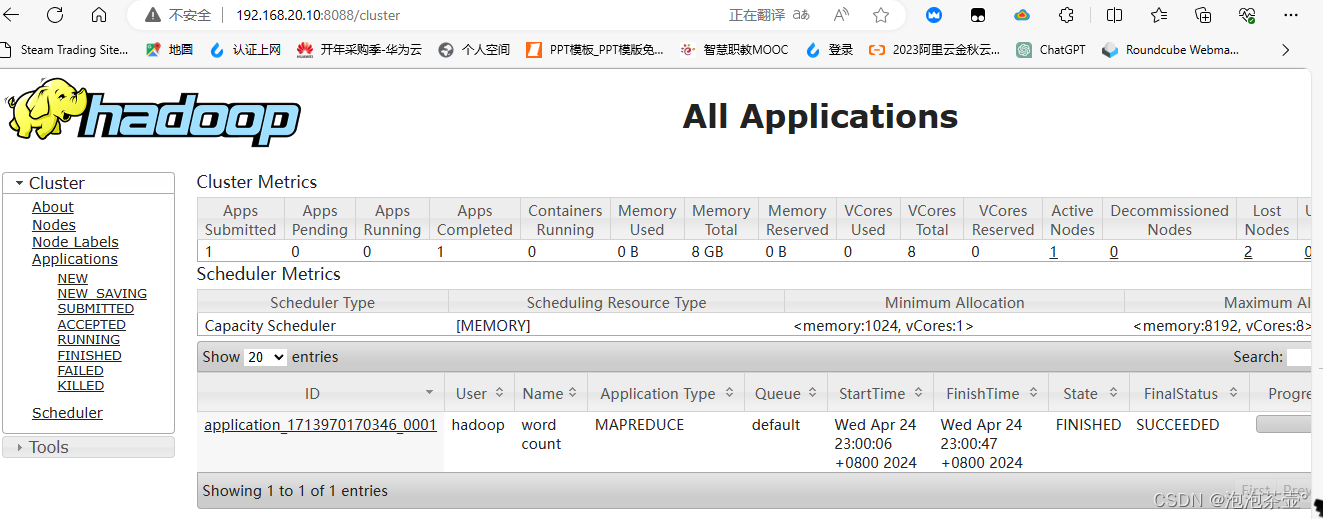

8088端口验证

spark :8080端口验证

发表评论