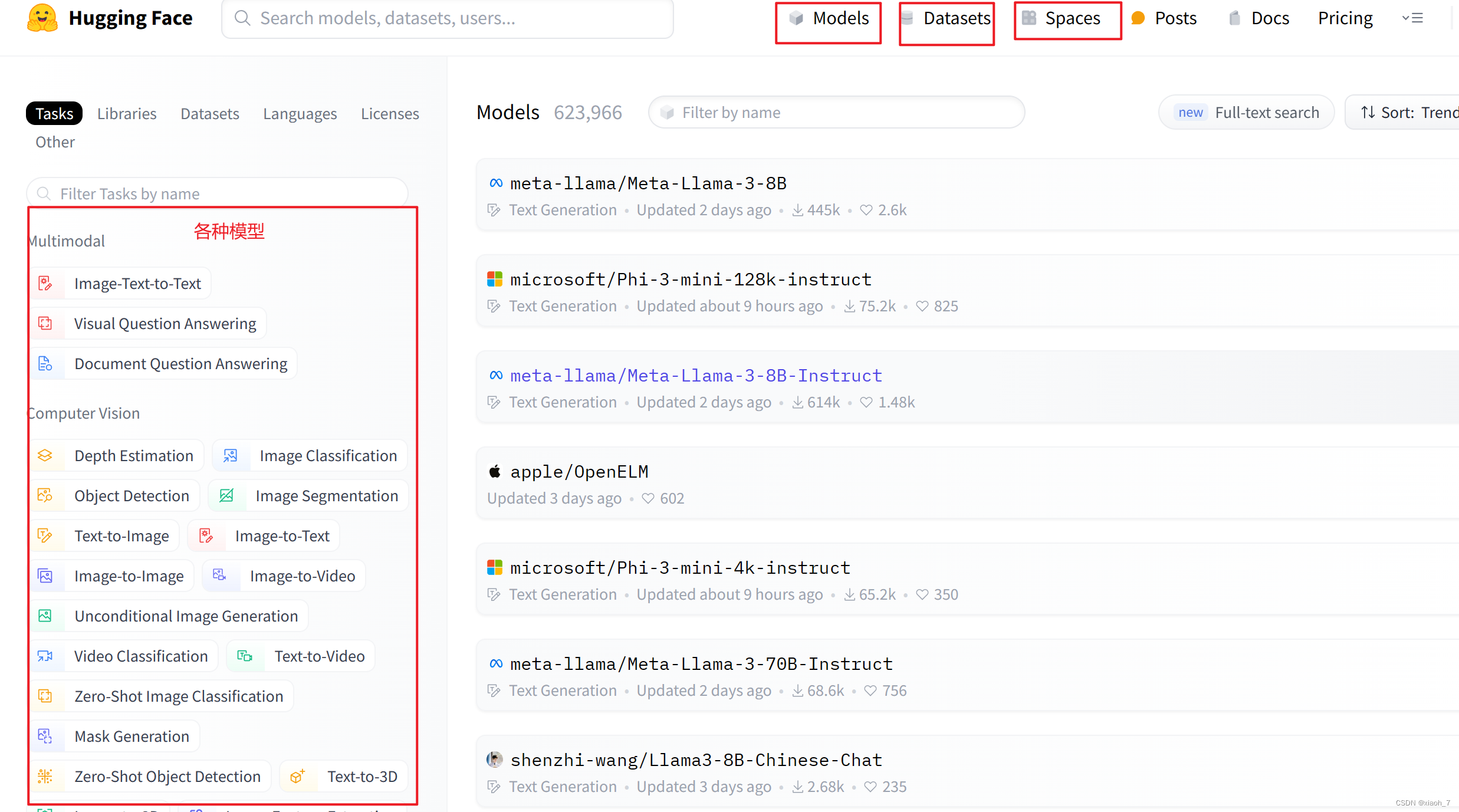

hugging face:自然语言处理的强大开源模型库

在数字化时代,自然语言处理(nlp)技术的崛起为人工智能的发展注入了新的活力。而hugging face,作为这一领域的佼佼者,凭借其强大的模型仓库、易用的api以及活跃的社区支持,成为无数nlp研究人员、开发者和爱好者的首选平台。

一、hugging face:nlp的瑞士军刀

hugging face,就像一把多功能的瑞士军刀,为nlp领域的研究者和实践者提供了丰富的工具与资源。无论是顶尖的transformer模型,还是各种实用的nlp数据集,你都能在这里找到。更重要的是,hugging face让这一切变得简单高效,让你能够轻松驾驭nlp的复杂世界。

二、为何hugging face如此受欢迎?

- 模型宝库: hugging face的模型仓库堪称nlp领域的“淘宝”,这里有bert、gpt、roberta等顶级transformer模型,它们经过大量数据的预训练,能够轻松应对各种nlp任务。

- 易用性至上: 使用hugging face的transformers库,你可以像操作玩具一样轻松加载和使用这些预训练模型。无论是文本生成、情感分析还是问答系统,都能轻松搞定。

- 社区力量大: hugging face拥有一个庞大的nlp社区,这里汇聚了来自世界各地的nlp爱好者。他们分享模型、代码和见解,共同推动着nlp技术的发展。

三、如何轻松拥抱hugging face?

- 网页一键下载: 打开hugging face的模型中心,搜索你需要的模型,点击下载即可。简单快捷,无需任何技术门槛。

- 命令行神器: 使用hugging face官方提供的命令行工具

huggingface-cli,你可以轻松下载和管理模型。只需几行命令,就能将顶级模型收入囊中。 - git clone高级玩法: 虽然这不是推荐的方法,但如果你对git操作比较熟悉,也可以尝试使用

git clone命令从仓库中下载模型。不过要注意,这种方法可能会占用较多磁盘空间,且不支持断点续传。

四、hugging face下载llama 3?

meta llama 3 是 meta ai在2024 年 4 月 18日 发布的。这是一款功能强大的开源大型语言模型,具有 8b 和 70b 两种参数版本。llama 3 在多项基准测试中表现出色,支持广泛的用例,包括推理和代码生成。此外,它还引入了分组查询注意力(gqa)并在超过** 15t 个标记的预训练数据**(超恐怖!!)上进行了训练。

以下载llama 3模型为例,以下是几种从hugging face(hf)平台下载模型到本地的方法:

方法一:使用hugging face的命令行工具huggingface-cli

-

首先,确保你已经安装了

huggingface_hub库。如果还没有安装,你可以使用以下命令安装:pip install -u huggingface_hub -

接下来,使用

huggingface-cli工具下载llama 3模型。模型的仓库地址通常可以在hugging face的模型页面上找到。以llama 3为例,运行以下命令:huggingface-cli download llama/llama-3这条命令会自动从hugging face的模型仓库中下载llama 3模型到本地。

方法二:通过浏览器网页下载

-

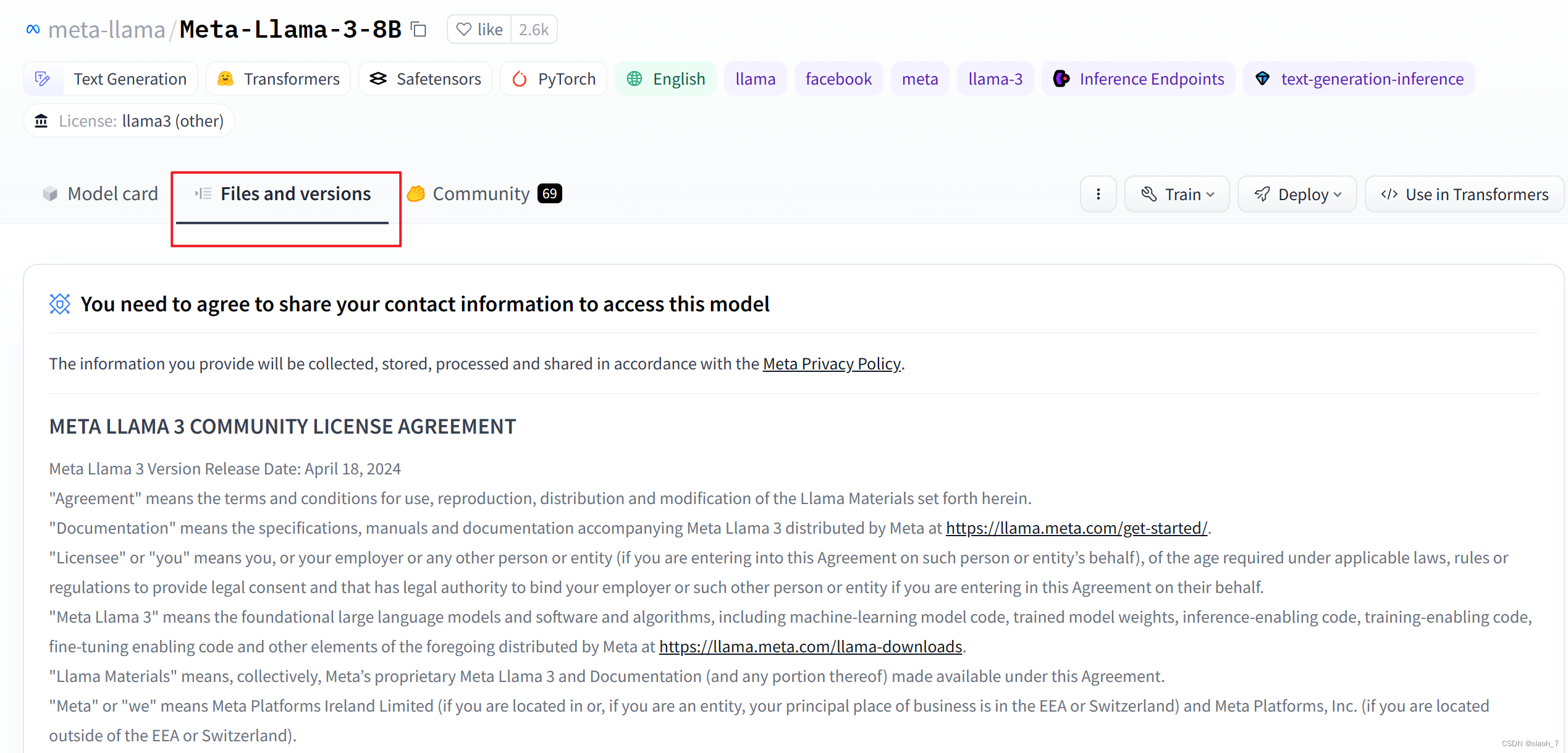

打开hugging face的官方网站,并导航到llama 3模型的页面。

也就是https://huggingface.co/meta-llama/meta-llama-3-8b/tree/main

-

在模型的页面上,找到“files and versions”部分。这里列出了模型的所有文件和相关版本。

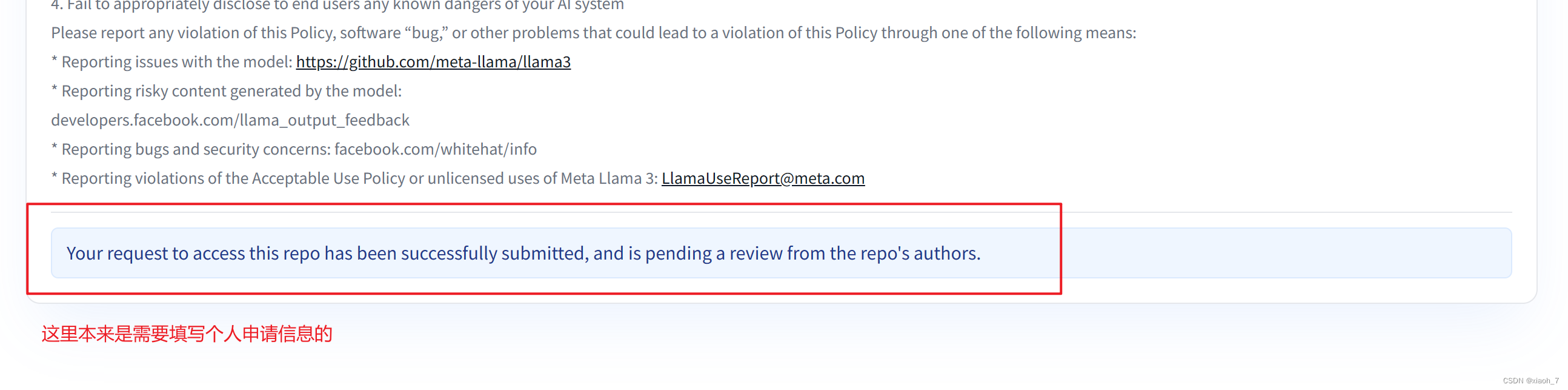

值得注意的是,由于meta的要求,需要先申请,申请方式也很简单,拉到最后,填写个人信息即可,然后等待邮件通知。

-

找到你需要的模型文件,点击下载按钮或者复制下载链接。如果使用下载按钮,浏览器通常会直接开始下载。如果选择复制链接,则可以使用你喜欢的下载工具或命令行工具进行下载。

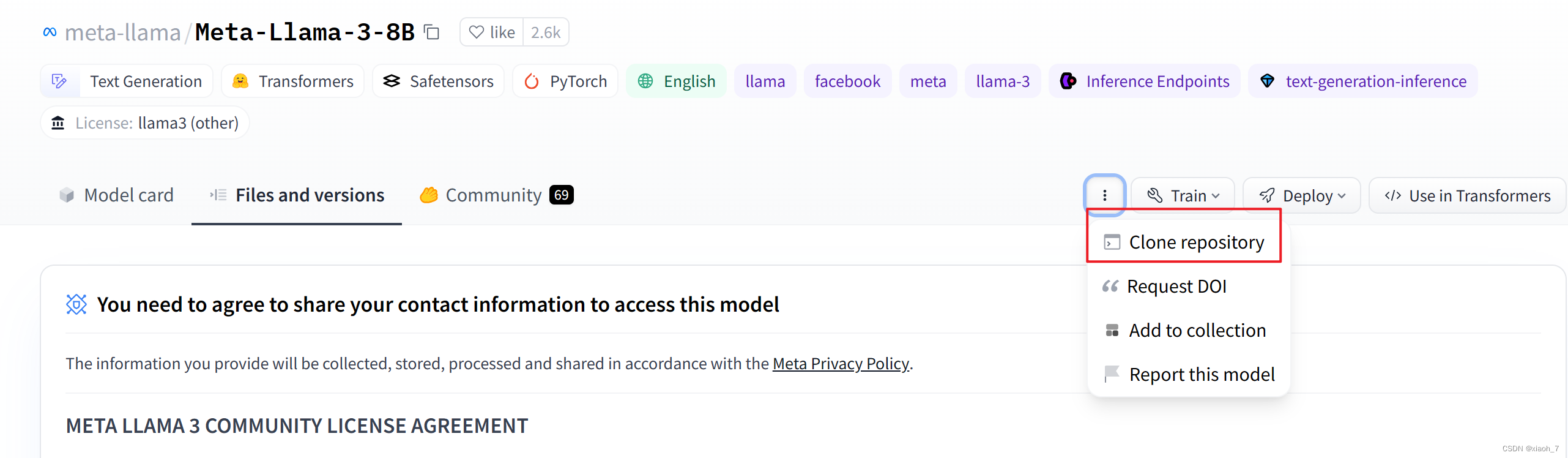

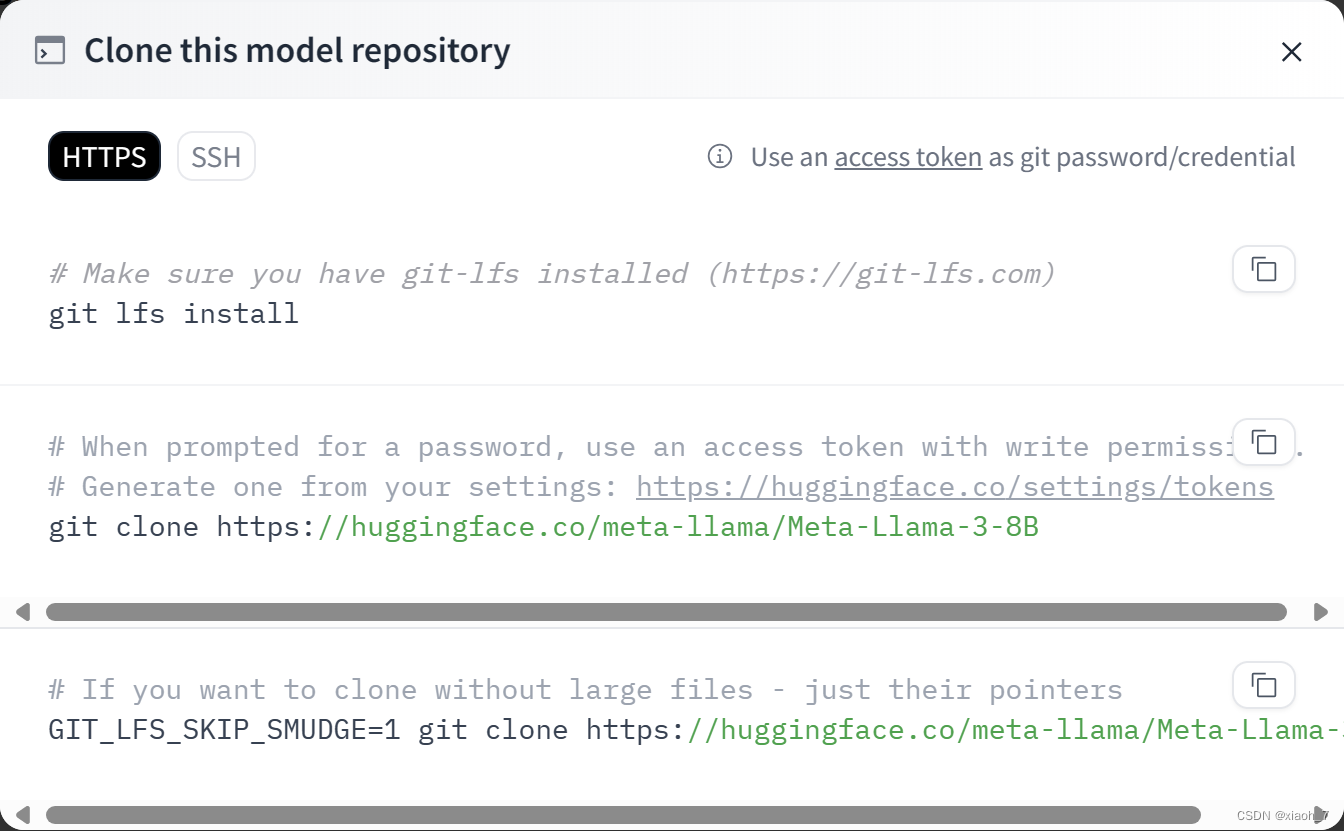

方法三:使用git下载

这个应该无需多介绍,在这里

无论你选择哪种方法,下载完成后,llama 3模型将保存在你指定的本地目录中,你可以使用hugging face的transformers库来加载和使用这个模型进行nlp任务。

五、结语

hugging face以其强大的模型仓库、易用的api和活跃的社区支持,成为了nlp领域的领军者。无论你是nlp的初学者还是资深专家,都能在这里找到你需要的一切。就像名字一样,拥抱!

版权声明

本博客内容仅供学习交流,转载请注明出处。

发表评论