华为npu 910b与nvidia gpu a100性能对比,从aicore到tensorcore,展现各自计算核心优势。

ai 2.0浪潮汹涌而来,若仍将其与区块链等量齐观,视作炒作泡沫,则将错失新时代的巨大机遇。现在,就是把握ai时代的关键时刻。

ai芯片作为ai热潮中的"掘金利器",备受瞩目。gartner预测,至2027年,其市场规模将飙升至1194亿美元,前景广阔。

英伟达,以80%的市场占有率雄踞算力之巅,其强势地位带来丰厚盈利。财报亮眼,市值更是一夜飙升2770亿美元,彰显其无可匹敌的市场影响力。

然而,美国实施的出口管制政策对英伟达在华业务造成了冲击,致其一季度h20芯片出口增长未达预期。但华为910b芯片订单成绩亮眼,呈现出强劲的市场需求。

英伟达ceo黄仁勋罕见发声,称华为为最大劲敌,其拥有丰富资源并自主设计软硬件提升ai算力。出口限制下,华为昇腾910系列ai芯片成为英伟达a100在中国市场的热门替代,自国企、通信商至互联网,昇腾芯片受到广泛采购,展现其卓越的市场影响力。

展望未来,随着sora、gpt-4o等多模态大模型的普及,计算资源需求将持续攀升。芯片设计需精准适配这些计算场景,并研发专用硬件加速器,以高效支持复杂模型的训练与应用,满足日益增长的计算需求。

揭秘ai芯片巨头对决!华为昇腾910b与nvidia a100硬件参数解析,一探华为npu与nvidia gpu在设计与应用中的实力较量,洞察各自优势与短板,为您的“淘金”之旅提供关键指引。

1. ai芯片硬件概述

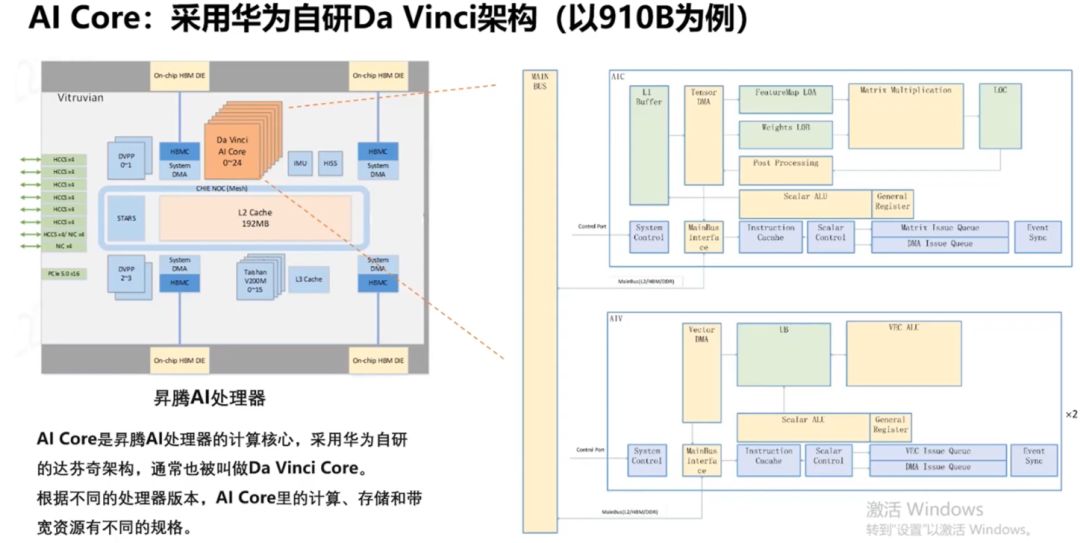

昇腾910b,华为顶尖ai处理器,专为推理与训练而生。搭载创新达芬奇架构与高效npu设计,昇腾910b展现卓越计算性能与能效比,为人工智能任务提供强大动力。

华为自研的910b ai处理器架构图亮相,集成25个ai core、4个hbm 2.0内存及ai cpu、dvpp模块、hccs链路等关键组件,配备先进缓存系统,展现强大ai处理能力。

910b的ai core是专为深度学习设计的计算核心,自诞生起便针对高性能计算需求进行优化,为深度学习领域提供强大支持与高度灵活性。

nvidia gpu起初深耕图形处理,后借tesla芯片之力转型gpgpu,实现通用计算,并不断提升ai计算能力,与华为npu发展轨迹迥异。

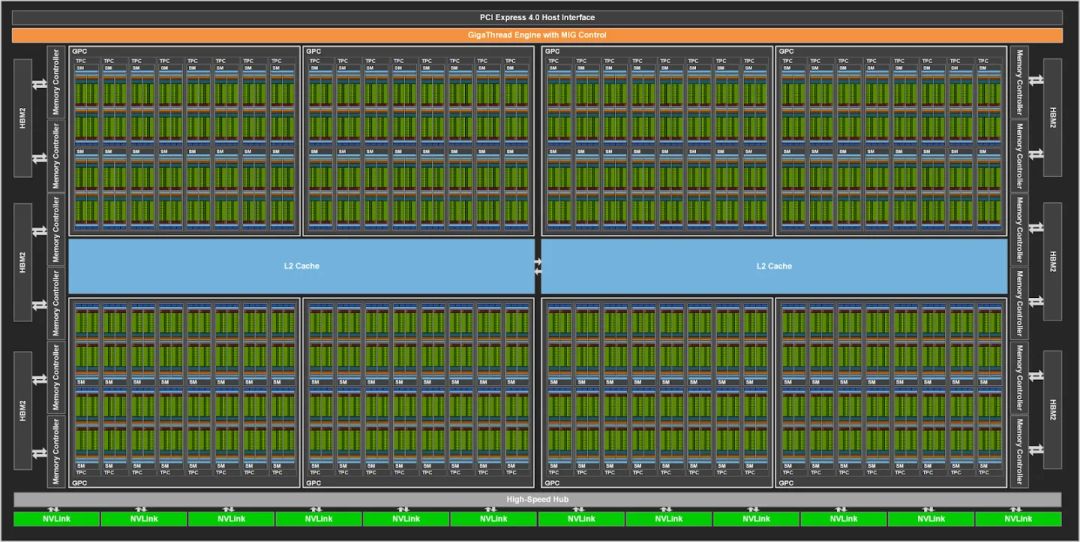

nvidia a100 gpu,ampere架构的巅峰之作,引领技术革新,加速迈向人工通用智能(agi)。这款gpu在图形处理、深度学习及高性能计算领域均展现卓越性能,成为ai研究与应用的关键动力,开启智能新时代。

a100全能应用版gpu内置128个sm,tensorcore版则拥有108个sm。每个sm配备丰富cuda核心和tensor核心,专为图形通用计算和ai张量计算设计,展现了出色的计算性能与效率。

a100 gpu搭载丰富的hbm2堆栈,结合第三代nvlink协议与第二代nvswitch技术,实现gpu间高速数据交换。其性能卓越,fp32性能较v100提升10倍,混合精度训练效能更增20倍。这些显著优势使a100 gpu成为ai领域进步的强大驱动力,引领行业迈向新高度。

英伟达gpu与华为npu,虽初衷各异,但在大模型时代,两者均为ai芯片翘楚,以其卓越的训练、推理计算性能与能效比,共同引领ai发展潮流。

如果你想了解华为910b和英伟达a100更详细的对比,可以参考这篇文章:

华为npu vs 英伟达gpu 架构原理和编程范式深度对比

2. 计算性能比较

华为910b npu的核心计算单元为ai core,共计25个,与gpu中的sm相似,但npu并行计算单元较gpu更为精简,展现其高效能、专业化的ai处理能力。

nvidia a100 tensorcore版gpu配备108个sm,而全功能版则高达128个,彰显gpu在并行计算单元领域的卓越性。更多sm赋予其强大并行计算能力,轻松应对复杂计算挑战,展现技术领先实力。

910b npu的每个aicore集成两大计算利器:2个ai vector向量计算单元与1个ai cube矩阵计算单元。前者媲美gpu中的cuda core,后者则与tensorcore相当,共同为高性能计算提供强大支撑。

910b npu中,每aicore配备2个ai vector,总计25个aicore拥有50个ai vector,每ai vector每时钟周期可完成128次fp16计算。相较之下,a100拥有108个sm,每sm包含64个fp32 cuda core,每cuda core每时钟周期执行一次fp32计算。这凸显了910b npu在ai处理上的高效计算能力。

a100 gpu中,每sm搭载4个tensor core,每个tensor core每时钟周期可完成高达4x8x8的fp16/fp32 fma计算,单sm即实现1024次密集fp16/fp32 fma操作,整机配备108个sm,计算能力卓越。

910b npu的每个aicore都配备一个cube core,其计算能力强大,单个时钟周期内可执行多达16x16x16次fp16/fp32 fma运算。这意味着,每个aicore能高效完成4096次密集的fp16/fp32 fma操作。而910b npu总共配备了25个这样的aicore,计算能力惊人。

华为npu芯片设计聚焦高效能,虽减少计算单元数量,但矩阵计算单元远超gpu,强调单元计算力与效率,专为处理大规模矩阵计算任务如深度学习推理而优化。

经过测试数据分析,在普通模式下,910b与a100算力旗鼓相当。但华为910b在单个时钟周期内可处理16x16x16的矩阵计算,远胜于a100的4x8x8,其单次矩阵计算能力高达a100的16倍,效能显著。

a100凭借sparsity稀疏矩阵计算支持及丰富的tensorcore单元,在多数场景中显著超越910b。尽管910b在单一矩阵计算上表现出色,但a100在处理多元计算任务时依旧占据优势,尤其在稀疏矩阵计算领域,a100的性能尤为突出。

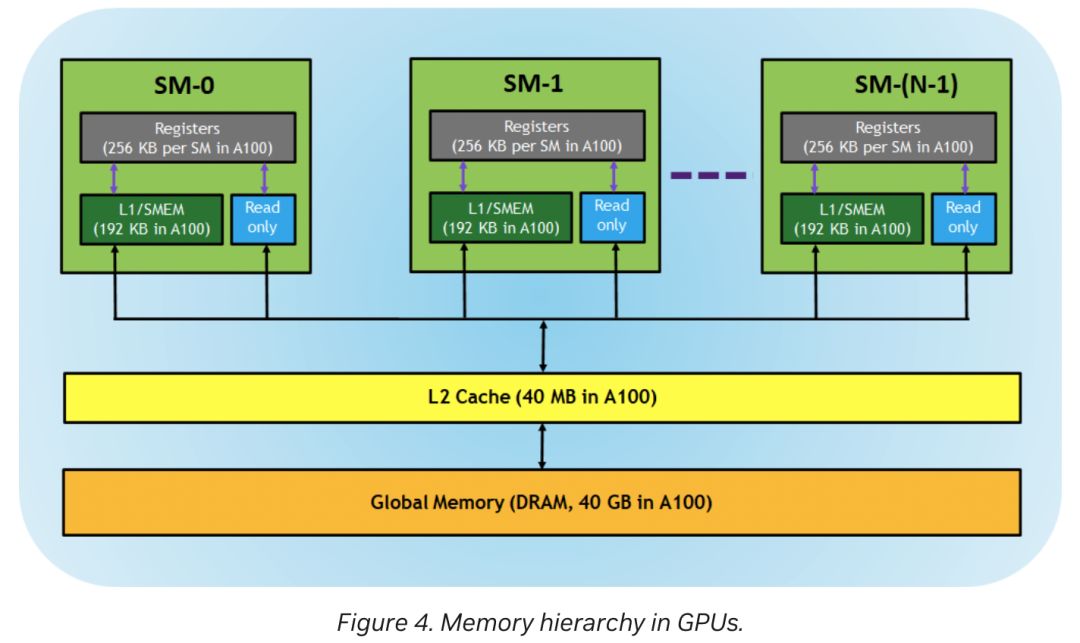

3. 内存架构比较

华为910b与英伟达a100在内存架构上大相径庭。910b凭借ai vector与ai cube的完全解耦设计,实现了两计算单元独立存储体系,展现了独特的技术优势。

此外,在全局存储的l2缓存方面,a100配备40mb,而910b则大幅升级至192mb,显著超越a100,提供更强大的缓存能力。

在a100中,l1/共享内存统一为192kb的逻辑区域;而华为910b的l1缓存独立存在于cube单元,达1mb,ub缓存则作为共享内存,位于vec单元,容量为256kb,彰显不同设计思路。

a100的每个sm配备256kb寄存器或l0缓存,而910b的cube拥有256kb输出寄存器及64kb输入寄存器,彰显其卓越的数据处理能力。

910b相较于a100,拥有更庞大的存储体系,显著提升了深度学习中大数据传输的支持能力,因此更适用于深度学习任务,展现卓越性能。

4. 通信性能比较

通信架构上的优势一直是英伟达强大的护城河之一。

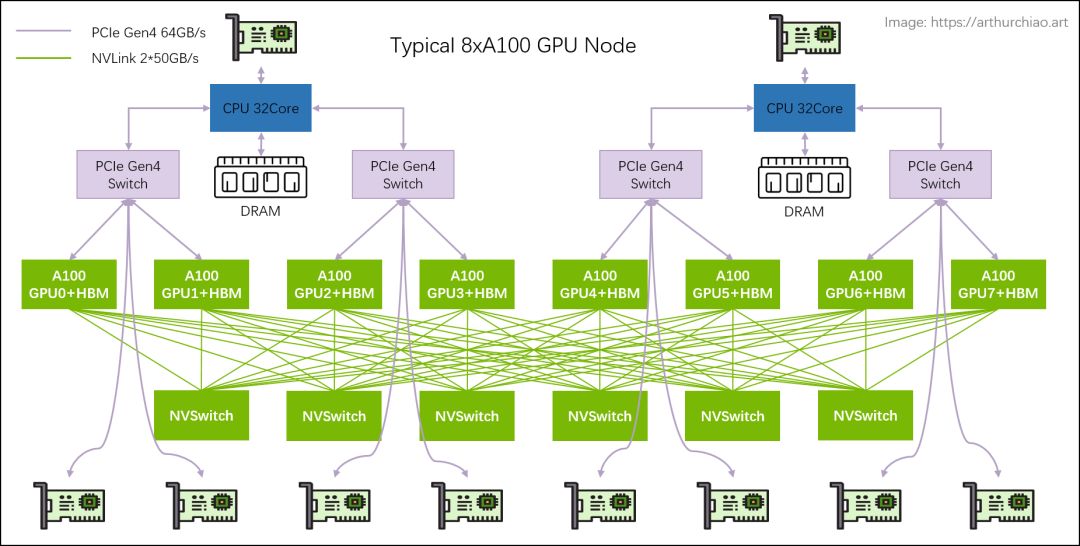

a100架构汇集第三代nvlink、第二代nvswitch及第四代pcle,实现高效的gpu间互联。在摩尔定律渐失效、算力需求飙升的今天,这一创新设计尤显关键,为满足高性能计算需求提供了强大支持。

a100架构中,每张gpu卡依托12条nvlink链路和6个nvswitch,实现全连接网络拓扑,性能卓越。

尽管标准dgx a100配置只配备8块gpu卡,未能充分发挥nvlink的硬件潜能,但该系统可扩展性强,支持增添更多a100 gpu卡与nvswitch,轻松打造更强大的超级计算机,满足大规模运算需求。

a100通过nvlink与nvswitch技术,实现了gpu间的全互联高速通信,总带宽高达600gb/s。得益于nvswitch的互联功能,即便是单点对点的传输,也能达到惊人的600gb/s带宽,确保了机内gpu间通信的高效与稳定。

dgx a100搭载高性能infiniband适配器,支持rdma技术,实现gpu间通信带宽高达200gbps。然而,需注意infiniband需专用网卡及昂贵交换机,投入成本相对较高。尽管如此,其卓越的通信性能仍具强大吸引力。

机内cpu与gpu的通信经由pcie switch高效互联。每cpu与4个gpu通过pcie switch实现通信,宛如交换机运作,支持多插槽配置。gpu 0~3及gpu 4~7间,既可依赖nvlink直接沟通,亦可选择pcie switch进行数据传输。nvlink专为实现gpu间的高速通信而设计,确保数据处理流畅无阻。

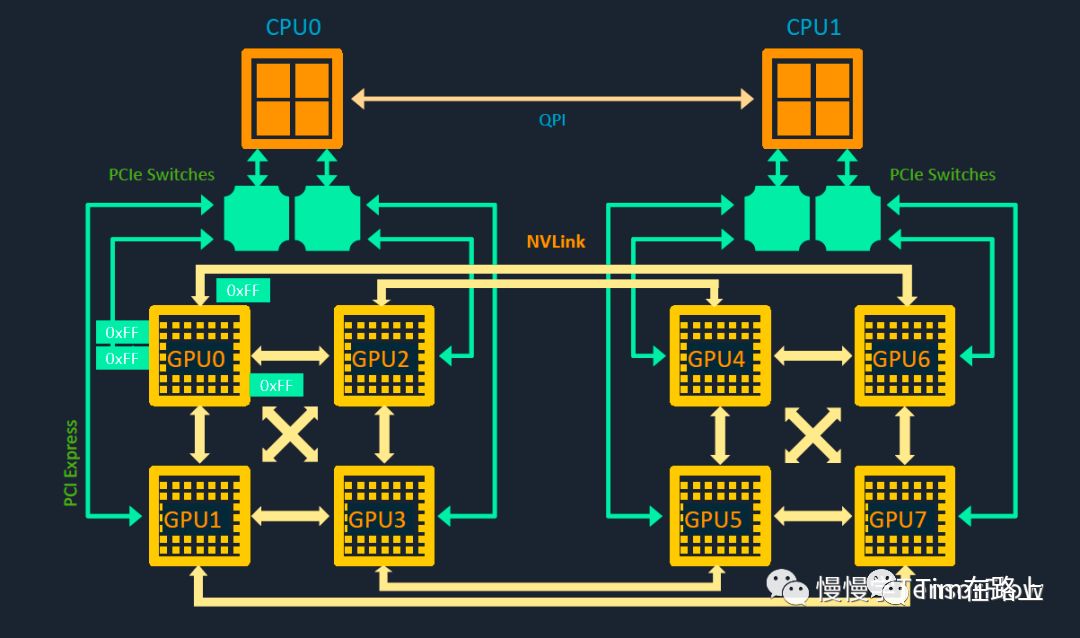

相较于a100,华为910b因缺少nvswitch,故采用类似gpu dgx-1的芯片直接互联方式进行机内通信,实现了高效的数据传输。

dgx-1的gpu架构图彰显其独特设计:每芯片配备4个nvlink链路,四芯片组合成cube mesh。gpu 0至3与gpu 4至7均通过nvlink和pcie switch实现互联。然而,gpu 0与gpu 4间无直接通路,需通过如gpu0-gpu2-gpu4的间接路径进行通信,这一创新设计确保数据处理的高效与灵活。

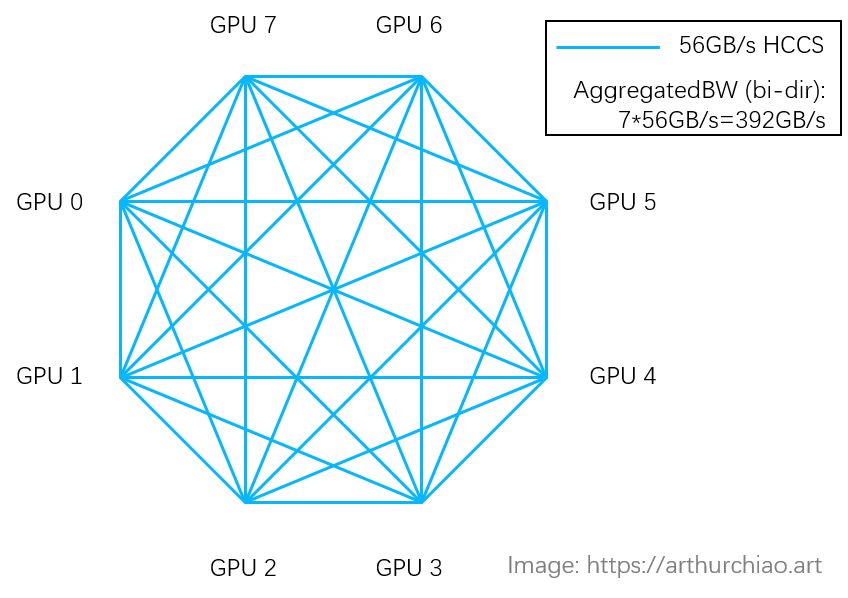

华为910b中,每芯片支持7个hccs链路,8芯片组成cube mesh。与dgx-1的gpu跳通信不同,16卡910b机器间采用pcie互联。如npu0与npu9间需跨pcie通信,通信效率受限。这一设计虽独特,但在特定场景下可能面临通信效率挑战。

华为910b在机间gpu通信上未配置infiniband适配器,仅依赖pcie通信,性能显著受限,通信速度相对较慢。

华为910b在cpu-gpu通信中凭借pcie gen5占据优势,但整体性能仍显著落后于a100。然而,华为据传已研发出类似“nvswitch”的首代硬件,显著提升通信性能,前景可期。

5. 总结

英伟达a100芯片,承袭英伟达技术精髓,不仅深度学习ai性能出众,更在图像处理及通用计算领域展现卓越性能,全面领先行业。

英伟达h100架构革新设计,移除rt core,以深度学习ai计算为重心,此举突破传统计算设计对深度学习性能的限制,精准切分深度学习领域的巨大市场潜力。

华为910b芯片,专为神经网络芯片npu设计,具备超大矩阵与高带宽内存系统,矩阵运算与流水并行处理能力卓越。在深度学习场景中,尤其在gemm计算上,其性能表现尤为突出。

华为芯片技术虽然取得了一些进步,但面临的挑战和短板同样不容忽视:

- 华为芯片设计卓越,但制程技术仍待提升。英伟达b架构芯片采用领先的4nm工艺,而华为910b芯片则基于7nm+技术。这一细微差距赋予英伟达芯片显著能效优势,性能卓越且能耗更低。华为需继续精进制程技术,以迎头赶上。

- 华为芯片设计优化亟待加强,以减少代际间的内部结构大幅变动,确保硬件兼容性与稳定性。同时,配套的api和开发工具亦需精进,以满足开发者需求,构建更为稳定、高效的开发环境。优化之路,持续进行,追求卓越。

- 华为npu在机间通信能力上尚待提升,与英伟达存在明显差距。英伟达gpu凭借nvlink和nvswitch技术,实现高速数据传输与高效并行计算,而华为npu相关技术尚未成熟,可能在大规模计算中遭遇性能瓶颈。

- 华为npu生态系统建设仍面临严峻挑战。构建强大生态需竞争力产品、丰富软件支持、广泛开发者基础及良好社区环境。华为应加大投入,吸引更多开发者和合作伙伴,共同推动npu技术的创新与应用,共筑繁荣生态。

华为910c已迈入送测阶段,对标英伟达h100。华为自研switch补足hccs通信短板,更研发测试fp8精度,力推国产算力进入新时代。国产科技实力崭露头角,华为引领算力新篇章!

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-

发表评论