🍉 csdn 叶庭云:

一、什么是 treelite?

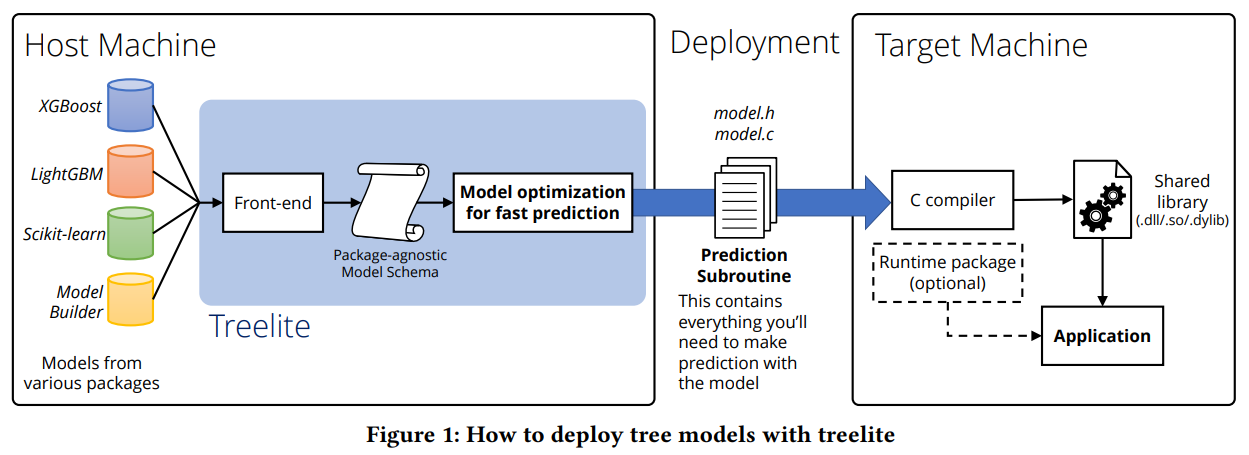

treelite 是一个专门用于将决策树集成模型高效部署到生产环境中的机器学习模型编译器,特别适合处理大批量数据的推理任务,能够显著提升推理性能。它提供多个前端接口,可与其他集成梯度提升树库(如 xgboost、lightgbm 和 scikit-learn)配合使用。通过编译优化,treelite 能将模型的性能提升 2 到 6 倍,相比于原生模型。treelite 的核心功能在于将树模型编译为高效的 c 代码,从而在推理阶段实现显著的性能提升。

treelite 官网:https://treelite.readthedocs.io/en/latest/index.html#

treelite 的主要功能

- 模型编译:将决策树模型编译成高效的可部署形式,方便部署。

- 性能优化:使用 treelite 进行模型编译优化后的性能相比于原生的 xgboost、lightgbm 模型通常会提升 2-4 倍。

- 互操作性:支持与其他树模型库(例如 xgboost、lightgbm 和 scikit-learn)的无缝集成。

treelite 的设计特点

- 模块化设计:前端(与其他树库交互的部分)和后端(生成可部署 c 文件的部分)之间有明显的分离。前端负责与其他树库的交互,后端负责生成可部署的 c 文件。这种设计使得 treelite 能够轻松地与不同的树模型库集成,同时保持其核心编译功能的独立性。

- 前端接口:提供了多个前端接口来与其他树库配合使用,包括专用接口导入 xgboost、lightgbm 和 scikit-learn 生成的模型

- 可扩展性:允许用户以编程方式指定其模型,还支持自定义模型编译。

treelite 支持的模型类型

- 决策树集成:包括随机森林和梯度提升决策树(gbdts)。

- 支持的前端接口:xgboost、lightgbm 和 scikit-learn。

treelite 的设计与实现

- 编译过程:treelite 的编译过程包括将树模型转换为中间表示(intermediate representation,ir),然后优化该 ir 并生成最终的 c 代码。这一过程充分利用了编译器优化技术,将树模型转换为高效的代码,从而在推理阶段实现快速响应。

- 优化策略:treelite 采用多种优化策略,包括逻辑分支优化、内存访问优化和并行计算优化,以提高模型推理速度。这些优化策略使得 treelite 生成的 c 代码在推理时能够充分利用硬件资源,实现高性能推理。

treelite 的性能优势:优化后的模型在预测速度上相比原生模型有显著提升,最高可提高 6 倍。treelite 主要在以下两个方面进行了改进:

- 通过规则编译加快预测速度。将决策规则 “编译” 为嵌套的 if-else 条件,可以将给定的树集成模型转化为 c 程序。在转换过程中,每个测试节点被转化为一对 if-else 语句,随后递归地将左右子节点扩展为 c 代码,直至触及每个叶节点。通过这种方式,我们能够针对正在检查的模型实现编译时优化。以前,模型在运行时从文件中加载,且预测逻辑并未考虑到与特定模型相关的信息。然而,现在通过规则编译,编译器能够访问正在编译的特定模型中的每一位信息,进而利用这些信息进一步优化生成的机器代码。作为早期演示,treelite 提供了两种优化方案。

- 逻辑分支优化,对条件分支进行注释。我们预测每个条件的可能性时,会依据训练数据中满足该条件的数据点数量。若条件在训练数据中有至少 50% 的概率为真,则将其标记为 “预期为真”;否则,标记为 “预期为假”。gcc 和 clang 编译器均提供

__builtin_expect这一编译器内在函数,用以指定条件的预期结果。这有助于编译器更智能地决定分支顺序,从而改进分支预测。 - 在逻辑比较优化方面,原始的分支比较可能涉及浮点数比较逻辑。为提高效率,我们建议将浮点数比较量化为整数数值比较。这一优化措施将测试节点中的所有阈值转换为整数,从而确保每个阈值条件都执行整数比较,而非传统的浮点比较。通过 “量化” 阈值为整数索引,在 x86-64 等平台上,将浮点比较替换为整数比较,不仅减少了可执行代码的大小,还改善了数据局部性,进而提升了性能。

treelite 的应用场景

- 大规模数据推理:特别适用于需要处理大量数据的场景。

- 模型部署:高效地将训练好的模型部署到生产环境中。

通过这些功能和应用场景,treelite 为数据科学家和机器学习工程师提供了一个强大的工具,用于优化决策树集成模型的部署和推理性能。

二、为什么要用 treelite?

在生产环境部署决策树集成模型,为什么要使用 treelite?

在生产环境中部署决策树集成模型时,选择使用 treelite 的主要原因包括以下几点:

- 模型导出和独立的预测库:treelite 可以将训练好的模型导出为独立的预测库,从而在部署时无需安装任何机器学习包,简化部署流程。

- 模型编译优化:treelite 可以将树模型编译优化为单独的库,显著提高模型的预测速度,例如,xgboost 模型的预测速度可提高 2~6 倍。

- 支持多种树模型:treelite 支持包括随机森林、gbdt、xgboost、lightgbm 和 scikit-learn 等在内的多种流行机器学习库。

- 跨语言支持:treelite 提供多个前端接口,便于将模型部署到不同编程语言环境(如 c、java 等),从而更容易地集成到现有生产系统中。

- 性能提升:使用 treelite 进行模型编译优化后,性能通常比原生的 xgboost、lightgbm 模型提升 2~4 倍,这对处理大批量数据的推理场景尤为重要。

- 良好的社区支持:treelite 拥有一个活跃的社区,提供详细的文档和丰富的资源,如官方文档、技术论文和示例代码等。这些资源为开发者提供了深入学习和使用的便利,进一步推动了 treelite 在机器学习领域的应用和发展。

综上所述,treelite 以其模型导出、编译优化、多模型支持、跨语言部署和性能提升等特点,成为生产环境中部署决策树集成模型的首选工具。

三、使用 treelite 部署决策树集成模型的具体操作步骤

treelite 是一个专门用于加速决策树集成模型推理(预测)速度的库。在生产环境中部署决策树集成模型时,使用 treelite 可以显著加快模型的推理速度。以下是使用 treelite 在生产环境中部署决策树集成模型的具体操作步骤:

1. 安装 treelite 和 tl2cgen:

确保你已经安装好了 treelite 和 tl2cgen。如果没有安装,可以使用以下命令进行安装:

pip install treelite

pip install tl2cgen

2. 准备模型:

确保你拥有一个经过良好训练的决策树集成模型,如使用 xgboost、lightgbm 或 catboost 训练得到的模型。模型需保存为支持的格式,常见的格式包括 json、bson 或 pickle。

3. 转换为 treelite 格式:

将你的决策树模型转换成 treelite 可以识别的格式。通常,这需要使用 treelite 提供的 api 来加载模型。下面是一个使用 xgboost 模型的示例:

import tl2cgen

import treelite

import xgboost as xgb

# importing tree ensemble models:https://treelite.readthedocs.io/en/latest/tutorials/import.html#

# treelite 3.x 及更早版本

# xgb_model = treelite.model.load("my_model.json", model_format="xgboost_json")

# json format

model = treelite.frontend.load_xgboost_model("my_model.json")

# legacy binary format

model = treelite.frontend.load_xgboost_model_legacy_binary("my_model.model")

# to import models generated by lightgbm, use the load_lightgbm_model() method:

model = treelite.frontend.load_lightgbm_model("lightgbm_model.txt")

补充以下内容:

- tl2cgen:treelite 树编译器已迁移到 tl2cgen。tl2cgen(treelite 2 c 生成器)是一个决策树模型的模型编译器。您可以将任何决策树集成模型(随机森林、梯度提升模型)转换为 c 代码,并将其作为原生二进制文件分发。

- tl2cgen 与 treelite 无缝集成。任何由 treelite 支持的树模型都可以通过 tl2cgen 转换为 c 语言代码。tl2cgen 是一个模型编译器,能够将树模型转换为 c 代码。它可以转换所有采用 treelite 格式存储的树模型。tl2cgen 是众多使用 treelite 作为库的应用程序之一。

- 从 4.0 版本起,treelite 停止支持将树模型编译为 c 代码,该功能已转移至 tl2cgen。从 4.0 版本起,treelite 已转变为一个小型库,使得其他 c++ 应用程序能够在磁盘和网络上交换及存储决策树。使用 treelite 可以帮助应用程序开发者支持多种树模型,同时减少代码重复并保持高度的准确性。树模型采用一种高效的二进制格式进行存储。

4. 编译 treelite 模型:

为了加快部署推理速度,treelite 需要将模型编译成高效的机器码。这一步骤通常包括指定目标平台和选择编译器选项。例如,若你打算在 cpu 上运行模型,可以采取以下步骤:

# 编译模型为动态链接库

toolchain = 'gcc' # 或者其他你使用的编译器,如 'clang', 'msvc'

tl2cgen.export_lib(model, toolchain=toolchain, libpath="./mymodel.so", params={'parallel_comp': 32})

5. 加载编译后的模型:

在生产环境中,需要加载编译后的模型文件,如动态链接库(.so 文件或 .dll 文件),使用 tl2cgen 的 predictor 类加载 .so 文件。

predictor = tl2cgen.predictor("./mymodel.so")

6. 进行预测:

使用编译后的模型对新数据进行预测时,需确保输入数据的格式与训练时的数据格式一致:

# 假设 x 是特征矩阵

dmat = tl2cgen.dmatrix(x[10:20, :])

out_pred = predictor.predict(dmat)

print(out_pred)

7. 性能优化:

如有必要,可对模型进行性能优化,例如通过量化参数以减少内存占用并提高推理速度。

8. 集成到生产环境:

最后,需将编译后的模型及必要的 treelite 运行时代码集成至生产环境,以便实际应用。

请注意,具体的 api 调用和参数设置可能因模型类型和所用机器学习框架而异。务必参考 treelite 官方文档获取最新、准确的信息。

总的来说,treelite 是一款优秀的决策树集成模型部署和推理优化工具,支持将模型部署为 .so 文件,不仅便于其他语言调用,还能有效防止模型参数泄露。

📚️ 相关链接:

发表评论