背景

最近几年,人工智能技术的发展势头愈发强劲。无论是大型语言模型的突破,如美国openai公司开发的chatgpt,还是中国诸家企业在自主学习系统领域的快速进步,都展现了人工智能技术的前所未有的潜力和变革力量。这不仅仅是技术本身的飞速发展,更是人类对知识边界与认知极限的一次深度探索。从自然语言处理到计算机视觉,从强化学习到生成式ai,技术创新层出不穷,为人类社会带来了前所未有的变革。

在这场技术革命中,我们欣喜地看到ai系统能够以接近或超越人类水平的能力,完成复杂的知识推理、多任务处理以及创造性思考。例如,deepseek等中国公司开发的智能搜索引擎,不仅在信息检索方面取得了显著进展,还展现出独特的领域适应能力。此外,ai技术的应用已经渗透到各个行业,从医疗、教育到金融,每一个领域都在经历着前所未有的数字化与智能化转型。在这个充满挑战与机遇的时代,我们需要以更加开放和包容的心态,拥抱人工智能带来的变革,同时也要保持对未知未来的一种敬畏与谨慎。

本文旨在详细介绍如何离线搭建deepseek-r1,主要为企业级开发使用。另外官方线上环境因火爆的访问量及持续遭受每秒上亿次的dos恶意请求,导致访问体验感不好的小伙伴也可以进行离线搭建使用。

仅需线上体验的朋友可以直接跳转官网链接。

搭建准备

基础概念

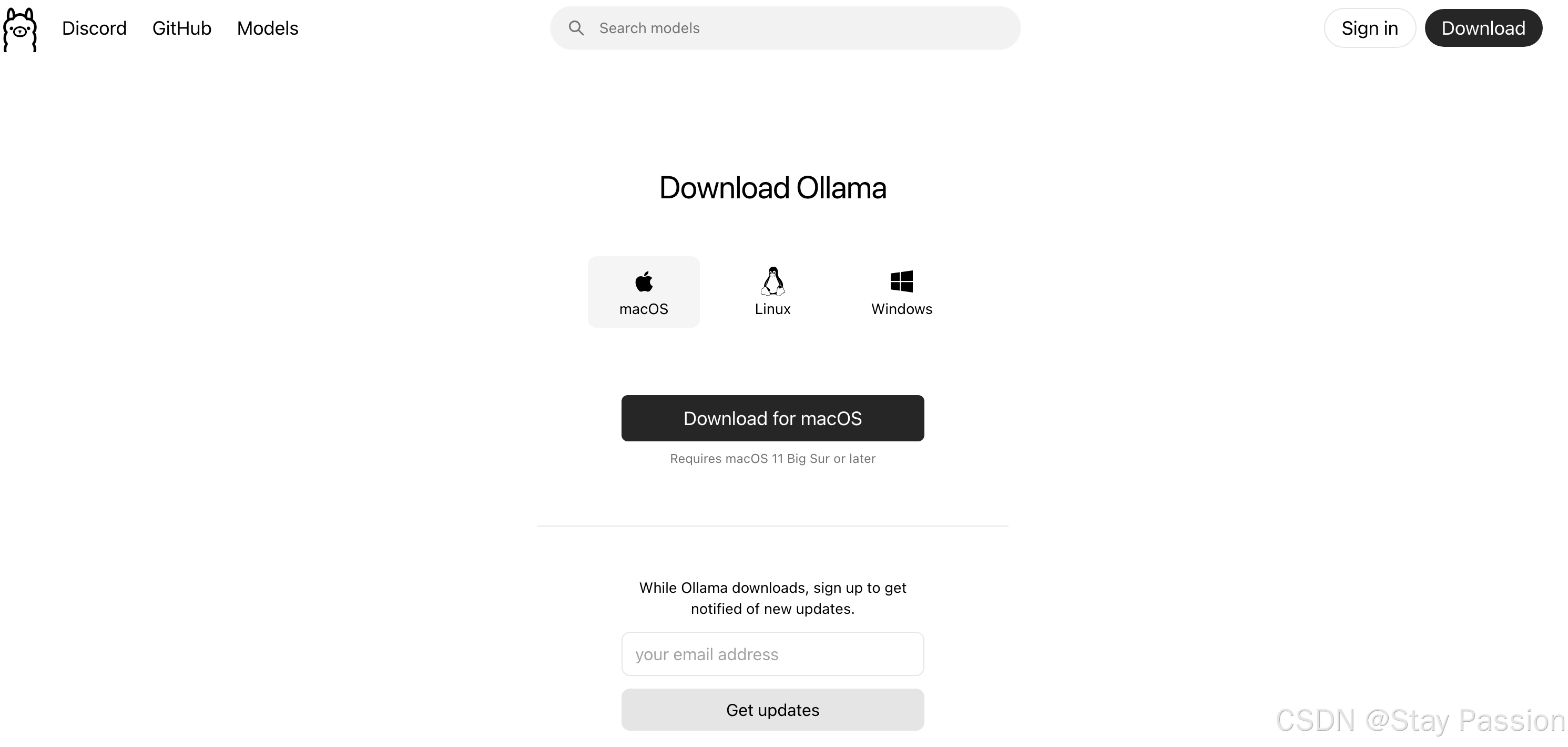

ollama 是一个开源的人工智能平台,专注于大语言模型(large language model, llm)的本地部署和管理。它允许开发者在自己的服务器上运行多种预训练语言模型,如 gpt-3 或 chatgpt,并通过 restful api 提供服务。ollama 的核心优势在于其高效的本地推理能力,能够在资源有限的环境下快速响应用户查询。如下附上ollama基础指令。

#1.启动ollama服务 ollama serve #2.创建模型 (create);使用 modelfile 来创建一个新模型。你需要提供一个包含模型信息的 modelfile。 ollama create /path/to/modelfile #3.显示模型信息 (show);查看特定模型的详细信息,例如模型名称、版本等。 ollama show model_name #4.列出所有模型 (list);列出本地所有可用的模型,可以在这里查找模型名称。 ollama list ollama ls #5.运行模型 (run);运行一个已安装的模型,执行某些任务。 ollama run model_name #6.列出正在运行的模型 (ps);显示当前正在运行的模型列表。 ollama ps #7.删除模型 (rm);删除一个已安装的模型。 ollama rm model_name #8.查看版本 (version);显示当前 ollama 工具的版本信息。 ollama -v ollama --version #9.复制模型 (cp);复制一个模型到另一个位置或给定名称的地方。 ollama cp old_model new_model #10.从注册表拉取模型 (pull);从模型注册表中拉取一个模型,供本地使用。 ollama pull model_name #11.推送模型到注册表 (push);将本地模型推送到模型注册表中,以便他人或其他系统使用。 ollama push model_name

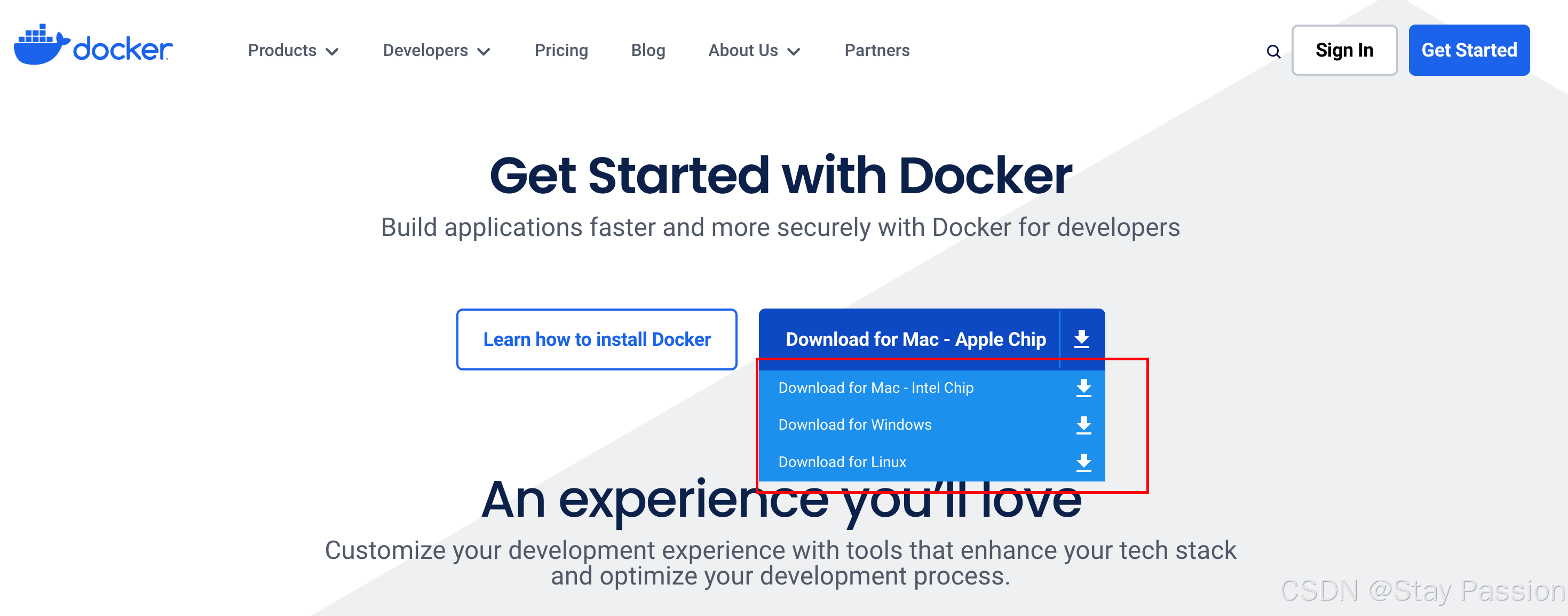

docker是一种开源的容器化平台,用于将软件及其所有依赖环境打包到镜像文件中,以便于在任何环境下轻松运行。此处使用docker主要用于运行open-webui,以便于更方便的使用deepseek-r1。

搭建过程

上述安装产品安装成功之后,便可以开始着手搭建deepseek-r1。

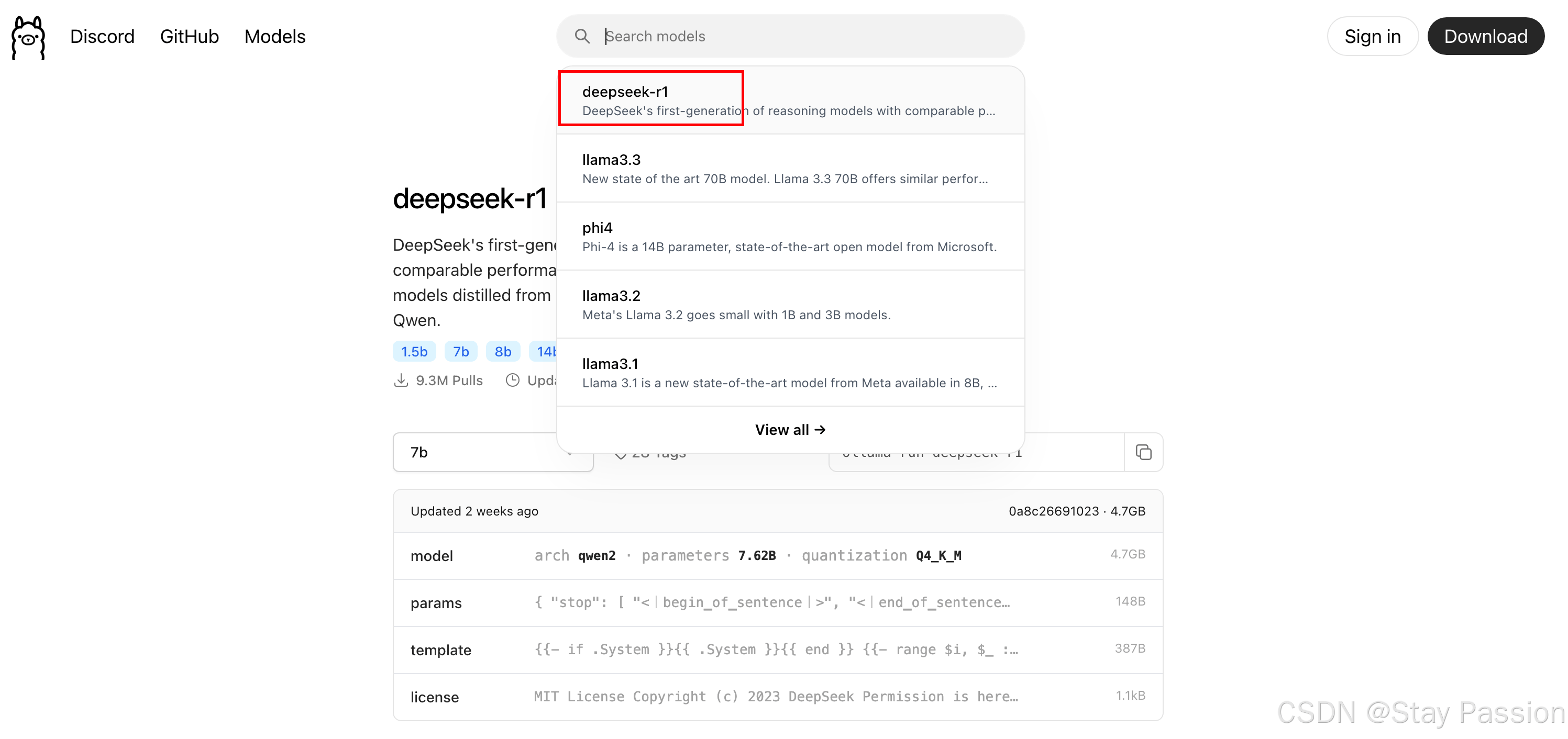

首先在ollama官网查询 deepseek 或者 deepseek-r1

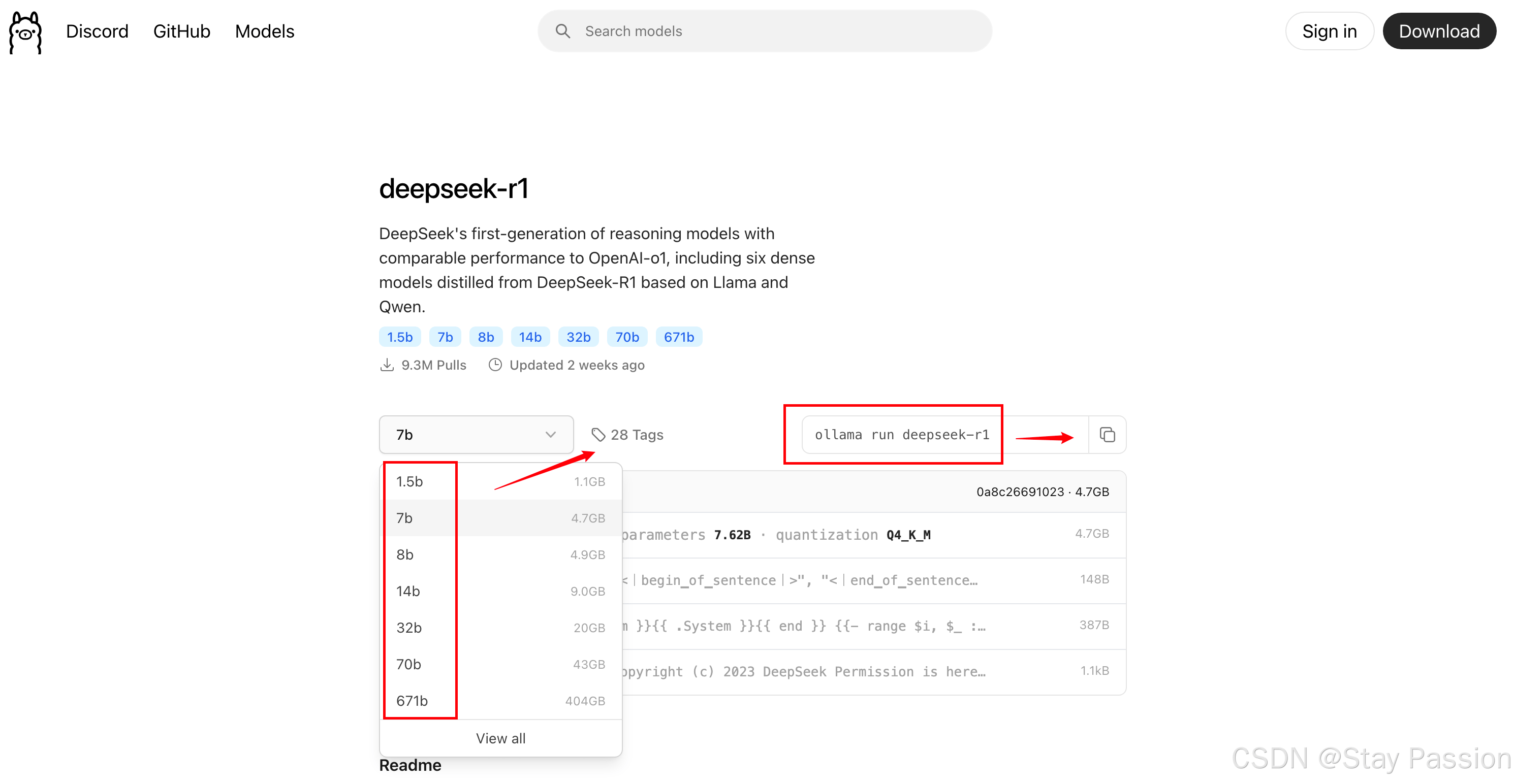

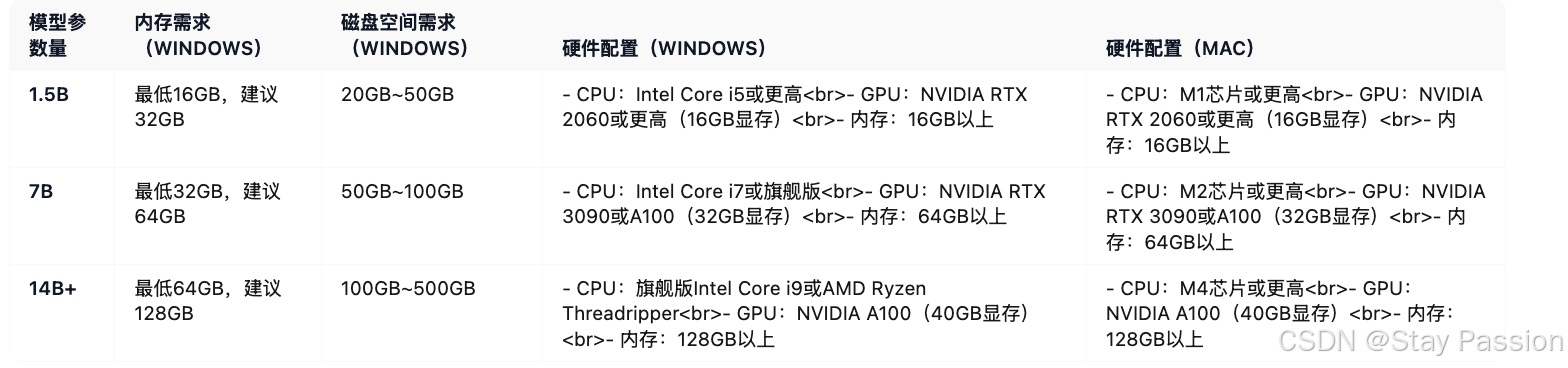

如下图目前存在28个tag,按照我们自身电脑配置选择对应的版本,同时复制右侧命令。

数字后面的b代表着算力参数,随着参数增加,训练和 inference 的计算量也显著增加,但也要选择和本地硬件相匹配。

配置对照表

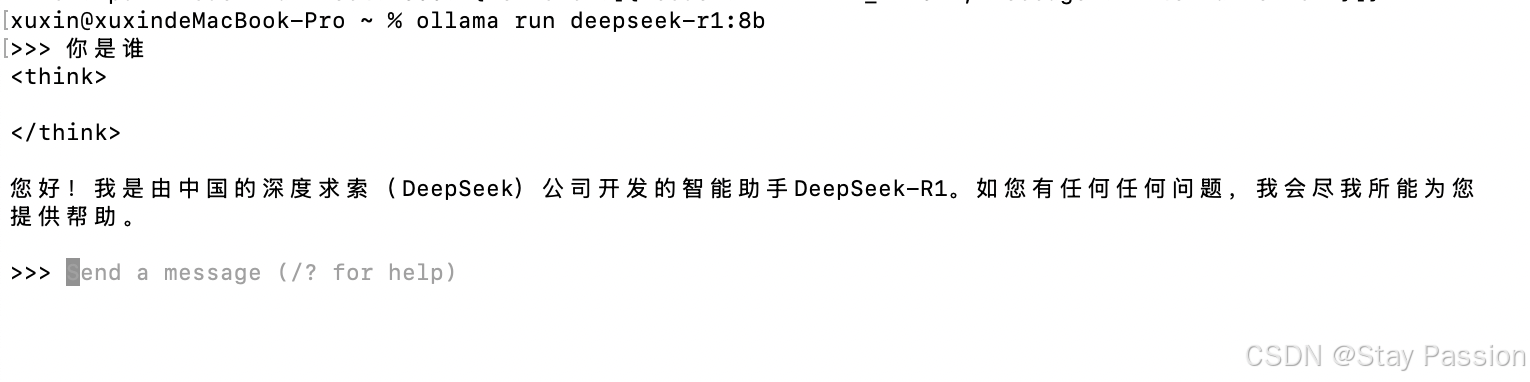

- mac用户打开终端(windows用户打开cmd)输入上述复制命令

下载结束且成功之后(出现三个箭头),则可以进行问答。前期下载速度还是蛮快的,后面速度会越来越慢(fq可有效提高下载速度),可以手动 control c 结束之后重新运行(会接着进行下载)。

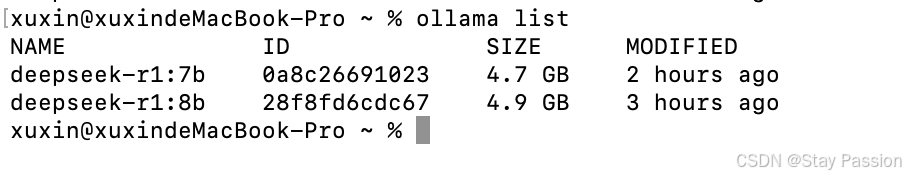

下载成功之后可以查询到下载的模型信息

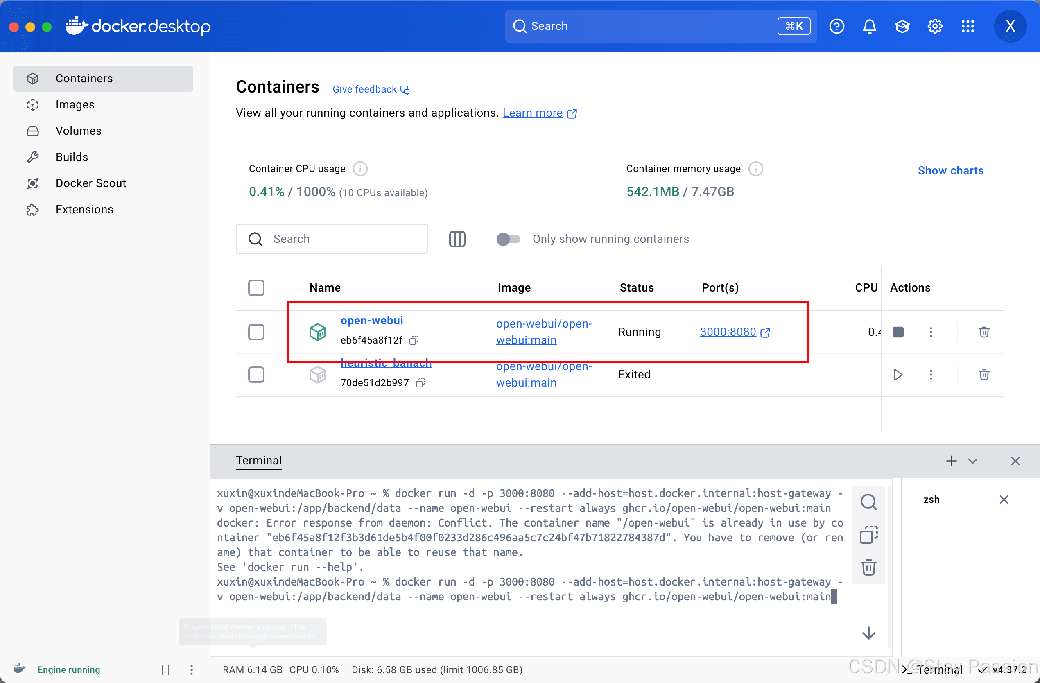

- 安装webui

如上小黑框中的交互方式显然不能满足我们的要求,我们需要一个友好的交互页面(如chatgpt一样),还可以记录下我们对话的内容。此时引入open web ui。

登录docker客户端并点击terminal输入如下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

步骤解释:

docker run:使用命令启动一个新的docker容器。-d:表示运行容器时在后台,避免终端被占据。-p 3000:8080:将宿主机的端口3000映射到容器内的端口8080。这样,外部访问的请求会被转发到容器内的8080端口,以供webui服务提供响应。--add-host=host.docker.internal:host-gateway:为docker容器网络配置添加一个宿主名。host.docker.internal是docker默认配置的一个虚拟ip地址,允许容器访问主机网络中的其他服务,如本地服务器或数据库等。--name open-webui:指定容器的名称为open-webui,方便在后续操作中通过名称管理和停止容器。ghcr.io/open-webui/open-webui:main:从github container registry(ghcr)拉取镜像。open-webui:main表示使用仓库中的open-webui项目的主分支镜像。如果没有权限访问该镜像,docker命令将失败。--restart always:设置容器重启策略,当容器退出时自动启动新实例,以确保服务持续运行,避免应用程序故障导致服务中断。-v open-webui:/app/backend/data:创建一个匿名卷,将宿主机的文件夹open-webui挂载到容器内的路径/app/backend/data。这允许容器在运行期间生成或修改数据,而这些数据会被保存到宿主机的指定文件夹中,方便后续管理和持久化。

通过以上命令,您可以在本地启动一个webui服务,外部用户可以通过宿主机的3000端口访问。容器将自动重启,以应对崩溃或终止情况,并且数据会被持久保存以供后续使用。

访问

webui本地访问地址: http://localhost:3000/

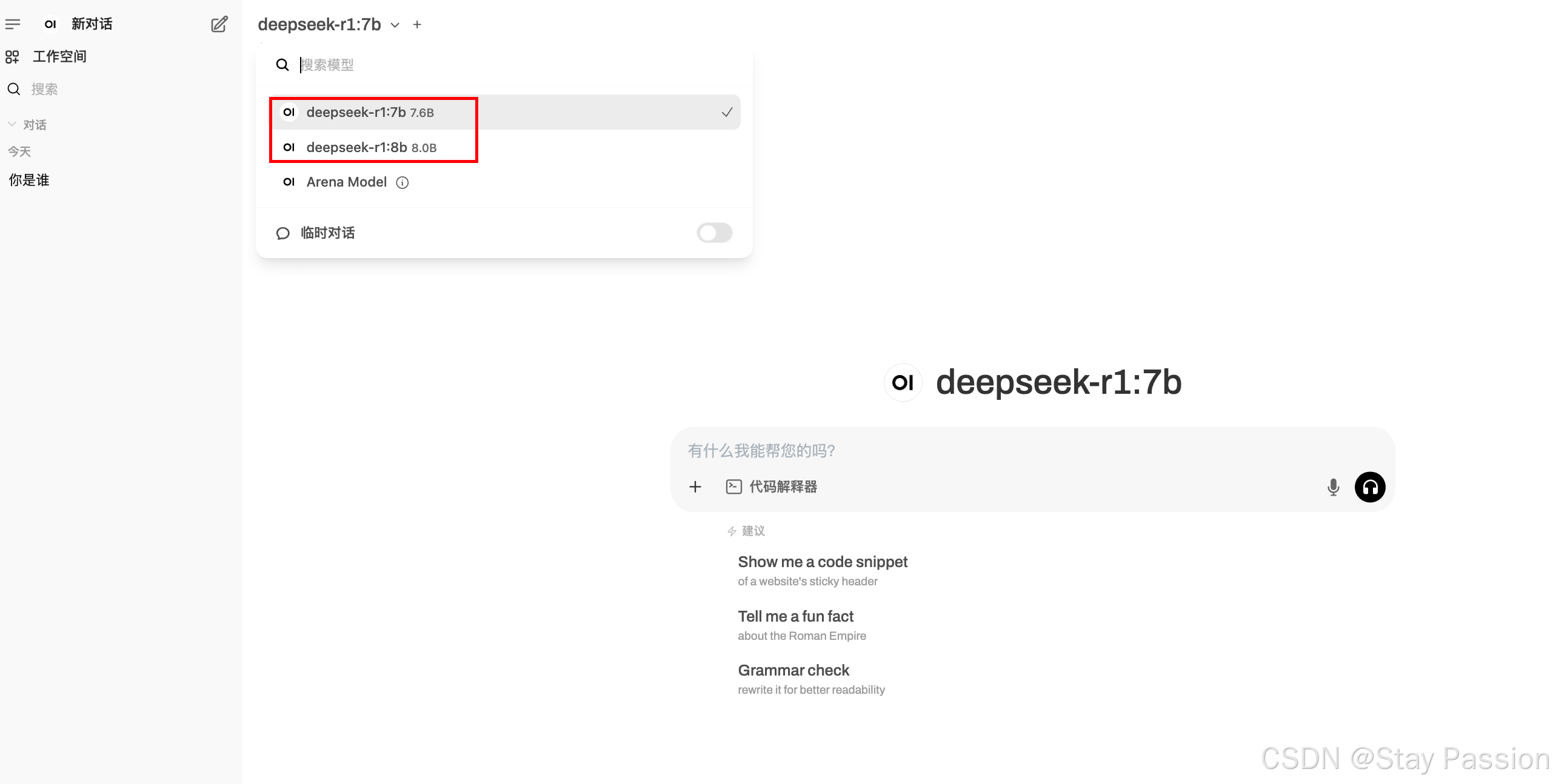

登录成功之后可以选择我们下载好的对应模型进行对话。

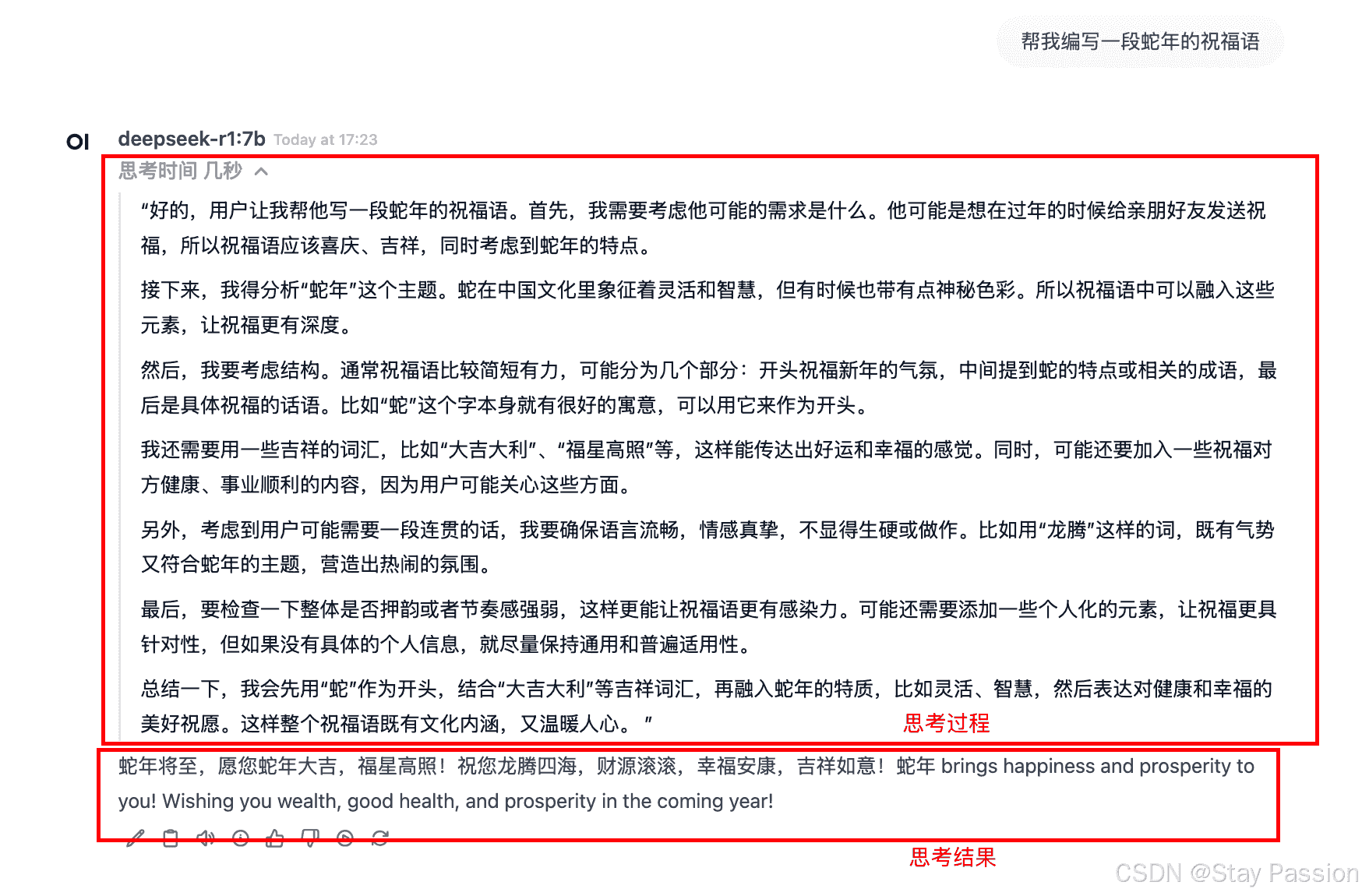

对话测试

综上,我们就完成了deepseek r1 的本地搭建。于用户角度,与chatgpt相比,deepseek独有的思考过程让人眼前一亮。

总结

到此这篇关于本地搭建deepseek-r1、webui的文章就介绍到这了,更多相关本地搭建deepseek-r1、webui内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论