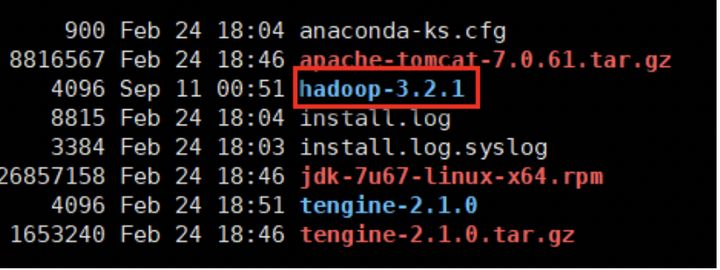

上传hadoop-3.2.1.tar.gz到node01服务器

解压安装包命令:tar -zxvf hadoop-3.2.1.tar.gz

删除hadoop-3.2.1.tar.gz压缩包命令:rm -f hadoop-3.2.1.tar.gz

hadoop配置文件修改

hadoop安装主要就是配置文件的修改,一般在主节点进行修改,修改完毕后下发给其他各个从节点机器

进入hadoop配置文件目录中去

命令:cd hadoop-3.2.1/etc/hadoop/

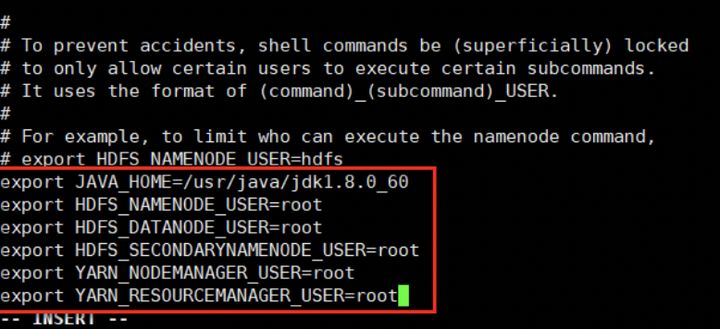

配置hadoop-env.sh文件

文件中设置的是hadoop运行时需要的环境变量,java_home是必须设置的

找到jdk安装路径地址

命令:echo $java_home

/usr/java/jdk1.8.0_60

编辑hadoop-env.sh文件命令:vi hadoop-env.sh

在该文件中需要配置jdk的环境变量,并指定namenode、datanode、secondarynamenode使用的用户,一般是root

export java_home=/usr/java/jdk1.8.0_60

export hdfs_namenode_user=root

export hdfs_datanode_user=root

export hdfs_secondarynamenode_user=root

export yarn_nodemanager_user=root

export yarn_resourcemanager_user=root

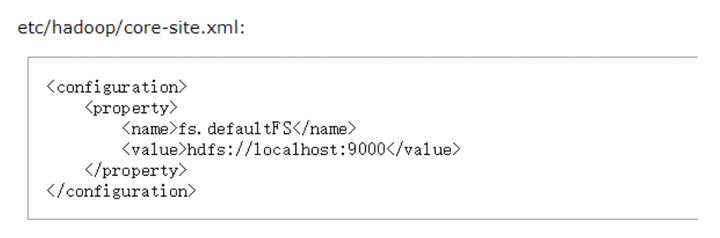

配置core-site.xml文件

hadoop的核心配置文件,有默认的配置项core-default.xml

指定hadoop所使用的文件系统schema,hdfs的老大(namenode)的地址

如何配置?

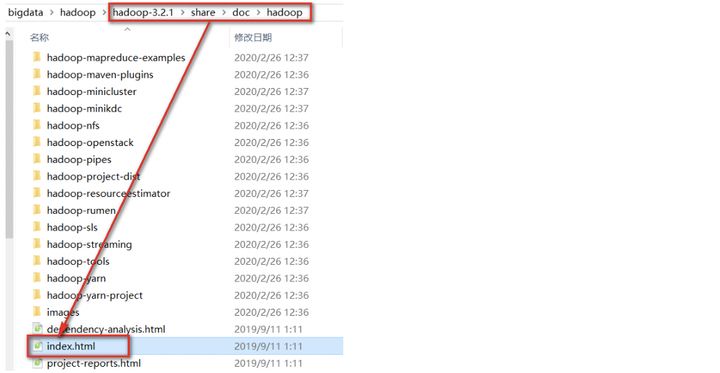

打开hadoop-3.2.1—share----doc—hadoop----index.html文件

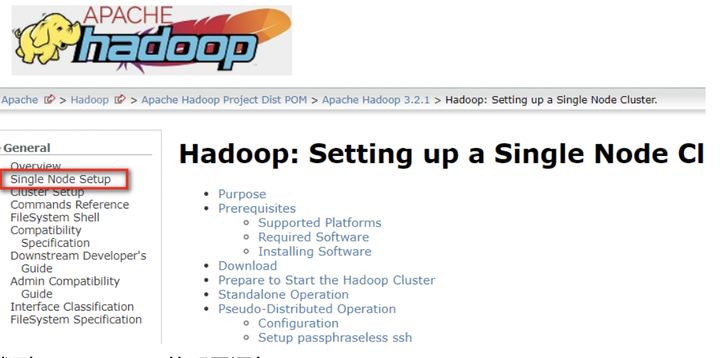

在打开的网页中点击single node setup

找到core-site.xml的配置语句

修改成如下代码,hadoop3默认端口为9820

<property>

<name>fs.defaultfs</name>

<value>hdfs://node01:9820</value>

</property>

指定hadoop运行时产生文件的存储目录,默认/tmp/hadoop-&{user.name}

tmp目录会未经过同意,直接删除其中的文件,所以需要重新定义一个文件存储目录

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hdata/hddata</value>

</property>

配置hdfs-site.xml文件

指定hdfs副本的数量,默认备份3份

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node02:9868</value>

</property>

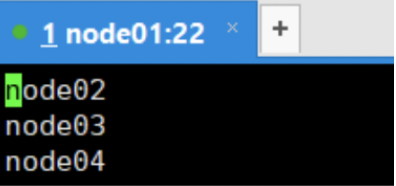

配置workers文件

workers文件,里面写上从节点所在的主机名

编辑文件命令:vi workers

在改文件中配置hadoop集群的节点

node02

node03

node04

文件分发

使用scp命令下发hadoop-3.2.1到node02、node03、node04上

scp -r hadoop-3.2.1 root@node02:/root

scp -r hadoop-3.2.1 root@node03:/root

scp -r hadoop-3.2.1 root@node04:/root

配置hadoop3环境变量

编辑文件命令:vi /etc/profile

在文件中添加红色部分代码

export java_home=/usr/java/jdk1.8.0_60

export hadoop_home=/root/hadoop-3.2.1

export path= p a t h : path: path:java_home/bin: h a d o o p _ h o m e / b i n : hadoop\_home/bin: hadoop_home/bin:hadoop_home/sbin

重新加载配置文件命令:source /etc/profile

文件分发

将/etc/profile配置文件分发到node02、node03、node04上

scp /etc/profile node02:/etc/

scp /etc/profile node03:/etc/

scp /etc/profile node04:/etc/

在node02、node03、node04上重新加载配置文件

source /etc/profile

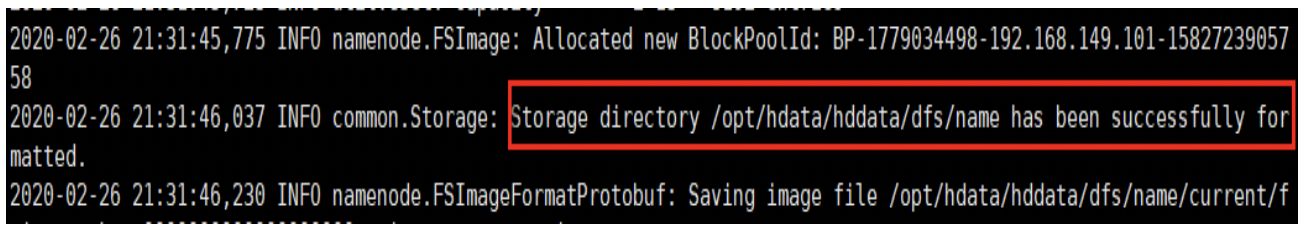

hadoop3集群启动、初体验

要启动hadoop集群,需要启动hdfs和yarn两个集群

注意:首次启动hdfs时,必须对其进行格式化操作,本质上是一些清理和准备工作,因此此时的hdfs在物理上还是不存在的

格式化命令:hdfs namenode -format或者hadoop namenode -format

因为在配置core-site.xml文件的时候,配置了一个文件存储目录,该目录没有创建,在hadoop格式化的时候会自动创建,所以可以查看该目录是否创建来判断是否格式化成功

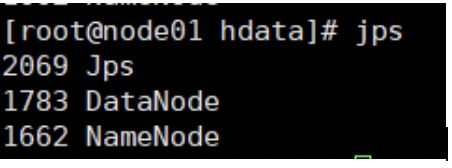

单个启动集群

如果配置了etc/hadoop/workers和ssh免密登录,则可以使用程序脚本启动所有hadoop两个集群的相关进程,在主节点所设定的机器上执行

启动hdfs集群命令:start-dfs.sh

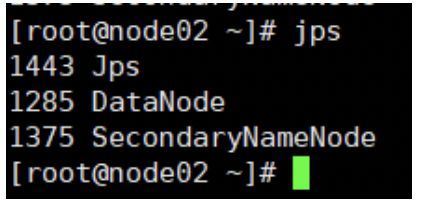

通过jps可以查看每台虚拟机上启动的节点信息

node01

node02

node03

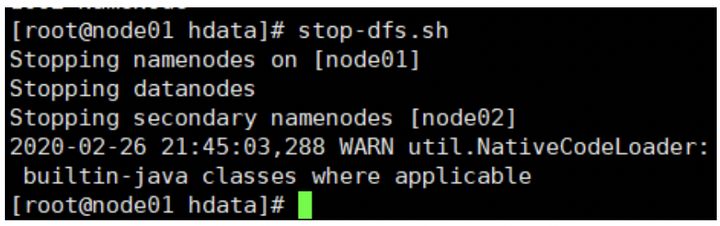

停止hdfs集群命令:stop-dfs.sh

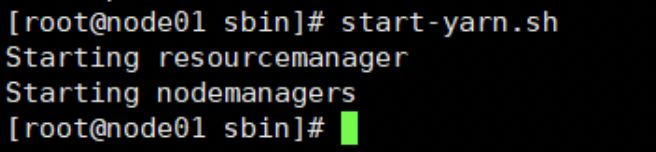

启动yarn集群命令:start-yarn.sh

停止yarn集群:stop-yarn.sh

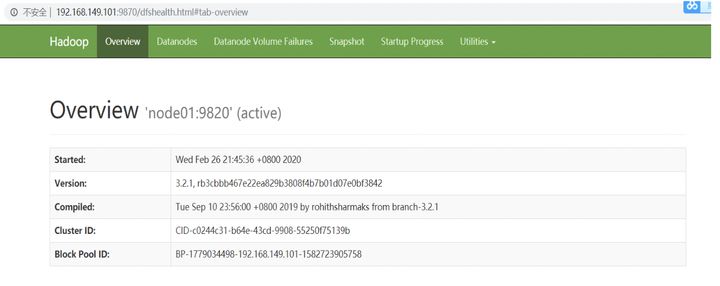

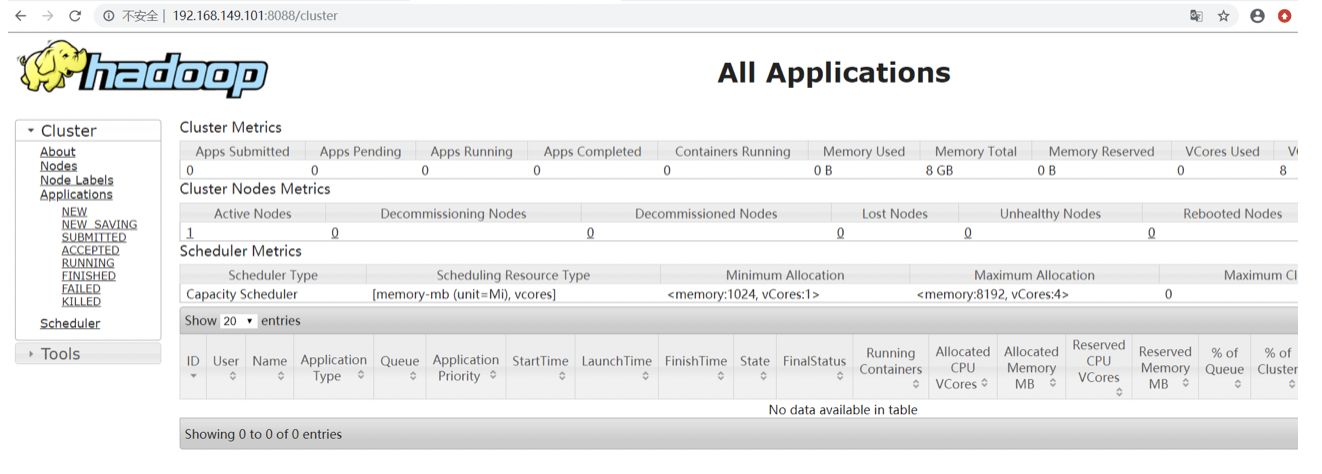

集群web-ui

一旦hadoop集群启动并运行,可以通过web-ui进行集群查看,如下所述

namenode: 默认9870

如:192.168.149.101:9870

yarn集群页面展示,默认端口号为8088。如:192.168.149.101:8088

脚本一键启动

接下来需要同时启动hdfs集群与yarn集群,启动命令在hadoop-2.6.5/sbin目录下

进入该目录命令:cd hadoop-2.6.5/sbin/

一键启动命令:start-all.sh

如何自学黑客&网络安全

黑客零基础入门学习路线&规划

初级黑客

1、网络安全理论知识(2天)

①了解行业相关背景,前景,确定发展方向。

②学习网络安全相关法律法规。

③网络安全运营的概念。

④等保简介、等保规定、流程和规范。(非常重要)

2、渗透测试基础(一周)

①渗透测试的流程、分类、标准

②信息收集技术:主动/被动信息搜集、nmap工具、google hacking

③漏洞扫描、漏洞利用、原理,利用方法、工具(msf)、绕过ids和反病毒侦察

④主机攻防演练:ms17-010、ms08-067、ms10-046、ms12-20等

3、操作系统基础(一周)

①windows系统常见功能和命令

②kali linux系统常见功能和命令

③操作系统安全(系统入侵排查/系统加固基础)

4、计算机网络基础(一周)

①计算机网络基础、协议和架构

②网络通信原理、osi模型、数据转发流程

③常见协议解析(http、tcp/ip、arp等)

④网络攻击技术与网络安全防御技术

⑤web漏洞原理与防御:主动/被动攻击、ddos攻击、cve漏洞复现

5、数据库基础操作(2天)

①数据库基础

②sql语言基础

③数据库安全加固

6、web渗透(1周)

①html、css和javascript简介

②owasp top10

③web漏洞扫描工具

④web渗透工具:nmap、burpsuite、sqlmap、其他(菜刀、漏扫等)

恭喜你,如果学到这里,你基本可以从事一份网络安全相关的工作,比如渗透测试、web 渗透、安全服务、安全分析等岗位;如果等保模块学的好,还可以从事等保工程师。薪资区间6k-15k

到此为止,大概1个月的时间。你已经成为了一名“脚本小子”。那么你还想往下探索吗?

如果你想要入坑黑客&网络安全,笔者给大家准备了一份:282g全网最全的网络安全资料包评论区留言即可领取!

7、脚本编程(初级/中级/高级)

在网络安全领域。是否具备编程能力是“脚本小子”和真正黑客的本质区别。在实际的渗透测试过程中,面对复杂多变的网络环境,当常用工具不能满足实际需求的时候,往往需要对现有工具进行扩展,或者编写符合我们要求的工具、自动化脚本,这个时候就需要具备一定的编程能力。在分秒必争的ctf竞赛中,想要高效地使用自制的脚本工具来实现各种目的,更是需要拥有编程能力.

如果你零基础入门,笔者建议选择脚本语言python/php/go/java中的一种,对常用库进行编程学习;搭建开发环境和选择ide,php环境推荐wamp和xampp, ide强烈推荐sublime;·python编程学习,学习内容包含:语法、正则、文件、 网络、多线程等常用库,推荐《python核心编程》,不要看完;·用python编写漏洞的exp,然后写一个简单的网络爬虫;·php基本语法学习并书写一个简单的博客系统;熟悉mvc架构,并试着学习一个php框架或者python框架 (可选);·了解bootstrap的布局或者css。

8、超级黑客

这部分内容对零基础的同学来说还比较遥远,就不展开细说了,附上学习路线。

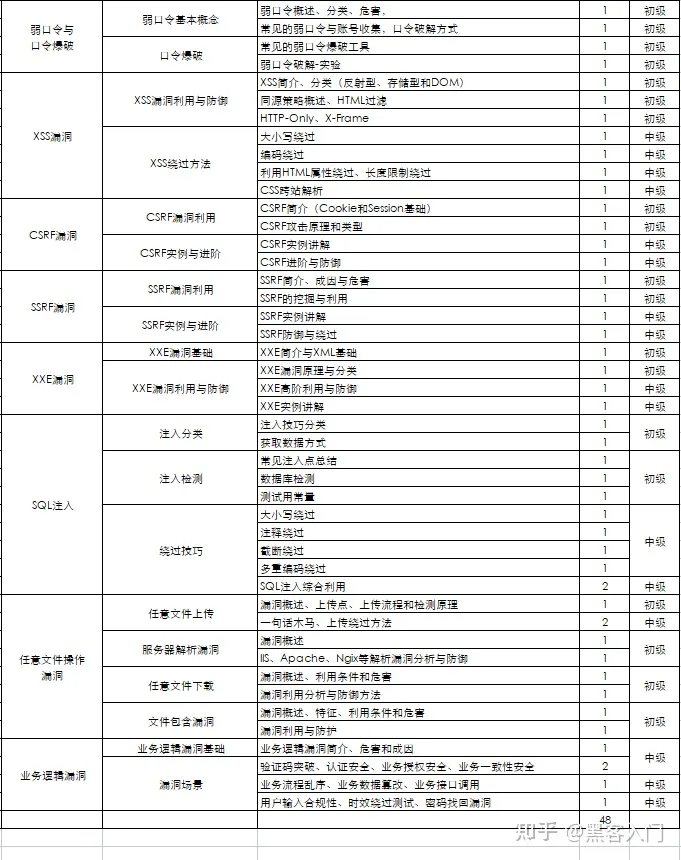

网络安全工程师企业级学习路线

如图片过大被平台压缩导致看不清的话,评论区点赞和评论区留言获取吧。我都会回复的

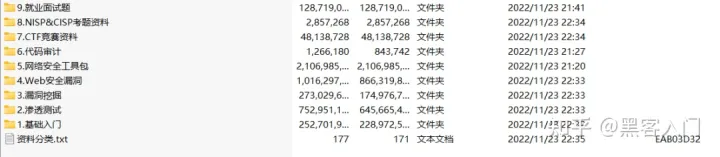

视频配套资料&国内外网安书籍、文档&工具

当然除了有配套的视频,同时也为大家整理了各种文档和书籍资料&工具,并且已经帮大家分好类了。

一些笔者自己买的、其他平台白嫖不到的视频教程。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事it行业的老鸟或是对it行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

发表评论