虚拟现实和增强现实之场景理解算法:手势识别教程

虚拟现实与增强现实概论

1. 虚拟现实与增强现实的定义

虚拟现实(virtual reality,vr)是一种通过计算机生成的三维环境,让用户能够沉浸其中并进行交互的技术。它通常需要通过头戴式显示器、手柄或其他传感器设备来实现,使用户感觉自己置身于虚拟世界中。

增强现实(augmented reality,ar)则是在现实世界的视图上叠加虚拟信息,如图像、文字或3d模型,以增强用户对现实环境的感知和体验。ar技术广泛应用于手机应用、游戏、教育和工业等领域。

2. 虚拟现实与增强现实的历史与发展

2.1 虚拟现实的历史

- 1960s: ivan sutherland开发了第一个头戴式显示器,标志着vr技术的开端。

- 1980s: jaron lanier提出了“虚拟现实”这一术语,并创立了vpl research,推动了vr技术的商业化。

- 1990s: vr技术开始在游戏、军事训练和医疗领域得到应用。

- 2010s: 随着oculus rift和htc vive等设备的出现,vr技术进入了消费市场,开启了新一轮的发展热潮。

2.2 增强现实的发展

- 1990s: tom caudell和david mizell在波音公司首次使用“增强现实”一词,描述了一种将虚拟信息叠加到现实世界的技术。

- 2000s: ar技术在教育、娱乐和军事领域开始应用,如ar游戏和ar辅助教学。

- 2010s: 随着智能手机的普及,ar技术通过应用如pokemon go和snapchat滤镜,进入了大众视野。

- 2020s: ar技术在工业、医疗和零售领域的应用日益广泛,如ar辅助手术和ar试衣间。

3. 虚拟现实与增强现实的应用领域

3.1 游戏与娱乐

vr和ar技术为游戏和娱乐行业带来了革命性的变化,提供了沉浸式的游戏体验。例如,vr游戏《beat saber》让用户在虚拟环境中挥舞光剑,而ar游戏《pokemon go》则让用户在现实世界中捕捉虚拟宠物。

3.2 教育与培训

在教育领域,vr和ar技术可以创建虚拟实验室,让学生进行安全的实验操作,或者通过ar技术将复杂的解剖结构直接展示在学生面前,提高学习效率。

3.3 医疗健康

vr技术在心理治疗中被用于治疗恐惧症和ptsd,通过模拟各种场景帮助患者克服心理障碍。ar技术则在手术中提供实时的解剖信息,辅助医生进行精准操作。

3.4 工业与制造

在工业领域,ar技术可以用于指导工人进行设备组装和维护,减少错误和提高效率。vr技术则可以用于设计和模拟工厂布局,优化生产流程。

3.5 零售与商业

ar技术在零售业中被用于创建虚拟试衣间,顾客可以在不试穿实体衣物的情况下看到自己穿上衣服的效果。vr技术则可以用于创建虚拟商店,提供沉浸式的购物体验。

以上内容概述了虚拟现实与增强现实的基本定义、历史发展以及它们在不同领域的应用。虽然没有直接涉及手势识别的代码示例,但这些信息为理解手势识别在vr和ar中的重要性提供了必要的背景知识。手势识别作为场景理解算法的关键部分,是实现用户与虚拟或增强现实环境自然交互的基础。在后续的教程中,我们将深入探讨手势识别的算法和技术实现。

场景理解算法基础

4. 计算机视觉简介

计算机视觉(computer vision, cv)是人工智能的一个重要分支,它致力于让计算机“看”和“理解”世界。计算机视觉技术通过图像处理、模式识别和机器学习等方法,使计算机能够从图像或视频中识别和理解物体、场景、动作等信息。在虚拟现实(vr)和增强现实(ar)领域,计算机视觉技术是实现场景理解和交互的关键。

4.1 核心技术

- 图像处理:包括图像增强、图像分割、特征提取等。

- 模式识别:通过识别图像中的模式,如边缘、纹理、形状等,来识别物体。

- 机器学习:尤其是深度学习,用于模型训练,提高识别的准确性和鲁棒性。

5. 深度学习在场景理解中的应用

深度学习,尤其是卷积神经网络(convolutional neural networks, cnns),在场景理解中发挥了重要作用。cnns能够自动学习图像的特征,无需人工设计特征,这大大提高了识别的效率和准确性。

5.1 cnns在手势识别中的应用

手势识别是场景理解中的一个具体应用,它通过识别用户的手势来实现与虚拟或增强现实环境的交互。cnns可以用于识别手势的形状、方向和动态变化,从而实现对用户意图的理解。

示例代码

# 导入必要的库

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

# 创建cnn模型

model = models.sequential()

model.add(layers.conv2d(32, (3, 3), activation='relu', input_shape=(32, 32, 3)))

model.add(layers.maxpooling2d((2, 2)))

model.add(layers.conv2d(64, (3, 3), activation='relu'))

model.add(layers.maxpooling2d((2, 2)))

model.add(layers.conv2d(64, (3, 3), activation='relu'))

model.add(layers.flatten())

model.add(layers.dense(64, activation='relu'))

model.add(layers.dense(10))

# 编译模型

model.compile(optimizer='adam',

loss=tf.keras.losses.sparsecategoricalcrossentropy(from_logits=true),

metrics=['accuracy'])

# 训练模型

# 假设我们有数据集(x_train, y_train)和(x_test, y_test)

# model.fit(x_train, y_train, epochs=10)

# model.evaluate(x_test, y_test, verbose=2)

5.2 数据样例

在训练手势识别模型时,数据集通常包含各种手势的图像和对应的标签。例如,一个手势数据集可能包含以下样例:

- 图像:一张32x32像素的彩色图像,表示一个特定的手势。

- 标签:一个整数,表示该手势的类别,如0表示“停止”,1表示“前进”,2表示“后退”等。

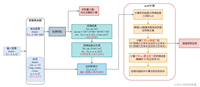

6. 手势识别算法的原理与流程

手势识别算法通常包括以下几个步骤:

- 图像采集:从摄像头或传感器获取图像或视频流。

- 预处理:对图像进行缩放、灰度化、滤波等处理,以减少噪声并标准化输入。

- 特征提取:使用cnns等技术从图像中提取特征。

- 分类:将提取的特征输入到训练好的模型中,进行手势分类。

- 后处理:对分类结果进行处理,如平滑、滤波,以提高识别的稳定性。

6.1 实际应用

在虚拟现实和增强现实环境中,手势识别可以用于控制虚拟对象、导航、游戏交互等。例如,用户可以通过手势来控制虚拟现实中的角色移动,或者在增强现实应用中通过手势来选择和操作虚拟物体。

示例代码

# 手势识别的简化流程示例

import cv2

import numpy as np

# 加载预训练的模型

model = tf.keras.models.load_model('gesture_model.h5')

# 打开摄像头

cap = cv2.videocapture(0)

while true:

# 读取摄像头的图像

ret, frame = cap.read()

# 预处理图像

gray = cv2.cvtcolor(frame, cv2.color_bgr2gray)

resized = cv2.resize(gray, (32, 32))

normalized = resized / 255.0

reshaped = np.reshape(normalized, (1, 32, 32, 1))

# 使用模型进行手势识别

prediction = model.predict(reshaped)

gesture = np.argmax(prediction)

# 显示识别结果

cv2.puttext(frame, str(gesture), (10, 30), cv2.font_hershey_simplex, 1, (0, 255, 0), 2)

cv2.imshow('gesture recognition', frame)

# 按'q'键退出

if cv2.waitkey(1) & 0xff == ord('q'):

break

# 释放摄像头资源

cap.release()

cv2.destroyallwindows()

6.2 结论

通过计算机视觉和深度学习技术,我们可以实现高效准确的手势识别,从而为虚拟现实和增强现实应用提供更自然、更直观的交互方式。手势识别不仅增强了用户体验,还为开发人员提供了新的设计空间,可以创建更加沉浸和互动的虚拟和增强现实环境。

手势识别技术详解

7. 基于图像的手势识别

7.1 原理

基于图像的手势识别技术主要依赖于计算机视觉中的图像处理和模式识别算法。它通过捕捉和分析单帧图像中的手部形状、位置和方向来识别特定的手势。这一过程通常包括手部检测、特征提取和手势分类三个步骤。

- 手部检测:使用肤色模型、边缘检测或机器学习方法从图像中分割出手部区域。

- 特征提取:从手部区域提取关键特征,如轮廓、关节位置或手部形状的几何特征。

- 手势分

发表评论