hdfs(hadoop distributed file system)是一种用于存储大规模数据的分布式文件系统,由于其高可靠性和高吞吐量的特点,被广泛应用于大数据处理环境中。为了确保数据的安全性,hdfs提供了一些身份验证机制,用于确保只有经过授权的用户能够访问存储在hdfs中的数据。本文将介绍hdfs的安全身份验证原理,包括kerberos和ldap两种身份验证方式,并提供相应的代码示例和参数介绍。

一、kerberos身份验证

kerberos是一种网络身份验证协议,它可以确保用户的身份在网络中得到认证,从而保证了数据的安全性。在hdfs中,kerberos用于对用户进行身份验证。下面是使用kerberos进行hdfs身份验证的代码示例:

- 创建kerberos认证配置文件krb5.conf:

| [libdefaults] default_realm = example.com udp_preference_limit = 1 kdc_timeout = 3000

[realms] example.com = { kdc = kdc.example.com admin_server = admin.example.com } |

- 启动kerberos认证服务(kdc)和管理员服务(kadmind)。

- 创建hdfs服务主体:

kadmin.local -q "addprinc -randkey hdfs/_host@example.com"

kadmin.local -q "addprinc -randkey hdfs/namenode.example.com@example.com"

kadmin.local -q "addprinc -randkey hdfs/datanode.example.com@example.com"

- 导出hdfs服务主体的服务密钥:

kadmin.local -q "ktadd -k hdfs.keytab hdfs/namenode.example.com@example.com"

kadmin.local -q "ktadd -k hdfs.keytab hdfs/datanode.example.com@example.com"

- 为hdfs服务配置kerberos认证:

| <configuration> <property> <name>dfs.namenode.kerberos.principal</name> <value>hdfs/namenode.example.com@example.com</value> </property> <property> <name>dfs.namenode.keytab.file</name> <value>/path/to/hdfs.keytab</value> </property> <property> <name>dfs.datanode.kerberos.principal</name> <value>hdfs/datanode.example.com@example.com</value> </property> <property> <name>dfs.datanode.keytab.file</name> <value>/path/to/hdfs.keytab</value> </property> </configuration> |

- 启动hdfs服务。

代码说明:

以上代码演示了如何使用kerberos进行hdfs身份验证,其中:

- 第1步配置了kerberos认证的相关参数,如默认realm、kdc和管理员服务地址等。

- 第3步创建了hdfs服务主体,其中"_host"表示任意主机名。

- 第4步导出了hdfs服务主体的服务密钥。

- 第5步配置了hdfs服务的kerberos认证参数,如主体和密钥文件等。

参数介绍:

- dfs.namenode.kerberos.principal:指定了namenode的kerberos主体。

- dfs.namenode.keytab.file:指定了namenode的服务密钥文件。

- dfs.datanode.kerberos.principal:指定了datanode的kerberos主体。

- dfs.datanode.keytab.file:指定了datanode的服务密钥文件。

二、ldap身份验证

ldap(lightweight directory access protocol)是一种用于访问和维护分布式目录信息的协议,它可以用于用户身份验证。在hdfs中,ldap用于对用户进行身份验证。下面是使用ldap进行hdfs身份验证的代码示例:

- 配置hdfs服务的ldap身份验证:

| <configuration> <property> <name>hadoop.security.authentication</name> <value>simple</value> </property> <property> <name>hadoop.security.auth_to_local</name> <value>default</value> </property> <property> <name>hadoop.security.auth_to_local.service</name> <value>rule:[2:$1@$0](.*@example\.com)s/@.*//</value> </property> <property> <name>hadoop.security.group.mapping</name> <value>org.apache.hadoop.security.ldapgroupsmapping</value> </property> <property> <name>hadoop.security.group.mapping.ldap.url</name> <value>ldap://ldap.example.com:389</value> </property> <property> <name>hadoop.security.group.mapping.ldap.bind.user</name> <value>cn=admin,dc=example,dc=com</value> </property> <property> <name>hadoop.security.group.mapping.ldap.bind.password.file</name> <value>/path/to/ldap.password</value> </property> <property> <name>hadoop.security.group.mapping.ldap.base</name> <value>dc=example,dc=com</value> </property> <property> <name>hadoop.security.group.mapping.ldap.search.filter.user</name> <value>(&(objectclass=person)(cn={0}))</value> </property> <property> <name>hadoop.security.group.mapping.ldap.search.filter.group</name> <value>(&(objectclass=groupofnames)(member={0}))</value> </property> </configuration> |

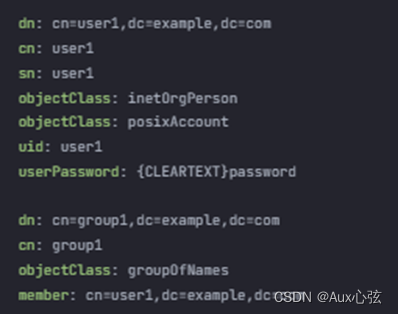

- 创建ldap用户和组:

| dn: cn=user1,dc=example,dc=com cn: user1 sn: user1 objectclass: inetorgperson objectclass: posixaccount uid: user1 userpassword: {cleartext}password

dn: cn=group1,dc=example,dc=com cn: group1 objectclass: groupofnames member: cn=user1,dc=example,dc=com |

- 启动hdfs服务。

代码说明:

以上代码演示了如何使用ldap进行hdfs身份验证,其中:

- 第1步配置了hdfs服务的ldap身份验证参数,如认证方式、认证规则、ldap服务器地址和绑定用户等。

- 第2步创建了ldap用户和组,其中"cn=user1,dc=example,dc=com"表示用户1的dn,"member: cn=user1,dc=example,dc=com"表示组1中包含用户1。

三、参数介绍

- hadoop.security.authentication:指定了hadoop安全认证的方式,这里使用的是简单认证。

- hadoop.security.auth_to_local:指定了身份映射规则,默认使用default规则。

- hadoop.security.auth_to_local.service:指定了自定义的身份映射规则,该规则将用户的kerberos主体转换为用户名。

- hadoop.security.group.mapping:指定了用户组映射类,这里使用的是ldapgroupsmapping。

- hadoop.security.group.mapping.ldap.url:指定了ldap服务器的url。

- hadoop.security.group.mapping.ldap.bind.user:指定了ldap服务器的管理员用户。

- hadoop.security.group.mapping.ldap.bind.password.file:指定了ldap服务器管理员用户的密码文件。

- hadoop.security.group.mapping.ldap.base:指定了ldap服务器的基本dn。

- hadoop.security.group.mapping.ldap.search.filter.user:指定了用户查询过滤器。

- hadoop.security.group.mapping.ldap.search.filter.group:指定了组查询过滤器。

总结:了hdfs的安全身份验证原理和相应的代码示例。这些身份验证机制可以帮助用户保护存储在hdfs中的数据的安全性。对于使用hdfs的大数据应用来说,选择合适的身份验证方式非常重要,以确保数据的机密性和完整性。

发表评论