定义:

1. token: 是文本或序列数据中的最小离散单元。在自然语言处理中,一个 token 可以是一个单词、一个子词(如字母、音节或子词片段),或一个字符,取决于任务和数据的预处理方式。这意味着文本中的每个 token 都代表着文本中的一个具体的、离散的信息单元。

2. tokens: 通常是文本数据的基本单位,将文本拆分成 tokens 有助于神经网络理解和处理文本信息。例如,句子 "i love deep learning" 可以被拆分成三个单词 tokens:["i", "love", "deep", "learning"]。

作用:

1. 表示文本数据:tokens 用于将文本转化为计算机可以理解的形式。通过将连续的文本数据拆分成离散的 tokens,每个 token 对应一个特定的文本元素,文本数据可以更容易地被处理和分析。

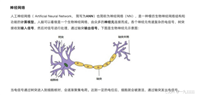

2. 输入神经网络:tokens 通常作为神经网络的输入。神经网络会将文本序列中的每个 token 编码为向量表示,以便进行后续的计算和处理。这些向量表示被称为嵌入(embeddings),它们将每个 token 映射到连续的向量空间中。

3. 序列建模:tokens 在序列数据建模中发挥关键作用。神经网络可以通过将 token 的向量表示传递给循环神经网络(rnn)、长短时记忆网络(lstm)、或变换器(transformer)等模型来建模序列数据,例如自然语言文本。这些模型能够捕捉到 tokens 之间的上下文关系,从而更好地理解序列数据。

4. 注意力机制:在自然语言处理中,注意力机制经常用于处理 tokens 之间的相关性。注意力机制允许神经网络动态地关注输入序列中的不同部分,以便更好地理解上下文关系。通过注意力机制,模型可以根据 tokens 之间的重要性来分配不同的权重。

5. 语言生成:tokens 也在语言生成任务中发挥关键作用。例如,在机器翻译中,模型可以生成一个 token(单词或子词)的序列,从而生成目标语言的翻译。生成的 tokens 组成了生成文本的基础。

6. 预训练模型:近年来,预训练模型(如bert、gpt 和 roberta)在自然语言处理任务中取得了巨大成功。这些模型通过在大规模文本上预训练,学会了识别和理解文本中的 tokens,并可以在各种 nlp 任务中进行微调。这些模型的关键在于它们的能力,能够捕捉到 tokens 之间的语义关系和上下文信息。

thus, tokens 是神经网络处理文本和序列数据的基本单位,通过将文本分解成 tokens 并将其表示为向量,神经网络能够更好地理解、建模和处理文本信息,这在自然语言处理等领域具有广泛的应用。这些 tokens 不仅用于表示文本数据,还在神经网络中作为输入、上下文建模、注意力机制和语言生成等方面发挥重要作用。

发表评论