1.背景介绍

1. 背景介绍

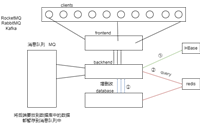

hbase和flink都是apache基金会下的开源项目,分别属于nosql数据库和流处理框架。hbase是基于hadoop的分布式数据库,主要用于存储大量数据并提供快速随机读写访问。flink是一个流处理框架,可以处理实时数据流和批处理任务。

在现代数据处理中,数据集成是一个重要的环节,涉及到数据的整合、清洗、转换和分析。为了更高效地处理大规模数据,需要将hbase和flink结合起来,实现数据集成。

本文将从以下几个方面进行深入探讨:

- hbase和flink的核心概念与联系

- hbase和flink的核心算法原理和具体操作步骤

- hbase和flink的最佳实践:代码实例和详细解释

- hbase和flink的实际应用场景

- 相关工具和资源推荐

- 未来发展趋势与挑战

2. 核心概念与联系

2.1 hbase核心概念

hbase是一个分布式、可扩展、高性能的列式存储数据库。它支持随机读写访问,并提供了数据的自动分区和负载均衡功能。hbase的核心概念包括:

- 表(table):hbase中的表是一种类似于关系数据库中表的数据结构,用于存储数据。表由一个名称和一组列族(column family)组成。

- 列族(column family):列族是表中所有列的容器,用于组织数据。列族内的列具有相同的数据类型和存储格式。

- 行(row):hbase中的行是表中数据的基本单位,由一个唯一的行键(row key)组成。行键可以是字符串、数字等类型。

- 列(column):列是表中数据的基本单位,由一个列键(column key)和一个值(value)组成。列键由列族和一个单独的键组成。

- 时间戳(timestamp):hbase中的数据具有时间戳,用于记录数据的创建或修改时间。时间戳可以是整数或长整数类型。

2.2 flink核心概念

flink是一个流处理框架,可以处理实时数据流和批处理任务。flink的核心概念包括:

- 数据流(datastream):flink中的数据流是一种无状态的数据序列,可以通过各种操作符(如map、filter、reduce等)进行处理。

- 数据集(dataset):flink中的数据集是一种有状态的数据序列,可以通过各种操作符(如map、filter、reduce等)进行处理。

- 源(source):flink中的源是数据流或数据集的来源,可以是文件、socket、kafka等。

- 接收器(sink):flink中的接收器是数据流或数据集的目的地,可以是文件、socket、kafka等。

- 操作符(operator):flink中的操作符是数据流或数据集的处理单元,可以是基本操作符(如map、filter、reduce等),也可以是自定义操作符。

2.3 hbase和flink的联系

hbase和flink的联系主要表现在以下几个方面:

- 数据源:flink可以将hbase表作为数据源,从中读取数据。

- 数据接收器:flink可以将处理结果写入hbase表,作为数据接收器。

- 数据集成:flink可以将hbase中的数据与其他数据源(如kafka、hdfs等)进行集成,实现数据的整合、清洗、转换和分析。

3. 核心算法原理和具体操作步骤

3.1 hbase的数据读写

hbase的数据读写操作主要通过api进行,如下所示:

3.1.1 数据读取

```java configuration conf = new configuration(); hbaseadmin admin = new hbaseadmin(conf); htable table = new htable(conf, "mytable");

scan scan = new scan(); result result = table.getscanner(scan).next(); ```

3.1.2 数据写入

```java configuration conf = new configuration(); hbaseadmin admin = new hbaseadmin(conf); htable table = new htable(conf, "mytable");

put put = new put(bytes.tobytes("row1")); put.add(bytes.tobytes("column1"), bytes.tobytes("value1")); table.put(put); ```

3.2 flink的数据处理

flink的数据处理操作主要通过api进行,如下所示:

3.2.1 数据读取

java streamexecutionenvironment env = streamexecutionenvironment.getexecutionenvironment(); datastream<string> text = env.readtextfile("input.txt");

3.2.2 数据写入

java datastream<string> output = text.map(new mapfunction<string, string>() { @override public string map(string value) { return value.touppercase(); } }); output.writeastext("output.txt");

3.3 hbase和flink的数据集成

为了实现hbase和flink的数据集成,需要将hbase作为flink的数据源和数据接收器。具体操作步骤如下:

3.3.1 数据源

java datastream<string> hbasesource = env.addsource(new flinkhbasetablesource<>("mytable", "row1", "column1"));

3.3.2 数据接收器

java datastream<string> hbasesink = env.addsink(new flinkhbasetablesink<>("mytable", "row1", "column1"));

4. 具体最佳实践:代码实例和详细解释

4.1 hbase和flink的数据集成示例

以下是一个hbase和flink的数据集成示例:

```java import org.apache.flink.api.common.functions.mapfunction; import org.apache.flink.api.java.tuple.tuple2; import org.apache.flink.streaming.api.datastream.datastream; import org.apache.flink.streaming.api.environment.streamexecutionenvironment; import org.apache.flink.streaming.connectors.hbase.flinkhbasetablesource; import org.apache.flink.streaming.connectors.hbase.flinkhbasetablesink;

public class hbaseflinkintegration { public static void main(string[] args) throws exception { streamexecutionenvironment env = streamexecutionenvironment.getexecutionenvironment();

// 读取hbase数据

datastream<string> hbasesource = env.addsource(new flinkhbasetablesource<>("mytable", "row1", "column1"));

// 数据处理

datastream<tuple2<string, integer>> processed = hbasesource.map(new mapfunction<string, tuple2<string, integer>>() {

@override

public tuple2<string, integer> map(string value) {

string[] parts = value.split(",");

return new tuple2<>(parts[0], integer.parseint(parts[1]));

}

});

// 写入hbase数据

processed.addsink(new flinkhbasetablesink<>("mytable", "row1", "column1"));

env.execute("hbaseflinkintegration");

}} ```

在上述示例中,我们首先通过flinkhbasetablesource读取hbase数据,然后通过map函数对数据进行处理,最后通过flinkhbasetablesink写入hbase数据。

4.2 解释

在这个示例中,我们使用了flink的hbase连接器来实现hbase和flink的数据集成。首先,我们通过flinkhbasetablesource读取hbase数据,然后通过map函数对数据进行处理,最后通过flinkhbasetablesink写入hbase数据。

具体来说,我们读取了hbase表“mytable”的“row1”行,并读取了“column1”列的数据。然后,我们使用map函数将读取到的数据进行处理,将数据分为两部分:一个是字符串类型的“name”,另一个是整数类型的“age”。最后,我们使用flinkhbasetablesink将处理后的数据写入hbase表“mytable”的“row1”行,并更新“column1”列的值。

5. 实际应用场景

hbase和flink的数据集成可以应用于以下场景:

- 实时数据分析:通过将hbase数据与实时数据流(如kafka、socket等)进行集成,实现对大数据集的实时分析。

- 数据清洗与转换:通过将hbase数据与其他数据源(如hdfs、hive等)进行集成,实现数据的清洗、转换和整合。

- 数据报表生成:通过将hbase数据与其他数据源(如mysql、postgresql等)进行集成,实现数据报表的生成和更新。

6. 工具和资源推荐

为了更好地进行hbase和flink的数据集成,可以使用以下工具和资源:

- hbase:官方文档(https://hbase.apache.org/book.html)、中文文档(https://hbase.apache.org/2.2/book.html.zh-cn.html)、社区论坛(https://groups.google.com/forum/#!forum/hbase-user)。

- flink:官方文档(https://flink.apache.org/docs/latest/)、中文文档(https://flink.apache.org/docs/latest/zh/)、社区论坛(https://flink.apache.org/community.html)。

- flink hbase connector:github仓库(https://github.com/ververica/flink-connector-hbase)、文档(https://ververica.github.io/flink-connector-hbase/)。

7. 总结:未来发展趋势与挑战

hbase和flink的数据集成已经得到了广泛应用,但仍然存在一些挑战:

- 性能优化:在大规模数据集中,hbase和flink的数据集成可能会导致性能瓶颈。需要进一步优化算法和数据结构,提高性能。

- 可扩展性:hbase和flink的数据集成需要支持大规模数据和多源集成。需要进一步研究和开发可扩展性解决方案。

- 容错性:在实际应用中,hbase和flink的数据集成可能会遇到故障和异常。需要进一步研究和开发容错性解决方案。

未来,hbase和flink的数据集成将继续发展,不断完善和优化,为大数据处理提供更高效、可靠的解决方案。

发表评论