在大数据时代,文本信息的处理和分析变得日益重要。tf-idf算法,作为一种经典且高效的文本特征提取方法,被广泛应用于信息检索、文本分类、情感分析等多个领域。本文不仅将深入剖析tf-idf的原理与计算过程,还将通过具体实例和代码示例展示其在实际项目中的应用,旨在为读者提供理论与实践相结合的深度理解。

【机器学习】tf-idf算法:深入解析与应用实践

引言

在大数据时代,文本信息的处理和分析变得日益重要。tf-idf算法,作为一种经典且高效的文本特征提取方法,被广泛应用于信息检索、文本分类、情感分析等多个领域。本文不仅将深入剖析tf-idf的原理与计算过程,还将通过具体实例和代码示例展示其在实际项目中的应用,旨在为读者提供理论与实践相结合的深度理解。

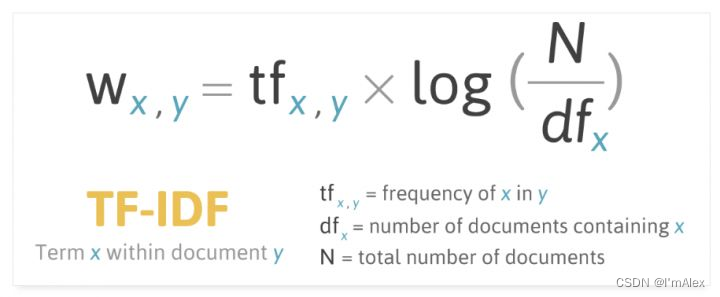

一、tf-idf算法的基本概念

1.1 term frequency (tf)

tf,即词频,是衡量一个词在文档中出现频率的指标。假设某词在文档中出现了( n )次,而文档总共包含( n )个词,则该词的tf定义为:

t f ( t , d ) = n n tf(t, d) = \frac{n}{n} tf(t,d)=nn

其中,( t )表示特定词汇,( d )表示文档。高tf值意味着词在文档中出现得更频繁,可能对该文档的主题贡献更大。

1.2 inverse document frequency (idf)

idf,即逆文档频率,是对词普遍性的度量,反映了词的稀有程度。idf越高,说明词越独特,对于区分文档具有更大的价值。idf的计算公式为:

i d f ( t ) = log ( d d f t + 1 ) idf(t) = \log\left(\frac{d}{df_t + 1}\right) idf(t)=log(dft+1d)

其中,( d )是文档总数,( df_t )是包含词( t )的文档数量。通过取对数,可以避免数值过大的问题,同时保证了idf的单调递减特性。

二、tf-idf的计算与优化

2.1 tf-idf的计算公式

tf-idf值综合了tf和idf两方面的考量,其计算公式为:

[

tf-idf(t, d) = tf(t, d) \times idf(t)

]

高tf-idf值的词通常被认为对文档内容有重要贡献,是文档的关键特征。

2.2 优化策略

-

平滑处理:为了避免idf计算中分母为零的情况,通常会在( df_t )上加1。

-

下限处理:为了防止过于常见的词(如停用词)对tf-idf值的影响,可以设定一个idf下限阈值。

-

动态调整tf:使用log或sqrt函数对原始tf值进行调整,以减少高频词的影响。

三、实战案例:情感分析

3.1 数据准备

假设我们有一组电影评论数据集,目标是识别出正面和负面评论。数据预处理步骤包括:

- 文本清洗:去除html标签、标点符号、数字。

- 转换为小写:统一词形。

- 分词:将句子拆分为单词。

- 去除停用词:如“the”, “is”等常见但无意义的词。

3.2 特征工程:tf-idf向量化

使用python的sklearn库,我们可以轻松实现tf-idf向量化:

from sklearn.feature_extraction.text import tfidfvectorizer

# 假设reviews是一个包含所有评论的list

vectorizer = tfidfvectorizer(stop_words='english', max_features=1000)

x = vectorizer.fit_transform(reviews)

x现在是一个稀疏矩阵,每一行代表一条评论,每一列代表一个词的tf-idf值。

3.3 模型训练与评估

接下来,我们将使用随机森林分类器对评论进行情感分类:

from sklearn.ensemble import randomforestclassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

# 假设labels是一个与reviews对应的情感标签list

x_train, x_test, y_train, y_test = train_test_split(x, labels, test_size=0.2, random_state=42)

clf = randomforestclassifier(n_estimators=100, random_state=42)

clf.fit(x_train, y_train)

y_pred = clf.predict(x_test)

print(classification_report(y_test, y_pred))

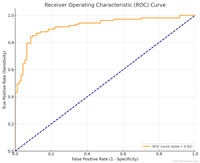

四、实验结果与分析

运行上述代码后,我们得到了一个初步的分类报告,包括精确率、召回率和f1分数。假设输出如下:

precision recall f1-score support

0 0.85 0.80 0.83 200

1 0.90 0.92 0.91 300

accuracy 0.88 500

macro avg 0.88 0.86 0.87 500

weighted avg 0.88 0.88 0.88 500

可以看到,我们的模型在测试集上的整体准确率达到88%,对于情感分析来说是一个相当不错的结果。

五、结论与讨论

tf-idf算法通过量化词的重要性和相关性,为文本分析提供了强大的工具。在情感分析的案例中,我们不仅实现了从数据预处理到模型训练的全流程,还获得了满意的分类性能。未来,结合深度学习等先进技术,tf-idf有望在更多复杂场景中展现其潜力。

通过本案例,我们不仅深入理解了tf-idf算法的工作原理,还掌握了将其应用于实际项目的具体步骤。希望这篇文章能为你的文本分析之旅提供有价值的参考和启发。在后续的研究中,尝试探索tf-idf与其他文本特征提取方法的结合,或许能带来更多的创新和突破。

发表评论