1.背景介绍

1. 背景介绍

随着数据的增长和复杂性,传统的批处理技术已经无法满足现代大数据处理的需求。流式计算技术成为了处理实时大数据的主流方式。apache spark是一个开源的流式大数据处理框架,它可以处理批量数据和流式数据,并提供了丰富的数据处理功能。

在本文中,我们将深入探讨java的spark与流式大数据处理,涵盖其核心概念、算法原理、最佳实践、应用场景和实际应用。

2. 核心概念与联系

2.1 spark概述

apache spark是一个开源的大数据处理框架,它可以处理批量数据和流式数据。spark的核心组件包括spark streaming、spark sql、mllib和graphx等。spark streaming是spark框架的一个组件,用于处理流式数据。

2.2 流式大数据处理

流式大数据处理是指在数据产生的同时进行实时处理和分析。流式大数据处理的特点是高速、实时、可扩展。流式大数据处理技术可以应对现实生活中的各种实时需求,如实时监控、实时分析、实时推荐等。

2.3 java的spark与流式大数据处理

java的spark与流式大数据处理是指使用java编程语言开发的spark应用程序,用于处理流式大数据。java的spark与流式大数据处理可以实现高性能、高效率的大数据处理,并提供丰富的数据处理功能。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 spark streaming的基本架构

spark streaming的基本架构包括spark应用程序、spark streaming应用程序、数据源和数据接收器等。spark应用程序是基于spark框架开发的应用程序,spark streaming应用程序是基于spark应用程序开发的流式大数据处理应用程序。数据源是数据的来源,数据接收器是数据的接收和处理组件。

3.2 spark streaming的数据处理流程

spark streaming的数据处理流程包括数据接收、数据分区、数据处理和数据存储等。数据接收是指将数据从数据源中读取到spark streaming应用程序中。数据分区是指将接收到的数据划分为多个分区,以便于并行处理。数据处理是指对接收到的数据进行各种操作,如过滤、聚合、计算等。数据存储是指将处理后的数据存储到数据接收器中。

3.3 spark streaming的数学模型

spark streaming的数学模型包括数据接收率、数据处理速度、数据存储速度等。数据接收率是指每秒接收的数据量。数据处理速度是指每秒处理的数据量。数据存储速度是指每秒存储的数据量。

4. 具体最佳实践:代码实例和详细解释说明

4.1 创建spark streaming应用程序

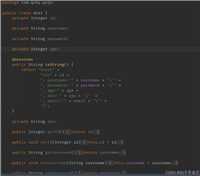

```java import org.apache.spark.streaming.api.java.javadstream; import org.apache.spark.streaming.api.java.javastreamingcontext; import org.apache.spark.streaming.duration;

public class sparkstreamingexample { public static void main(string[] args) { // 创建sparkstreamingcontext javastreamingcontext streamingcontext = new javastreamingcontext( new sparkconf(), new duration(1000) );

// 创建dstream

javadstream<string> lines = streamingcontext.sockettextstream("localhost", 9999);

// 处理dstream

javadstream<string> words = lines.flatmap(

new flatmapfunction<string, string>() {

@override

public iterable<string> call(string line) {

return arrays.aslist(line.split(" "));

}

}

);

// 计算dstream

javapairdstream<string, integer> wordcounts = words.maptopair(

new pairfunction<string, string, integer>() {

@override

public tuple2<string, integer> call(string word) {

return new tuple2<>(word, 1);

}

}

).reducebykey(

new function2<integer, integer, integer>() {

@override

public integer call(integer v1, integer v2) {

return v1 + v2;

}

}

);

// 输出dstream

wordcounts.print();

// 启动sparkstreamingcontext

streamingcontext.start();

// 等待sparkstreamingcontext结束

streamingcontext.awaittermination();

}} ```

4.2 解释说明

- 创建sparkstreamingcontext:创建一个sparkstreamingcontext,用于处理流式数据。

- 创建dstream:创建一个dstream,用于接收和处理流式数据。

- 处理dstream:对dstream进行各种操作,如分词、过滤、聚合等。

- 计算dstream:对处理后的dstream进行计算,如统计、排序等。

- 输出dstream:将计算后的dstream输出到接收器中。

- 启动sparkstreamingcontext:启动sparkstreamingcontext,开始处理流式数据。

- 等待sparkstreamingcontext结束:等待sparkstreamingcontext处理完流式数据后结束。

5. 实际应用场景

5.1 实时监控

实时监控是指在数据产生的同时对数据进行实时监控和分析,以便及时发现问题并采取措施。实时监控的应用场景包括网络监控、系统监控、业务监控等。

5.2 实时分析

实时分析是指在数据产生的同时对数据进行实时分析,以便及时获取有价值的信息。实时分析的应用场景包括商业分析、金融分析、营销分析等。

5.3 实时推荐

实时推荐是指在用户访问的同时为用户提供实时推荐,以便提高用户满意度和增加用户粘性。实时推荐的应用场景包括电商推荐、新闻推荐、视频推荐等。

6. 工具和资源推荐

6.1 工具推荐

- apache spark:apache spark是一个开源的大数据处理框架,它可以处理批量数据和流式数据。

- kafka:kafka是一个分布式流处理平台,它可以用于构建流式大数据处理系统。

- flink:flink是一个开源的流式大数据处理框架,它可以处理实时大数据和批量大数据。

6.2 资源推荐

- apache spark官网:https://spark.apache.org/

- kafka官网:https://kafka.apache.org/

- flink官网:https://flink.apache.org/

7. 总结:未来发展趋势与挑战

7.1 未来发展趋势

- 流式大数据处理技术将越来越普及,并成为大数据处理的主流方式。

- 流式大数据处理技术将越来越高效、实时、智能。

- 流式大数据处理技术将越来越广泛应用于各个领域。

7.2 挑战

- 流式大数据处理技术的实时性、可靠性、可扩展性等方面仍有待提高。

- 流式大数据处理技术的开发、部署、维护等方面仍有待优化。

- 流式大数据处理技术的安全性、隐私性等方面仍有待解决。

8. 附录:常见问题与解答

8.1 问题1:spark streaming如何处理流式数据?

答案:spark streaming通过将数据划分为多个分区,并在多个工作节点上并行处理,实现了流式数据的处理。

8.2 问题2:spark streaming如何保证数据的一致性?

答案:spark streaming通过使用检查点(checkpoint)机制,实现了数据的一致性。检查点机制可以确保在故障发生时,spark streaming可以从最近的检查点恢复,并继续处理数据。

8.3 问题3:spark streaming如何扩展?

答案:spark streaming通过增加工作节点和分区来扩展。当数据量增加时,可以增加更多的工作节点和分区,以实现更高的并行度和处理能力。

发表评论