==================================================================

hadoop1.0由分布式存储系统hdfs和分布式计算框架mapreduce组成,其中hdfs由一个namenode和多个datenode组成,mapreduce由一个jobtracker和多个tasktracker组成。

hadoop2.0为克服hadoop1.0中的不足进行了下面改进:

-

针对hadoop1.0单namenode制约hdfs的扩展性问题,提出hdfs federation,它让多个namenode分管不同的目录进而实现访问隔离和横向扩展,同时彻底解决了namenode单点故障问题;

-

针对hadoop1.0中的mapreduce在扩展性和多框架支持等方面的不足,它将jobtracker中的资源管理和作业控制分开,分别由resourcemanager(负责所有应用程序的资源分配)和applicationmaster(负责管理一个应用程序)实现,即引入了资源管理框架yarn。

-

yarn作为hadoop2.0中的资源管理系统,它是一个通用的资源管理模块,可为各类应用程序进行资源管理和调度,不仅限于mapreduce一种框架,也可以为其他框架使用,如tez、spark、storm等

mapreduce1.0

mapreduce1.0计算框架主要由三部分组成:编程模型、数据处理引擎和运行时环境。

| 组成 | 说明 |

| — | :-- |

| 编程模型 | map和reduce两个阶段. |

| 数据处理引擎 | 由maptask和reducetask组成 |

| 运行时环境 | 由一个jobtracker和若干个tasktracker两类服务组成 |

基本编程模型是将问题抽象成map和reduce两个阶段。map阶段将输入的数据解析成key/value,迭代调用map()函数处理后,再以key/value的形式输出到本地目录,reduce阶段将key相同的value进行规约处理,并将最终结果写到hdfs上。

数据处理引擎由maptask和reducetask组成,分别负责map阶段逻辑和reduce阶段的逻辑处理;

运行时环境由一个jobtracker和若干个tasktracker两类服务组成,其中jobtracker负责资源管理和所有作业的控制,tasktracker负责接收来自jobtracker的命令并执行它。

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、oppo等大厂,18年进入阿里一直到现在。

深知大多数java工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年java开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

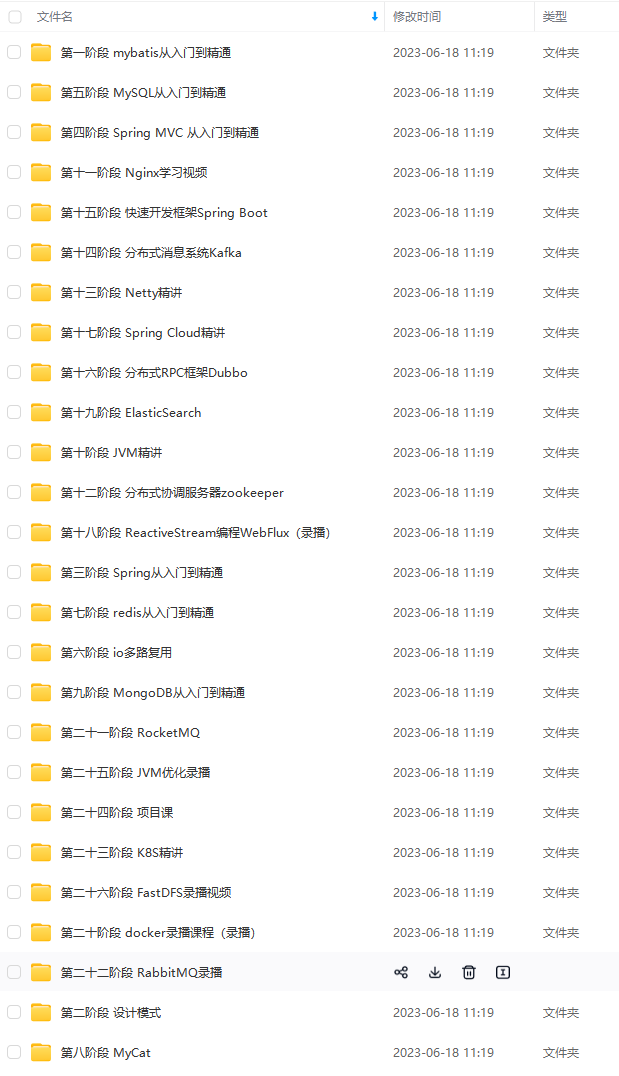

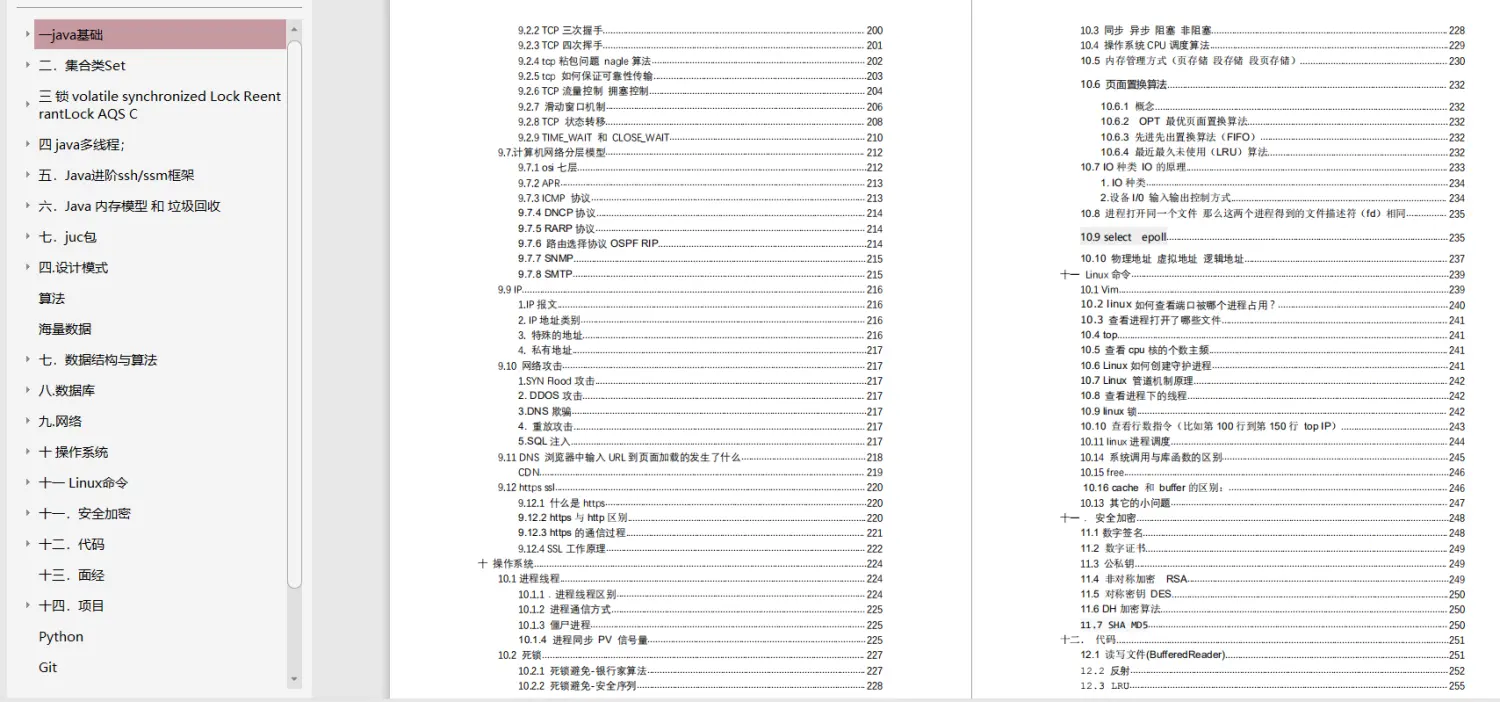

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上java开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注java获取)

写在最后

很多人感叹“学习无用”,实际上之所以产生无用论,是因为自己想要的与自己所学的匹配不上,这也就意味着自己学得远远不够。无论是学习还是工作,都应该有主动性,所以如果拥有大厂梦,那么就要自己努力去实现它。

最后祝愿各位身体健康,顺利拿到心仪的offer!

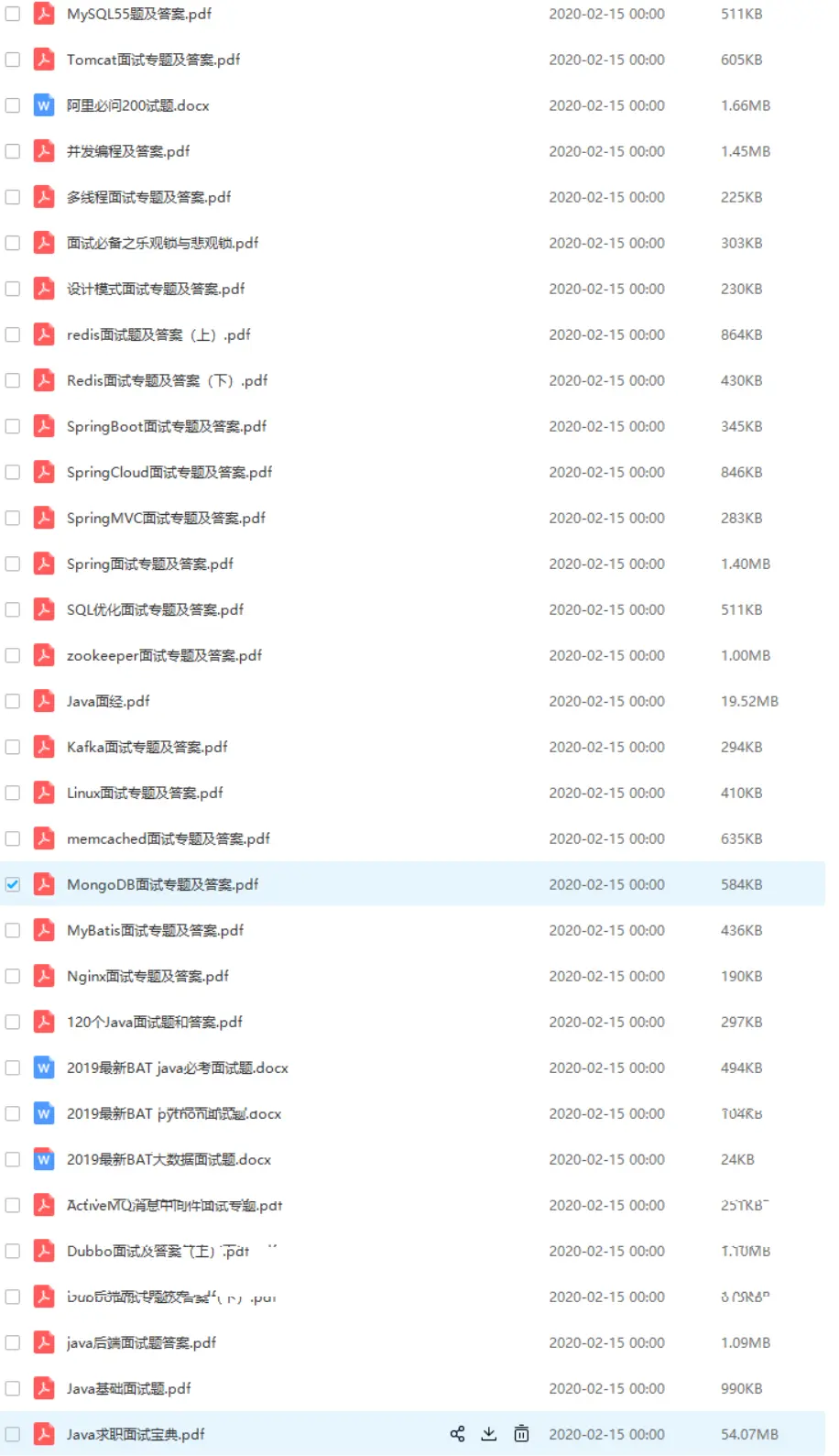

由于文章的篇幅有限,所以这次的蚂蚁金服和京东面试题答案整理在了pdf文档里

《一线大厂java面试题解析+核心总结学习笔记+最新讲解视频+实战项目源码》,

厂java面试题解析+核心总结学习笔记+最新讲解视频+实战项目源码》,**

发表评论