个人主页:欢迎来到 papicatch的博客

课设专栏 :

专业知识专栏:

文章目录

🍌归纳迁移学习(inductive transfer learning):

🍌直推式迁移学习(transductive transfer learning):

🍌跨领域迁移学习(cross-domain transfer learning):

🍌实例迁移学习(instance transfer learning):

🍌特征迁移学习(feature transfer learning):

🍌参数迁移学习(parameter transfer learning):

🍉引言

在当今数字化和智能化的时代,数据的价值日益凸显,而如何高效地利用数据成为了摆在研究者和从业者面前的重要课题。迁移学习作为一种创新的机器学习方法,应运而生,为解决数据利用和知识迁移的难题提供了全新的思路和有力的工具。

迁移学习旨在将从一个或多个相关领域中学习到的知识和模式,应用到新的、但具有一定相似性的领域或任务中。它打破了传统机器学习中每个任务都需要大量特定标注数据的限制,使得我们能够在数据稀缺的情况下,借助已有的知识和经验,快速有效地开展新的学习和分析。

例如,在图像识别领域,我们可以利用在大规模自然图像数据集上训练好的模型,将其迁移到医学图像诊断任务中,从而节省大量的训练时间和数据标注成本。同样,在语言处理中,从大规模通用文本数据中学习到的语言模型,可以被迁移到特定领域的文本分类或情感分析任务中。

🍉迁移学习

迁移学习(transfer learning) 是一种机器学习方法,其核心在于将从一个或多个源领域(source domain)和源任务(source task)中学习到的知识、模式或模型参数,有效地应用到目标领域(target domain)和目标任务(target task)中。

具体来说,迁移学习旨在利用已有的相关数据和模型的学习成果,来改善在新的、但具有一定相关性的任务中的学习效果。这种方法突破了传统机器学习中每个任务都需要独立收集大量特定标注数据并从头开始训练模型的限制。

例如,假如在一个大规模的图像数据集(如 imagenet)上训练了一个深度卷积神经网络来识别各种常见物体,这就是源任务。当我们想要构建一个模型来识别特定类型的医学图像中的病变时,就可以将在 imagenet 上学到的关于图像特征提取和分类的知识,迁移到这个新的医学图像识别任务中,这就是目标任务。

迁移学习的关键在于发现源领域和目标领域之间的相似性和相关性,并利用这些共性来加速和优化目标任务的学习过程。这可能涉及到对源模型的参数调整、特征选择和转换,或者采用特定的适应策略来弥合源领域和目标领域的数据分布差异。

在实际应用中,迁移学习具有诸多优势,如减少目标任务所需的数据标注量、降低训练成本、提高模型的收敛速度和泛化能力等。它使得在数据稀缺或新领域探索等场景下,能够更高效地构建有效的机器学习模型。

🍈基本概念

🍍定义

通过在源领域(source domain)或任务(source task)中学得的知识来帮助目标领域(target domain)或任务(target task)的学习。其利用已有的模型或知识,减少在目标任务中对大规模标注数据的依赖。

🍍类型

🍌归纳迁移学习(inductive transfer learning):

🍌直推式迁移学习(transductive transfer learning):

🍌跨领域迁移学习(cross-domain transfer learning):

🍌实例迁移学习(instance transfer learning):

🍌特征迁移学习(feature transfer learning):

🍌参数迁移学习(parameter transfer learning):

🍍优势

🍌数据高效性

🍌节省时间和计算资源

🍌提高模型性能

🍌跨领域应用:

🍌加速创新和研究

🍍缺点

🍌负迁移问题

🍌领域适配难度

🍌模型复杂度增加

🍌隐私和法律问题

🍌依赖已有模型

🍈核心方法

🍍基于实例的迁移学习

这种方法的核心思想是从源域中选择对目标域学习有帮助的实例数据,并将其与目标域数据一起用于模型训练。

🍍基于特征的迁移学习

重点在于将源域和目标域的数据映射到一个共同的特征空间,使得在这个空间中,源域和目标域的数据分布尽可能相似,从而便于模型学习。

🍍基于模型的迁移学习

利用源域训练好的模型,并将其应用于目标域的学习任务。

🍍基于关系的迁移学习

关注源域和目标域数据之间的关系,利用这些关系进行知识迁移。

🍈应用领域

🍍计算机视觉

🍍自然语言处理

🍍医疗领域

🍍金融领域

🍍工业领域

🍍教育领域

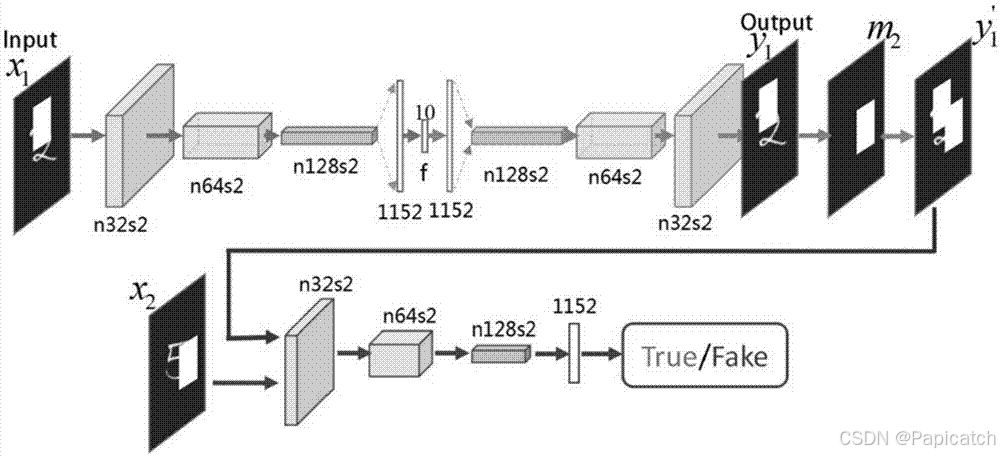

🍉vgg16实现图像风格转移

🍈步骤

🍍环境及数据集准备

🍍原理理解

🍈代码实现

构建预训练的 vgg16 模型:可以参考如下示例代码创建一个简化的 vgg16 模型,以便提取中间层的输出。

import torch

import torch.nn as nn

from torchvision.models import vgg16

class vgg16(nn.module):

def __init__(self):

super(vgg16, self).__init__()

features = list(vgg16(pretrained=true).features)[:] # 加载预训练的 vgg16 特征提取部分

self.features = nn.sequential(*features) # 使用 sequential 容器组合各层

def forward(self, x):

outputs = []

for layer in self.features:

x = layer(x)

if isinstance(layer, nn.relu): # 如果是 relu 激活层

outputs.append(x) # 保存该层的输出

return outputs加载内容图片和风格图片,并进行预处理,例如调整大小、转换为张量等。

定义内容损失(content_loss)和风格损失(style_loss)类,用于计算相应的损失。示例代码如下:

class content_loss(torch.nn.module):

def __init__(self, weight, target):

super(content_loss, self).__init__()

self.weight = weight

self.target = target.detach() * weight # 将目标内容从计算图中分离

self.loss_fn = torch.nn.mseloss() # 使用均方误差作为损失函数

def forward(self, input):

self.loss = self.loss_fn(input * self.weight, self.target)

return input

class style_loss(torch.nn.module):

def __init__(self, weight, target):

super(style_loss, self).__init__()

self.weight = weight

self.target = target.detach() * weight

self.loss_fn = torch.nn.mseloss()

self.gram = gram_matrix() # 用于计算 gram 矩阵

def forward(self, input):

self.gram = self.gram(input.clone()) # 计算输入的 gram 矩阵并乘以权重

self.gram.mul_(self.weight)

return input

class gram_matrix(torch.nn.module):

def forward(self, input):

a, b, c, d = input.size()

feature = input.view(a * b, c * d) # 调整形状

gram = torch.mm(feature, feature.t()) # 计算 gram 内积

return gram.div(a * b * c * d) # 归一化进行风格迁移的训练过程,将生成图片输入到风格迁移网络中,计算内容损失和风格损失,并反向传播更新生成图片的参数。训练步骤大致如下:

通过不断迭代训练,生成的图片会逐渐在内容上与内容图片相似,在风格上与风格图片相似,从而实现图像风格的转移。

请注意,实际实现中可能需要根据具体情况进行一些调整和优化,例如调整损失函数的权重、选择不同的 vgg16 层、使用不同的优化算法等,以获得更好的风格迁移效果。此外,还可以参考相关的开源项目和代码示例,以便更深入地理解和实现图像风格转移任务。上述代码只是一个简单的示例,实际应用中可能需要更复杂的架构和处理逻辑。

🍉总结

迁移学习是机器学习领域中一项极具创新性和实用价值的技术。它打破了传统机器学习中每个任务都需从零开始训练模型的局限性,通过巧妙地利用已在相关领域或任务中积累的知识和经验,极大地提高了学习效率和模型性能。

在迁移学习中,我们可以从大规模的、通用的数据源中获取有价值的信息,并将其应用到特定的、数据稀缺的目标任务中。这种跨领域和任务的知识迁移不仅节省了大量的数据标注时间和计算资源,还能够在目标任务数据有限的情况下,使模型快速达到较好的效果。

迁移学习的方法多种多样,包括基于实例、特征、模型和关系的迁移等。每种方法都有其独特的优势和适用场景,能够根据具体问题灵活选择和组合使用。

在实际应用中,迁移学习已经在计算机视觉、自然语言处理、医疗、金融、工业等众多领域取得了显著的成果。例如在图像分类、文本情感分析、疾病诊断、风险评估等任务中,迁移学习都发挥了重要作用,为解决实际问题提供了高效且准确的解决方案。

然而,迁移学习也并非完美无缺,可能存在负迁移、领域适配困难、模型复杂度增加等问题。但随着技术的不断发展和研究的深入,相信这些问题将逐步得到解决,迁移学习也将在未来的人工智能发展中发挥更加重要的作用,为推动各领域的智能化进程做出更大的贡献。

总的来说,迁移学习为我们提供了一种更智能、高效的数据利用方式,是机器学习领域的一个重要发展方向。

发表评论