🧡💛💚tensorflow2实战-系列教程 总目录

1、项目介绍

基本流程:

- 数据预处理:图像数据处理,准备训练和验证数据集

- 卷积网络模型:构建网络架构

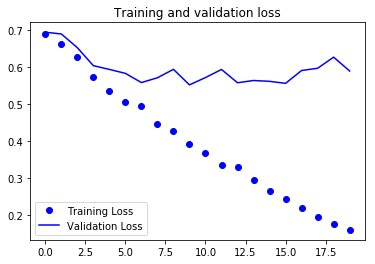

- 过拟合问题:观察训练和验证效果,针对过拟合问题提出解决方法

- 数据增强:图像数据增强方法与效果

- 迁移学习:深度学习必备训练策略

在我们的数据中,有训练和验证,训练集中分别有猫狗两个类别,都有1000张图像,验证集则有500张

2、数据读取

import os

import warnings

warnings.filterwarnings("ignore")

import tensorflow as tf

from tensorflow.keras.optimizers import adam

from tensorflow.keras.preprocessing.image import imagedatagenerator

# 数据所在文件夹

base_dir = './data/cats_and_dogs'

train_dir = os.path.join(base_dir, 'train')

validation_dir = os.path.join(base_dir, 'validation')

# 训练集

train_cats_dir = os.path.join(train_dir, 'cats')

train_dogs_dir = os.path.join(train_dir, 'dogs')

# 验证集

validation_cats_dir = os.path.join(validation_dir, 'cats')

validation_dogs_dir = os.path.join(validation_dir, 'dogs')

- 导包

- 指定数据路径

- 训练数据路径

- 验证数据路径

- 训练数据猫类别路径

- 训练数据狗类别路径

- 验证数据猫类别路径

- 训练数据狗类别路径

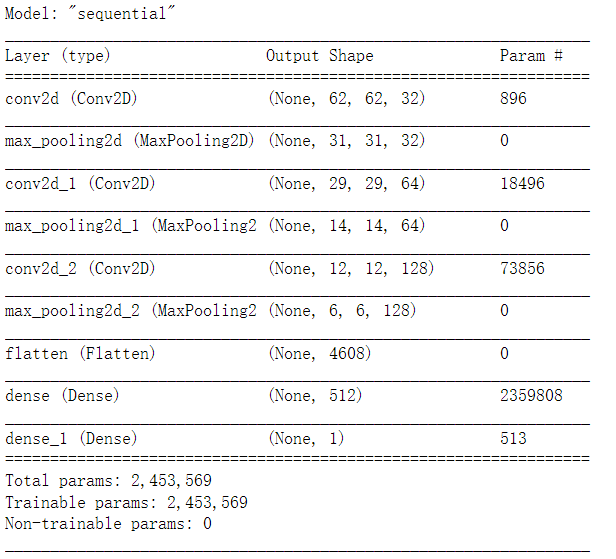

3、构建卷积神经网络

model = tf.keras.models.sequential([

#如果训练慢,可以把数据设置的更小一些

tf.keras.layers.conv2d(32, (3,3), activation='relu', input_shape=(64, 64, 3)),

tf.keras.layers.maxpooling2d(2, 2),

tf.keras.layers.conv2d(64, (3,3), activation='relu'),

tf.keras.layers.maxpooling2d(2,2),

tf.keras.layers.conv2d(128, (3,3), activation='relu'),

tf.keras.layers.maxpooling2d(2,2),

#为全连接层准备

tf.keras.layers.flatten(),

tf.keras.layers.dense(512, activation='relu'),

# 二分类sigmoid就够了

tf.keras.layers.dense(1, activation='sigmoid')

])

3个3x3卷积,穿插3个2x2池化,拉平操作,两个全连接层

model.summary()

打印一下模型架构:

配置训练器:

model.compile(loss='binary_crossentropy', optimizer=adam(lr=1e-4), metrics=['acc'])

4、数据预处理

- 读进来的数据会被自动转换成tensor(float32)格式,分别准备训练和验证

- 图像数据归一化(0-1)区间

train_datagen = imagedatagenerator(rescale=1./255)

test_datagen = imagedatagenerator(rescale=1./255)

train_generator = train_datagen.flow_from_directory(

train_dir, # 文件夹路径

target_size=(64, 64), # 指定resize成的大小

batch_size=20,

# 如果one-hot就是categorical,二分类用binary就可以

class_mode='binary')

validation_generator = test_datagen.flow_from_directory(

validation_dir,

target_size=(64, 64),

batch_size=20,

class_mode='binary')

打印结果:

found 2000 images belonging to 2 classes.

found 1000 images belonging to 2 classes.

5、模型训练

- 直接fit也可以,但是通常咱们不能把所有数据全部放入内存,fit_generator相当于一个生成器,动态产生所需的batch数据

- steps_per_epoch相当给定一个停止条件,因为生成器会不断产生batch数据,说白了就是它不知道一个epoch里需要执行多少个step

history = model.fit_generator(

train_generator,

steps_per_epoch=100, # 2000 images = batch_size * steps

epochs=20,

validation_data=validation_generator,

validation_steps=50, # 1000 images = batch_size * steps

verbose=2)

部分打印结果:

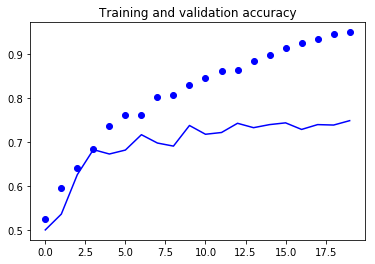

epoch 1/20 100/100 - 9s - loss: 0.6909 - acc: 0.5240 - val_loss: 0.6952 - val_acc: 0.5000

epoch 2/20 100/100 - 9s - loss: 0.6645 - acc: 0.5960 - val_loss: 0.6906 - val_acc: 0.5360

…

epoch 19/20 100/100 - 9s - loss: 0.1750 - acc: 0.9460 - val_loss: 0.6277 - val_acc: 0.7390

epoch 20/20 100/100 - 9s - loss: 0.1593 - acc: 0.9505 - val_loss: 0.5901 - val_acc: 0.7490

6、预测效果展示

import matplotlib.pyplot as plt

acc = history.history['acc']

val_acc = history.history['val_acc']

loss = history.history['loss']

val_loss = history.history['val_loss']

epochs = range(len(acc))

plt.plot(epochs, acc, 'bo', label='training accuracy')

plt.plot(epochs, val_acc, 'b', label='validation accuracy')

plt.title('training and validation accuracy')

plt.figure()

plt.plot(epochs, loss, 'bo', label='training loss')

plt.plot(epochs, val_loss, 'b', label='validation loss')

plt.title('training and validation loss')

plt.legend()

plt.show()

将训练损失、准确率和对应的epoch分别画图展示

发表评论