引言:无处不在的文本模式——为什么正则表达式是必备技能?

在数据处理、web 爬虫、日志分析、文本清洗和验证等众多领域,我们面对的最常见的数据类型之一就是非结构化的文本数据。这些数据看似杂乱无章,但其内部往往隐藏着某种“模式”(pattern):可能是特定格式的电话号码、邮箱地址,可能是html/xml标签,也可能是日志文件中由空格分隔的特定字段。

手动编写字符串方法(如 find(), split())来处理这些模式,不仅繁琐、容易出错,而且代码难以维护。此时,正则表达式(regular expression,简称 regex) 便闪亮登场。它是一种强大而灵活的文本处理工具,使用一种“模式字符串”来描述、匹配和操作文本,堪称程序员手中的“文本瑞士军刀”。

掌握正则表达式,意味着你获得了一种直接、高效表达复杂文本模式的能力。本章将带你从零基础到精通,深入探索 python 中 re 模块的方方面面,并通过大量贴近实战的案例,让你真正学会如何将这门“武器”应用于真实的数据处理任务中。

第一部分:正则表达式基础——从读懂到编写

1.1 初识正则:什么是正则表达式?

简单来说,正则表达式就是由普通字符(例如字母 ‘a’ 到 ‘z’)和特殊字符(称为"元字符")组成的文字模式。该模式描述在搜索文本时要匹配的一个或多个字符串。

例如,模式 \d{3}-\d{3}-\d{4} 可以匹配北美电话号码格式 123-456-7890。

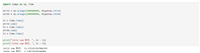

1.2 python re 模块初探

python 通过 re 模块提供了完整的正则表达式功能。

import re

# 最简单的例子:在字符串中查找 'hello'

text = "world hello python"

pattern = "hello"

# re.search() 扫描整个字符串,返回第一个匹配的match对象

match = re.search(pattern, text)

if match:

print(f"found '{match.group()}' at position {match.start()} to {match.end()}")

# 输出: found 'hello' at position 6 to 11

1.3 核心元字符详解(构建模式的基石)

元字符是正则表达式的灵魂。以下是必须掌握的核心元字符:

| 元字符 | 描述 | 示例 | 匹配示例 |

|---|---|---|---|

. | 匹配任意一个字符(除换行符) | a.b | aab, a7b, a%b |

^ | 匹配字符串的开始 | ^hello | hello world (中的hello) |

$ | 匹配字符串的结束 | world$ | hello world (中的world) |

* | 匹配前一个字符0次或多次 | ab*c | ac, abc, abbc, abbbc |

+ | 匹配前一个字符1次或多次 | ab+c | abc, abbc, abbbc (非ac) |

? | 匹配前一个字符0次或1次 | ab?c | ac, abc (非abbc) |

{m,n} | 匹配前一个字符m到n次 | a{2,4}b | aab, aaab, aaaab |

[...] | 匹配字符集合中的任意一个字符 | [aeiou] | 任何一个元音字母 |

[^...] | 否定字符集合,匹配不在其中的字符 | [^0-9] | 任意一个非数字字符 |

| ` | ` | 或,匹配左右任意一个表达式 | `cat |

( ... ) | 1. 分组,将被括起来的内容作为一个整体 | ||

| 2. 捕获,匹配的内容会被单独保存 |

1.4 特殊序列(常用字符集的简写)

| 特殊序列 | 描述 | 等价于 |

|---|---|---|

\d | 匹配任意数字 | [0-9] |

\d | 匹配任意非数字 | [^0-9] |

\s | 匹配任意空白字符(空格、tab、换行等) | [ \t\n\r\f\v] |

\s | 匹配任意非空白字符 | [^ \t\n\r\f\v] |

\w | 匹配任意字母数字和下划线(单词字符) | [a-za-z0-9_] |

\w | 匹配任意非单词字符 | [^a-za-z0-9_] |

\b | 匹配一个单词的边界(开头或结尾) | n/a |

实战示例 1.1:验证简单的用户名格式

要求:用户名必须以字母开头,长度在4-16字符之间,只能包含字母、数字和下划线。

import re

def validate_username(username):

pattern = r'^[a-za-z]\w{3,15}$'

# ^[a-za-z] : 必须以字母开头

# \w{3,15} : 后面跟3到15个单词字符(总长度就是4-16)

# $ : 必须以此结尾

if re.fullmatch(pattern, username): # fullmatch确保整个字符串匹配模式

return true

else:

return false

print(validate_username("alice123")) # true

print(validate_username("alice")) # true (长度4)

print(validate_username("23alice")) # false (数字开头)

print(validate_username("a")) # false (太短)

print(validate_username("alice!#")) # false (包含非法字符)

第二部分:pythonre模块核心方法——匹配、搜索、查找与替换

了解了基础语法后,我们来看看如何在 python 中具体使用它们。re 模块提供了多个函数来执行不同的操作。

2.1 re.match() vs re.search()

re.match(pattern, string): 仅从字符串的起始位置开始匹配。如果起始位置不匹配,即使后面有符合的也不会匹配成功。re.search(pattern, string): 扫描整个字符串,返回第一个成功的匹配。

text = "the price is 100 dollars" print(re.match(r'\d+', text)) # none (开头不是数字) print(re.search(r'\d+', text)) # <re.match object; span=(12, 15), match='100'>

2.2 re.findall() & re.finditer():全局查找

re.findall(pattern, string): 返回字符串中所有非重叠匹配的列表。如果模式中有分组,则返回分组元组的列表。re.finditer(pattern, string): 返回一个迭代器,包含所有匹配的match对象。对于大量数据,此方法更节省内存。

text = "apple: $1.99, banana: $0.50, orange: $2.00"

# 提取所有价格

prices = re.findall(r'\$\d+\.\d\d', text) # \.$ 转义,匹配真正的美元符号

print(prices) # ['$1.99', '$0.50', '$2.00']

# 使用finditer获取更多信息(如位置)

for match in re.finditer(r'\$\d+\.\d\d', text):

print(f"found {match.group()} at {match.span()}")

# found $1.99 at (7, 12)

# found $0.50 at (23, 28)

# found $2.00 at (38, 43)

2.3 re.sub() & re.subn():搜索与替换

re.sub(pattern, repl, string, count=0): 将字符串中所有匹配模式的地方替换为repl字符串,返回替换后的新字符串。re.subn(pattern, repl, string, count=0): 功能同sub(),但返回一个元组(新字符串, 替换次数)。

repl 可以是一个字符串,也可以是一个可调用对象(函数)。

text = "today is 2023-10-27. the meeting is on 2023-11-01."

# 将日期格式从 yyyy-mm-dd 改为 dd/mm/yyyy

# 使用分组 \1, \2, \3 来引用前面匹配的内容

new_text = re.sub(r'(\d{4})-(\d{2})-(\d{2})', r'\3/\2/\1', text)

print(new_text) # today is 27/10/2023. the meeting is on 01/11/2023.

# 使用函数进行更复杂的替换(将所有年份加1)

def add_one_year(match_obj):

year = int(match_obj.group(1))

month = match_obj.group(2)

day = match_obj.group(3)

return f"{day}/{month}/{year + 1}" # 返回要替换成的字符串

new_text_func = re.sub(r'(\d{4})-(\d{2})-(\d{2})', add_one_year, text)

print(new_text_func) # today is 27/10/2024. the meeting is on 01/11/2024.

2.4 re.compile():预编译正则表达式

如果你需要重复使用同一个模式,强烈建议先将其编译成一个正则表达式对象。这能显著提高效率。

import re # 未编译模式,每次调用都要解释一遍模式 result1 = re.findall(r'\d+', text1) result2 = re.findall(r'\d+', text2) # 编译模式,只需解释一次 pattern_obj = re.compile(r'\d+') # 返回一个pattern对象 result1 = pattern_obj.findall(text1) result2 = pattern_obj.findall(text2) # 编译后的对象拥有所有re模块的方法:search, match, findall, sub等

第三部分:高级技巧与复杂模式处理

3.1 非捕获分组 (?:...)

有时我们需要用括号来进行分组(例如应用量词 (ab)+),但又不想捕获这个分组的内容(即不想占用 \1, \2 的编号),这时可以使用非捕获分组。

text = "https://www.example.com http://blog.example.org"

# 只想捕获域名,不需要协议这个分组

# 使用 (?:...) 表示非捕获分组

domains = re.findall(r'(?:https?://)(\w+\.\w+\.\w+)', text)

print(domains) # ['www.example.com', 'blog.example.org']

# 对比捕获分组,结果会包含协议

domains_with_protocol = re.findall(r'(https?://)(\w+\.\w+\.\w+)', text)

print(domains_with_protocol) # [('https://', 'www.example.com'), ('http://', 'blog.example.org')]

3.2 贪婪 vs 非贪婪匹配

量词(*, +, ?, {m,n})默认是贪婪的,它们会匹配尽可能多的字符。在量词后面加上一个 ?,就变成了非贪婪(或最小)匹配,它会匹配尽可能少的字符。

html_text = "<title>python regular expressions</title> <div>content</div>" # 贪婪匹配:.* 会匹配到最后一个 > 之前的所有字符 greedy_match = re.search(r'<.*>', html_text) print(greedy_match.group()) # <title>python regular expressions</title> <div>content</div> # 非贪婪匹配:.*? 在遇到第一个 > 后就停止匹配 non_greedy_match = re.search(r'<.*?>', html_text) print(non_greedy_match.group()) # <title>

3.3 lookahead 和 lookbehind 断言(零宽断言)

这是一种高级技巧,用于判断一个位置的前后是否满足某种条件,但这个条件本身并不消耗字符(即不包含在最终匹配结果中)。

| 语法 | 名称 | 作用 |

|---|---|---|

(?=...) | 正向前瞻断言 | 匹配位置后面必须是 ... |

(?!...) | 负向前瞻断言 | 匹配位置后面必须不是 ... |

(?<=...) | 正向后顾断言 | 匹配位置前面必须是 ... (定长) |

(?<!...) | 负向后顾断言 | 匹配位置前面必须不是 ... (定长) |

# 提取后面跟着 " dollars" 的数字 text = "100 dollars, 200 euros, 300 dollars" dollars = re.findall(r'\d+(?=\s*dollars)', text) # 只匹配数字,不匹配后面的“dollars” print(dollars) # ['100', '300'] # 提取前面是 "$" 的数字 text = "the prices are $100, €200, and $300." prices = re.findall(r'(?<=\$)\d+', text) # 只匹配数字,不匹配前面的“$” print(prices) # ['100', '300'] # 匹配一个不在单词中间的连字符(即单词边界处的连字符) text = "multi-purpose and well-known, but not abc-123" hyphens = re.findall(r'(?<=\w)-(?=\w)', text) # 前面是单词字符,后面也是单词字符的连字符 print(hyphens) # ['-', '-'] (匹配到 purpose和known中的连字符,但没匹配abc-123,因为123不是单词字符\w)

第四部分:综合实战项目 —— nginx 日志分析工具

现在,让我们运用所学知识,构建一个模块三末尾提到的实战项目:一个功能更丰富的 nginx 日志分析工具。

项目目标: 解析标准的 nginx 访问日志,并能够:

- 统计每个 ip 的访问次数(pv)。

- 统计每个 ip 的独立 user-agent(大致代表不同浏览器),从而估算独立用户(uv)。

- 分析 http 状态码的分布。

- 提取最常访问的 url。

nginx 默认日志格式 (log_format main):$remote_addr - $remote_user [$time_local] "$request" $status $body_bytes_sent "$http_referer" "$http_user_agent"

一条示例日志:192.168.1.100 - - [27/oct/2023:14:30:01 +0800] "get /articles/python.html http/1.1" 200 1234 "https://www.google.com/" "mozilla/5.0 (windows nt 10.0; win64; x64) applewebkit/537.36"

代码实现:

# nginx_log_analyzer.py

import re

from collections import counter, defaultdict

from pathlib import path

def analyze_nginx_log(log_path):

"""

分析nginx访问日志

"""

# 使用编译正则表达式提高效率

# 分解日志行的正则模式

log_pattern = re.compile(

r'(?p<ip>\d+\.\d+\.\d+\.\d+)' # ip地址

r' - - ' # 忽略的标识

r'\[(?p<time>.*?)\]' # 时间戳

r' "(?p<request>.*?)"' # 请求行 (get /url http/1.1)

r' (?p<status>\d{3})' # 状态码

r' (?p<size>\d+)' # 响应大小

r' "(?p<referer>.*?)"' # 来源页

r' "(?p<agent>.*?)"' # user-agent

)

# 用于统计的数据结构

ip_counter = counter() # ip访问次数 (pv)

status_counter = counter() # 状态码出现次数

url_counter = counter() # 请求url出现次数

# 使用 defaultdict(set) 来记录每个ip对应的唯一user-agent

ip_ua_dict = defaultdict(set) # key: ip, value: set(user_agent1, user_agent2...)

try:

with open(log_path, 'r', encoding='utf-8') as f:

for line in f:

match = log_pattern.search(line)

if not match:

# 跳过无法识别的行

continue

# 从匹配结果中提取数据

data = match.groupdict()

ip = data['ip']

status = data['status']

request = data['request']

user_agent = data['agent']

# 1. 统计ip pv

ip_counter[ip] += 1

# 2. 记录ip和user-agent(用于估算uv)

ip_ua_dict[ip].add(user_agent) # 使用set自动去重

# 3. 统计状态码

status_counter[status] += 1

# 4. 从请求行中提取url(简单处理,提取第一个单词后的部分)

parts = request.split()

if len(parts) >= 2:

url = parts[1] # 例如 "/articles/python.html"

url_counter[url] += 1

except filenotfounderror:

print(f"error: file {log_path} not found.")

return

# --- 输出分析报告 ---

print("=" * 50)

print("nginx log analysis report")

print("=" * 50)

print(f"\n1. top 10 ip addresses by page views (pv):")

for ip, count in ip_counter.most_common(10):

print(f" {ip:15} : {count:4}")

print(f"\n2. estimated unique visitors (uv) per ip (by unique user-agent):")

# 计算每个ip的uv(即其唯一user-agent集合的大小)

ip_uv = {ip: len(ua_set) for ip, ua_set in ip_ua_dict.items()}

for ip, uv_count in sorted(ip_uv.items(), key=lambda x: x[1], reverse=true)[:10]:

print(f" {ip:15} : {uv_count:4} (pv: {ip_counter[ip]})")

print(f"\n3. http status code distribution:")

for status, count in status_counter.most_common():

print(f" {status} : {count}")

print(f"\n4. top 10 most frequently requested urls:")

for url, count in url_counter.most_common(10):

print(f" {count:4} : {url}")

if __name__ == "__main__":

log_file = "access.log" # 替换为你的日志文件路径

analyze_nginx_log(log_file)

这个项目如何运用了正则表达式?

- 复杂模式匹配:使用一个复杂的正则表达式,通过命名分组一次性解构日志行的各个部分,代码清晰且易于维护。

- 效率:使用

re.compile()预编译正则模式,在循环外完成,极大提升分析速度。 - 数据处理:结合

collections.counter和defaultdict,高效地进行计数和统计,这是正则表达式与python数据结构的完美结合。

总结

通过本章,你已经从正则表达式的新手成长为能够处理复杂文本任务的熟练工。我们涵盖了从基础元字符到高级断言,从简单搜索到大型日志分析的全过程。

最佳实践与常见陷阱:

- 编译重用:始终使用

re.compile()预编译需要多次使用的模式。 - 使用原始字符串:模式字符串前加

r(如r'\n')可以避免python字符串字面量和正则转义符的混淆。 - 谨慎使用贪婪匹配:

.和.*是“万恶之源”,它们经常会匹配到比你预期多得多的内容。非贪婪匹配.*?是你的好朋友。 - 测试驱动:编写正则表达式时,务必使用在线测试工具(如 regex101.com)进行反复测试和调试,不要盲目猜测。

- 可读性优先:过于复杂的正则表达式难以理解和维护。必要时,可以将其拆分成多个步骤,或者添加详细的注释。

- 不是万能的:对于xml/html等嵌套结构复杂的文本,正则表达式可能无法完美处理(著名的“解析html不能用正则”问题),此时应使用专门的解析器(如

lxml,beautifulsoup)。

正则表达式是一项投入产出比极高的技能。虽然学习曲线稍显陡峭,但一旦掌握,它将为你打开一扇新的大门,让你处理文本数据的能力产生质的飞跃。在接下来的数据存储、web爬虫等章节中,它将持续发挥着不可替代的作用。

到此这篇关于python正则表达式在数据处理中应用实战的文章就介绍到这了,更多相关python正则表达式数据处理内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论