前言:tika是一款apache开源的,跨平台,支持多品种文本类型的内容检测和提取工具。apache官方的介绍如下:apache tika™ 工具包可检测并提取一千多种不同文件类型(如 ppt、xls 和 pdf)中的元数据和文本。所有这些文件类型都可以通过一个界面进行解析,这使得 tika 可用于搜索引擎索引、内容分析、翻译等。

1、apache tika是什么?

apache tika 是一个内容分析工具包,它能够从各种类型的文档中提取元数据和文本内容。tika 支持多种文件格式,包括但不限于 pdf、word 文档、excel 表格、powerpoint 演示文稿、html、xml、图像文件等,tika 通过集成众多开源库(如 apache poi、pdfbox、tesseract ocr 等)来支持这些格式的解析。tika 的设计目标是提供一种简单且一致的方式来处理不同格式的文件,使用 tika 可避免为不同文件类型单独开发解析器,简化代码逻辑。

(1)主要功能

- 元数据提取:tika 可以获取文件的作者、创建时间、文件类型、修改日期等元数据信息。

- 文本提取:tika 能够解析文件并提取其中的文本内容,这对于需要对文档进行全文搜索或自然语言处理的应用非常有用。

- 语言检测:tika 还具备识别文档所用语言的能力。

- mime 类型检测:通过文件的内容来确定其 mime 类型(例如 application/pdf 或 text/plain)。

(2)基本特性

- 支持多种格式:tika 支持多种文件格式,包括常见的文档、图片、音频和视频格式。

- 支持流式解析,避免大文件内存溢出

- 可扩展性:tika 的设计是模块化的,允许开发者添加新的解析器来支持新的文件格式。

- 安全性:tika 提供了防止文件注入攻击的机制,确保在处理用户上传的文件时保持安全性。

(3)使用场景

- 搜索引擎:在构建企业级搜索系统时,可以使用 tika 来索引非结构化数据。

- 数据分析:对于需要从大量不同格式的文档中收集信息的数据分析项目来说,tika 提供了一个强大的工具集。

- 文档管理系统:帮助实现更智能的文档管理解决方案,自动分类和标记上传的文件。

- 安全审计:检查传入或传出组织边界的文件是否包含敏感信息。

- 数据转换与翻译:支持将文档转换为纯文本、html 或翻译为其他语言,适用于多语言内容平台。

(4)tika 架构组件

apache tika 的架构组件主要包括以下几个核心部分,它们共同协作,以支持从各种文件格式中提取文本、元数据和其他信息。以下是 apache tika 的主要架构组件:

①tika core

tika core 是 apache tika 的核心组件,提供了文件解析、内容提取的基础功能。它包含了最基本的功能,如文档类型识别、解析和提取文本内容。tika core 是其他功能和模块的基础。

- 文件解析(parser):用于解析各种文件格式,返回提取的文本和元数据。

- 内容提取(content extraction):提取文件中的内容,包括文本、图片、音频、视频等。

- 文件类型识别(mime type detection):根据文件的内容而不是扩展名,判断文件的实际类型(如 pdf、word、excel、html 等)。

②tika parsers

tika parsers 是一组负责解析不同类型文件的组件。它们是 tika 核心的关键组成部分,能处理多种格式,如文本文档、电子表格、pdf、图像、音频等。tika 会根据文件类型自动选择合适的解析器。

- 文本解析器(text parsers):解析普通文本文件(如 .txt、.xml、.html 等)。

- 多媒体解析器(media parsers):解析图片、音频、视频等多媒体文件。

- 文档解析器(document parsers):解析各类办公文档,如 word、excel、powerpoint、pdf 等。

- 元数据解析器(metadata parsers):提取文件中的元数据,如作者、创建日期、修改日期、文件大小等。

tika 提供了许多内置的解析器(基于其他开源库,如 apache poi、pdfbox、ocr 等),可以扩展和定制以支持新的文件格式。

③tika config (配置管理)

tika config 是用来管理 tika 配置的模块,允许用户通过配置文件来定制 tika 的行为。通过 tika config,用户可以指定特定的解析器、提取策略、字符集等设置。

- 配置文件:可以通过

tika-config.xml文件来配置如何解析不同类型的文件。 - 自定义解析器和扩展:用户可以自定义自己的解析器,并通过配置文件将其加入到

tika系统中

2、tika主要方法(detect、parse、translate)

(1)detect(类型/语言检测)

- 文件类型检测

通过 mime 类型识别(如 application/pdf)和 魔术字节(文件头特征)判断文档格式。例如,即使将 pdf 文件扩展名改为 .txt,tika 仍能准确识别其真实类型。

detector detector = new defaultdetector(); mediatype type = detector.detect(inputstream, metadata); // 返回 mime 类型

- 语言检测

基于 n-gram 算法 分析文本的语言特征(如中文、英文),支持多语种混合文档识别。

(2)parse(内容解析)

parser parser = new autodetectparser(); contenthandler handler = new bodycontenthandler(); // 提取纯文本 parser.parse(inputstream, handler, metadata, new parsecontext());

(3)translate(翻译)

集成翻译服务,可调用外部 api(如 google translate、microsoft translator)将解析后的文本翻译为目标语言。需配置服务密钥和端点。

translatetranslator translator = new googletranslator(); string translatedtext = translator.translate(extractedtext, "en", "zh-cn");

3、tika 核心解析方法

apache tika 提供了多种文档解析方法,适用于不同场景的需求。以下是其核心解析方法及特点:

(1)统一解析接口(parser api)

通过 autodetectparser 自动检测文档类型并调用对应的解析器,适用于多格式混合处理场景。

parser parser = new autodetectparser(); contenthandler handler = new bodycontenthandler(); // 文本提取 metadata metadata = new metadata(); parser.parse(inputstream, handler, metadata, new parsecontext());

自动识别 1000+ 文件类型(如 pdf、word、excel、html 等)

支持流式解析,避免大文件内存溢出

(2)门面类(facade api)

通过 tika 类简化调用,适合快速提取文本或元数据

tika tika = new tika();

//解析为纯文本

string text = tika.parsetostring(new file("document.pdf"));

// 检测 mime 类型

string mimetype = tika.detect(file); 优势:

- 代码简洁,无需手动配置解析器。

- 内置语言检测(基于 n-gram 算法)。

(3)手动指定解析器

针对特定格式使用专用解析器(需明确文件类型),可优化性能或处理特殊需求。

适用场景:

- 需要深度控制解析流程(如提取特定元数据字段4。

- 处理特殊格式(如 ofd 国家标准文档。

(4)元数据与内容分离处理

结合 metadata 和 contenthandler 分别处理元数据与内容,适用于结构化数据提取15。

metadata metadata = new metadata(); contenthandler texthandler = new bodycontenthandler(); parser parser = new autodetectparser(); parser.parse(inputstream, texthandler, metadata, new parsecontext()); // 获取元数据 string author = metadata.get(metadata.author);

扩展性:

- 支持自定义元数据字段

- 可集成翻译服务(如 google translate)对提取文本翻译。

4、利用 tika 从 pdf 文件中提取文本

(1)引入maven依赖

<dependencies>

<dependency>

<groupid>org.apache.tika</groupid>

<artifactid>tika-core</artifactid>

<version>2.9.2</version>

</dependency>

<dependency>

<groupid>org.apache.tika</groupid>

<artifactid>tika-parsers-standard-package</artifactid>

<version>2.9.2</version>

</dependency>

</dependencies>(2)使用 tika 从 pdf 文件中提取文本和元数据

package com.hs.demo.util.tika;

import org.apache.tika.tika;

import org.apache.tika.exception.tikaexception;

import org.apache.tika.metadata.metadata;

import org.apache.tika.parser.parsecontext;

import org.apache.tika.parser.pdf.pdfparser;

import org.apache.tika.sax.bodycontenthandler;

import org.xml.sax.saxexception;

import java.io.file;

import java.io.fileinputstream;

import java.io.ioexception;

/**

* 首先检测了给定文件的 mime 类型,然后使用pdfparser对象来解析该文件,并打印出提取到的文本以及一些基本的元数据信息。

*/

public class tikaexample {

public static void main(string[] args) {

try (fileinputstream input = new fileinputstream(new file("d://xxx.pdf")))

{

// 创建 tika 实例

tika tika = new tika();

// 获取文件的 mime 类型

string mimetype = tika.detect(input);

system.out.println("detected mime type: " + mimetype);

// 重置输入流位置

input.getchannel().position(0);

// 准备解析器

bodycontenthandler handler = new bodycontenthandler(-1); // -1 表示不限制输出大小

metadata metadata = new metadata();

parsecontext context = new parsecontext();

// 解析 pdf 并获取内容

pdfparser parser = new pdfparser();

parser.parse(input, handler, metadata, context);

// 输出结果

system.out.println("extracted text:\n" + handler.tostring());

system.out.println("metadata:");

string[] metadatanames = metadata.names();

for (string name : metadatanames) {

system.out.println(name + ": " + metadata.get(name));

}

} catch (ioexception | saxexception | tikaexception e) {

e.printstacktrace();

}

}

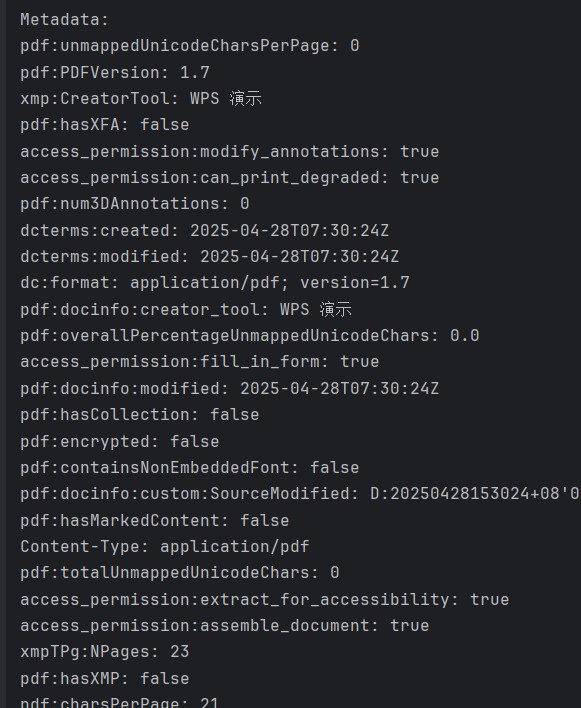

}输出元数据如下:

5、基于springboot使用tika

(1)tika配置文件tika-config.xml 定义 tika 运行属性

此配置文件存放于 springboot 项目的 resources 目录下即可,如果位置发生变化需要在获取资源的时候改变位置保持同步一致即可。

<?xml version="1.0" encoding="utf-8"?>

<properties>

<encodingdetectors>

<!-- 检测 html 文件的字符编码,它会根据 html 元素(如 <meta> 标签)中的声明来判断编码。 -->

<encodingdetector class="org.apache.tika.parser.html.htmlencodingdetector">

<params>

<!-- 读取的最大字节数(这里是 64,000 字节)用于判断编码 -->

<param name="marklimit" type="int">64000</param>

</params>

</encodingdetector>

<!-- tika 的通用编码检测器 -->

<encodingdetector class="org.apache.tika.parser.txt.universalencodingdetector">

<params>

<param name="marklimit" type="int">64000</param>

</params>

</encodingdetector>

<!-- 基于 icu4j 库的编码检测器。icu4j 是一个强大的国际化库,能够更准确地检测多语言文本的编码。 -->

<encodingdetector class="org.apache.tika.parser.txt.icu4jencodingdetector">

<params>

<param name="marklimit" type="int">64000</param>

</params>

</encodingdetector>

</encodingdetectors>

</properties>(2)编写配置文件,注入tika bean

import org.apache.tika.tika;

import org.apache.tika.config.tikaconfig;

import org.apache.tika.detect.detector;

import org.apache.tika.exception.tikaexception;

import org.apache.tika.parser.autodetectparser;

import org.apache.tika.parser.parser;

import org.springframework.beans.factory.annotation.autowired;

import org.springframework.context.annotation.bean;

import org.springframework.context.annotation.configuration;

import org.springframework.core.io.resource;

import org.springframework.core.io.resourceloader;

import org.xml.sax.saxexception;

import java.io.ioexception;

import java.io.inputstream;

/**

* tika 配置类

*

*/

@configuration

public class mytikaconfig {

@autowired

private resourceloader resourceloader;

@bean

public tika tika() throws tikaexception, ioexception, saxexception {

resource resource = resourceloader.getresource("classpath:tika-config.xml");

inputstream inputstream = resource.getinputstream();

tikaconfig config = new tikaconfig(inputstream);

detector detector = config.getdetector();

parser autodetectparser = new autodetectparser(config);

return new tika(detector, autodetectparser);

}

}(3)测试类

@springboottest 注解用于在 spring boot 应用程序中进行集成测试。它会启动整个 spring 应用程序上下文,从而允许测试类在真实的应用环境中运行。@springboottest 默认会加载主应用程序类作为配置类。

@springboottest

public class tikaparserdemotest {

@autowired

private tikaparserservice tikaparserservice;

@test

public void testtikaparser() throws tikaexception, ioexception {

tikaparserservice.parser(paths.get("d:", "xxx.pdf"));

}

}6、注意事项

虽然用起来简单,但 tika 有几个坑踩过才能懂:

(1)大文件解析要注意性能

默认情况下,tika 会把整个文件的内容加载到内存中解析,文件太大时容易内存爆炸。解决方法是用流式解析,像这样:

public string parsefilewithstream(string filepath) throws ioexception, tikaexception {

try (inputstream stream = new fileinputstream(filepath)) {

return tika.parsetostring(stream);

}

}(2)字符编码问题

如果你的文档内容有乱码问题,建议检查 tika-config.xml 的编码检测器配置是否正确。

(3)解析结果二次处理

如果你的文档内容是富文本,比如包含 html 标签,tika 会直接输出原始 html。这时候可以 用 jsoup 或类似工具对内容做清理。

参考链接:

spring boot 实现数据泄露防护:使用 apache tika 检测敏感信息

apache tika代码示例:使用 tika 从 pdf 文件中提取文本_apache tika 提取文本-csdn博客

https://juejin.cn/post/7388635438742044681

16. springboot集成tika实现文档解析_springboot tika-csdn博客

到此这篇关于springboot集成tika实现文档解析的文章就介绍到这了,更多相关springboot tika文档解析内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论