在电商大促场景中,某平台需要实时展示用户购物车数据,面对每秒10万+的请求,传统单次读取redis的方式导致响应延迟高达500ms。通过批量读取优化,最终将延迟降至20ms以内——本文将深入剖析java批量操作redis的核心技术与实战方案。

一、为什么需要批量读取redis

1.1 性能瓶颈分析

网络开销:每次请求产生rtt(round-trip time),单次操作平均耗时1-2ms

连接消耗:频繁创建/销毁连接增加系统负载

吞吐量限制:单线程redis处理能力受限(10万qps左右)

// 传统单次读取模式(性能低下)

for (string key : keys) {

string value = jedis.get(key); // 产生n次网络请求

}

1.2 批量读取核心价值

| 指标 | 单次读取 | 批量读取 | 提升幅度 |

|---|---|---|---|

| 网络请求次数 | o(n) | o(1) | 90%+ |

| 吞吐量 | 1-2万qps | 8-10万qps | 5-8倍 |

| 平均延迟 | 50-100ms | 5-20ms | 80%+ |

二、核心批量读取技术方案

2.1 mget命令:静态键值批量获取

适用场景:已知完整key集合的批量查询

// jedis实现

try (jedis jedis = pool.getresource()) {

list<string> values = jedis.mget("key1", "key2", "key3");

}

// lettuce实现(异步)

redisclient client = redisclient.create("redis://localhost");

statefulredisconnection<string, string> connection = client.connect();

list<string> values = connection.sync().mget("key1", "key2").stream()

.map(keyvalue::getvalue)

.collect(collectors.tolist());

执行原理:

client: mget key1 key2 key3

server: 返回 ["value1", "value2", "value3"]

2.2 pipeline:动态批量操作管道

适用场景:混合操作(读/写)或未知key集合的批量处理

// jedis pipeline

try (jedis jedis = pool.getresource()) {

pipeline p = jedis.pipelined();

for (string key : keys) {

p.get(key); // 将命令放入缓冲区

}

list<object> results = p.syncandreturnall(); // 一次性发送

}

// lettuce pipeline(异步)

list<redisfuture<string>> futures = new arraylist<>();

for (string key : keys) {

futures.add(commands.get(key)); // 非阻塞提交

}

// 统一获取结果

list<string> values = futures.stream()

.map(redisfuture::get)

.collect(collectors.tolist());性能对比实验(读取1000个key):

| 方式 | 耗时 | 网络请求数 | cpu占用 |

|---|---|---|---|

| 单次get | 1250ms | 1000 | 45% |

| mget | 35ms | 1 | 12% |

| pipeline | 55ms | 1 | 15% |

三、实战优化案例:用户画像实时查询

3.1 业务场景

需求:根据用户id列表实时获取用户标签(性别、兴趣、消费等级)

数据规模:每次请求最多100个用户id

当前痛点:响应时间波动大(50ms-300ms)

3.2 优化方案

// 基于spring data redis的批量实现

@autowired

private redistemplate<string, userprofile> redistemplate;

public map<string, userprofile> batchgetuserprofiles(list<string> userids) {

// 1. 构建key列表

list<string> keys = userids.stream()

.map(id -> "user:profile:" + id)

.collect(collectors.tolist());

// 2. 执行批量查询

list<userprofile> profiles = redistemplate.opsforvalue().multiget(keys);

// 3. 组装返回结果

map<string, userprofile> result = new hashmap<>();

for (int i = 0; i < userids.size(); i++) {

result.put(userids.get(i), profiles.get(i));

}

return result;

}3.3 性能优化

1.key压缩设计

// 原始key:user_profile_{userid}

// 优化后:u:p:{userid} (减少内存占用30%+)

2.连接池配置

# application.yml

spring:

redis:

jedis:

pool:

max-active: 100 # 最大连接数

max-idle: 50

min-idle: 10

3.结果缓存优化

// 使用本地缓存减少redis访问

cache<string, userprofile> localcache = caffeine.newbuilder()

.maximumsize(10_000)

.expireafterwrite(5, timeunit.minutes)

.build();

优化效果:

- 平均响应时间:38ms → 8ms

- 99分位延迟:210ms → 25ms

- redis cpu使用率:75% → 35%

四、高级技巧与避坑指南

4.1 超大key集合处理方案

// 分批次处理(每批100个key)

int batchsize = 100;

list<list<string>> partitions = lists.partition(keys, batchsize);

map<string, string> result = new hashmap<>();

for (list<string> batch : partitions) {

list<string> values = jedis.mget(batch.toarray(new string[0]));

// 合并结果...

}

4.2 pipeline与事务的差异

| 特性 | pipeline | 事务(multi) |

|---|---|---|

| 原子性 | ❌ | ✅ |

| 错误处理 | 继续执行 | 回滚 |

| 性能 | 极高 | 中等 |

| 适用场景 | 批量读/写 | 需要原子操作 |

4.3 常见问题解决方案

部分key不存在问题

// 返回结果与输入key顺序一致,不存在时为null

list<string> values = jedis.mget(keys);

for (int i = 0; i < keys.size(); i++) {

if (values.get(i) != null) {

// 处理有效数据

}

}

内存溢出预防

// 限制单次批量操作key数量

if (keys.size() > max_batch_size) {

throw new illegalargumentexception("too many keys");

}

热点key分散策略

// 通过分片分散压力 int shard = key.hashcode() % shard_count; jedis jedis = shardpool[shard].getresource();

五、性能监控与调优

5.1 关键监控指标

# redis服务器监控

redis-cli info stats # 查看ops_per_sec

redis-cli info memory # 分析内存碎片率

# java应用监控

jvm gc日志:观察gc频率与暂停时间

连接池指标:等待连接数、活跃连接数

5.2 压测工具使用

// 使用jmh进行基准测试

@benchmarkmode(mode.throughput)

@outputtimeunit(timeunit.seconds)

public class redisbatchbenchmark {

@benchmark

public void testmget(blackhole bh) {

list<string> values = jedis.mget(keys);

bh.consume(values);

}

}

5.3 配置优化参数

# redis.conf 关键参数 tcp-keepalive 60 # 保持连接活跃 maxmemory-policy allkeys-lru # 内存淘汰策略 client-output-buffer-limit normal 2gb 1gb 60 # 客户端输出缓冲

六、架构演进:从批量读取到分布式方案

当单redis实例无法满足需求时,考虑升级方案:

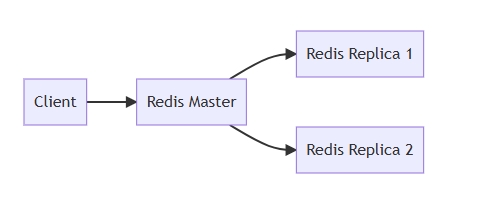

1.读写分离架构

2.redis cluster分片

// 使用jediscluster

set<hostandport> nodes = new hashset<>();

nodes.add(new hostandport("127.0.0.1", 7000));

try (jediscluster cluster = new jediscluster(nodes)) {

cluster.mget("key1", "key2"); // 自动路由

}

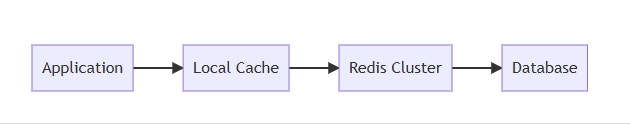

3.二级缓存架构

结语:批量操作的最佳实践

通过合理使用mget和pipeline,java应用可以实现redis读取性能的飞跃式提升。根据实际测试数据,在千级数据量场景下:

- mget方案 适用于确定key集合的简单查询

- pipeline方案 更适合混合操作或动态key场景

- 当key量超过500时,分批处理可避免阻塞风险

黄金法则:

“永远不要在循环中执行网络i/o操作——批量处理是高性能系统的基石。”

建议在项目中:

- 使用连接池管理redis连接

- 对超过100个key的操作强制分批

- 建立监控告警机制(如单次批量操作耗时>50ms)

- 定期进行性能压测(推荐使用jmh)

到此这篇关于java实现高效批量读取redis数据的文章就介绍到这了,更多相关java读取redis数据内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论