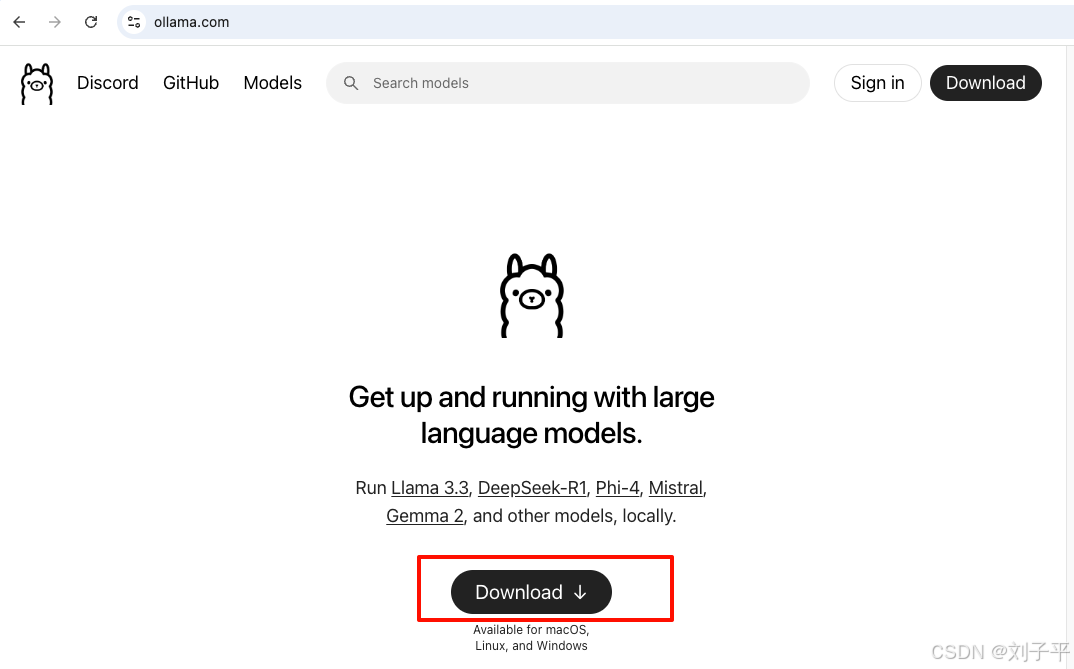

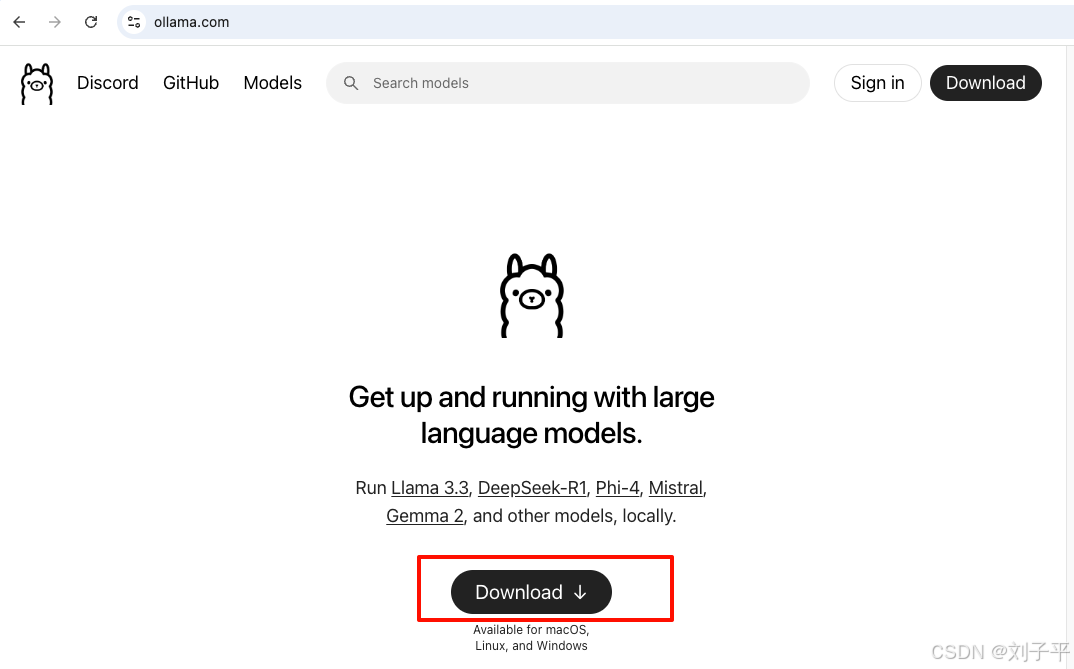

下载安装ollama地址:https://ollama.com/ollama 是一个开源的大型语言模型(llm)本地运行框架,旨在简化大模型的部署和管理流程,使开发者、研究人员及爱好者能够高效地在本地

下载安装ollama

地址: https://ollama.com/ollama 是一个开源的大型语言模型(llm)本地运行框架,旨在简化大模型的部署和管理流程,使开发者、研究人员及爱好者能够高效地在本地环境中实验和集成最新模型

一路下一步

安装好后

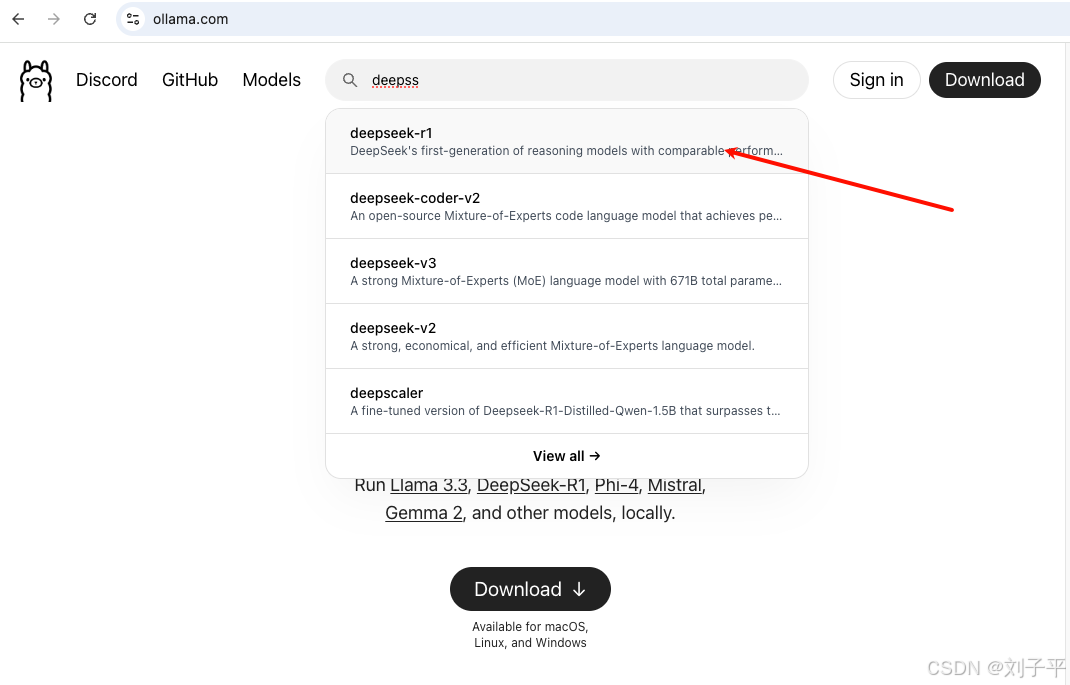

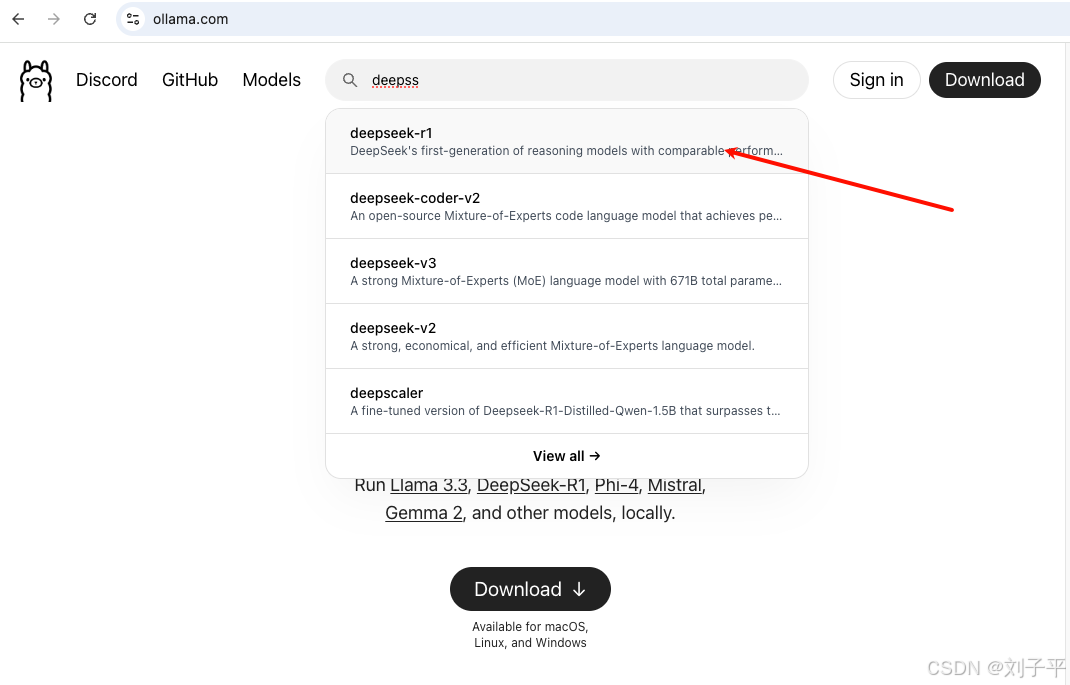

搜索需要的大模型

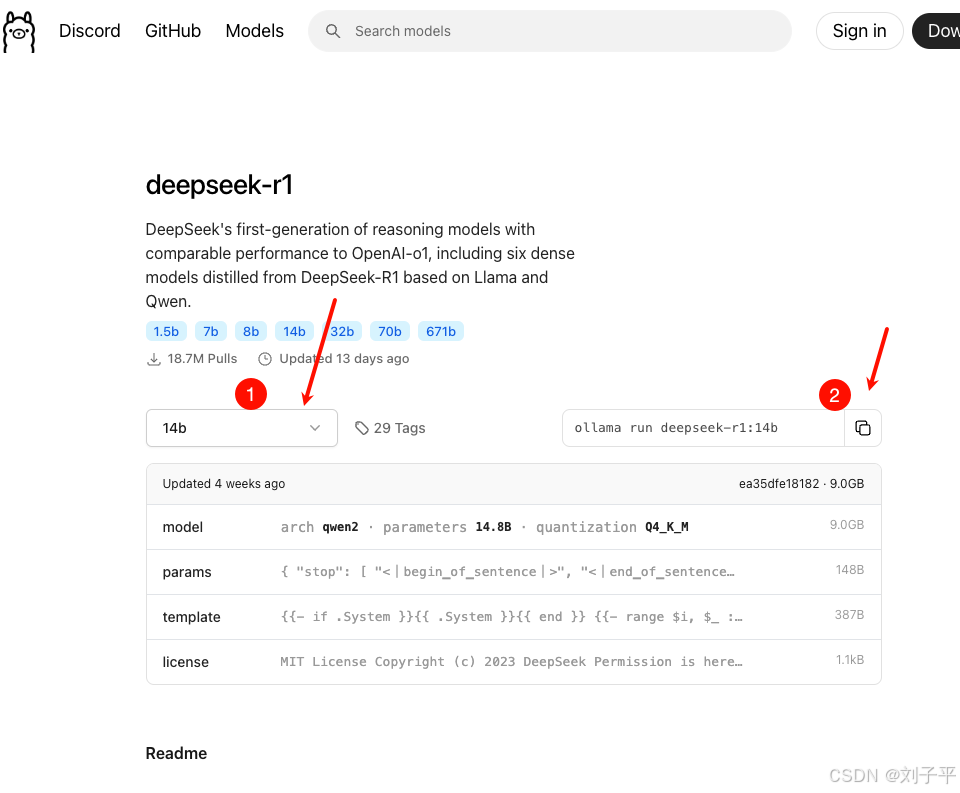

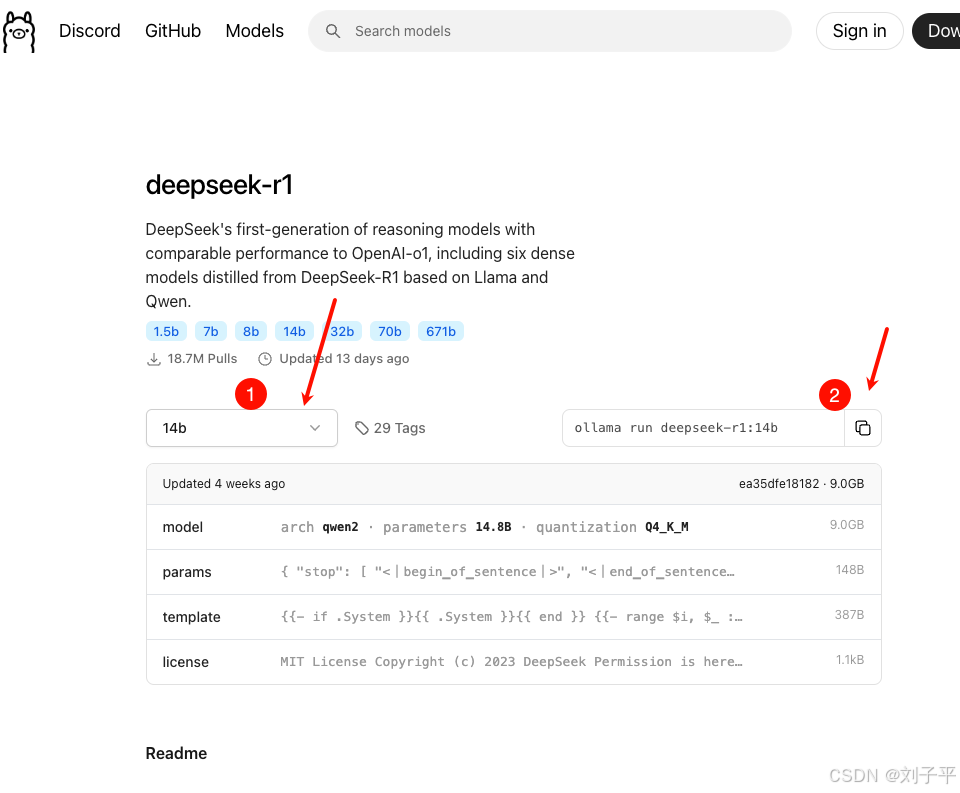

2. 根据自己需求, 选择合适的大模型版本

3. 本地电脑配置较差,我安装的14b

4. 复制命令 ollama run deepseek-r1:14b 到终端运行

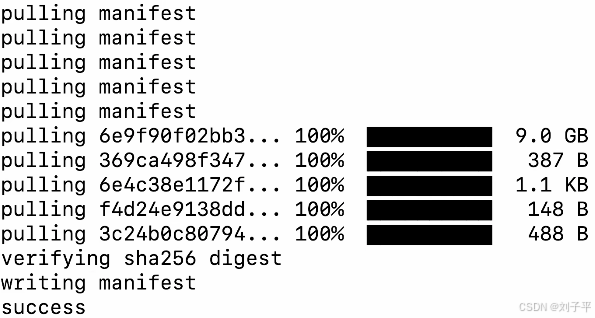

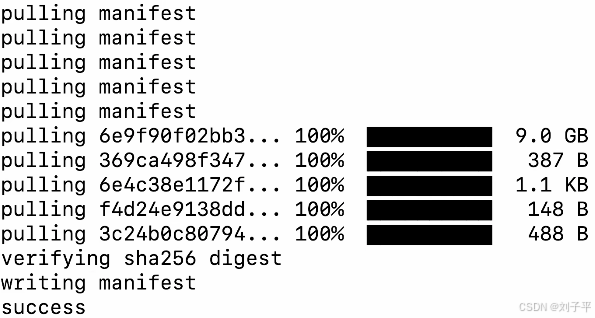

看到 success就成功了

可以开始对话了 (首次较慢)

进阶

不想用黑窗口的话 可以下载cherry studio

cherry studio 是一款开源的多模型 ai 桌面客户端,专为专业用户设计,支持跨平台操作(windows/macos/linux),集成 300+ 大语言模型和本地化部署能力,旨在简化 ai 技术的应用流程,提升工作效率

简单配置就能使用了(网上教程可多 就不赘述了)

到此这篇关于mac快速本地部署deepseek的实现步骤的文章就介绍到这了,更多相关mac本地部署deepseek内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

相关文章:

-

想要保护 mac 上的重要数据?「时间机器」绝对是你的不二之选。它是苹果官方推出的 macos 备份工具,不仅十分可靠,还特别容易上手。设置好之后,它就会自动在后台自动帮你备份数据…

-

要知道,自从apple宣告要从x86转型到apple silicon起,这可是计算机硬件领域的一次重大变革之举。长期以来,x86架构处理器在计算机领域占据着相当重要的地位,而app…

-

这是最便宜的 m4 mac mini,以及最便宜的 m4 pro mac mini。在这段视频中,我会开箱它们,进行一些测试和跑分,并回答一个问题:这款 mac 是否物有所值?以及…

-

趁着国补,我入手了mac mini m4 16g+256g+万兆的版本,当然花销没有买千兆而因为京东延迟发货的朋友低,但是入手4200左右我也已经十分满意了。今天,我就与大家聊一聊…

-

mac安装redis官网下载指定版本的redis https://redis.io/ 目前3.2.0 是最新最稳定的 版本这里是历史版本下载下载指定版本安装1.放到自定义目录下并解…

-

版权声明:本文内容由互联网用户贡献,该文观点仅代表作者本人。本站仅提供信息存储服务,不拥有所有权,不承担相关法律责任。

如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 2386932994@qq.com 举报,一经查实将立刻删除。

发表评论