前言

最近大火的国产ai大模型deepseek大家应该都不陌生。除了在手机上安装app或通过官网在线体验,其实我们完全可以在windows电脑上进行本地部署,从而带来更加便捷的使用体验。 之前也提到过,本地部署ai模型有很多好处,比如:隐私安全——所有数据都保存在本地,不用担心泄露敏感信息;响应速度快——官方或第三方服务由于访问量大,常常会导致卡顿,而本地部署能避免这种延迟问题。

要在本地部署deepseek r1大模型并不难,只需安装开源工具ollama,它可以支持各种ai模型的运行。

如果觉得在终端里与ai交互不够直观或美观,还可以再安装一个图形化界面,就能像与chatgpt一样,在网页上与大模型对话了。

软件介绍

ollama

ollama是一个开源软件,主要用于在本地电脑设备上下载、部署和使用大模型(llm)。它提供了丰富的llm库,如llama、qwen、mistral以及deepseek r1等,并且支持不同参数规模的模型,以适配不同性能的电脑设备。ollama虽然支持直接使用llm,但仅能在命令行中进行对话,交互功能有限,因此需要配合其他工具使用。通俗理解为用于方便本地部署大模型使用的工具,实现离线使用和数据得到安全保护。

deepseek r1

deepseek r1是一个大模型,常用于本地部署。通过ollama和cherrystudio,用户可以在本地电脑上部署和使用deepseek r1,从而实现离线使用和隐私保护。deepseek r1在本地部署时,不需要依赖高配置的gpu,较低参数规模的模型甚至不需要独立显卡也可以在电脑运行。

cherrystudio

cherrystudio是一个可视化界面工具,内置了多个大模型服务商,用户只需进行简单的配置即可使用大模型。它使得交互操作更加方便,用户不需要在命令行中进行对话。通过配置ollama模型,cherrystudio可以提供更友好的用户界面,使得本地部署的大模型更容易使用。通俗理解为就是一个与ai交互的界面,界面上可以选择你部署好的不同ai模型(如deepseekr1等)进行使用。

windows本地部署

一、安装ollama

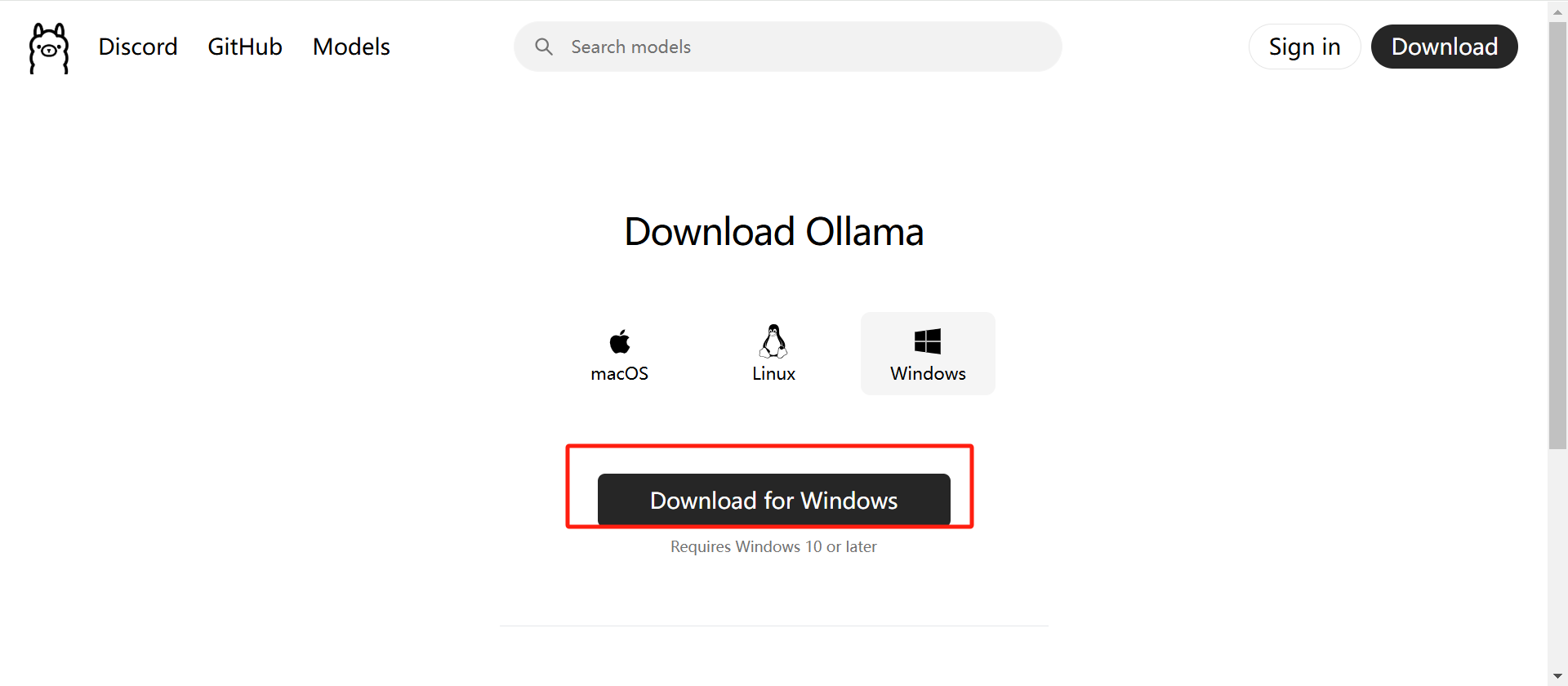

1、访问ollama的官网:https://ollama.com/download

2、下载好后,鼠标右键以管理员身份运行

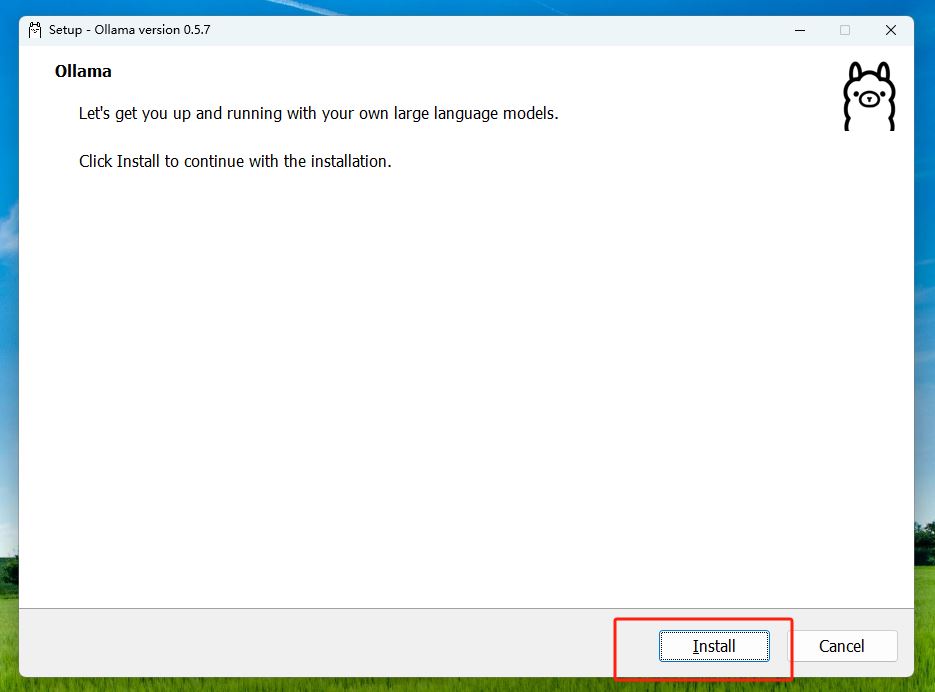

3、点击install安装,默认安装在c盘,所以c盘最好预留出空间来,最低4gb的存储空间.

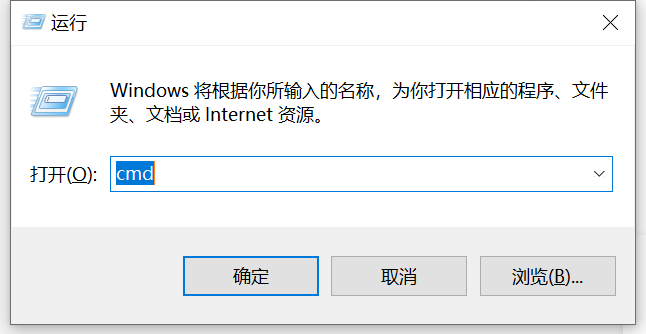

4、安装好之后,我们按住win+r键,在运行框中输入cmd打开windows系统自带的终端界面:

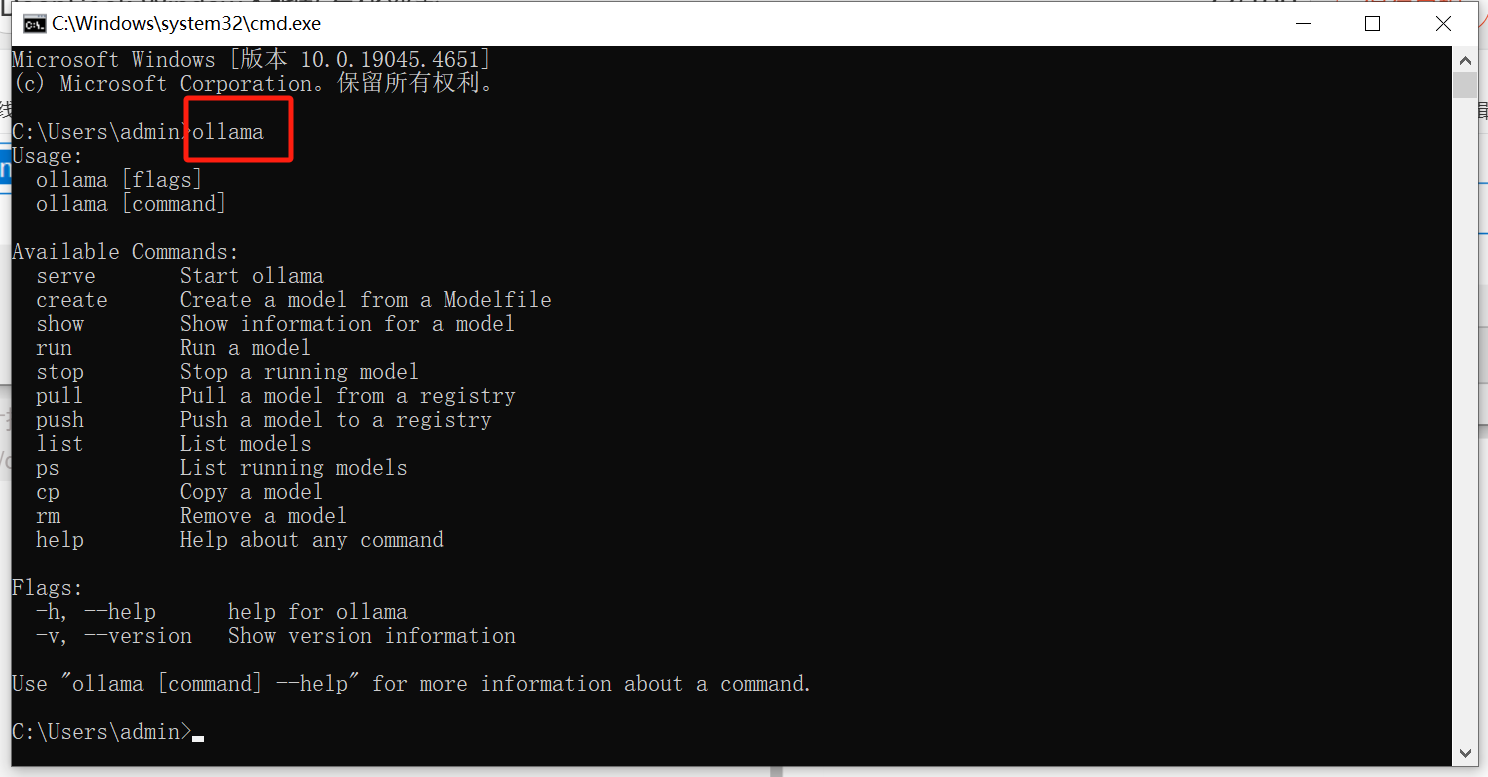

5、然后输入ollama回车,看到下面信息即为安装成功!但现在还没有ai模型,下一步将会教你利用ollama安装deepseek r1模型。

二、安装deepseek-r1模型

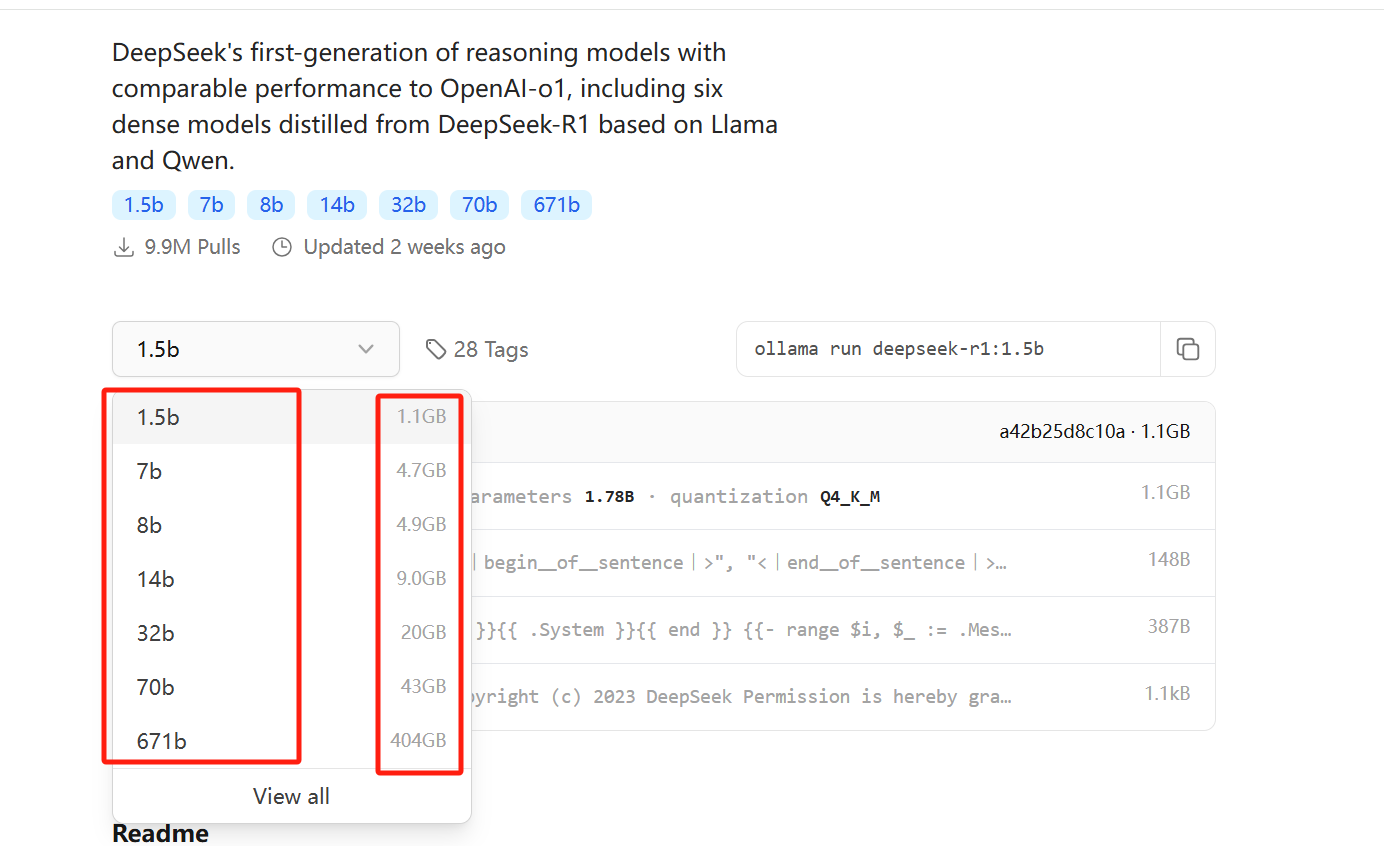

1、访问ollama 提供的模型下载地址:https://ollama.com/library/deepseek-r1

deepseek-r1模型配置要求

大家可以根据自己的需求和资源配置选择模型进行下载,下面是不同版本模型版本对性能配置要求。

1.5b版本

- cpu:最低4核,推荐多核处理器

- 内存:8gb以上

- 硬盘:3gb以上存储空间(模型文件约1.5-2gb)。

- 显卡:非必需,若使用gpu加速,推荐4gb以上显存的显卡(如gtx 1650)

- 适用场景:低资源设备部署(如树莓派、旧款笔记本)、实时文本生成(聊天机器人、简单问答)、嵌入式系统或物联网设备

7b版本

- cpu:8核以上,推荐现代多核cpu

- 内存:16gb以上

- 硬盘:8gb以上

- 显卡:推荐8gb以上显存的显卡(如rtx 3070/4060)

- 适用场景:本地开发测试、中等复杂度nlp任务(文本摘要、翻译)、轻量级多轮对话系统

8b版本

- cpu:8核以上

- 内存:16gb以上

- 硬盘:8gb以上

- 显卡:推荐8gb以上显存的显卡(如rtx 4090或a5000)

- 适用场景:需更高精度的轻量级任务(如代码生成、逻辑推理)

14b版本

- cpu:12核以上

- 内存:32gb以上

- 硬盘:15gb以上

- 显卡:16gb以上显存的显卡(如rtx 4090或a5000)

- 适用场景:企业级复杂任务(合同分析、报告生成)、长文本理解与生成(书籍/论文辅助写作)

32b版本

- cpu:16核以上(如amd ryzen 9或intel i9)

- 内存:64gb以上

- 硬盘:30gb以上

- 显卡:24gb以上显存的显卡(如a100 40gb或双卡rtx 3090)

- 适用场景:高精度专业领域任务(医疗/法律咨询)、多模态任务预处理(需结合其他框架)

70b版本

- cpu:16核以上

- 内存:64gb以上

- 硬盘:30gb以上

- 显卡:40gb以上显存的显卡(如多张a100/h800等专业卡)

- 适用场景:高性能场景、需平衡质量与成本

671b版本

- cpu:16核以上

- 内存:64gb以上

- 硬盘:30gb以上

- 显卡:40gb以上显存的显卡(如多张a100/h800等专业卡)

- 适用场景:尖端领域(药物研发、复杂系统模拟),适合云服务或科研机构

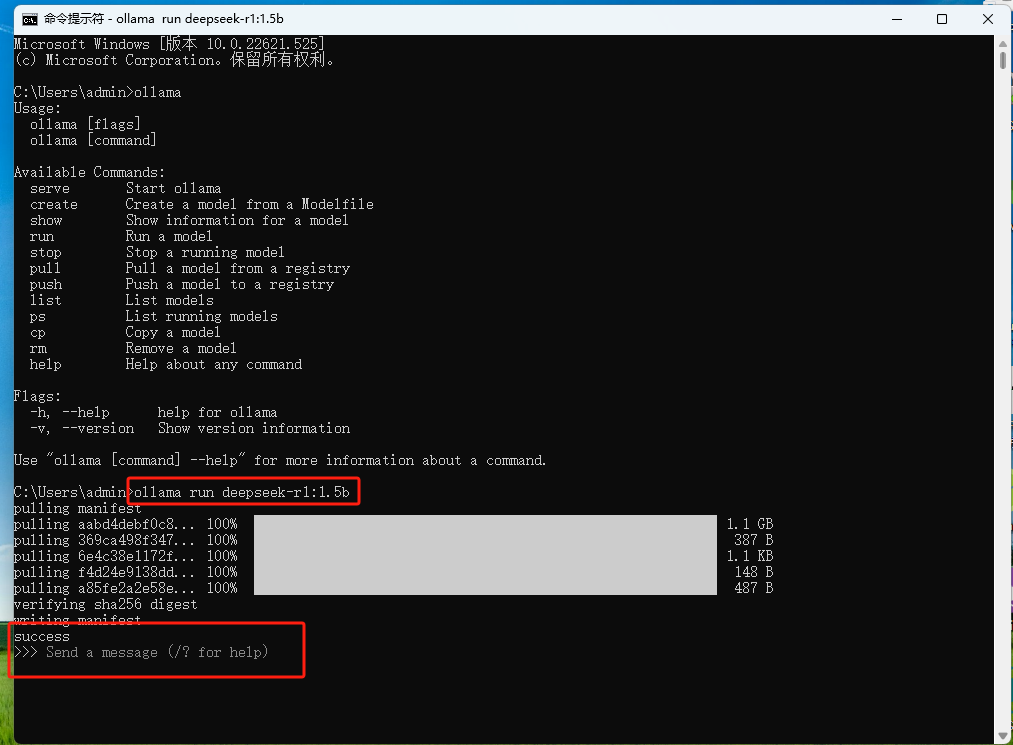

2、我这里下载1.5b的轻量级deepseek模型进行演示,如下命令:

ollama run deepseek-r1:1.5b

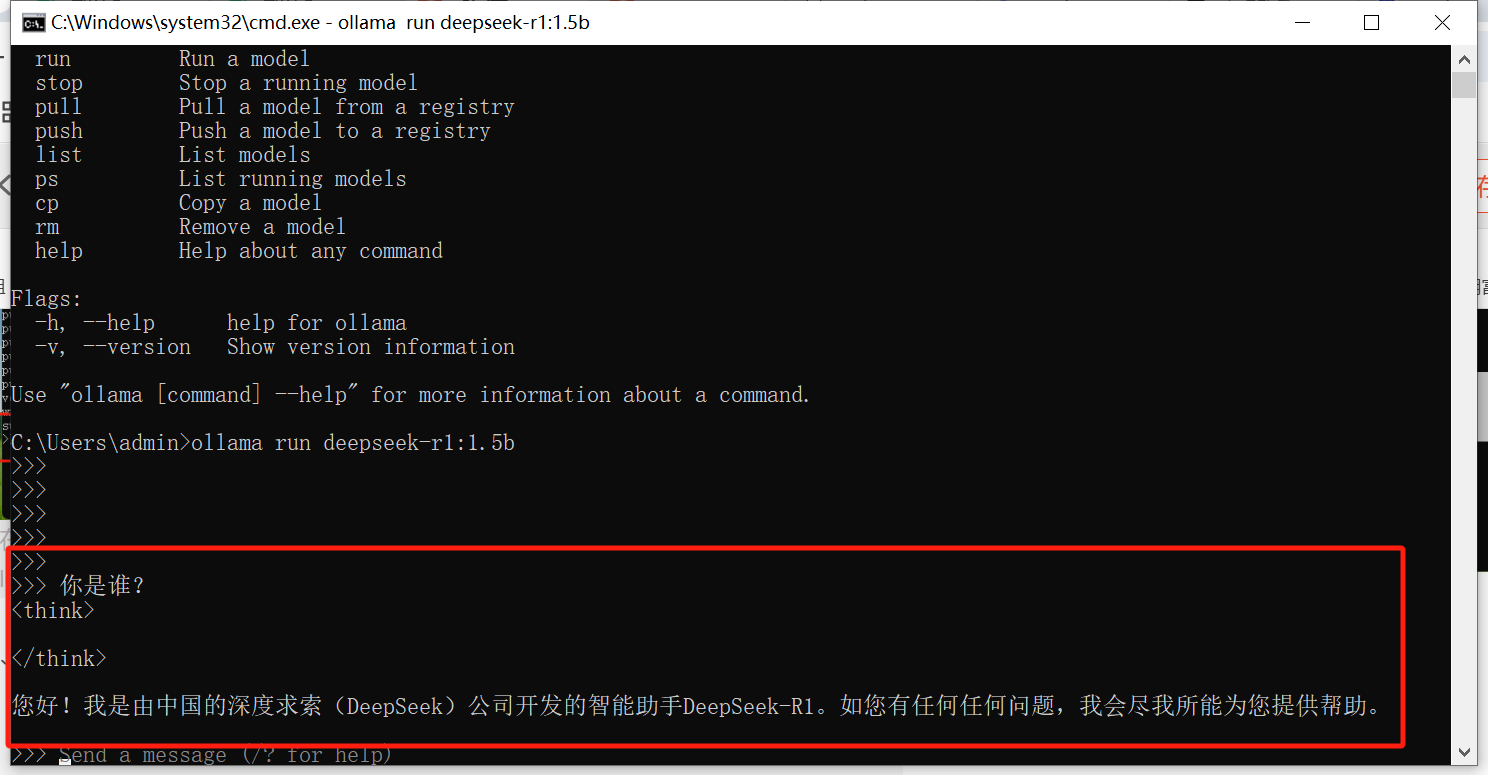

3、输入问题,马上就能收到回答,速度挺快的:

三、安装图形化交互界面

1、首先下载一个叫 cherry studio的软件,这个软件主要用于与ai交互的可视化界面。如下图。网址: https://cherry-ai.com/download

2、右键管理员身份运行安装“cherry-studio-0.9.19-setup.exe”软件即可。

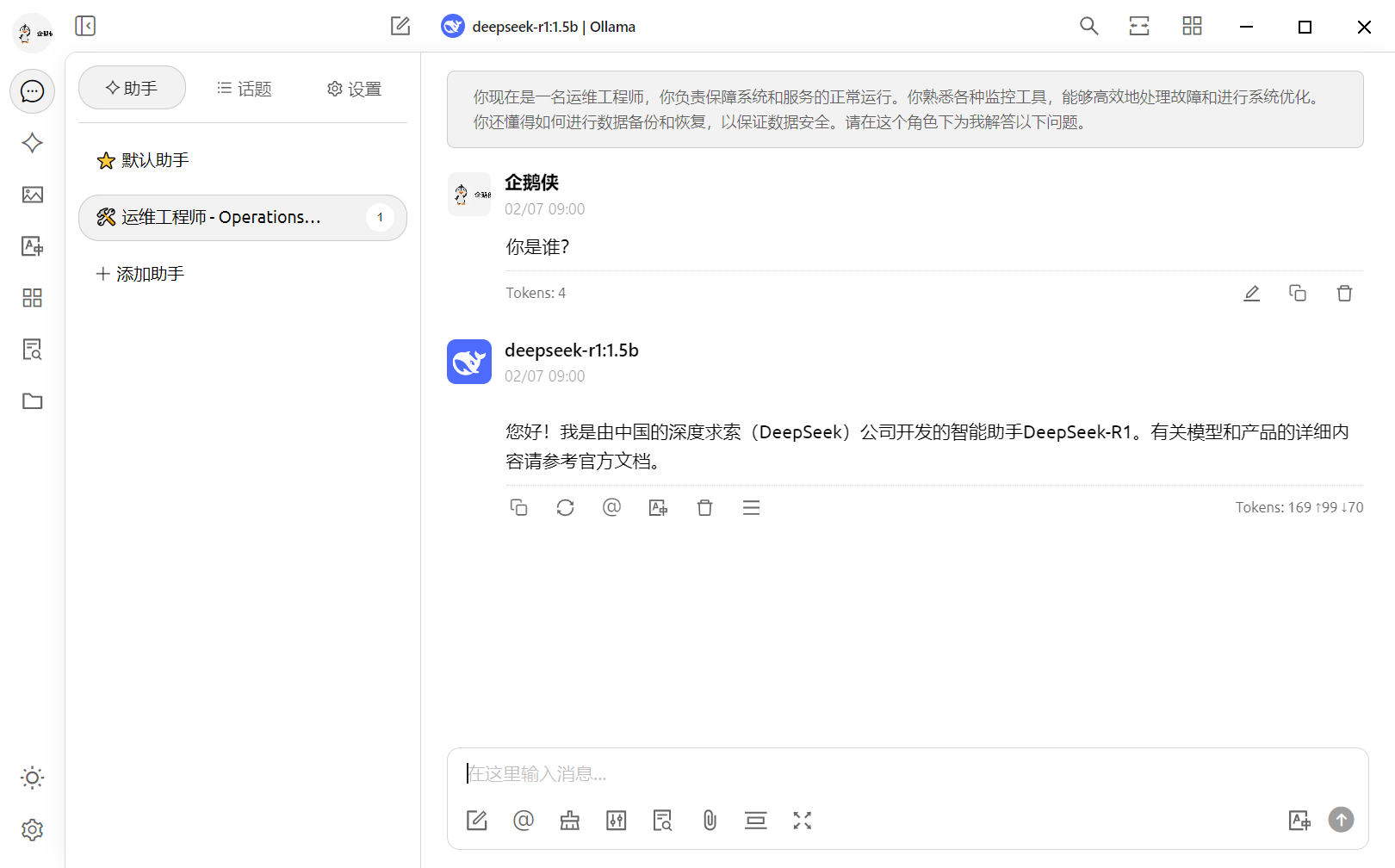

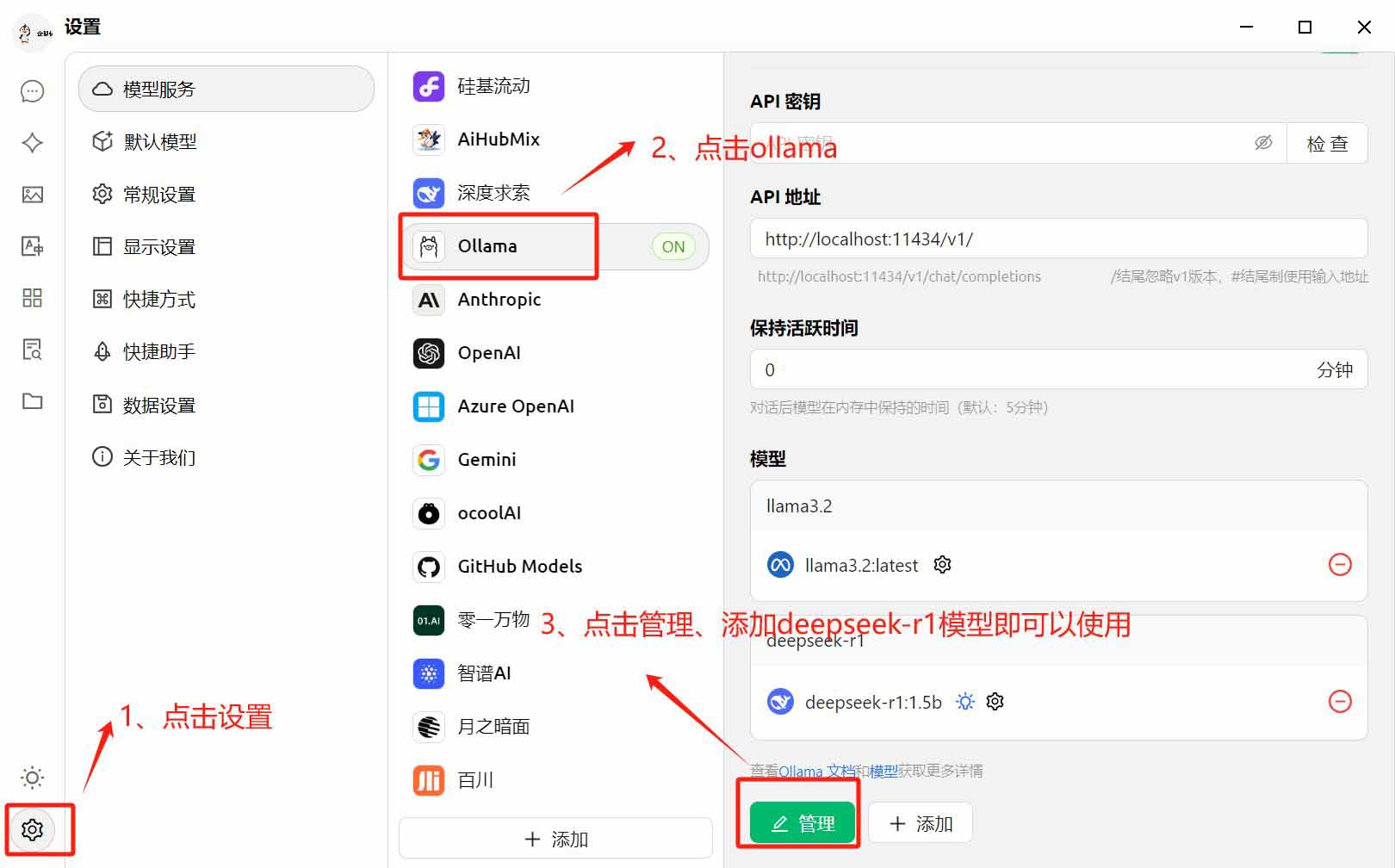

3、安装好后,桌面双击运行该软件,进行设置添加deepseek模型

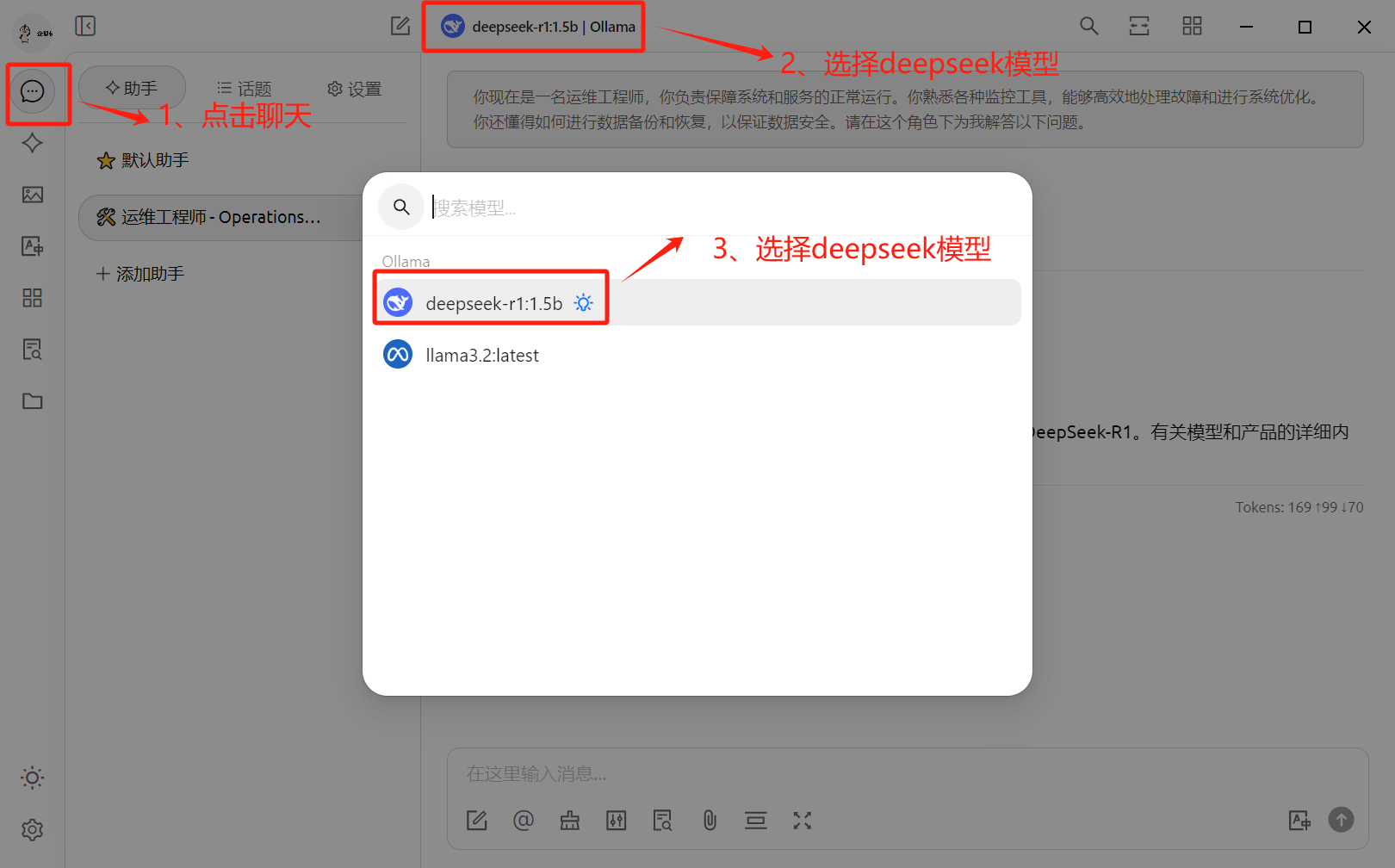

4、选择deepseek模型进行对话

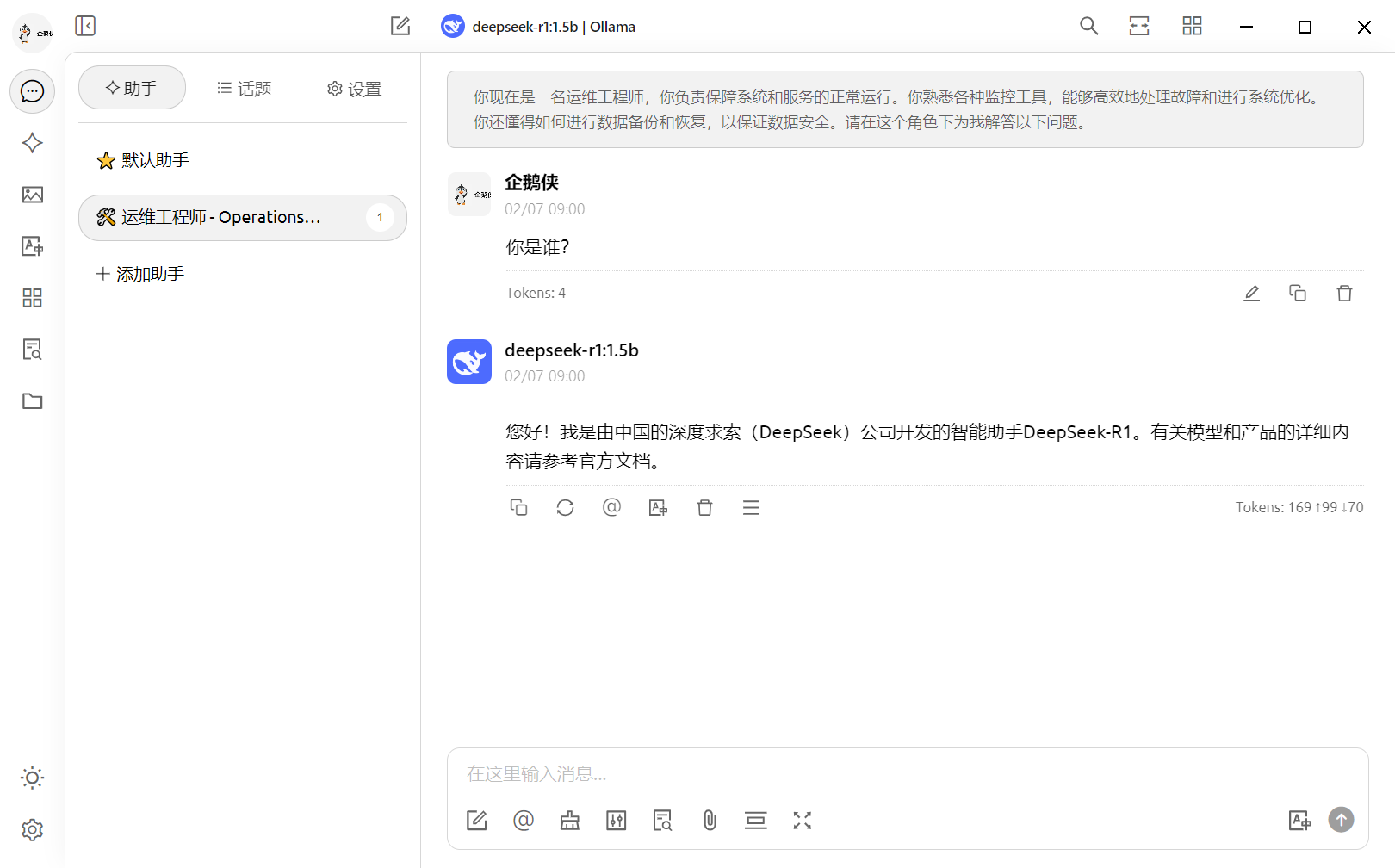

5、现在就可以用界面跟ai交互啦

总结

看到这里,相信你对deepseek 本地化部署又一定了解了;其实部署不难,如果你是个人搭建体验的话,也不用再为性能和本地硬件资源发愁;恰好你有充足的算力和技术储备,本地部署也是个非常不错的选择。不过,在整个过程中,我想和你分享的不仅仅是这些技术细节。而是一个中国团队能做出世界级大模型,一个需要 +86 才能注册的大模型。很庆幸,我们能作为中国 ai 技术进步的见证人。当然,暂时的领先不是终点。但 deepseek 给我们带来的,是“中国也可以”这份信心。这,才是我们真正要守护的希望。

以上为个人经验,希望能给大家一个参考,也希望大家多多支持代码网。

发表评论