在python中进行网络编程和web开发时,经常需要发送http请求并处理服务器返回的响应。其中,获取响应体(response body)是常见的需求之一。本文将详细介绍在python中如何获取http请求的响应体,包括使用内置的urllib库、第三方库requests以及一些高级用法。通过丰富的案例和代码示例,帮助新手朋友更好地理解和掌握这一技能。

一、引言

http协议是web开发中最重要的协议之一,它定义了客户端和服务器之间的通信方式。在http请求和响应中,响应体包含了服务器返回给客户端的数据,这些数据可能是html文档、json对象、图片等。在python中,有多种方法可以发送http请求并获取响应体。

二、使用urllib库获取response body

urllib是python标准库中的一个模块,用于处理url和http请求。虽然urllib的api相对繁琐,但它是python内置的,无需额外安装。

1. 基本用法

下面是一个使用urllib发送get请求并获取响应体的示例:

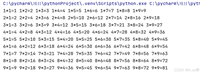

import urllib.request

url = 'http://example.com'

request = urllib.request.request(url)

with urllib.request.urlopen(request) as response:

body = response.read() # 获取响应体

print(body.decode('utf-8')) # 将字节数据解码为字符串

在这个例子中,我们首先创建了一个request对象,然后使用urlopen函数发送请求。urlopen返回一个类文件对象,我们可以使用read方法读取响应体。注意,read方法返回的是字节数据,我们需要使用decode方法将其解码为字符串。

2. 发送post请求

使用urllib发送post请求并获取响应体的示例如下:

import urllib.request

import urllib.parse

url = 'http://example.com/post'

data = {'key': 'value'}

data_encoded = urllib.parse.urlencode(data).encode('utf-8') # 将数据编码为字节

request = urllib.request.request(url, data=data_encoded)

with urllib.request.urlopen(request) as response:

body = response.read()

print(body.decode('utf-8'))

在这个例子中,我们使用urlencode函数将数据编码为url编码的字符串,并将其转换为字节数据。然后,我们将字节数据传递给request对象的data参数,以发送post请求。

三、使用requests库获取response body

requests是一个第三方库,用于发送http请求。与urllib相比,requests的api更加简洁和易用。

1. 安装requests库

在使用requests库之前,需要先安装它。可以使用pip命令进行安装:

pip install requests

2. 基本用法

下面是一个使用requests发送get请求并获取响应体的示例:

import requests url = 'http://example.com' response = requests.get(url) body = response.text # 直接获取响应体的字符串表示 print(body)

在这个例子中,我们直接调用requests.get函数发送get请求,并获取响应体。response.text属性包含了响应体的字符串表示,无需手动解码。

3. 发送post请求

使用requests发送post请求并获取响应体的示例如下:

import requests

url = 'http://example.com/post'

data = {'key': 'value'}

response = requests.post(url, data=data)

body = response.text

print(body)

在这个例子中,我们直接调用requests.post函数发送post请求,并传递数据字典。response.text属性同样包含了响应体的字符串表示。

4. 处理json响应

如果服务器返回的是json格式的响应体,我们可以使用response.json()方法将其解析为python字典:

import requests url = 'http://example.com/api/data' response = requests.get(url) data = response.json() # 将json响应解析为python字典 print(data)

在这个例子中,response.json()方法将json响应体解析为python字典,方便我们进行后续处理。

四、高级用法

除了基本的get和post请求外,python的http客户端还支持更多高级功能,如处理请求头、设置超时、处理cookies等。

1. 处理请求头

我们可以使用headers参数传递请求头信息:

import requests

url = 'http://example.com'

headers = {

'user-agent': 'mozilla/5.0 (windows nt 10.0; win64; x64) applewebkit/537.36 (khtml, like gecko) chrome/58.0.3029.110 safari/537.3'}

response = requests.get(url, headers=headers)

body = response.text

print(body)

在这个例子中,我们传递了一个包含user-agent的请求头信息。

2. 设置超时

在发送请求时,我们可以设置超时时间,以避免请求长时间无响应:

import requests

url = 'http://example.com'

try:

response = requests.get(url, timeout=5) # 设置超时时间为5秒

body = response.text

print(body)

except requests.exceptions.timeout:

print("请求超时")

在这个例子中,我们设置了超时时间为5秒。如果请求在5秒内没有响应,将抛出requests.exceptions.timeout异常。

3. 处理cookies

我们可以使用cookies参数传递cookies信息,或者使用session对象来维护cookies:

import requests

url = 'http://example.com'

cookies = {'session_id': 'abc123'}

response = requests.get(url, cookies=cookies)

body = response.text

print(body)

# 使用session对象维护cookies

session = requests.session()

response = session.get(url)

# 在后续的请求中,cookies会自动携带

response = session.get('http://example.com/another-page')

body = response.text

print(body)

在这个例子中,我们首先使用cookies参数传递了cookies信息。然后,我们使用session对象来维护cookies,这样在后续的请求中,cookies会自动携带。

五、案例:爬取网页内容

下面是一个使用requests库爬取网页内容并提取特定信息的示例:

import requests

from bs4 import beautifulsoup

url = 'http://example.com'

response = requests.get(url)

if response.status_code == 200:

soup = beautifulsoup(response.text, 'html.parser')

title = soup.title.string # 提取网页标题

print("网页标题:", title)

# 提取其他信息...

else:

print("请求失败,状态码:", response.status_code)

在这个例子中,我们首先使用requests.get函数发送get请求,并检查响应状态码是否为200(表示成功)。然后,我们使用beautifulsoup库解析html内容,并提取网页标题。

六、总结

本文详细介绍了在python中如何获取http请求的响应体。我们介绍了使用内置的urllib库和第三方库requests的基本用法和高级功能。通过丰富的案例和代码示例,我们展示了如何发送get和post请求、处理json响应、设置请求头、设置超时以及处理cookies等。

到此这篇关于python如何获取http请求的response body的文章就介绍到这了,更多相关python获取http请求的response body内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论