torch.nn.**

torch.nn.**是一个继承了torch.nn.module的类,使用前必须先构造对象,然后再调用。如果直接使用则会报错

例如

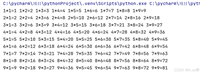

a = torch.randn(3,4) print(a) sigmoid = torch.nn.sigmoid() a = sigmoid(a) print(a) a = torch.nn.sigmoid(a)

tensor([[ 0.2462, -2.1680, -1.4064, -0.0268],

[-0.4800, -0.4670, 1.7318, 0.3498],

[ 0.0137, -2.1080, -0.0825, -0.1350]])

tensor([[0.5612, 0.1027, 0.1968, 0.4933],

[0.3823, 0.3853, 0.8496, 0.5866],

[0.5034, 0.1083, 0.4794, 0.4663]])

traceback (most recent call last):

traceback (most recent call last):

file "c:\文件\llama\tmp.py", line 8, in <module>

a = torch.nn.sigmoid(a)

^^^^^^^^^^^^^^^^^^^

file "c:\users\90929\appdata\local\conda\conda\envs\lce\lib\site-packages\torch\nn\modules\module.py", line 485, in __init__

raise typeerror(

typeerror: sigmoid.__init__() takes 1 positional argument but 2 were given

torch.nn.functional.**

torch.nn.functional.**是一个纯数学函数,可以直接使用

a = torch.randn(3,4) print(a) a = torch.nn.functional.sigmoid(a) print(a)

tensor([[-0.1516, 0.5398, 0.3226, -0.4956],

[-0.2250, 0.6393, 0.4432, 0.4215],

[-0.5741, 0.0689, 0.3078, -1.5994]])

tensor([[0.4622, 0.6318, 0.5799, 0.3786],

[0.4440, 0.6546, 0.6090, 0.6039],

[0.3603, 0.5172, 0.5763, 0.1681]])区别

pytorch中torch.nn与torch.nn.functional的区别是:1.继承方式不同;2.可训练参数不同;3.实现方式不同;4.调用方式不同。

1.继承方式不同

torch.nn 中的模块大多数是通过继承torch.nn.module 类来实现的,这些模块都是python 类,需要进行实例化才能使用。而torch.nn.functional 中的函数是直接调用的,无需实例化.

2.可训练参数不同

torch.nn 中的模块可以包含可训练参数,可以使用model.parameters() 方法获取所有的可训练参数,用于优化算法的训练。而torch.nn.functional 中的函数没有可训练参数。

3.实现方式不同

torch.nn 中的模块是基于面向对象的方法实现的,而torch.nn.functional 中的函数是基于函数式编程实现的。因此,使用torch.nn.functional 可以更方便地进行函数组合、复用等操作,而torch.nn 则更适合用于定义有状态的模块。

4.调用方式不同

torch.nn 中的模块是通过类的实例进行调用,通常需要先创建模型实例,再将输入数据传入模型中进行前向计算。而torch.nn.functional 中的函数可以直接调用,只需要将输入数据传入函数中即可进行前向计算。

总之,torch.nn 和torch.nn.functional 都是用于构建神经网络模型的模块,但其实现方式、调用方式、可训练参数等方面有所不同。使用时需要根据具体需求选择合适的模块和函数

联系

torch.nn的类会在forward()方法中调用torch.nn.functional的函数,所以可以理解为nn模块中的方法是对nn.functional模块中方法的更高层的封装。

如何选择

1. 何时选择torch.nn

在定义深度神经网络的layer时推荐使用nn模块。

一是因为当定义有变量参数的层时(比如conv2d, linear, batch_norm),nn模块会帮助我们初始化好变量,而我们只需要传入一些参数;

二是因为model类本身是nn.module,看起来会比较协调统一;

三是因为可以结合nn.sequential。

四是当使用dropout时推荐使用nn模块,因为可以在测试阶段通过eval()方法方便地关闭dropout。

2. 何时选择torch.nn.functional

nn.functional中的函数相比nn更偏底层,所以虽然封装性不高,但透明度很高,可以在其基础上定义出自己想要的功能

到此这篇关于pytorch中torch.nn.**和torch.nn.functional.**的区别的文章就介绍到这了,更多相关pytorch torch.nn.**和torch.nn.functional.**内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论