每日AIGC最新进展(45):字节跳动开源大规模text-to-video数据集OpenVid-1M、浙江大学提出锚定条件控制视频生成GVDIFF、Meta AI研究院提出文生3D大模型3DGen

OpenVid-1M是一个大规模、高质量的文本到视频(Text-to-video, T2V)数据集,旨在推动T2V生成领域的研究。该数据集包含超过一百万段具有高美学标准、清晰度和表达性字幕的视频片段。它解决了现有数据集质量不高或体积过大不适合大多数研究机构使用的问题,并强调了充分利用文本信息的重要性。

openvid-1m: a large-scale high-quality dataset for text-to-video generation

https://nju-pcalab.github.io/projects/openvid

openvid-1m是一个大规模、高质量的文本到视频(text-to-video, t2v)数据集,旨在推动t2v生成领域的研究。该数据集包含超过一百万段具有高美学标准、清晰度和表达性字幕的视频片段。它解决了现有数据集质量不高或体积过大不适合大多数研究机构使用的问题,并强调了充分利用文本信息的重要性。

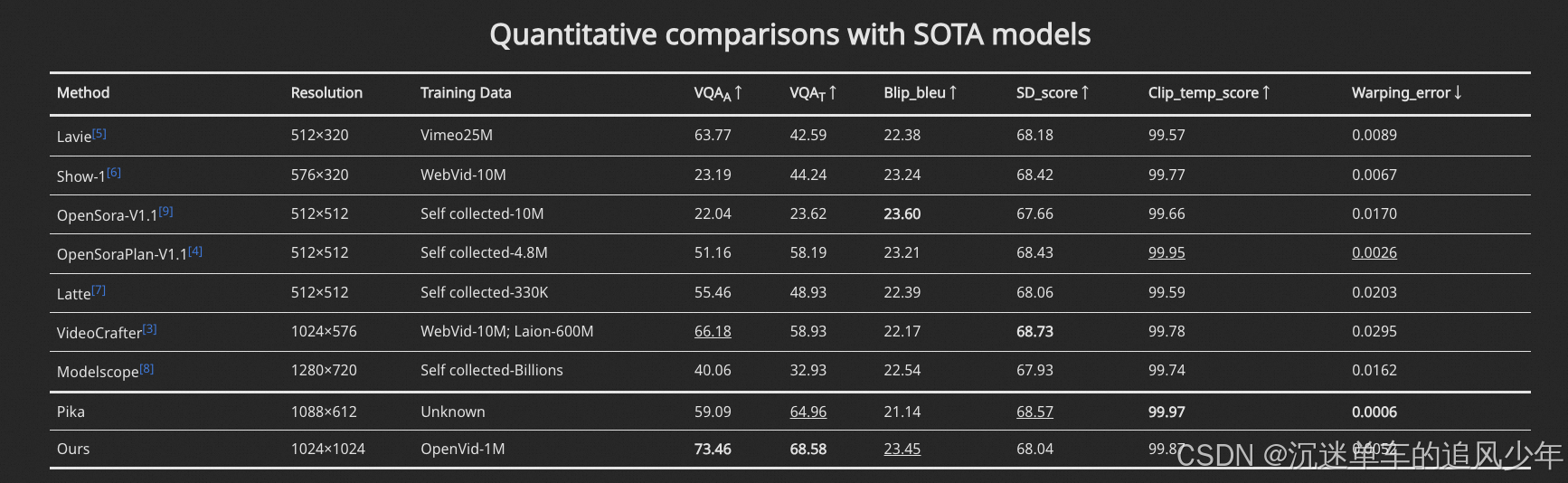

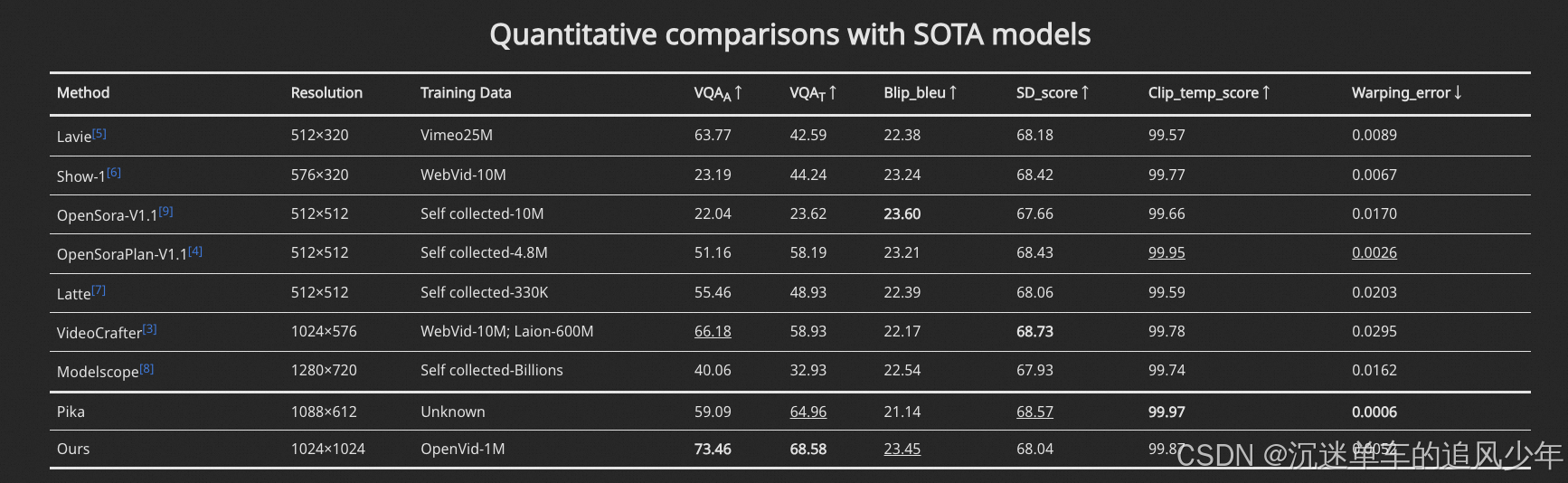

文本到视频(t2v)一代最近引起了极大的关注,这主要是由于先进的多模态模式sora。然而,目前研究界的t2v一代仍然面临两大挑战:1)缺乏精确的、高质量的开源数据集。以前流行的视频数据集,如webvid

相关文章:

-

初步了解之测试工具

作为Selenium的后端,测试人员可以利用Selenium的丰富功能进行移动应用的全面测试,包括模拟用户操作、测试应用的功能和性能等。它不仅可以测试静态和动态...

[阅读全文]

-

-

-

Postman下载、安装、注册登录-Windows篇…

-

-

jmeter是apache公司基于java开发的一款开源压力测试工具,体积小,功能全,使用方便,是一个比较轻量级的测试工具,使用起来非常简单。因为jmeter是java开发的,所以…

版权声明:本文内容由互联网用户贡献,该文观点仅代表作者本人。本站仅提供信息存储服务,不拥有所有权,不承担相关法律责任。

如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 2386932994@qq.com 举报,一经查实将立刻删除。

发表评论