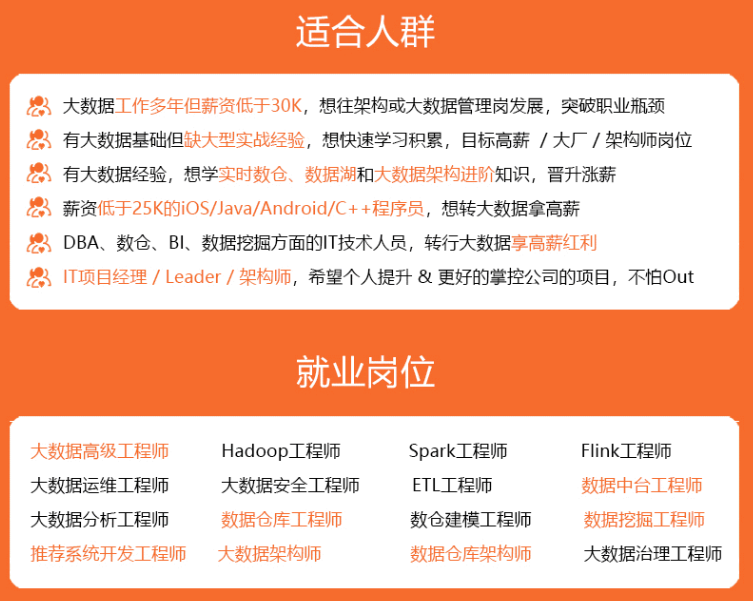

先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里p7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

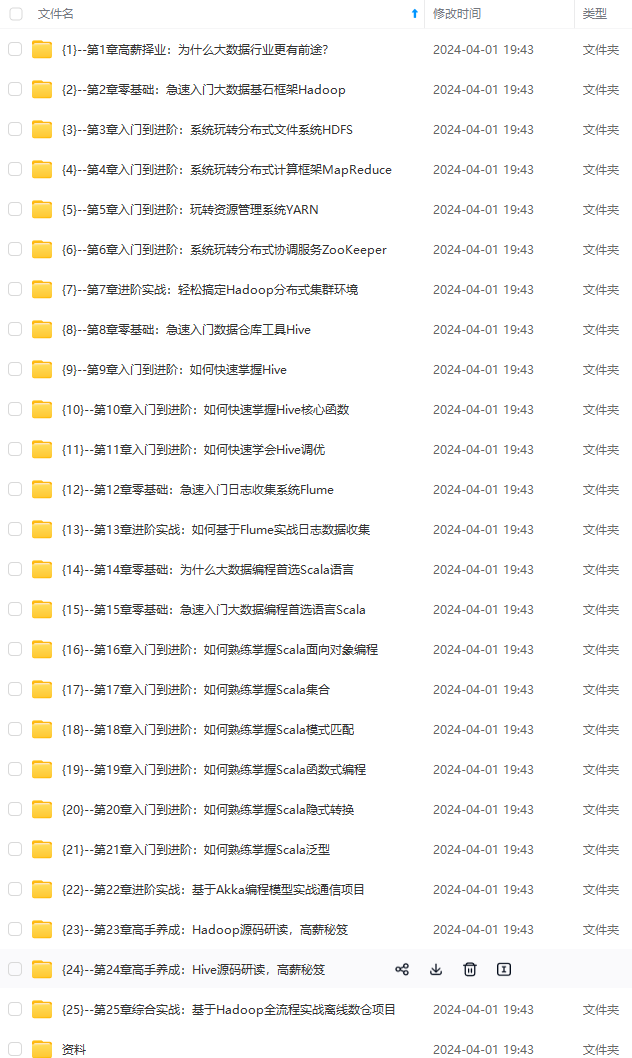

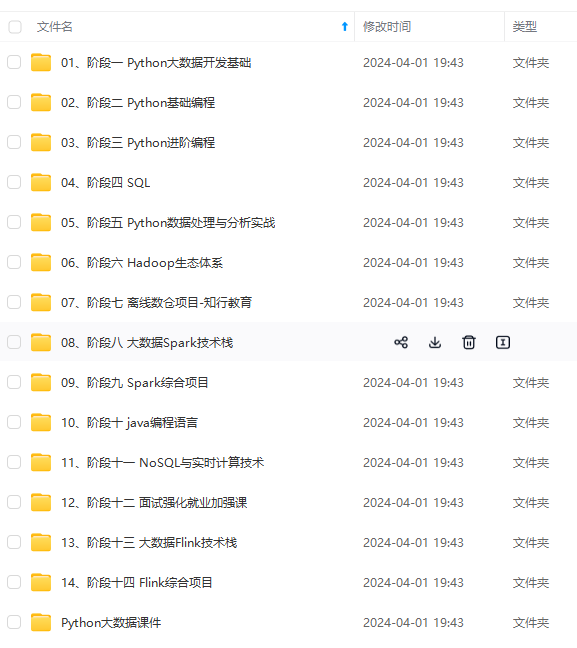

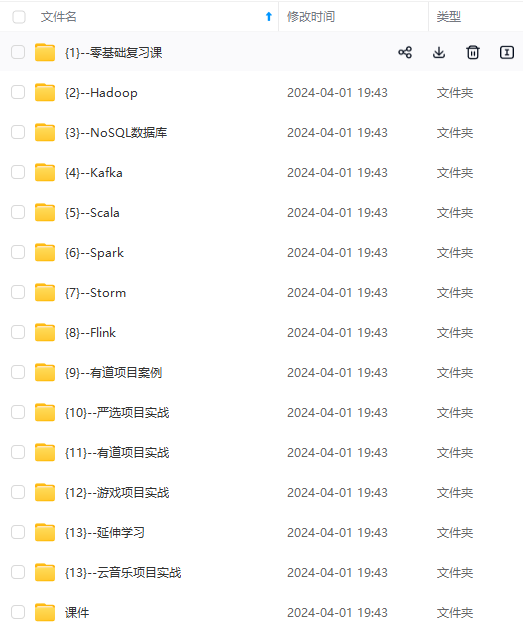

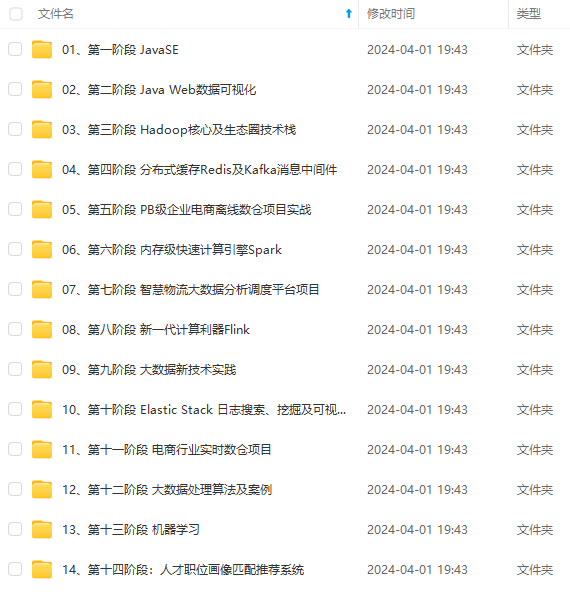

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加v获取:vip204888 (备注大数据)

正文

* ods:原始数据层

+ 存储格式:avro

+ 数据内容:基本与原始数据是一致的

* dwd:明细数据层

+ 存储格式:orc

+ 数据内容:基于与ods层是一致的

-

ods层的需求是什么?

- 自动化建库建表

- 建表

create table one_make_ods.表名 tableproperties(schema文件)+ 表名 + 表的注释 + 表对应的hdfs地址 + schema文件的地址 -

dwd层的需求是什么?

- 自动化建库建表

- 建表

create table one_make_dwd.表名( 字段信息 ) location+ 表名 + 表的注释 + 表对应的hdfs地址 + 字段信息 -

怎么获取表的schema信息?

- 表的注释、schema信息

- ods:oracle中获取表的注释、schema文件从sqoop生成的

- dwd:oracle中获取表的信息

- tablemeta:表名,表的注释,列的信息:list

- columnmeta:列名、列的注释、列的类型、长度、精度

-

如何使用python构建oracle和hive的连接?

- oracle:cx_oracle

- conn(host,port,user,passwd,sid)

- hive/sparksql:pyhive

- sparksql用法

- 编程方式:python文件 | jar包

- 流程

- step1:sparksession

- step2:读取数据源

- step3:处理

- 注册视图

- spark.sql(“”)

- spark-submit

- 优点:灵活

- 场景:dsl

- 流程

- 提交sql:thriftserver

- 场景:sql,调度开发

- 流程

- jdbc | pyhive | beeline:代码中开发

- spark-sql -f xxxx.sql:sql文件的运行

- oracle:cx_oracle

-

如果实现sql语句的执行?

-

step1: 先构建服务端的远程连接

- 服务端地址:主机名 + 端口

- 用户名和密码

-

step2:基于这个连接构建一个游标

-

step3:通过游标来执行sql语句:execute(string:sql)

-

step4:释放资源

-

-

集中问题

- 连接构建不上

- 映射不对:spark.bigdata.cn:can not connect[46.xxx.xxxx.xx,10001]

- 修改host文件

- 修改config.txt:node1

- 服务端问题:spark.bigdata.cn:can not connect[192.168.88.100,10001]

- spark的triftserver没有启动

- 启动完成先用dg或者beeline先测试一下

- thriftserver:依赖于metastore + yarn

- 检查yarn:本质就是一个spark程序:实时程序,不停止的

- spark的triftserver没有启动

- oracle:cx_oracle + 本地客户端:d:\instantclient_12_2

- 映射不对:spark.bigdata.cn:can not connect[46.xxx.xxxx.xx,10001]

- 安装

- python版本:python 3.7.4

- 命令sasl

- 连接构建不上

02:项目目标

- 回顾维度建模

- 建模流程:划分主题域和主题

- 维度设计:构建维度矩阵

- 维度模型:雪花模型、星型模式

- 项目中的建模流程和维度设计

- 划分了哪些主题域,每个主题域有哪些主题?

- 每个主题基于哪些维度进行分析?

- 维度层构建

- 时间维度

- 地区维度

- 油站维度

- 服务网点维度

- 组织机构维度

- 仓库维度

- 物流维度

03:维度建模回顾:建模流程

-

目标:掌握维度建模的建模流程

-

实施

-

step1-需求调研:业务调研和数据调研

- 了解整个业务实现的过程

- 收集所有数据使用人员对于数据的需求

- 整理所有数据来源

-

step2-划分主题域:面向业务将业务划分主题域及主题

- 用户域、店铺域

- 商品域、交易域、

- 客服域、信用风控域、采购分销域

-

step3-构建维度总线矩阵:明确每个业务主题对应的维度关系

-

step4-明确指标统计:明确所有原生指标与衍生指标

- 原生指标:基于某一业务事件行为下的度量,是业务定义中不可再拆分的指标,如支付总金额

- 衍生指标:基于原子指标添加了维度:近7天的支付总金额等

-

step5-定义事实与维度规范

- 命名规范、类型规范、设计规范等

-

step6-代码开发

-

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加v获取:vip204888 (备注大数据)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事it行业的老鸟或是对it行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

化的资料的朋友,可以添加v获取:vip204888 (备注大数据)**

[外链图片转存中…(img-ggxuub5w-1713381153802)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事it行业的老鸟或是对it行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

发表评论