一. 多头注意力

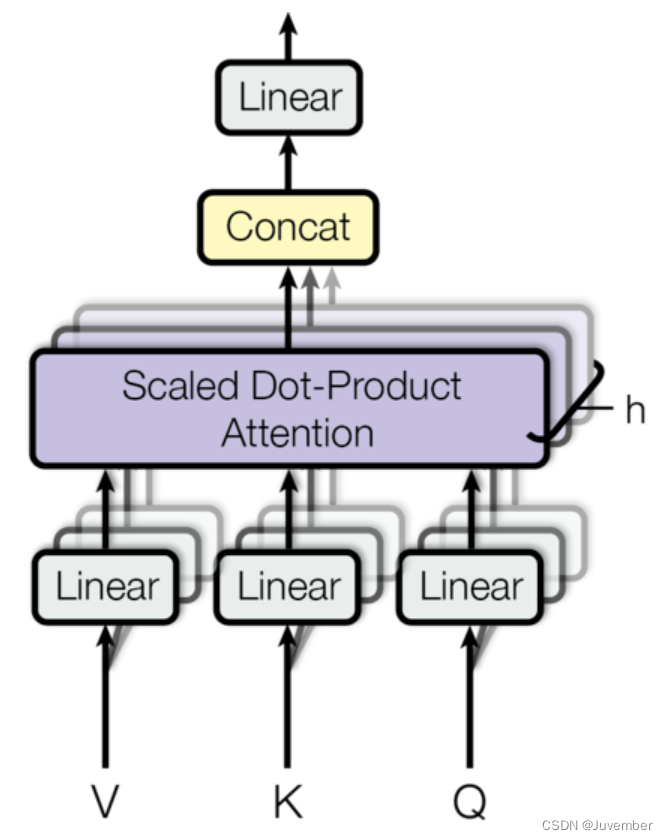

多头注意力(multi-head attention)是一种在transformer模型中被广泛采用的注意力机制扩展形式,它通过并行地运行多个独立的注意力机制来获取输入序列的不同子空间的注意力分布,从而更全面地捕获序列中潜在的多种语义关联。

在多头注意力中,输入序列首先通过三个不同的线性变换层分别得到query、key和value。然后,这些变换后的向量被划分为若干个“头”,每个头都有自己独立的query、key和value矩阵。对于每个头,都执行一次scaled dot-product attention(缩放点积注意力)运算,即:

a

t

t

e

n

t

i

o

n

(

q

,

k

,

v

)

=

s

o

f

t

m

a

x

(

q

⋅

k

t

d

k

)

⋅

v

attention(q, k, v) = softmax(\frac{q\cdot k^t}{\sqrt{d_k}})\cdot v

attention(q,k,v)=softmax(dkq⋅kt)⋅v

最后,所有头的输出会被拼接(concatenate)在一起,然后再通过一个线性层进行融合,得到最终的注意力输出向量。

通过这种方式,多头注意力能够并行地从不同的角度对输入序列进行注意力处理,提高了模型理解和捕捉复杂依赖关系的能力。在实践中,多头注意力能显著提升transformer模型在自然语言处理和其他序列数据处理任务上的性能。

二. 为什么使用多个注意力头

1、并行处理多种注意力模式:每个注意力头使用不同的线性变换,这意味着它们可以从输入序列的不同子空间中学习不同的特征关联。这样一来,模型可以通过多个注意力头同时关注输入序列的不同方面,例如语法结构、语义角色、主题转移等。

2、增加模型的学习能力和表达力:通过多个注意力头,模型可以学习到更丰富的上下文信息,每个头可能关注输入的不同特征,这些特征综合起来可以更全面地理解和处理输入序列。

3、提高模型性能:实验证明,多头注意力机制相较于单头注意力,往往能带来性能提升。这是因为模型可以通过并行处理和集成多个注意力头的结果,从不同角度捕捉数据的多样性,增强了模型对复杂序列任务的理解和泛化能力。

三. 多头自注意力(multi-head self-attention)

多头自注意力(multi-head self-attention)是多头注意力的一种,都属于注意力机制在深度学习中的应用,尤其是自然语言处理(nlp)领域的transformer模型中。

3.1 自注意力就是q=k=v?

在多头自注意力机制中,输入序列也是通过不同的线性变换得到 q q q、 k k k和 v v v向量。通常情况下, q q q、 k k k、 v v v 是由输入数据经过不同的权重矩阵 w q w^q wq、 w k w^k wk、 w v w^v wv转换得到的。

然而,在某些情况下,为了简化模型或出于其他设计考虑,可以设置 q q q= k k k= v v v,即使用相同的向量同时作为查询、键和值。这种设计可以减少模型的参数数量,并且在一些情况下可能有助于模型的学习效率和泛化能力。不过,这种设计也可能会限制模型捕捉不同类型信息的能力,因为查询、键和值在功能上是有所区分的。

所以,虽然在多头自注意力机制中 q q q= k k k= v v v 是一种可能的设计选择,但并不是所有情况下都适用。在实际应用中,是否采用这种设计取决于具体的任务需求和模型架构的考量。

3.2 多头自注意力与多头注意力的区别

1、应用场景:

- 多头注意力不仅限于自注意力场景,它可以应用于任何形式的注意力机制,包括但不限于跨序列的注意力,比如在一个序列上对另一个序列的注意力(cross-attention)。

- 多头自注意力特指在同一序列内部,每个元素对其它所有元素的注意力机制进行了多头处理,用于捕获序列内元素间的复杂依赖关系,常见于transformer的编码器和解码器中。

2、功能聚焦点:

- 多头注意力可以用来同时考虑多种类型的关联性,无论是否是同一序列内的元素间相互作用。

- 多头自注意力特别强调的是序列自身的自参照特性,即序列的每一个位置都能查看整个序列并据此调整自身的表现形式。

总结来说,多头注意力是一个通用术语,当应用于序列本身时,就成为多头自注意力。两者都是为了通过并行处理多个注意力视角来增强模型的表达能力和捕捉复杂模式的能力,只不过多头自注意力特别针对的是序列自身的上下文信息挖掘。

发表评论