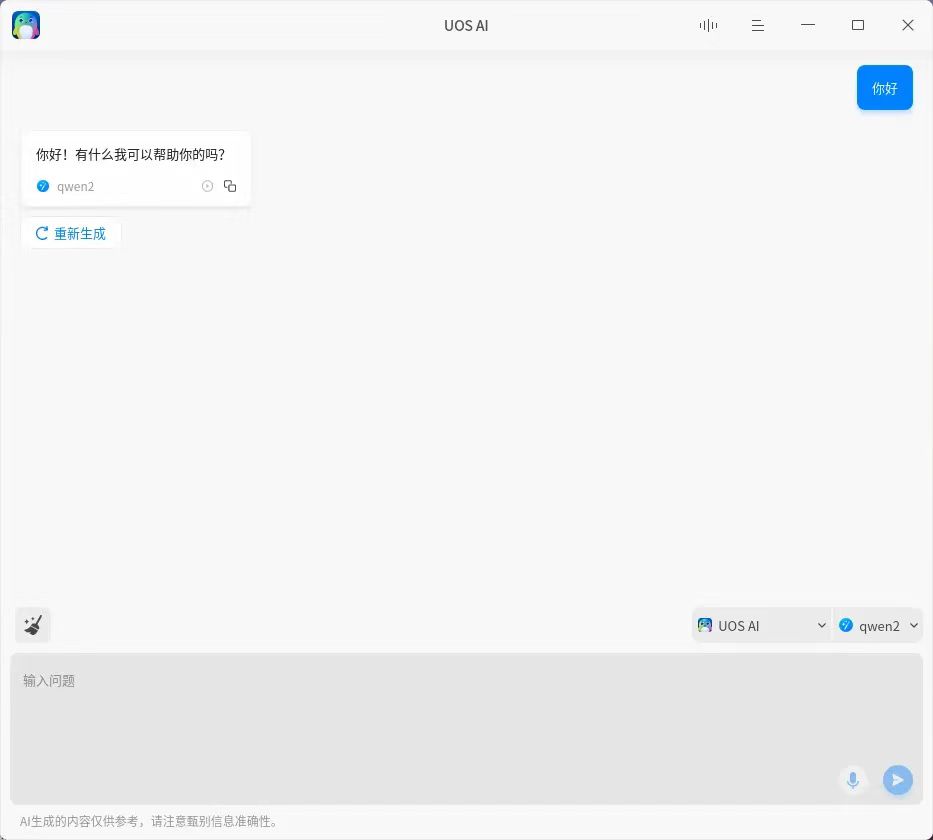

科技飞速发展的今天,操作系统作为计算机系统的灵魂,其每一次的更新与变革都牵动着无数用户的心弦。近日,开源操作系统 deepin 迎来了一次重大更新,这次更新不仅在性能上进行了全面优化,更在 ai 智能化方面迈出了划时代的步伐:内置 ai 助理,并成功兼容多个千亿级大模型,为用户带来了前所未有的智能操作体验。

为了让 deepin 和 uos ai 变得更开放、更强大,支持更多的大模型,我们开放了 uos ai 的模型接入接口,所有 openai 接口格式的大模型均可以接入到 uos ai,你可以根据自身需求,自行接入自己喜欢的大模型,让 uos ai 成为更个性化的智能伙伴。为了让更多用户了解如何配置专属模型,本篇文章将详细介绍:

1. uos ai 如何接入在线模型(例如月之暗面和智谱)

2. uos ai 如何接入本地模型(例如使用 ollama 运行本地模型)

uos ai 如何接入在线模型

目前,uos ai 1.3.0 版已在 deepin v23 rc2 应用商店发布,新版支持用户添加自定义模型。

接入条件

uos ai 的自定义模型的接口规范为 openai 的 /v1/chat/completions。因此只有提供了 openai 兼容接口的模型服务才可以被添加到 uos ai 中使用。

接入在线模型

接下来介绍在线模型的添加方式:

一、月之暗面

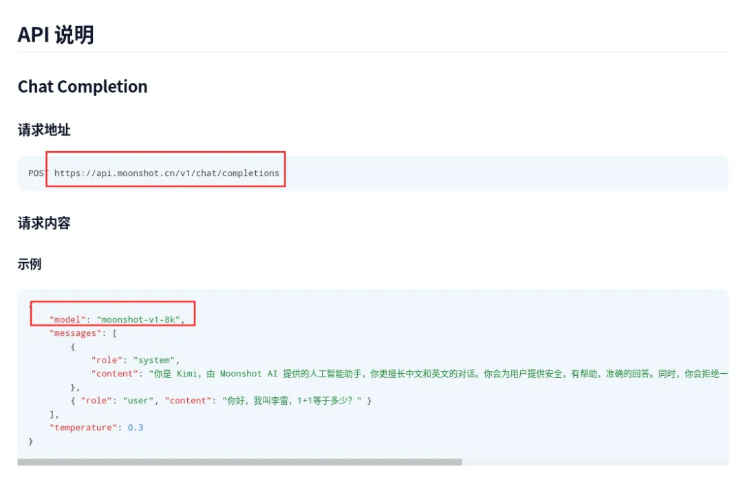

01:获取 api

打开月之暗面的 api 说明,获取:模型名称和 domain(请求地址):https://platform.moonshot.cn/docs/api/chat#api-%e8%af%b4%e6%98%8e

请求地址:https://api.moonshot.cn/v1/chat/completions

模型名称:moonshot-v1-8k

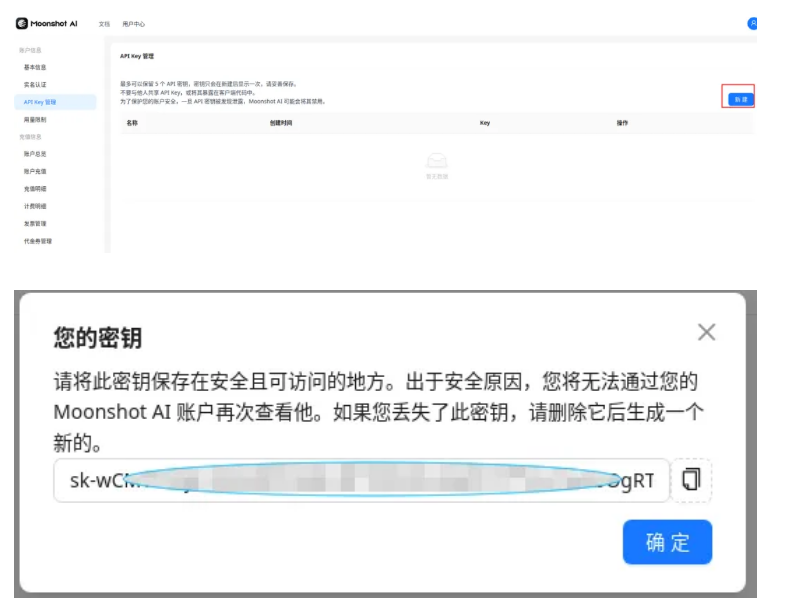

02:获取 api key

登录月之暗面控制台:https://platform.moonshot.cn/console/api-keys

进入【api key 管理】,点击右侧 “创建” 按钮,生成 api key:

在此界面复制生成的密钥。

03:uos ai 添加模型

进入 uos ai 设置界面,添加模型。在模型添加界面的模型选项中切换为 “自定义”。然后填入以下信息:

- api key:在 api key 栏粘贴上步复制的密钥

- 账号名称:任意填写

- 模型名称:填入第一步中月之暗面 api 声明的模型名称:moonshot-v1-8k

- 请求地址:https://api.moonshot.cn/v1

最终的填写效果是:

点击确认,完成校验后即可在对话窗口中使用。

二、智谱

01:获取 api

进入智谱 ai 开发平台,查询模型 api:https://open.bigmodel.cn/dev/api#glm-4

请求地址:https://open.bigmodel.cn/api/paas/v4/chat/completions

模型名称:glm-4

02:获取 api key

进入智谱《api keys》界面:https://open.bigmodel.cn/usercenter/apikeys

点击右侧《添加新的 api key》按钮,并在生成的新 key 后点击复制按钮。

03:uos ai 添加模型

进入 uos ai 设置界面,添加模型,在模型添加界面的模型选项中切换为 “自定义”。然后填入以下信息:

-

api key:在 api key 栏粘贴上步复制的密钥

-

账号名称:任意填写

-

模型名称:填入智谱模型的模型名称:glm-4

-

请求地址:uos ai 会在请求地址中自动添加 /chat/completions,因此这里填入的地址需要在智谱的地址去掉 /chat/completions 部分。实际填入的为:https://open.bigmodel.cn/api/paas/v4

点击确认,完成校验后即可在对话窗口中使用。

三、其他模型

其他兼容 openai api 接口的在线模型皆可用以上方法接入。

下面为部分大模型厂商的 api 说明:

-

通义千问:https://help.aliyun.com/zh/dashscope/developer-reference/compatibility-of-openai-with-dashscope

-

零一万物:https://platform.lingyiwanwu.com/docs#api-%e5%b9%b3%e5%8f%b0

uos ai 如何接入本地模型

ollama

ollama 是一个开源的大语言模型本地部署工具,通过它可以方便的在本机部署开源大模型。

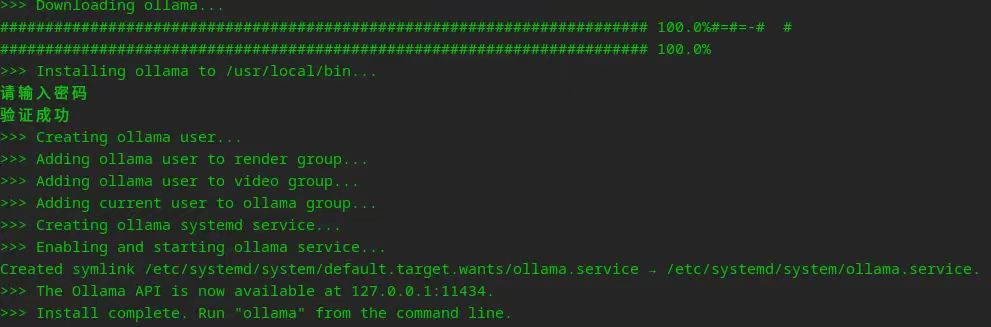

01:安装

ollama 仓库地址:https://github.com/ollama/ollama

按照教程在 deepin v23 中安装 ollama 程序。执行以下命令,直接安装 ollama。

curl -fssl https://ollama.com/install.sh | sh

ollama 服务地址:127.0.0.1:11434

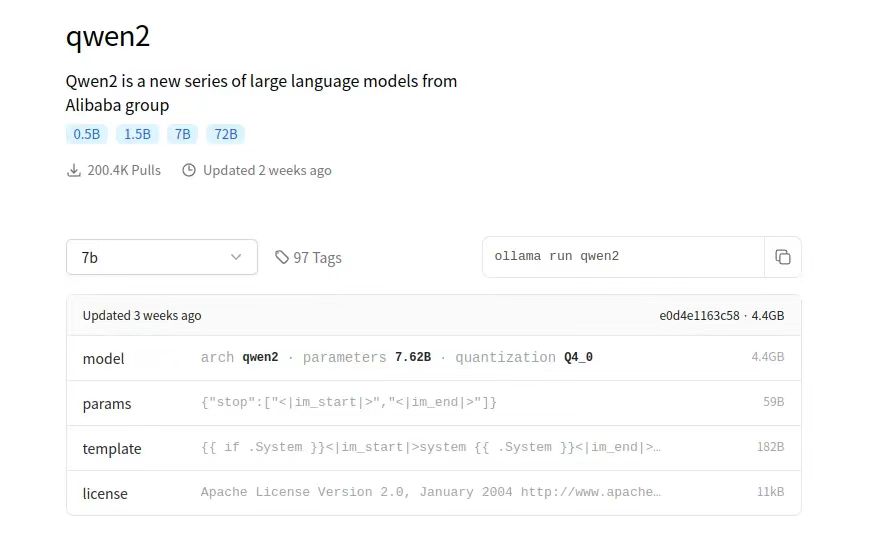

02:运行

安装完成后在终端运行模型,如 qwen2 的 7b 模型:ollama run qwen2:7b

模型第一次运行会自动下载,根据网络情况需要等待一会儿。

03:模型仓库

ollama 模型仓库:https://ollama.com/library

可根据自身需要选择模型。

04:uos ai 配置

ollama 启动模型后,即可在 uos ai 中添加该模型。

① 进入 uos ai 的模型添加界面,选择模型类型为自定义。

②账号名称:根据需要随意填写。

③api key:ollama 未开启鉴权,可以随意填写。

④模型名:填写 ollama 运行的模型名称,如前文运行的是 qwen2:7b,那么这里就填 qwen2:7b。

⑤模型请求地址:

ollama 默认服务地址为 127.0.0.1:11434,

其 openai 的兼容接口为 http://127.0.0.1:11434/v1/chat/completions

因此在 uos ai 中只需填入:http://127.0.0.1:11434/v1

完成添加后即可在 uos ai 中与本地模型对话。

目前,deepin uos ai 已覆盖 90% 主流开源大模型与 ai 框架,随着模型接口的开放,用户将在 uos ai 中体验到更多优秀的国内外大模型。未来,deepin 将持续探索大模型与 ai 原生应用,自然语言交互兼容性,数据安全性等多个技术点,推动人工智能与基础软件融合,为产业发展带来革命性变化。

附录:

(1)deepin 历史版本镜像(含 deepin v15):https://distrowatch.com/index.php?distribution=deepin

(2)uos ai 打通全局智能搜索:https://www.deepin.org/zh/uos-ai-gets-a-major-upgrade/

发表评论