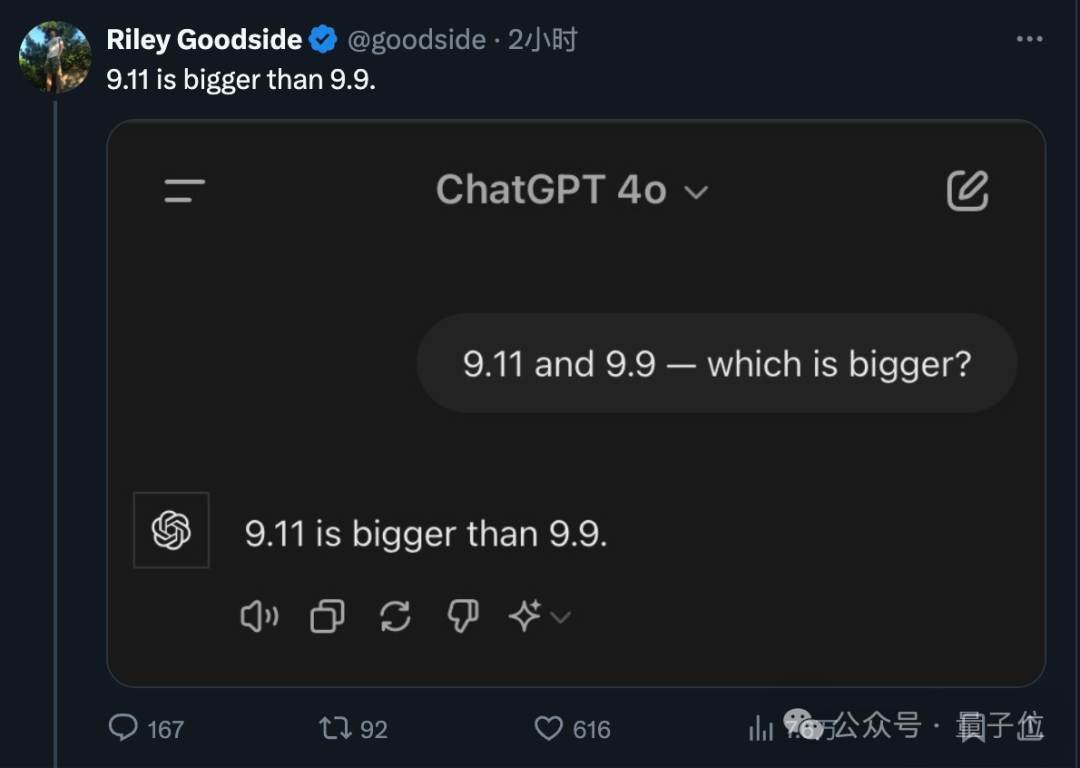

大模型集体失智!9.11和9.9哪个大,几乎全翻车了

- ai处理常识性问题能力受限,9.11>9.8数学难题暴露了ai短板。

- 训练数据偏差、浮点精度问题和上下文理解不足是ai在数值比较任务上可能遇到的困难。

- 改进ai需优化训练数据、prompt设计、数值处理准确性和逻辑推理能力,以提高处理常识性问题的能力。

🔗大模型集体失智!9.11和9.9哪个大,几乎全翻车了-csdn博客

又一个ai搜索引擎诞生:exa ai

- 称要做真正的 ai 搜索引擎取代google

- 与传统搜索引擎不同的是,exa 的搜索引擎专为ai模型设计。

- 使用向量数据库和嵌入模型(embedding models)技术,训练模型来预测下一个相关链接,而不是下一个词。这个方法使exa能够处理链接数据集,从而提供与众不同的搜索结果。

- exa使用端到端的transformer模型来过滤互联网信息,根据查询的实际意义而非关键词进行筛选。

🔗网站: https://exa.ai/

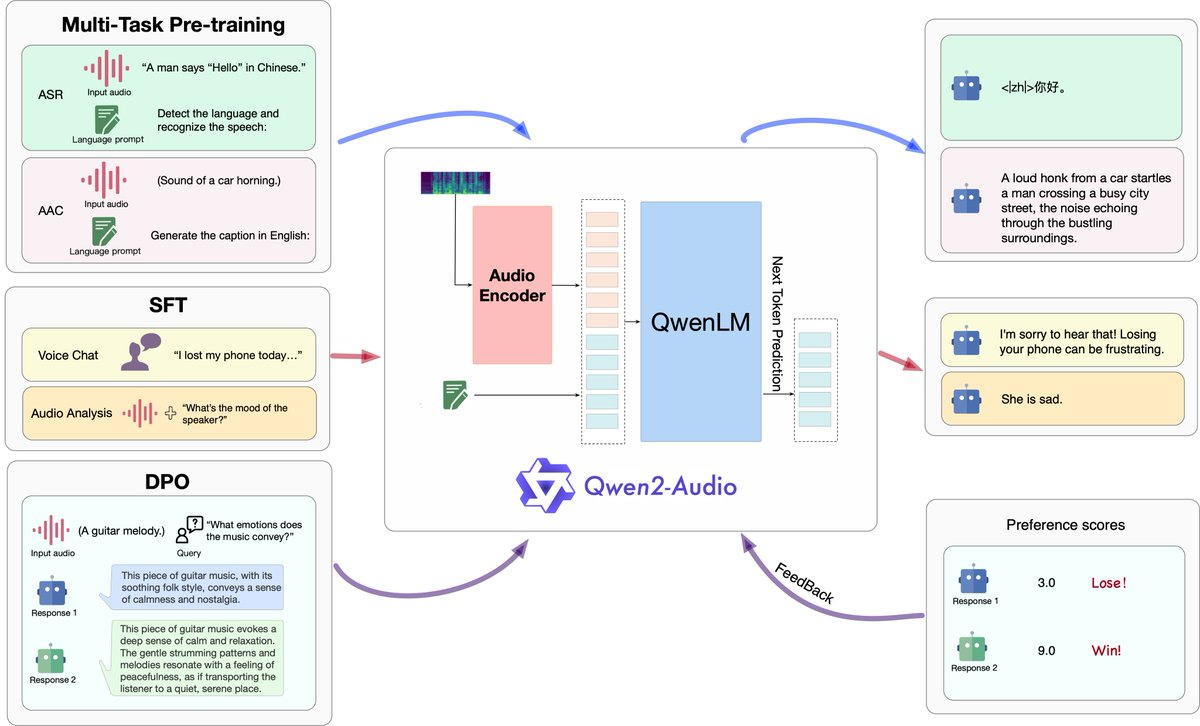

阿里巴巴发布语音模型:qwen2-audio

- 可与模型直接语音对话以及分析转录各种声音

- qwen2-audio可以通过语音聊天和音频分析两种方式与用户互动。在语音聊天模式下,用户可以与模型进行直接的语音对话,在音频分析模式下,用户可以上传音频文件进行转录分析等。

- qwen2-audio 能够识别语音中的情感,如愤怒、快乐、悲伤等。

- 用户无需区分语音聊天和音频分析模式,模型能够智能识别并在实际使用中无缝切换两种模式。

- qwen2-audio的模型架构由音频编码器和大语言模型组成:音频编码器基于whisper-large-v3模型;基础组件是qwen-7b

🔗github:https://github.com/qwenlm/qwen2-audio

🔗论文:https://arxiv.org/pdf/2407.10759

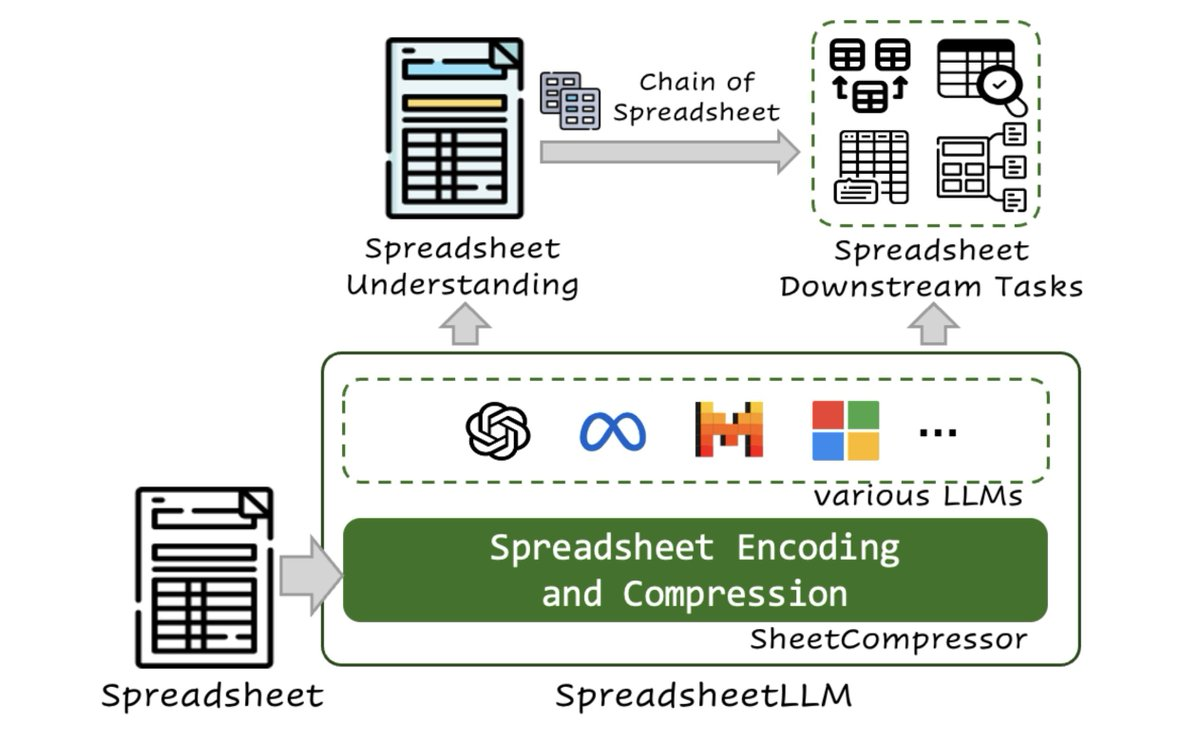

微软团队研究出新方法:可以让大语言模型更好地理解和处理电子表格数据

- 该方法显著提高了模型在电子表格表格检测和问答任务中的性能,同时大大减少了处理所需的计算资源。

- 在电子表格表格检测任务中的性能相比基础方法提高了25.6%,并且在f1评分上达到了78.9%,超过了现有最好的模型12.3%。

- spreadsheetllm主要通过三个主要步骤来实现:

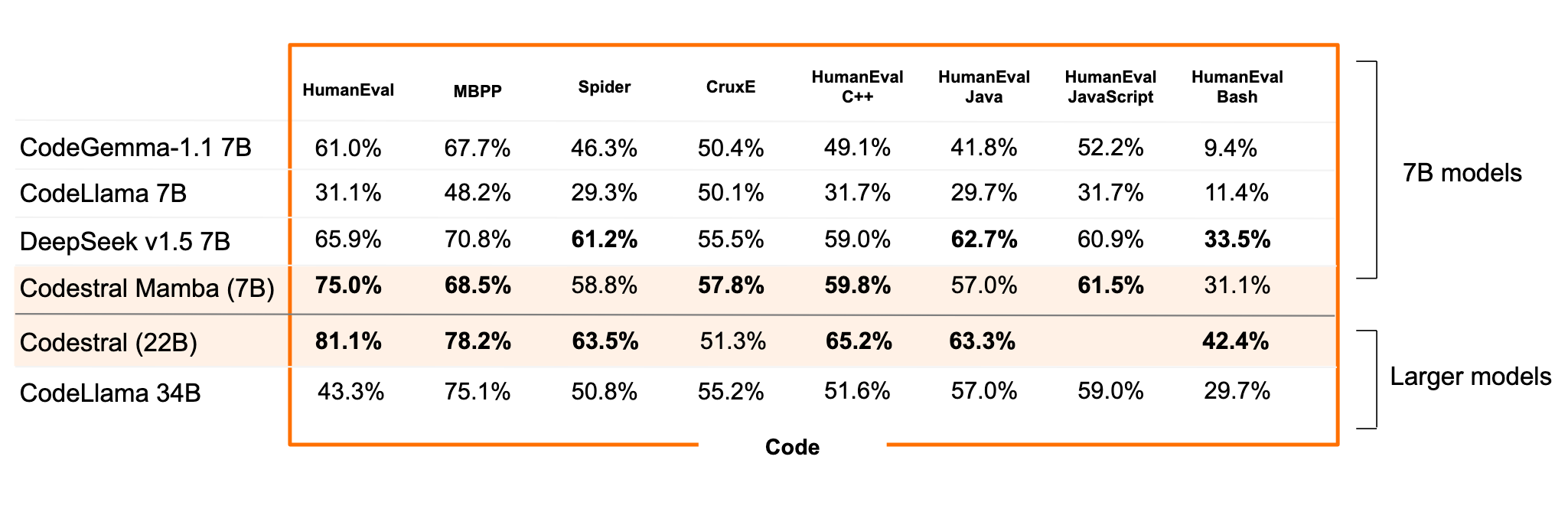

mistral发布了2个7b小模型:codestralmamba 7b和mathstral 7b

- codestral mamba超越了deepseek qwencode,成为小于10b参数的最佳模型,并且可以与codestral22b竞争,并且支持256k的上下文。

- 与传统的transformer模型不同,mamba模型在处理时间上更高效,并且可以处理无限长度的输入序列。用户可以免费使用、修改和分发该模型,适用于各种代码相关的应用场景。

🔗官方介绍:https://mistral.ai/news/codestral-mamba/

🔗模型下载:https://huggingface.co/mistralai/mamba-codestral-7b-v0.1

🔗模型下载:https://huggingface.co/mistralai/mathstral-7b-v0.1

🔗详情:mathσtral | mistral ai | frontier ai in your hands

可在手机运行!hugging face推小语言模型smollm

- 高效性能: smollm模型在低计算资源下表现出色,保护用户隐私。

- 丰富数据: 使用高质量的smollm-corpus数据集,确保模型学习到多样知识。

- 多种应用: 适用于手机、笔记本等设备,灵活运行,满足不同需求。

🔗 https://huggingface.co/blog/smollm

发表评论