名词解释

数据:数据一个载体,这个载体蕴含着信息。

数据集:是数据对象的集合,其中包含着数据对象。

数据对象:是用一组刻画对象基本特性的属性描述。

属性:是对象的性质或特性,用于描述数据的某个特征。

属性(特征)类型:按性质分为定位属性、定性属性、定量属性、时间属性,按表现形式分为数字数据、模拟数据。

数据类型:记录性数据,图数据,序列数据,典型的数据类型有标量、序数、区间和比率。

数据特性:维度,稀疏性,分辨率

数据约简主要策略:数据立方归并。维数约简。数据压缩。数据块约简。

相似度:是一个函数,输出一个[0,1]之间的实数值,用于量化相近程度,两个对象越接近,相似度就越高。

gini系数、信息熵、最大错误率:gini系数和信息熵是连续的,而最大错误率是不连续的。都是在p=0.5时取值最大。在两端时取值最小。以gini系数为划分准则更准确。

x

=

(

a

1

,

b

1

,

c

1

)

y

=

(

a

2

,

b

2

,

c

2

)

x=(a_1,b_1,c_1)\\ y=(a_2,b_2,c_2)\\

x=(a1,b1,c1)y=(a2,b2,c2)

欧氏距离:

(

a

1

−

a

2

)

2

+

(

b

1

−

b

2

)

2

+

(

c

1

−

c

2

)

2

\sqrt{(a_1-a_2)^2+(b_1-b_2)^2+(c_1-c_2)^2}

(a1−a2)2+(b1−b2)2+(c1−c2)2

余弦相似度:

a

1

×

a

2

+

b

1

×

b

2

+

c

1

×

c

2

a

1

2

+

b

1

2

+

c

1

2

+

a

2

2

+

b

2

2

+

c

2

2

a_1\times a_2 +b_1\times b_2+c_1\times c_2 \over \sqrt{a_1^2+b_1^2+c_1^2} +\sqrt{a_2^2+b_2^2+c_2^2}

a12+b12+c12+a22+b22+c22a1×a2+b1×b2+c1×c2

jaccard相似系数:

j

=

m

11

m

11

+

m

01

+

m

10

j = {m_{11} \over m_{11}+m_{01}+m_{10}}

j=m11+m01+m10m11

k-means(流程)

输入:

- 数据集:包含 n 个样本的数据集,每个样本有 m 个特征。

- 聚类数 k:用户事先指定的要将数据分成的簇的数量。

输出:

- k 个聚类中心:代表每个簇的中心点。

- 每个样本所属的簇:每个样本被分配到的聚类。

聚类过程(流程):

- 初始化:随机选择 k 个样本作为初始的聚类中心。

- 分配:计算每个样本与 k 个聚类中心的距离,并将每个样本分配到距离最近的聚类中心所代表的簇。

- 更新:重新计算每个簇的中心,即将每个簇中所有样本的特征均值作为新的聚类中心。

- 迭代:重复步骤 2 和 3,直到满足停止条件,如达到最大迭代次数或聚类中心不再改变。

k-means 通过不断迭代优化簇的分配,使得簇内样本的相似度最大化,簇间的相似度最小化。最终得到 k 个簇的聚类结果,每个样本被归到其中一个簇中。

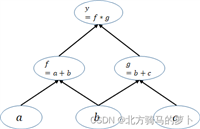

决策树(流程)

决策树是一种常用的机器学习算法,它可以用于分类和回归任务。在分类任务中,决策树通过对数据集进行递归的、树形结构的分割来进行分类。

基本构成:

- 节点(node):代表数据集中的一个特征。

- 分支(branch):代表特征的取值。

- 叶子节点(leaf node):代表最终的分类结果。

分类过程:

- 选择特征:从数据集中选择最佳的特征来进行分割。常用的指标有信息增益、基尼不纯度等。

- 分割数据集:根据选定的特征和阈值,将数据集分割成不同的子集。

- 递归:对每个子集重复上述过程,直到满足某个终止条件,例如达到最大深度、节点样本数少于阈值等。

分类的步骤:

- 准备数据:收集并准备带有标签的数据集。

- 选择最佳特征:通过某种标准(如信息增益)选择最佳的特征来进行分割。

- 构建决策树:递归地构建决策树,选择最佳特征并分割数据集,直到满足停止条件。

- 分类:使用构建好的决策树对新样本进行分类,沿着树的分支根据特征值逐步判断,最终到达叶子节点即为分类结果。

k 折交叉验证(流程)

k 折交叉验证是一种评估机器学习模型性能的方法,可以在数据较少的情况下有效地评估模型的泛化能力。

步骤:

- 数据集划分:将数据集分成 k 个大小相似的子集。

- 循环验证:对模型进行 k 次训练和验证,每次使用其中一个子集作为验证集,其余 k-1 个子集作为训练集。

- 评估性能:每次训练模型后,使用验证集计算模型的性能指标(如准确率、精确率、召回率等)。

- 平均性能:将 k 次验证得到的性能指标取平均作为模型的最终性能评估指标。

k 折交叉验证能够更充分地利用数据集,减少因数据划分不同而引入的偶然性,提高了对模型性能的评估可靠性。

dbscan 聚类(流程)

dbscan是一种基于密度的聚类算法,其主要思想是通过样本点周围的密度来发现簇,并能识别出噪声点。

- 选择参数:设置半径 eps 和最小样本数 minpts。

- 寻找核心点:计算每个样本点的邻域,识别核心点。

- 扩展簇:从核心点开始,沿着密度可达的路径(相邻核心点的连接)扩展簇。

- 标记噪声点:将无法被核心点直接或间接连接的点标记为噪声点。

优、缺点

朴素贝叶斯(分类):

优点:简单有效,对小样本数据效果好,对噪声数据的鲁棒性强。

缺点:朴素假设可能不符合实际情况,对特征相关性强较强的数据不适用。

决策树(分类):

优点:利于理解和解释,能够处理数值型和类别型数据,对缺失值不敏感。

缺点:容易过拟合,不稳定,不适用特征性关系较强的数据。

knn(分类):

优点:简单、适用广泛,对新数据集适应能力强,不需要假设数据分布情况。

缺点:计算开销大,需要大量存储空间,对异常值敏感。

k-means(聚类):

优点:易于理解实现,计算效率高,适用广泛。

缺点:需要提前预定聚类数量k,对聚类中心和异常值敏感,可能陷入局部最优解。

dbscan (聚类):

优点:不受初始值的影响,能够处理离群点和噪声,对任意形状的簇都有效。

缺点:对参数敏感,效率较低,簇密度过大时,无法准确识别簇的边界

apriori(关联规则):

优点:易于理解实现,可用于大规模数据,灵活性强。

缺点:候选集庞大,需要多次扫描数据集,计算和存储开销大。

fp-tree(关联规则):

优点:不产生候选集,只需扫描两次数据集,可处理连续值和高基数数据。

缺点:对内存要求过高,fp树构建过程可能比较缓慢。/

发表评论