不要盲目一下子就跟着做哦,先从头到尾看一遍哦,合适再来!或者多参考一下很多大佬的!

前言

anaconda+pycharm+nvidia显卡驱动+pytorch(含gpu版)+cuda+cudnn 这种组合就像是一个强大的“开发工具箱”,每一个部分都有其独特的功能,但当它们组合在一起时,它们能够协同工作,使深度学习和其他计算密集型任务变得更加高效和容易。

这些软件之间的协同工作可以视为一个高效的“深度学习生产线”,每个环节都扮演着不可或缺的角色,共同推动深度学习任务的高效完成。

首先,anaconda作为这个生产线的“基础平台”,为整个环境提供了稳定且强大的python支持。它确保了所有需要的python包(如numpy、pandas等)都能得到妥善管理,并通过conda这个包和环境管理器,帮助用户创建和切换不同的工作环境,确保不同项目之间的依赖关系不会相互干扰。

接着,pycharm作为“开发车间”,提供了强大的代码编辑、调试和测试功能。开发者可以在这个舒适的界面中编写、调试和优化python代码,确保深度学习模型的逻辑正确和性能优化。

而nvidia显卡驱动则是这个生产线的“动力源泉”。它确保了显卡能够正常工作,并与操作系统及其他软件无缝对接。对于深度学习任务来说,显卡的计算能力至关重要,而显卡驱动就是激发这种能力的关键。

pytorch(含gpu版)则是这个生产线的“核心生产线”,负责构建和优化深度学习模型。gpu版本的pytorch能够充分利用显卡的并行计算能力,显著加速模型的训练和推理过程。在这里,模型的结构、参数以及训练过程都由pytorch精心管理。

cuda和cudnn则像是生产线上的“高级技工”。cuda提供了与显卡通信的接口,使得pytorch能够调用显卡进行计算。而cudnn则针对深度学习中常见的基本操作进行了优化,为pytorch提供了更加高效的计算工具。这两者的协同工作,使得深度学习任务能够更快地完成。

在整个协同工作的过程中,这些软件之间的数据流动是无缝的。pytorch构建的模型可以在pycharm中进行调试和优化,然后通过cuda和cudnn在显卡上进行高效的计算。而anaconda则确保了整个过程中python环境的稳定和一致。

总的来说,这些软件之间的协同工作构成了一个高效、稳定的深度学习开发环境,使得开发者能够更轻松、更高效地进行深度学习任务的开发和实验。

一、安装anaconda3并配置环境

1.这是我安装anaconda的教程

2. 这里有详细安装环境为python3.7的教程,用于传统机器学习

链接:anaconda3+pycharm 搭建深度学习环境;安装不同框架;配置两个环境;anaconda配置国内镜像源-csdn博客

3. 配置python3.8版本的环境

3. 但目前,项目需要python3.8 ,因为python3.8用于承载pytorch的稳定性相对于其它版本较为良好,所以这里附上我安装python3.8环境的详解,我的环境名为yolo

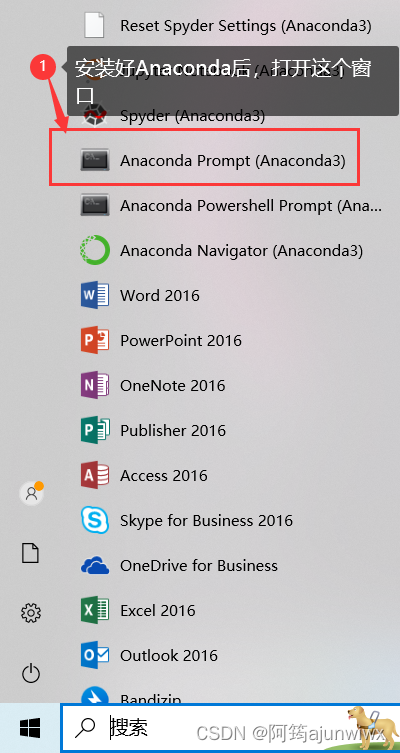

3.1 默认已经安装好anaconda后,开始菜单找到“anaconda prompt(anaconda)”打开它

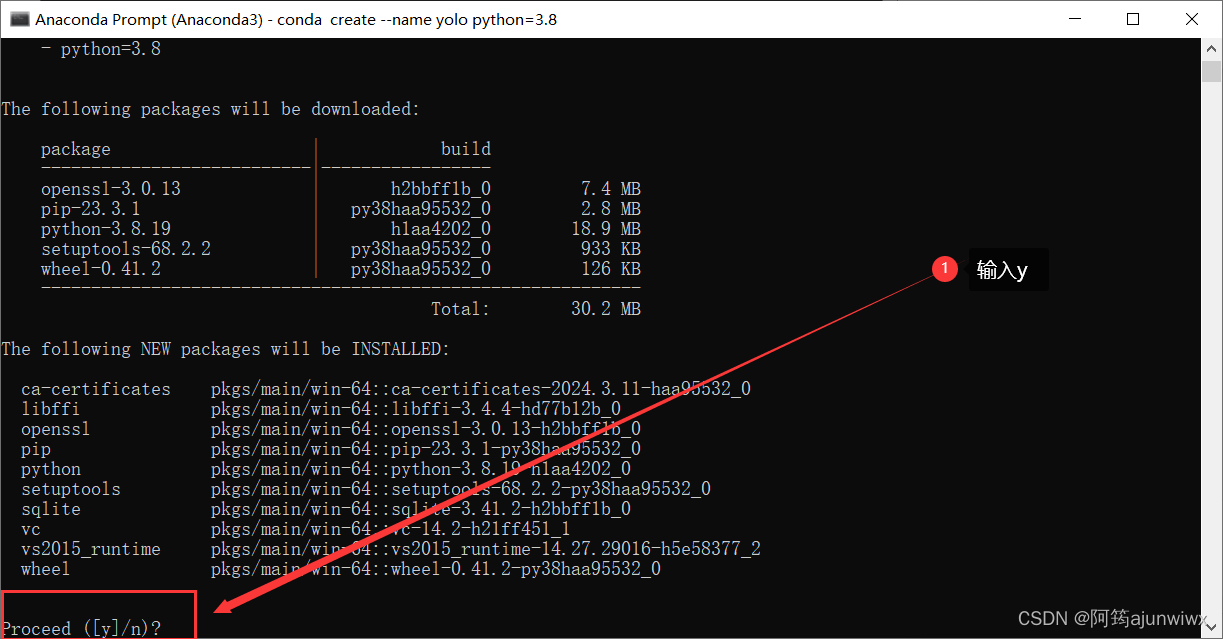

3.2 创建新环境,这里yolo是我的环境名字,取啥名任意哈各位~;

conda create --name yolo python=3.8

3.3 输入“y”后,回车确认;

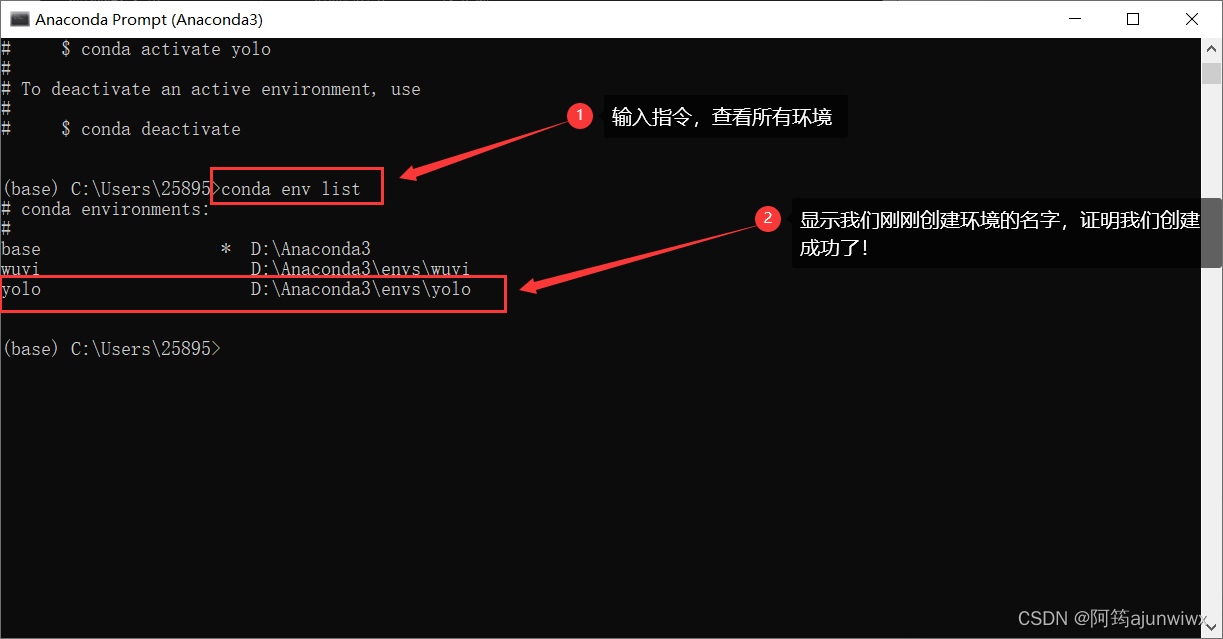

3.4 验证是否创建成功;

conda env list # 查看所有环境

3.5 输入下面指令,回车确认,激活你的环境;

conda activate yolo # 激活环境你的环境

3.6 接下来就是我们 pytorch框架的安装了,但如果是要跟我一样要跑数据集的,那么~,需要安装gpu版的,那么~,建议按照我下面的步骤走,不要急着安装新版的,因为每个项目适应的版本不一样~

二、安装pycharm

这是我安装的教程链接:pycharm安装教程-csdn博客

三、安装nvidia显卡驱动

可以先查看自己电脑显卡驱动的版本,在这里我安装驱动之前,我先查看我电脑的驱动(在下面2.3.1就是),不会查看的朋友可以看下面的《2. 验证是否成功安装好驱动》。

在这里先介绍一下

安装新版nvidia显卡驱动对于运行数据集来说是非常重要的,原因主要有以下几点:

首先,显卡驱动是显卡与计算机操作系统之间的接口,它使得显卡能够正常工作并发挥其应有的性能。当你运行一个数据集时,尤其是涉及图形处理或深度学习等计算密集型任务时,显卡的性能至关重要。因此,安装最新版的显卡驱动可以确保显卡与操作系统之间的兼容性,从而提供最佳的性能和稳定性。

其次,新版显卡驱动通常会修复旧版本中的一些错误和漏洞,提升显卡的性能和稳定性。这意味着在运行数据集时,新版驱动能够更有效地利用显卡的资源,减少出错的可能性,并提升计算速度。

此外,随着技术的发展和新的算法、技术的出现,新版显卡驱动还可能支持新的特性和功能。这些新特性可能有助于更好地处理数据集,提高计算效率,或者为开发者提供更多的灵活性和选择。

综上所述,安装新版nvidia显卡驱动可以确保显卡与操作系统的兼容性,提升显卡的性能和稳定性,并可能支持新的特性和功能,从而有助于更好地运行和处理数据集。

1. 安装对应自己电脑的驱动

1.1 官方链接:官方驱动 | nvidia;

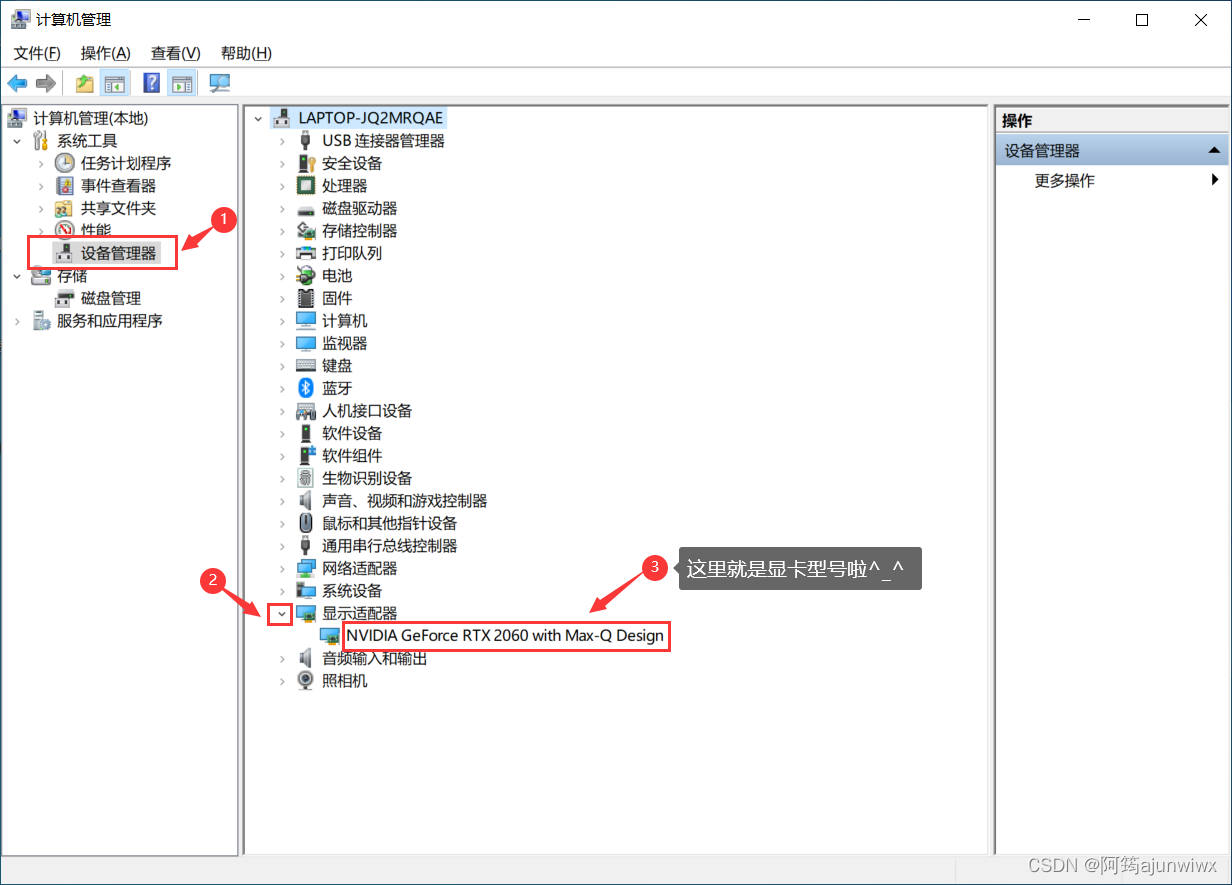

1.2 首先要在设备管理器中查看你的显卡型号;

1.3 在设别管理器中可以看到我们设备的显卡型号啦^_^

1.4 在官网上找自己的显卡型号系列;

根据自己的电脑的配置去选择驱动。这里notebooks是笔记本的意思,所以如果你是笔记本电脑,那么产品系列那个选项就要选择(notebooks)的。还有那个下载类型有两种一个是studio版本,一个是game ready版本。其实两个版本都差不多,一个是偏办公用,一个是偏游戏娱乐。按如下操作将驱动下载下来。

1.5 驱动程序下载,点击下载即可;

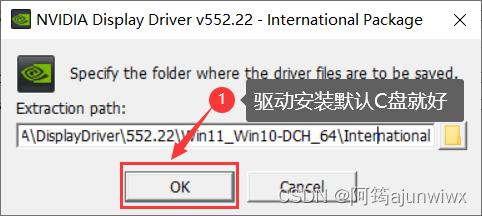

1.6 默认安装位置就好,不建议安装到别的盘里;

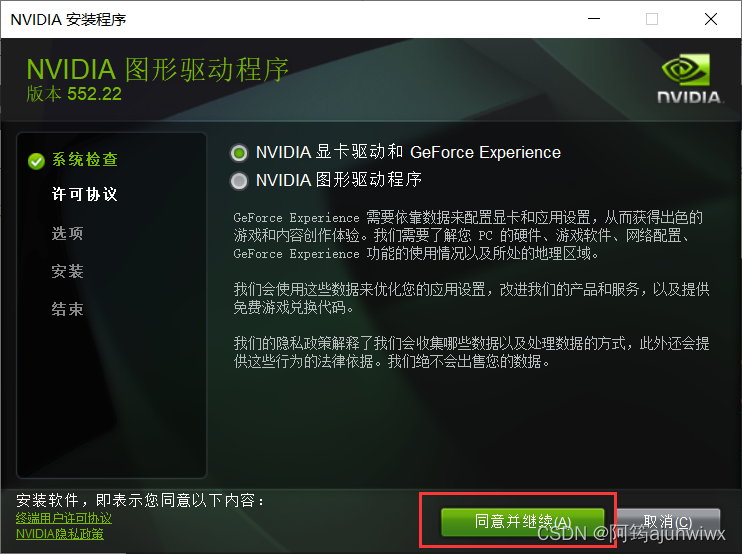

1.7 执行下一步吧;

1.8 第一次安装,默认精简吧;

1.9 在这里我就不创建桌面快捷方式了,按个人所需勾选吧;

2. 验证是否成功安装好驱动

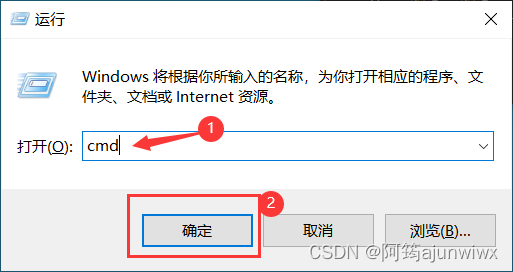

2.1 使用快捷键windows+r,输入cmd

2.2 输入以下代码

nvidia-smi

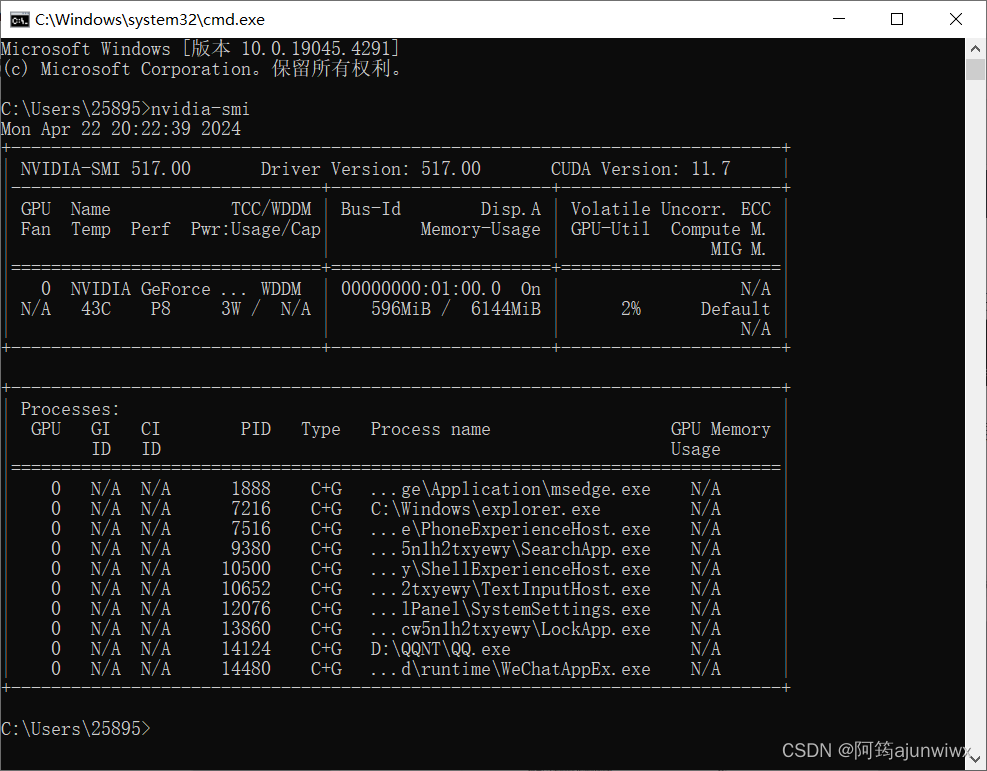

2.3 出现下面的信息说明安装成功

来来来,让我们做个对比

2.3.1 这是我电脑没安装更新的驱动配置图片

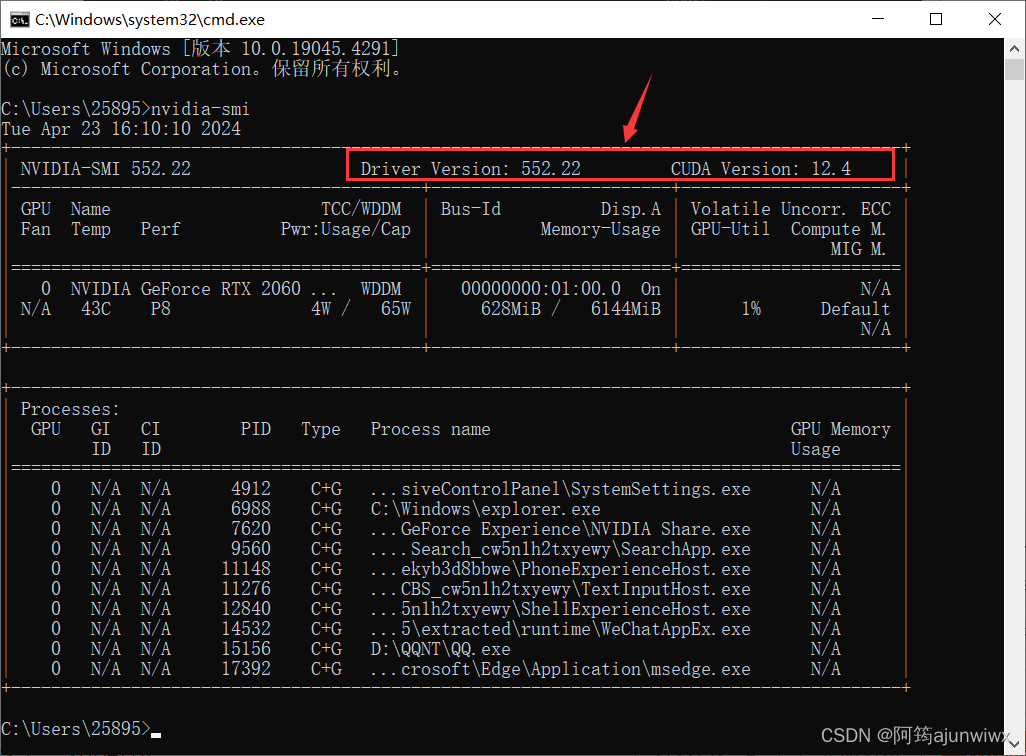

2.3.2 这是安装完上面的驱动后的图片

如下图的信息图,可以看到驱动的版本是552.22;最高支持的cuda版本是12.4版本。知道下面的信息就可以知道我们电脑最高适配程度,但要注意低版本的pytorch是否向上支持更高版本的cuda,也就是说要看我们需要的项目支持的pytorch版本再来安装对应的cuda,例如在下面的顺序里 3. yolo里支持的pytorch版本!!!!

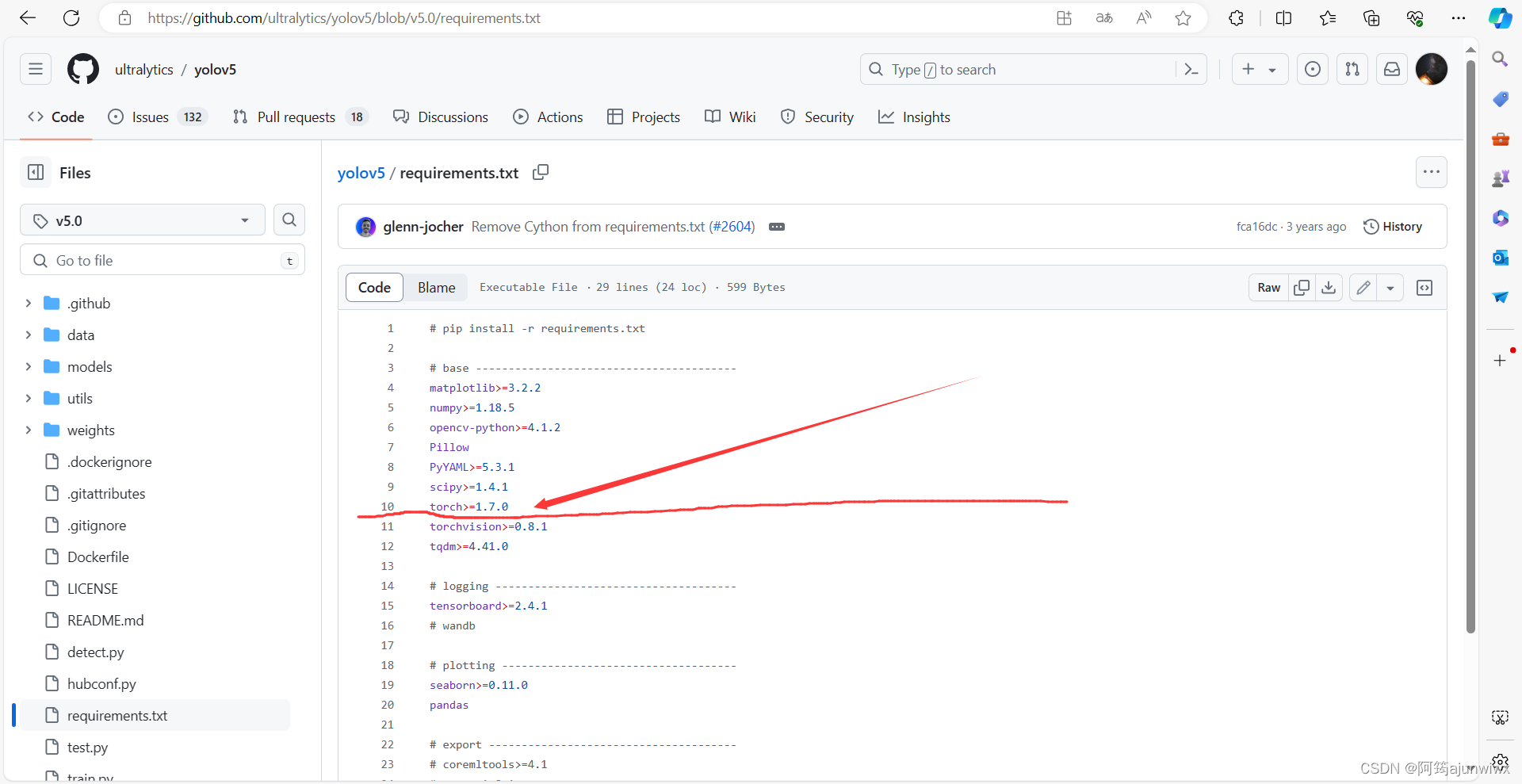

3. yolo里支持的pytorch版本

3.1 yolov5支持的pytorch版本

这里先浅浅看一下,后面有专门的讲解如何下载github项目即yolov5项目克隆

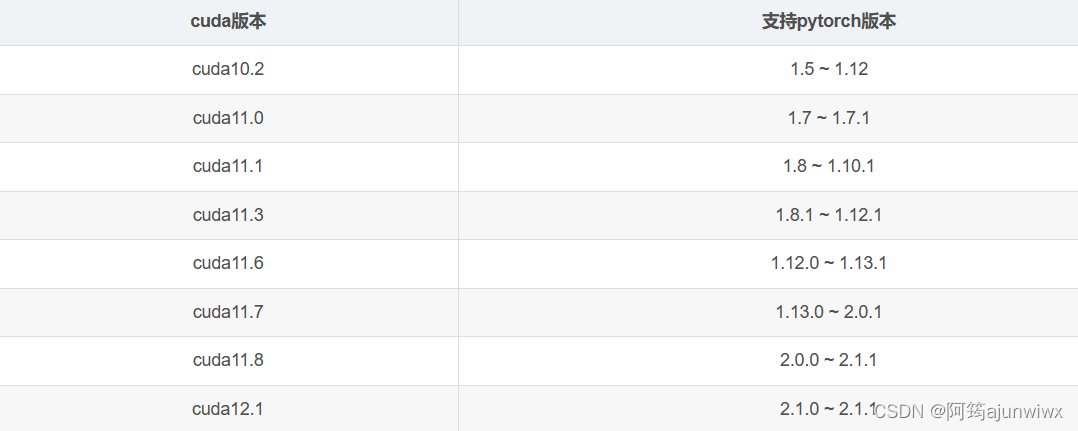

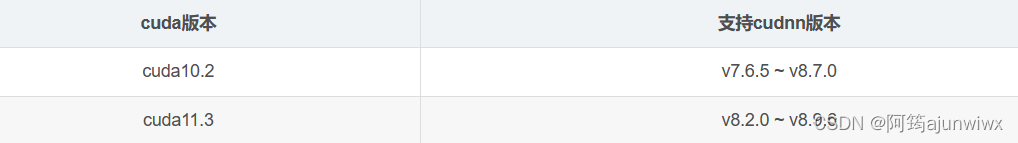

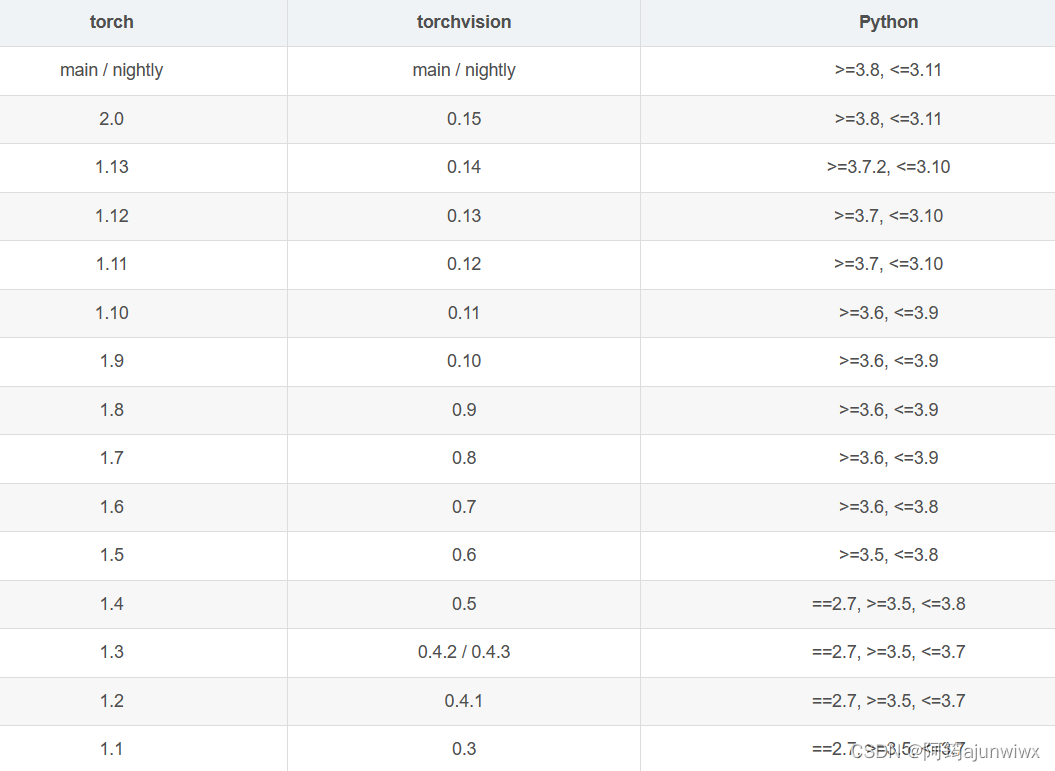

四、pytorch与cuda版本对应关系汇总

1. pytorch与cuda版本关系

2. cuda 与 cudnn关系

3. pytorch 与 python关系

五、安装cuda

1. 从nvidia官网下载cuda11.1

这里我放百度网盘链接安装包,有需要的朋友自己取哦^_^

链接:https://pan.baidu.com/s/1-6hbfi-pc_f8psevx65xiq?pwd=1234

提取码:1234

--来自百度网盘超级会员v5的分享

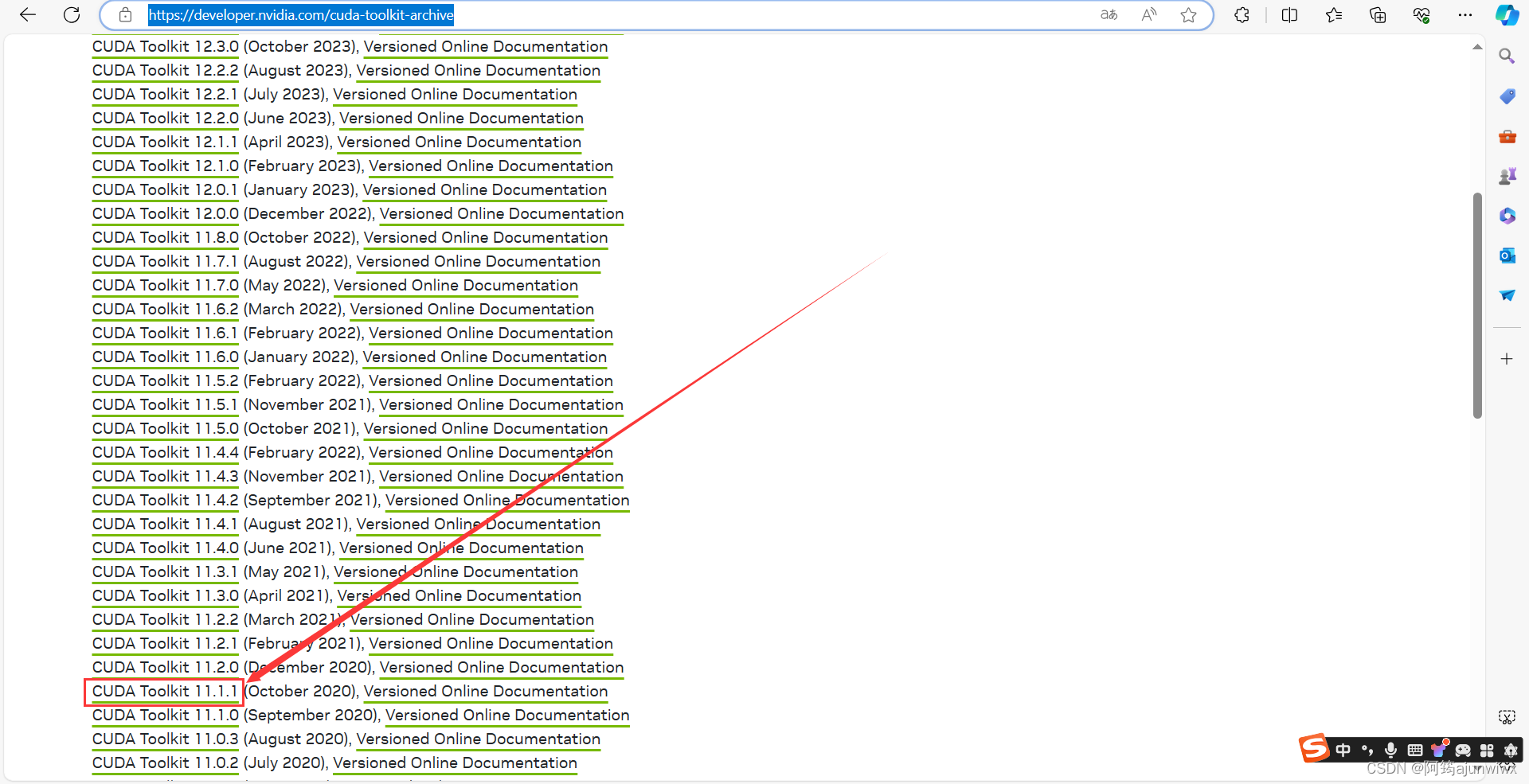

1.0 这是官网链接:cuda toolkit archive | nvidia developer

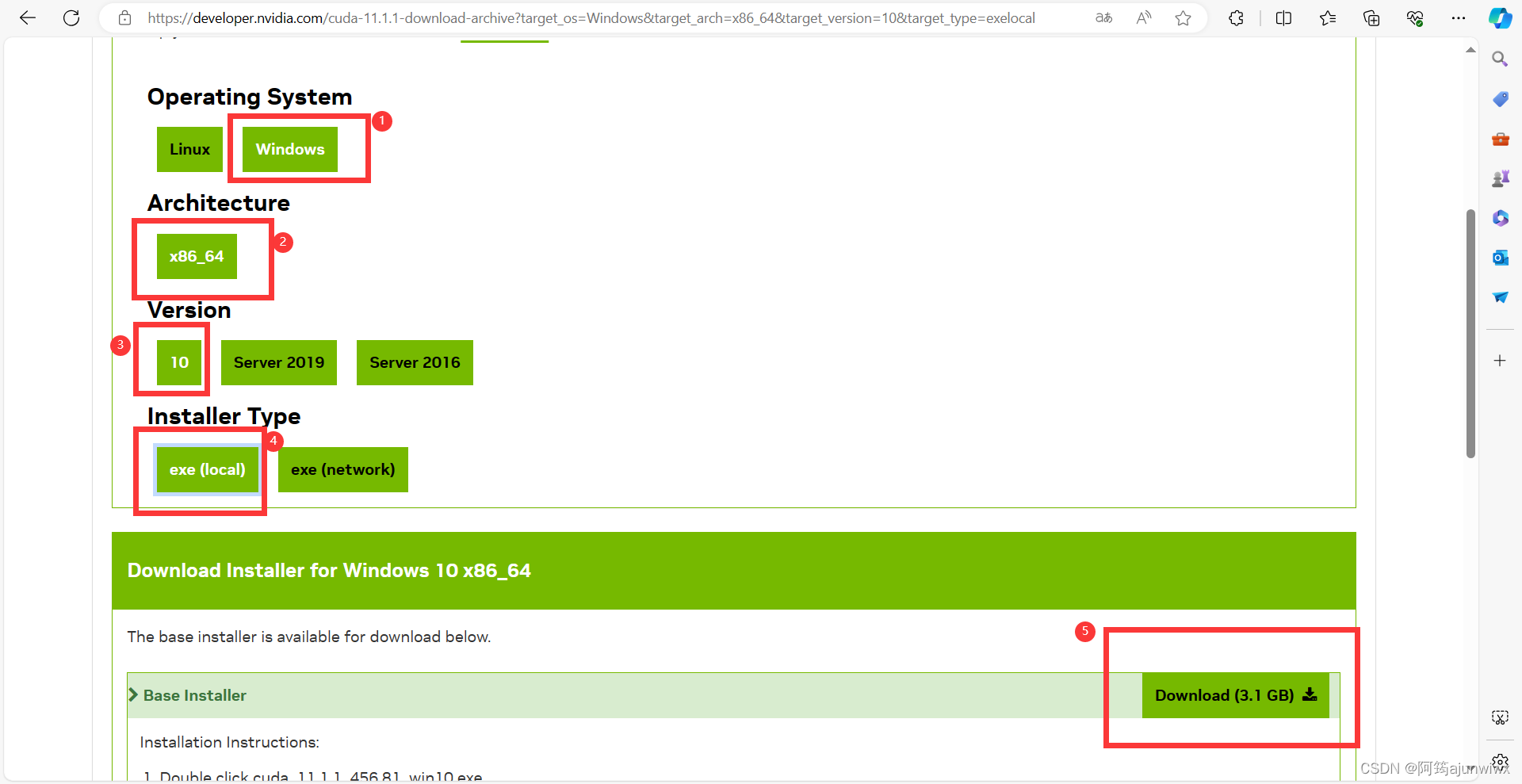

1.1 按照下面红色框框依次点击,最后点击下载;

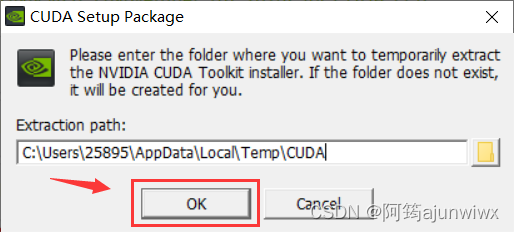

1.2 下载完后,双击运行,最好默认安装位置;

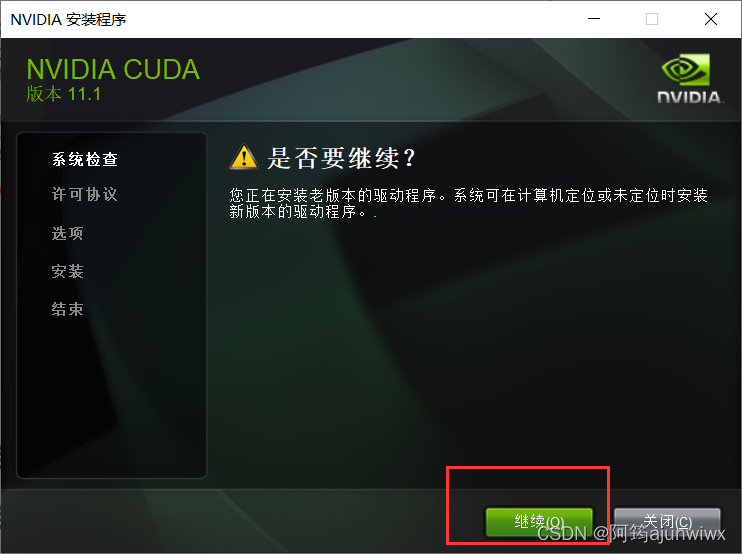

1.3 点击“继续”;

1.4 还是“同意”;

1.5 这一步选择“自定义”,再点击“下一步”;

1.6 取消勾选“visual studio integration”后,点击“下一步”;

1.7 点击“下一步”;

1.8 点击 “下一步”

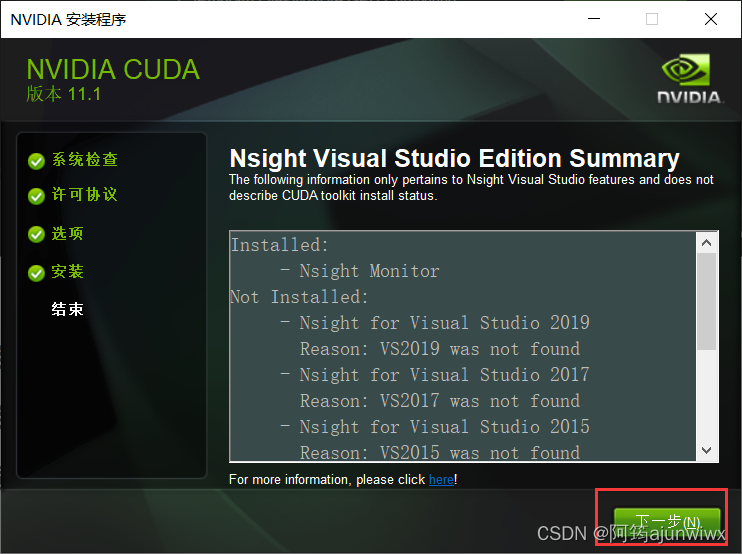

1.9 点击“关闭”, 就安装完成了!

六、安装cudnn

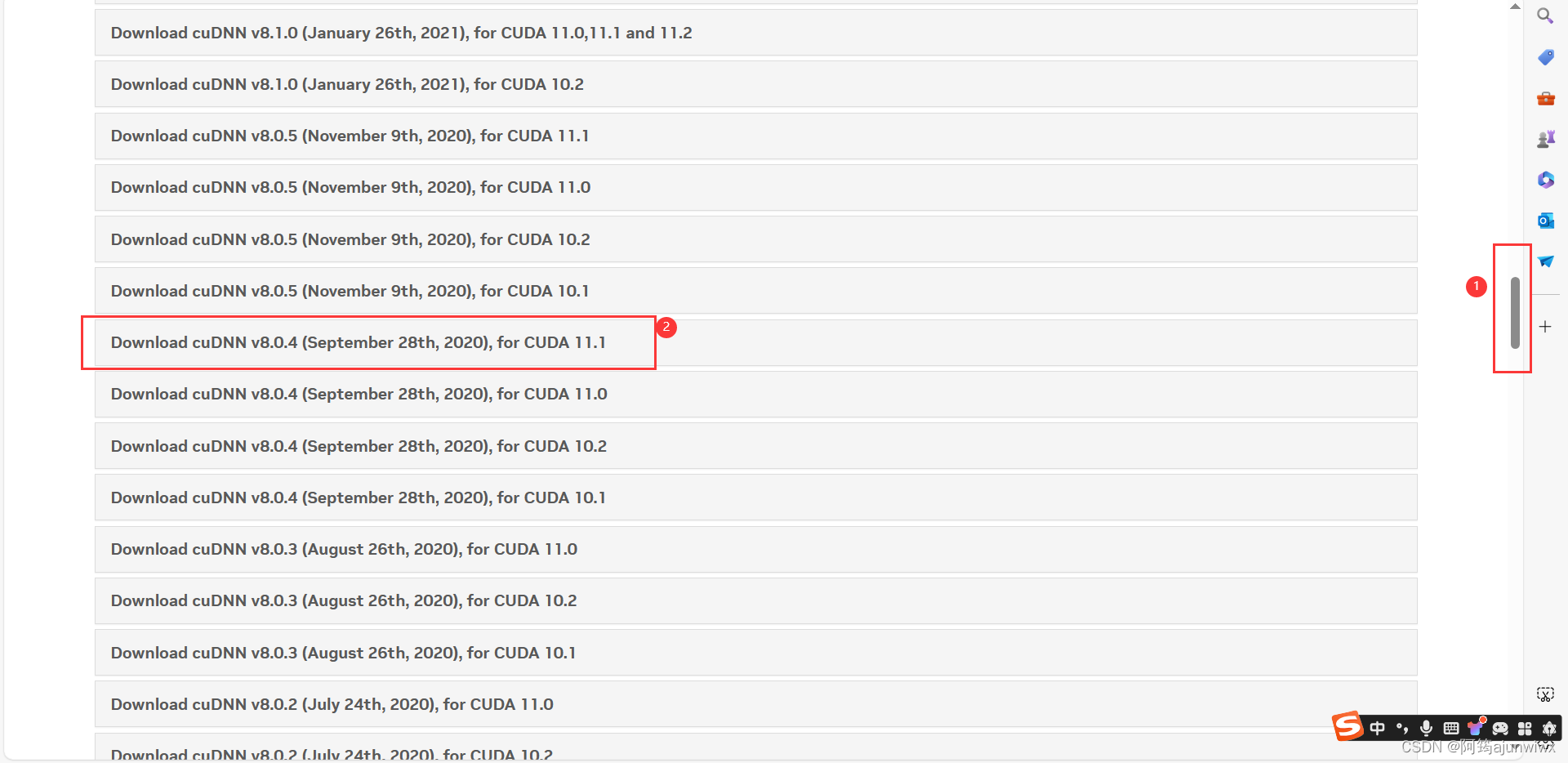

1. 从nvidia官网下载cudnn v8.0.4

这里我放百度网盘链接安装包,有需要的朋友自己取哦^_^

链接:https://pan.baidu.com/s/1bnbmgncp9ha659bt9thaxa?pwd=1234

提取码:1234

--来自百度网盘超级会员v5的分享

1.1 这里是官网地址:cudnn archive | nvidia developer

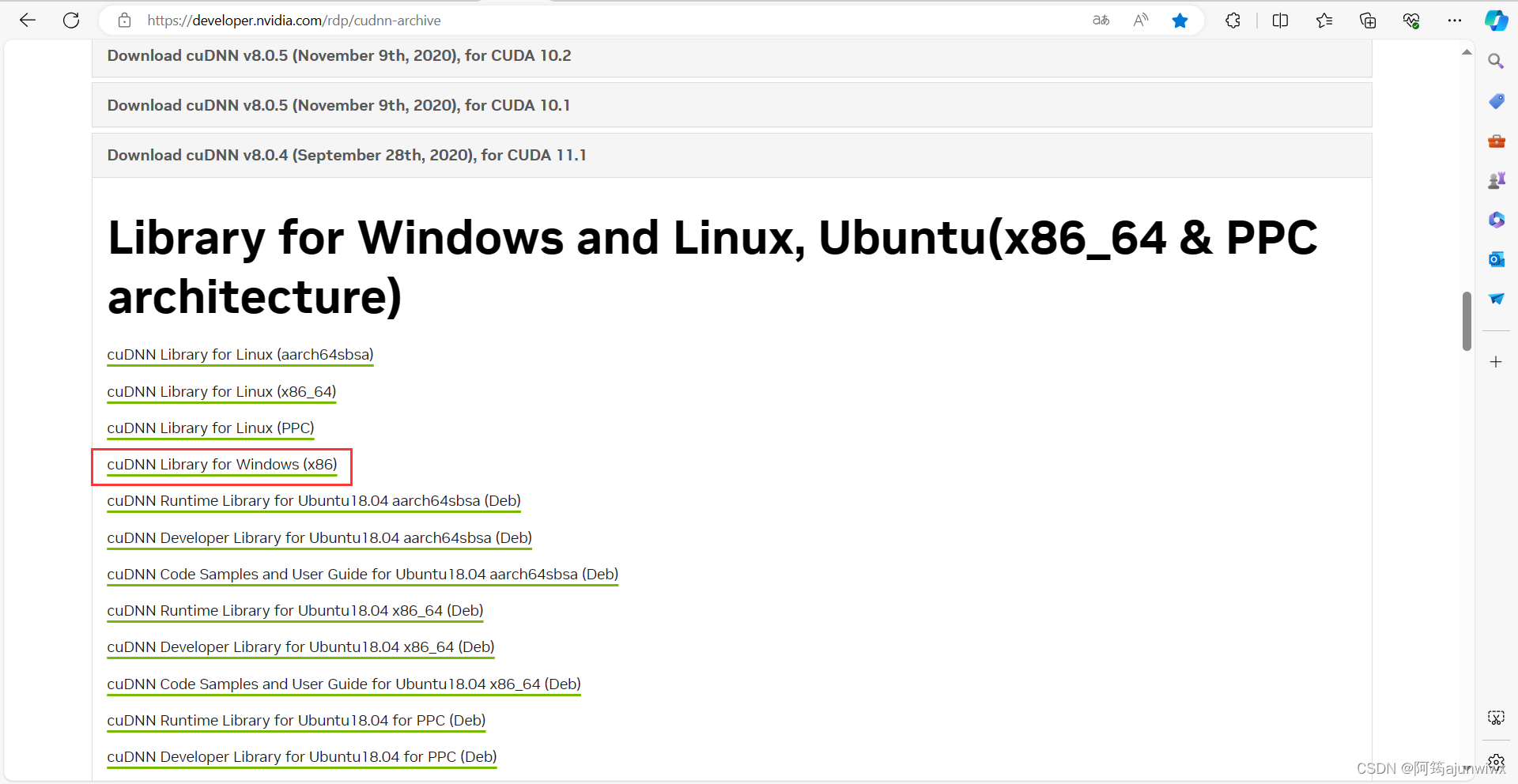

1.2 点击它下载是一个压缩包,如果第一次下载的朋友需要输入邮箱登录,登录即可,登录后还是下载不了,不要慌~,再重新进一下网站,再点击下载即可!

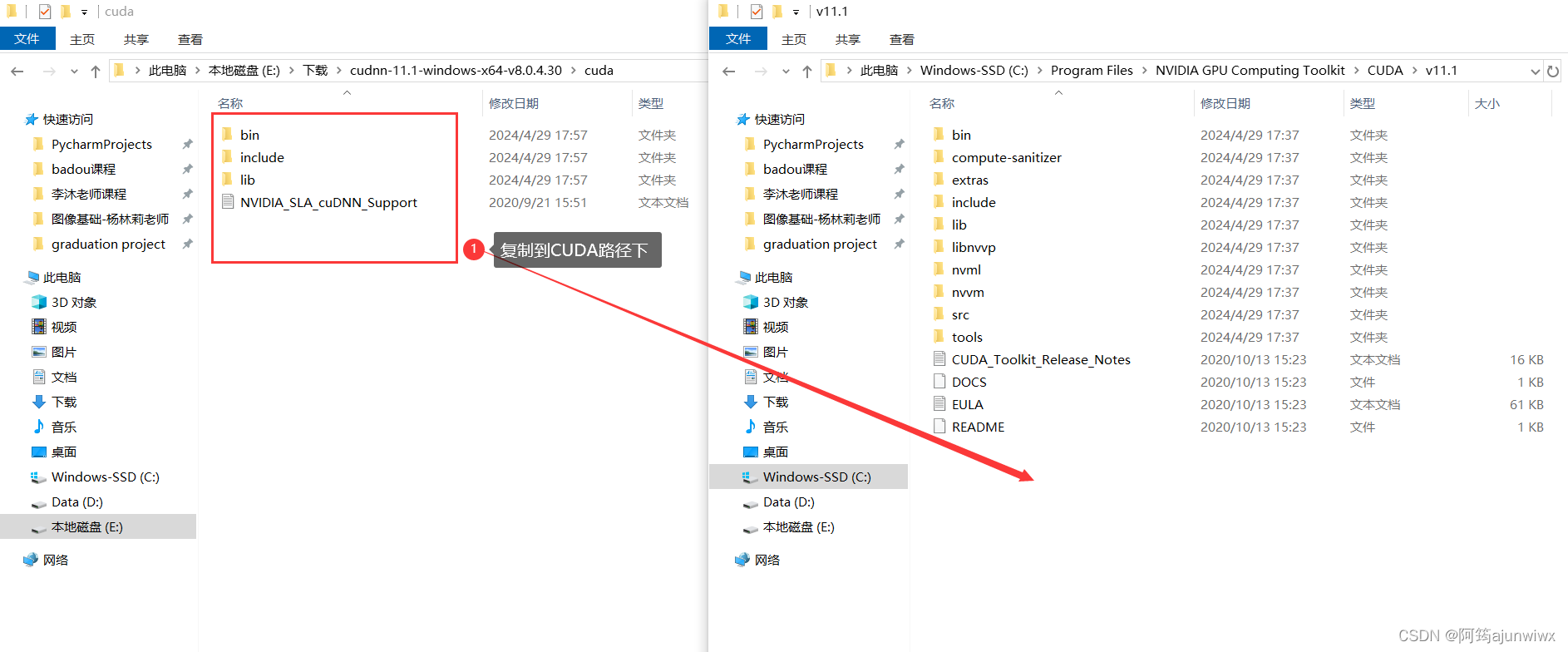

2. 第一步先解开压缩包,再替换cuda里的文件

2.1 c:\program files\nvidia gpu computing toolkit\cuda\v11.1,这是我的默认cuda安装位置路径。如果也是默认安装,那么我们的位置存放都差不多,可以按我的路径找一下文件夹。

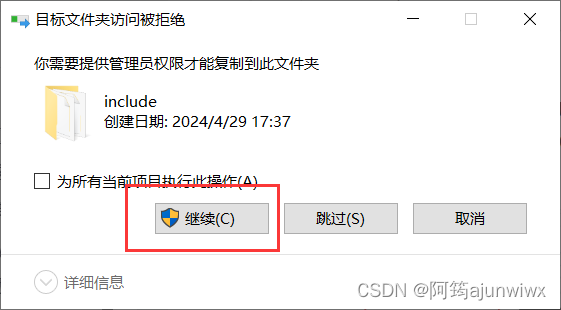

2.2 勾选下面的“为所有当前项目执行此操作”,再点击“继续”,即可;

3. 配置系统环境变量

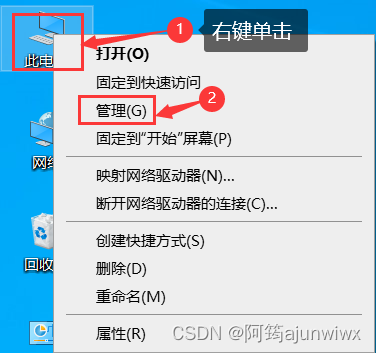

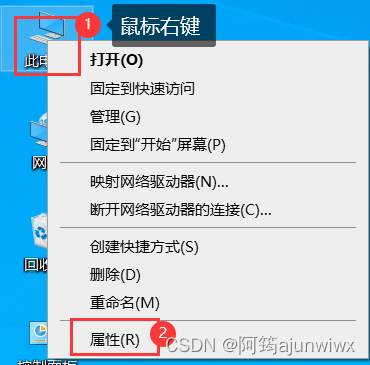

3.1 在桌面“此电脑”,鼠标右键,选择“属性”;

3.2 打开后,鼠标滚轮直接向下划到底,点击“高级系统设置”;

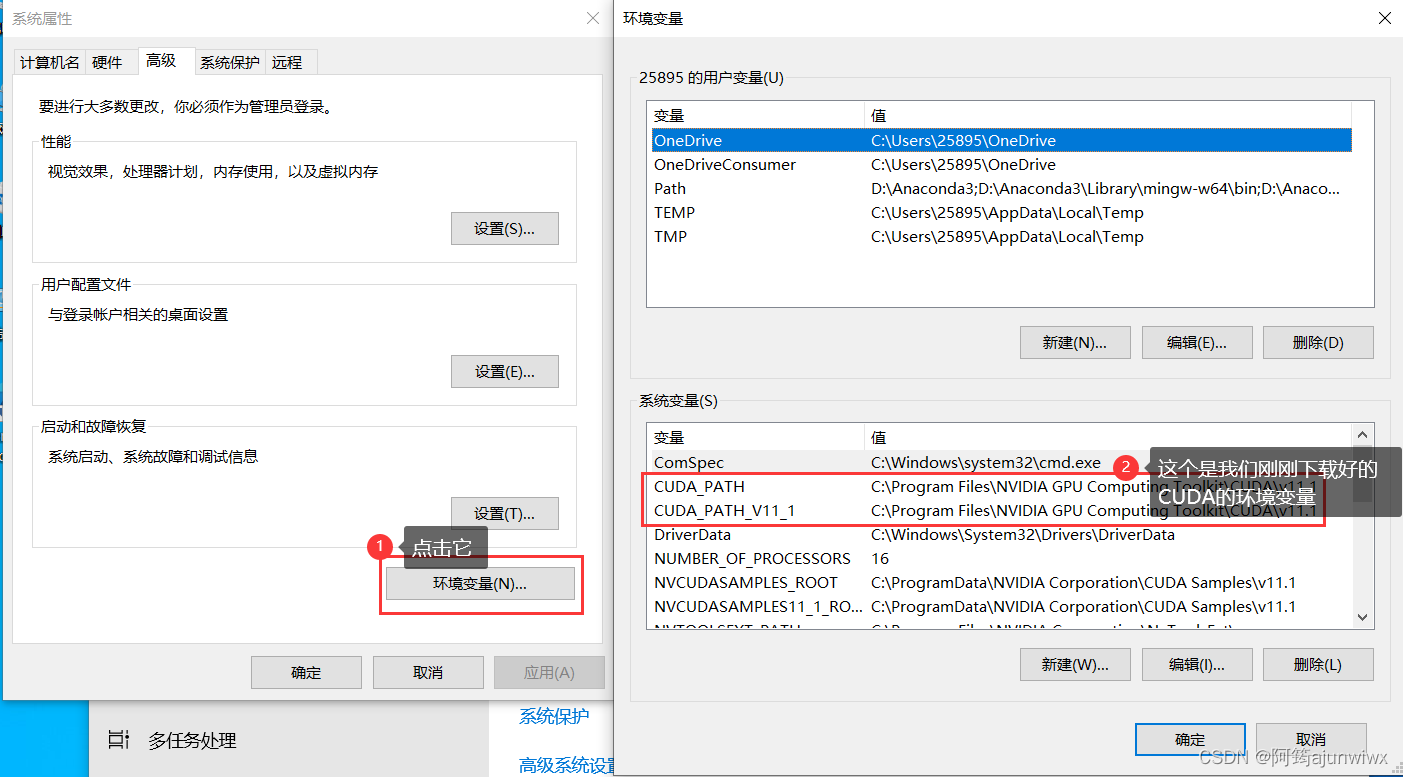

3.3 选择“环境变量”, 就可以在系统变量那里看到我们安装好的cuda了;

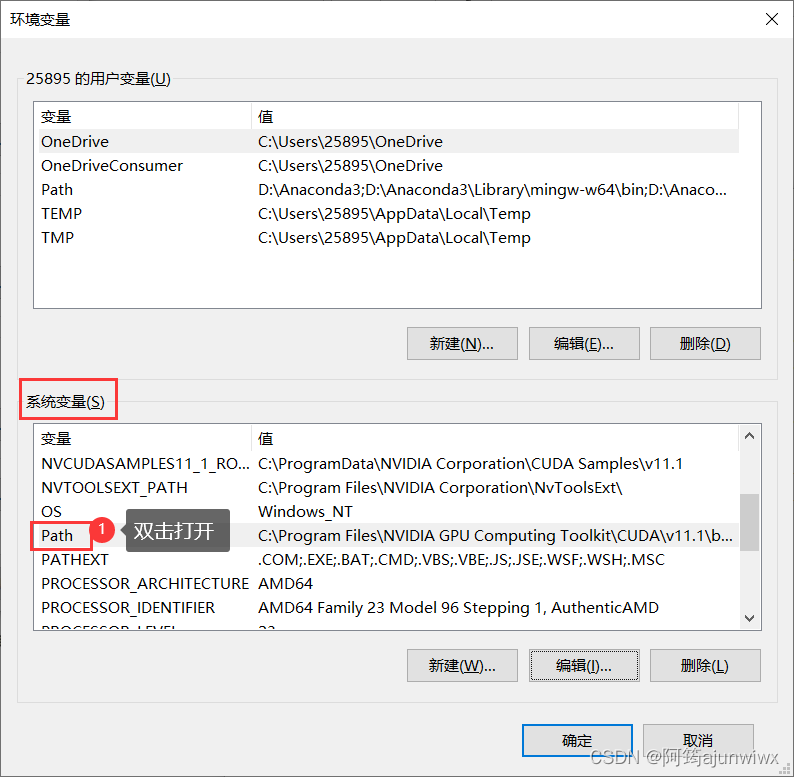

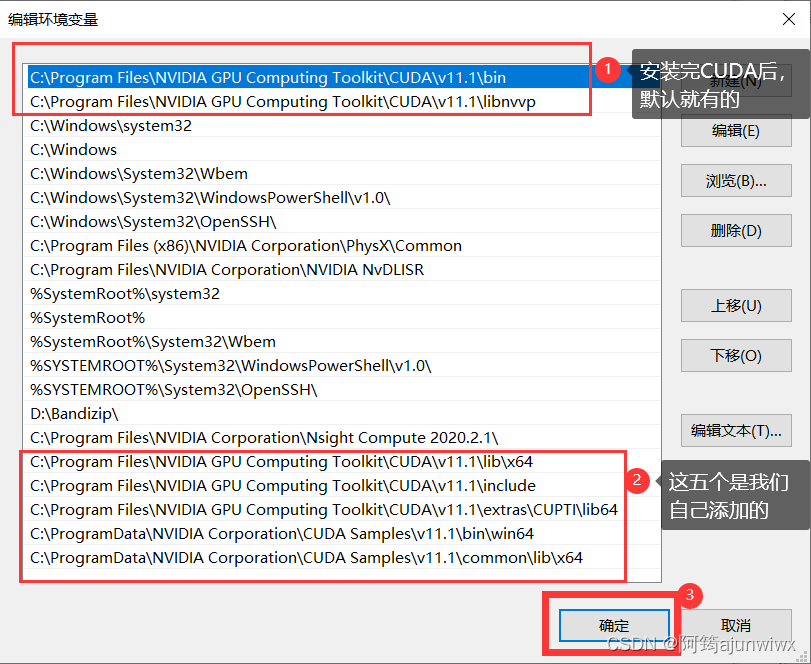

3.4 在系统环境变量下面鼠标下滑找到“path”,双击打开;

记住自己的cuda存放位置:c:\program files\nvidia gpu computing toolkit\cuda\v11.1

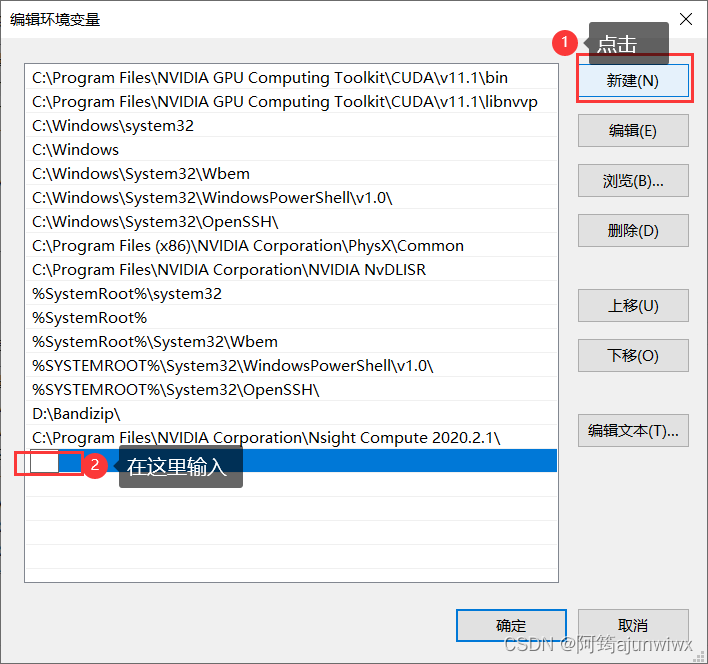

3.5 点击“新建”,添加环境变量,依次新建五次,添加五次;

c:\program files\nvidia gpu computing toolkit\cuda\v11.1\lib\x64

c:\program files\nvidia gpu computing toolkit\cuda\v11.1\include

c:\program files\nvidia gpu computing toolkit\cuda\v11.1\extras\cupti\lib64

c:\programdata\nvidia corporation\cuda samples\v11.1\bin\win64

c:\programdata\nvidia corporation\cuda samples\v11.1\common\lib\x64

3.6 下图是添加完后的样子,点击“确定”;

如果出现【path环境变量“此环境变量太大, 此对话框允许将值设置为最长2047个字符”问题】那么也可以解决,直接在注册表修改,不会的可以参考一下我推荐的

链接:此环境变量太大, 此对话框允许将值设置为最长2047个字符(一招帮你解决,亲测有效)-阿里云开发者社区 (aliyun.com)

4. 重启电脑,使环境变量配置生效!

5. 验证是否安装成功cuda和cudnn

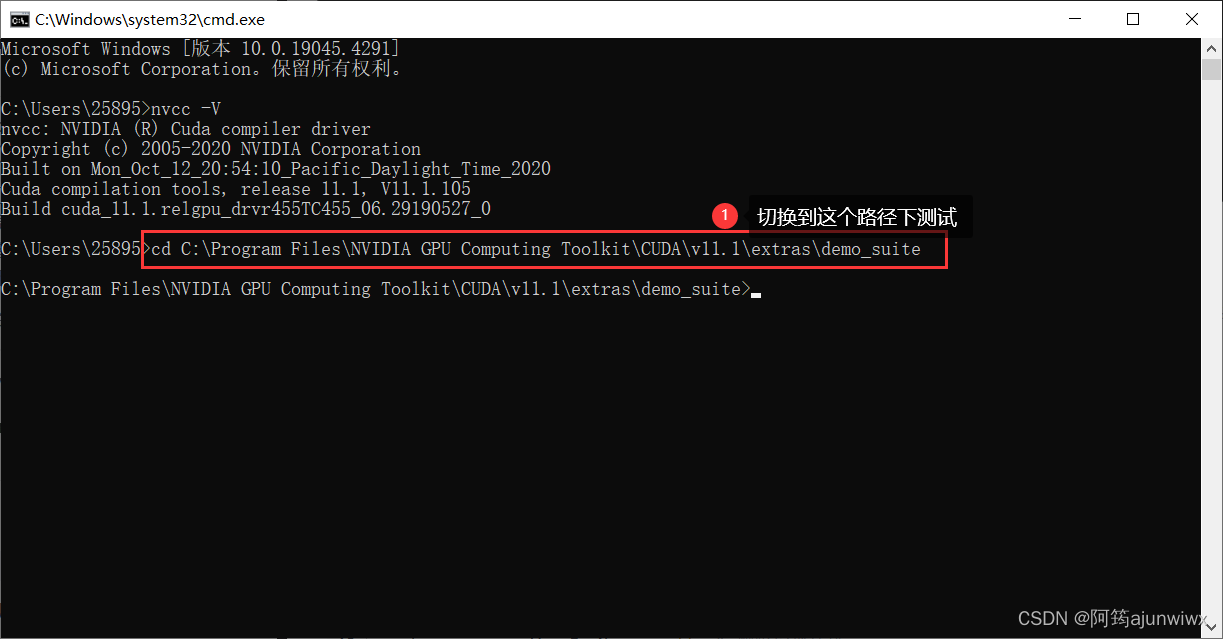

5.1 使用系统快捷键windows+r,输入cmd,输入切换路径:cd c:\program files\nvidia gpu computing toolkit\cuda\v11.1\extras\demo_suite

# 切换路径

cd c:\program files\nvidia gpu computing toolkit\cuda\v11.1\extras\demo_suite

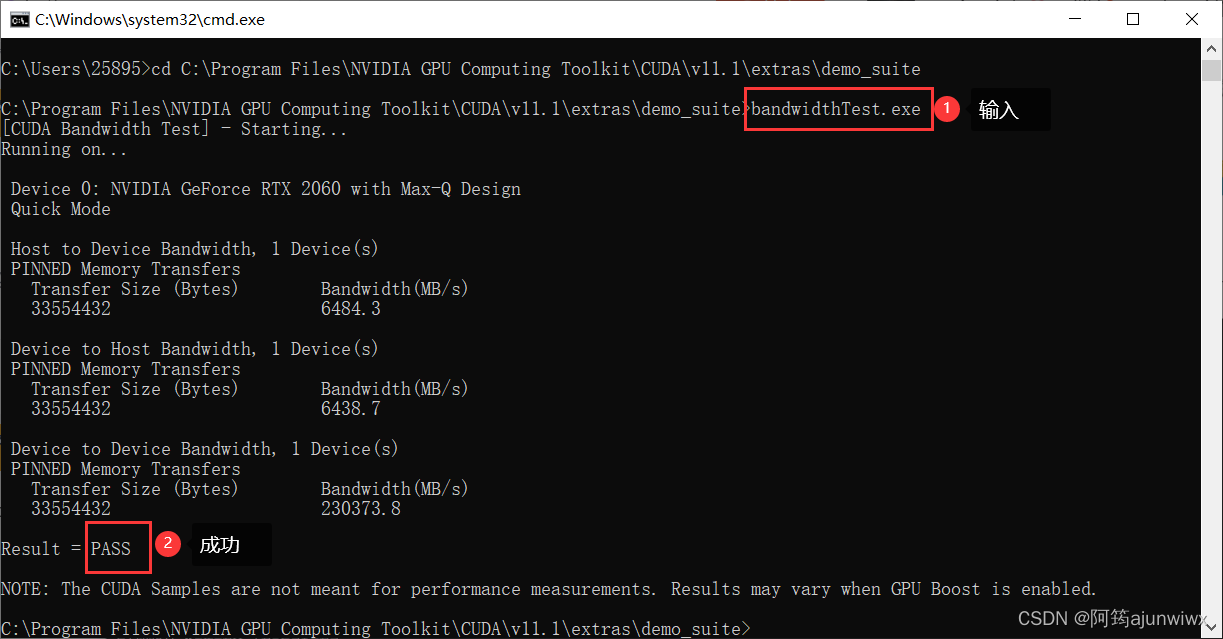

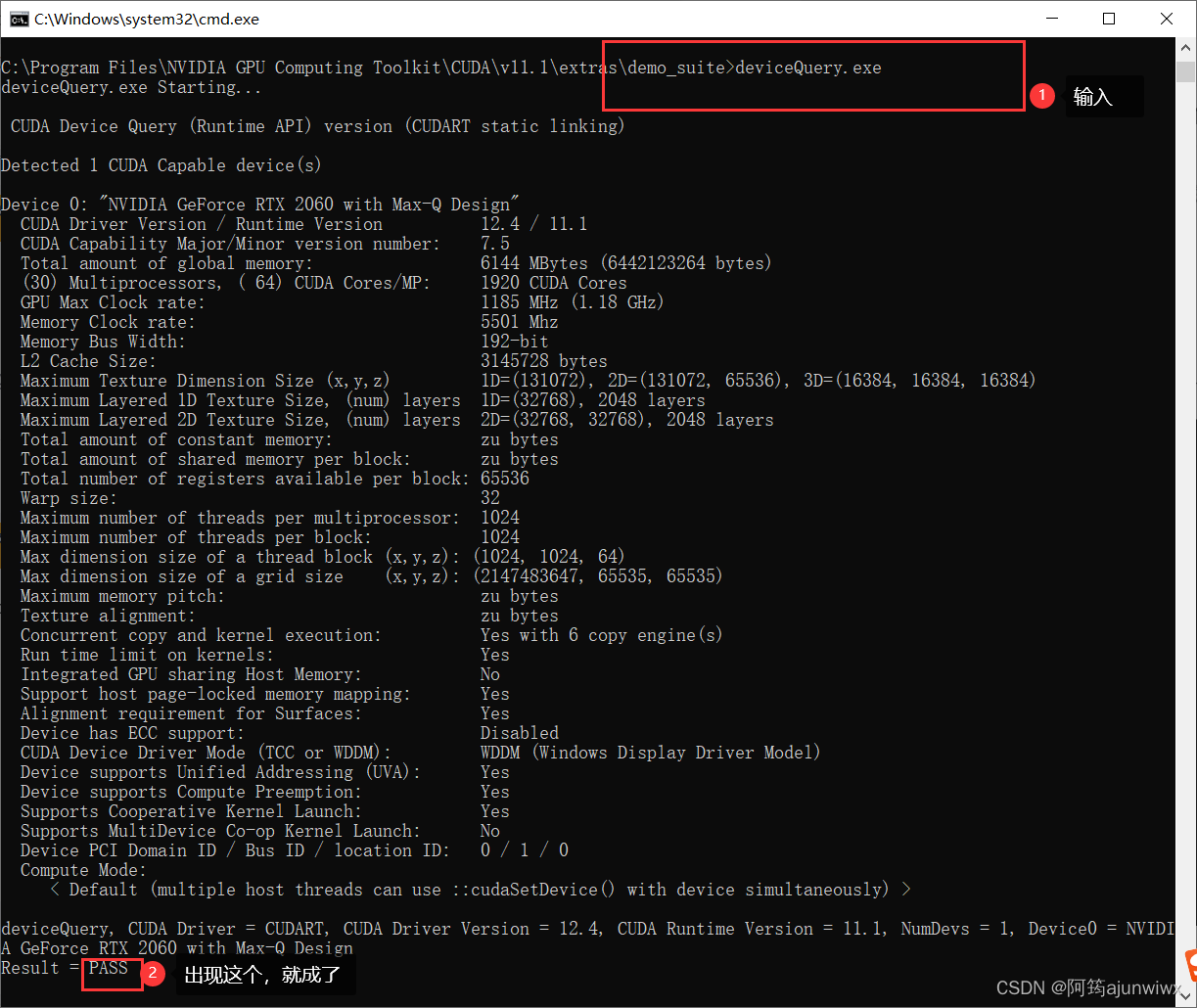

# 依次输入

bandwidthtest.exe

devicequery.exe5.2 再依次输入bandwidthtest.exe、devicequery.exe,每次都出现‘pass’则成功。

七、安装pytorch(gpu版本)

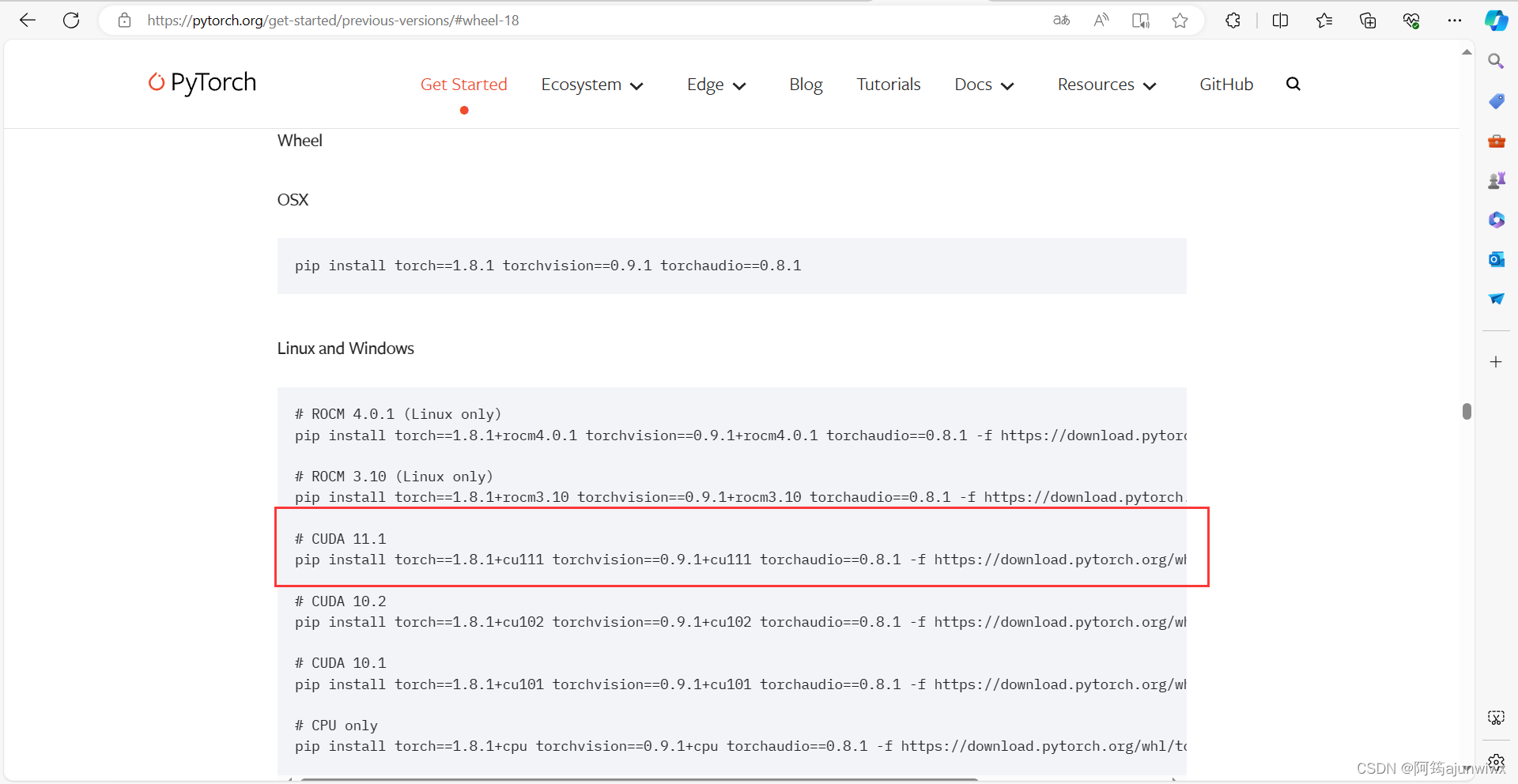

1. 官网查询

找到对应自己需要的版本

网址:previous pytorch versions | pytorch

2. 由于项目需要,我安装的是torch 1.8版本

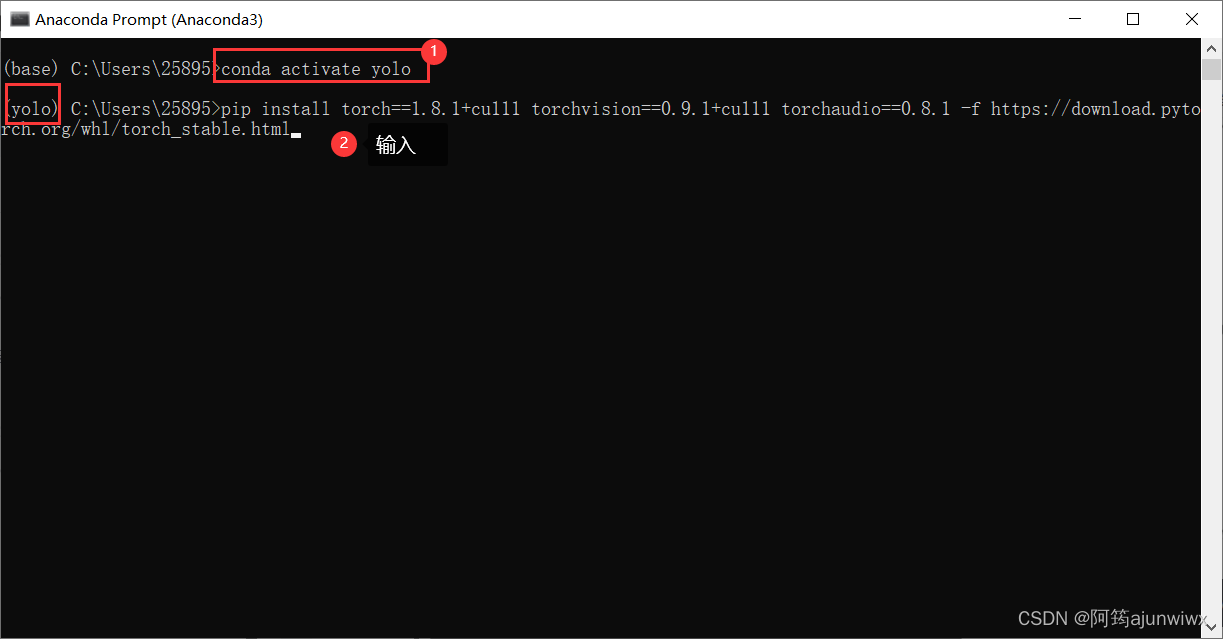

pip install torch==1.8.1+cu111 torchvision==0.9.1+cu111 torchaudio==0.8.1 -f https://download.pytorch.org/whl/torch_stable.html2.1 打开“anaconda prompt (anaconda3)”,首先切换上面我们创建好的环境,在输入我们上面查询的;

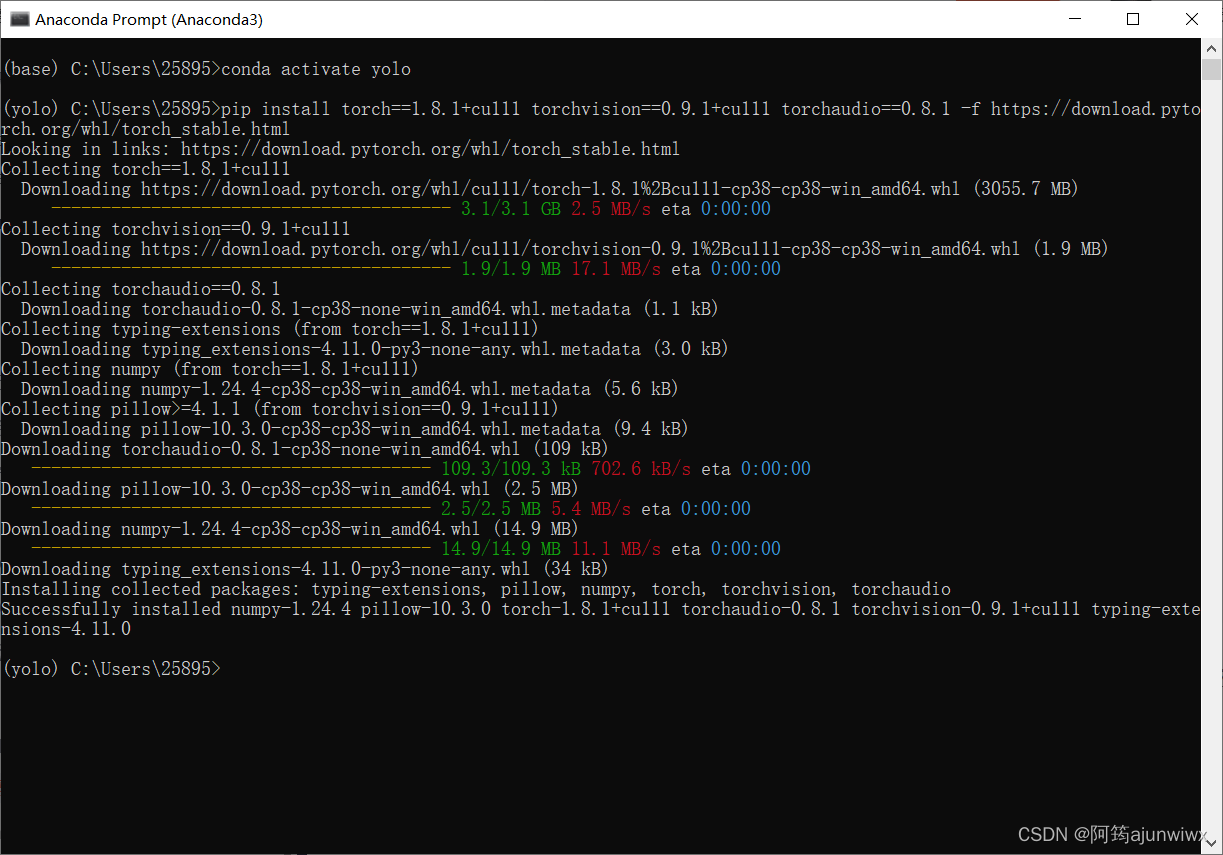

2.2 这是安装好之后的模样~

八、在 pycharm验证配置是否成功

我比较喜欢跑代码验证,所以可以直接在pycharm里面验证(提示:上面有我安装pycharm的教程)

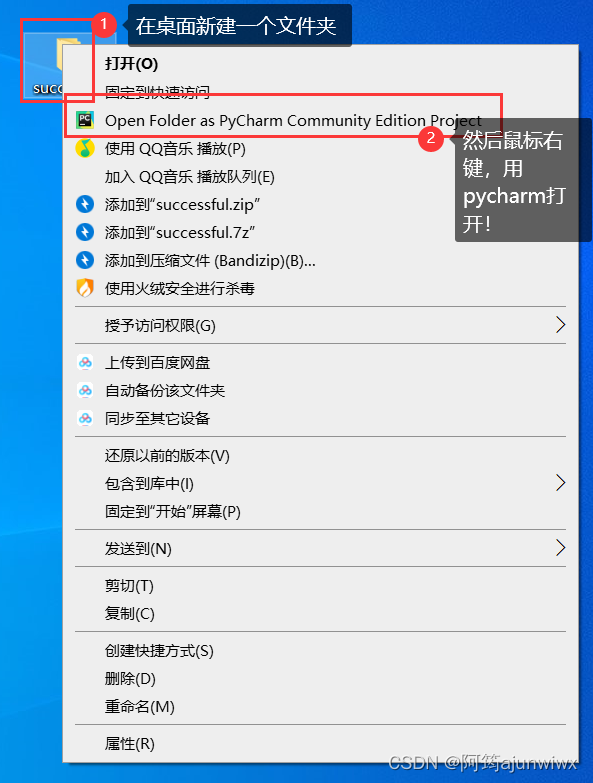

1. 新建文件夹,鼠标右键用“pycharm”打开

或者直接在pycharm新建项目都可以;

2. 打开后,首先在pycharm里配置我们的深度学习环境

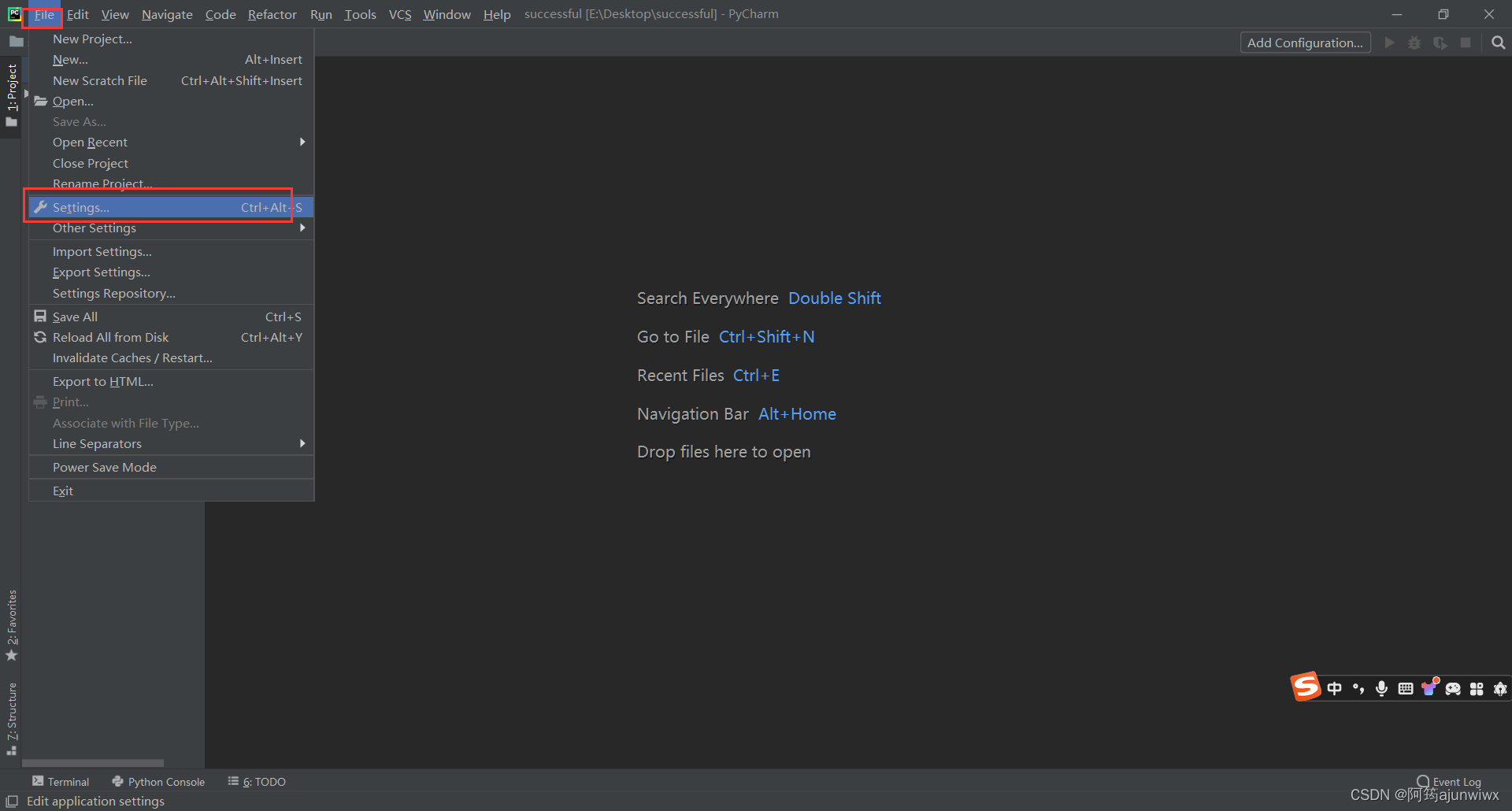

2.1 “setting”

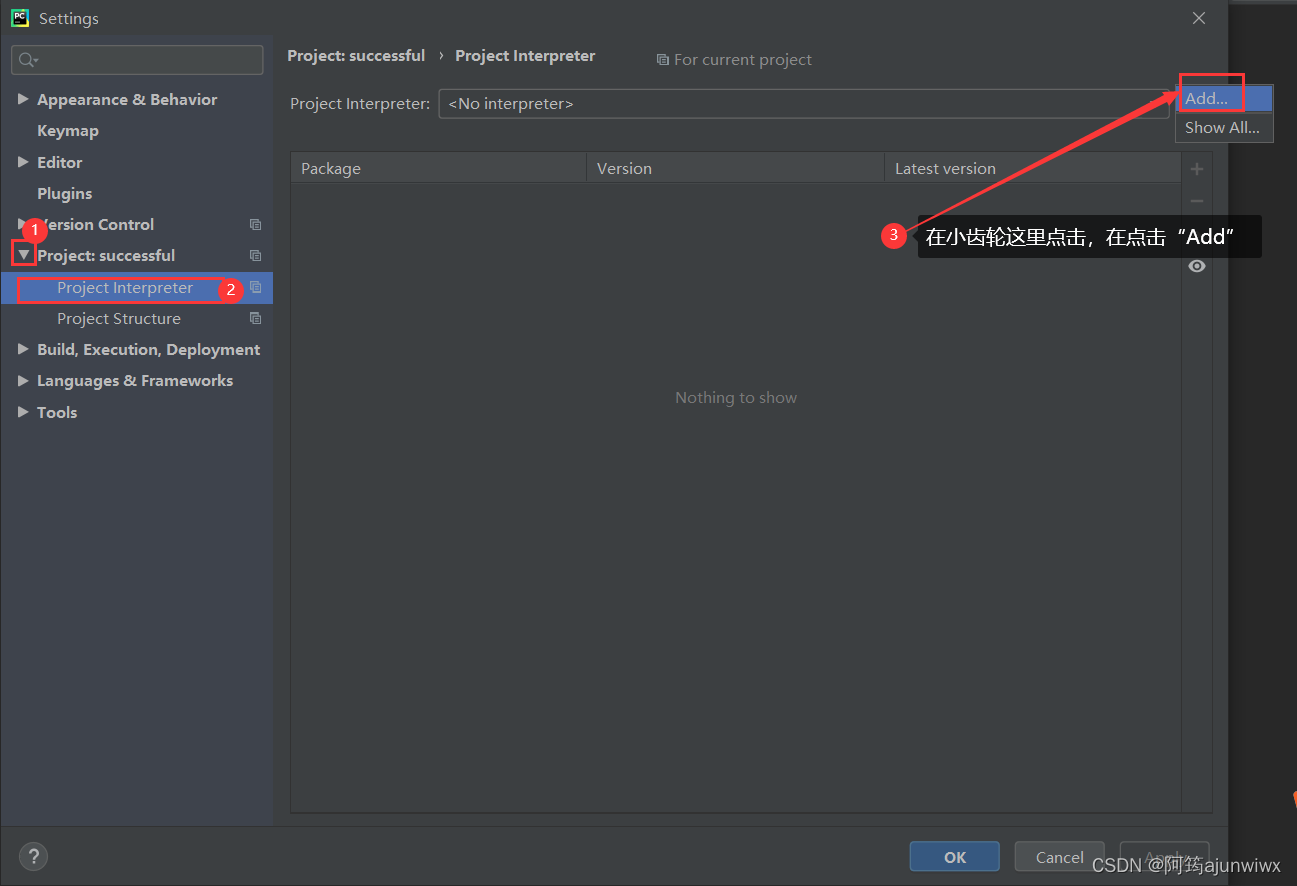

2.2 按照下面的步骤,在第三步那里点击小齿轮就出现“add”啦 ^_^

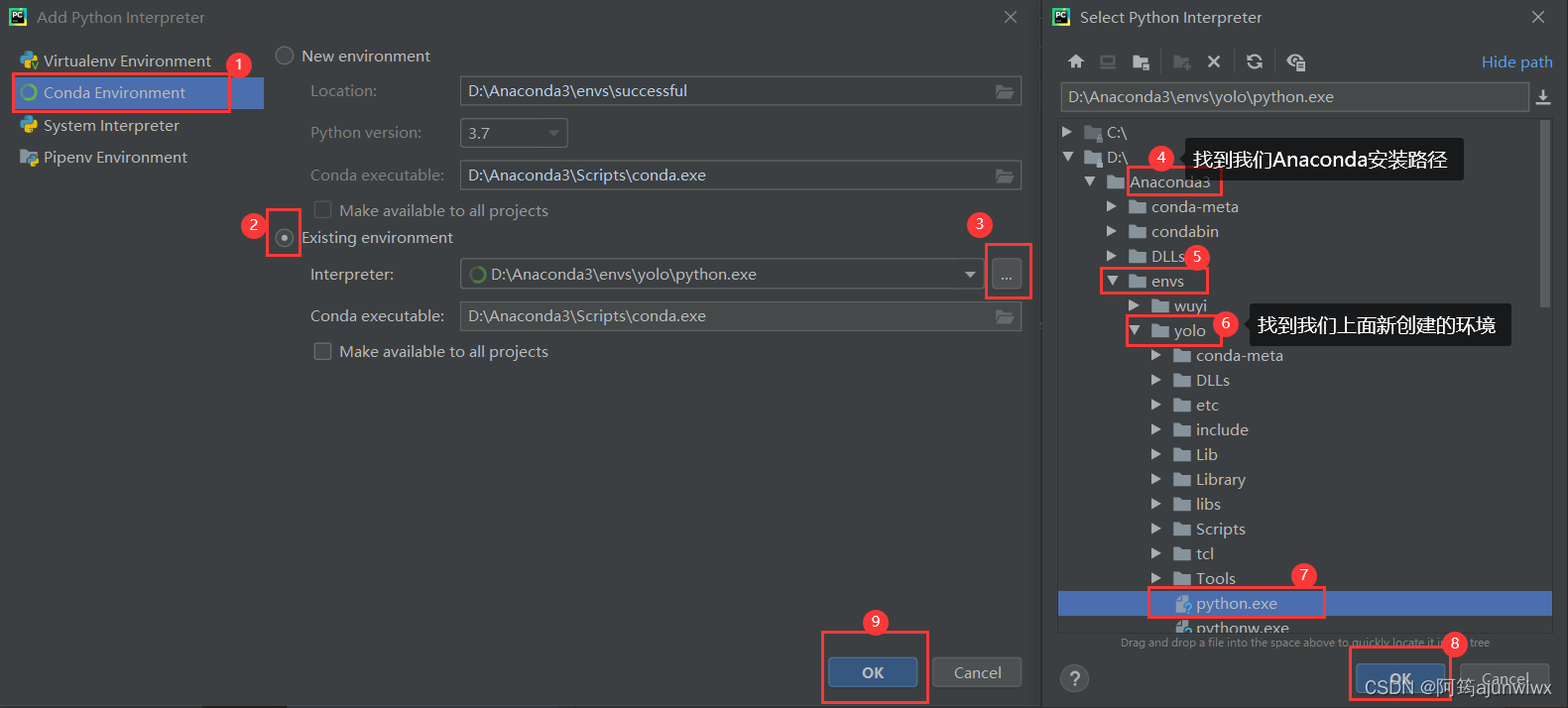

2.3 紧跟下面步骤走哦;

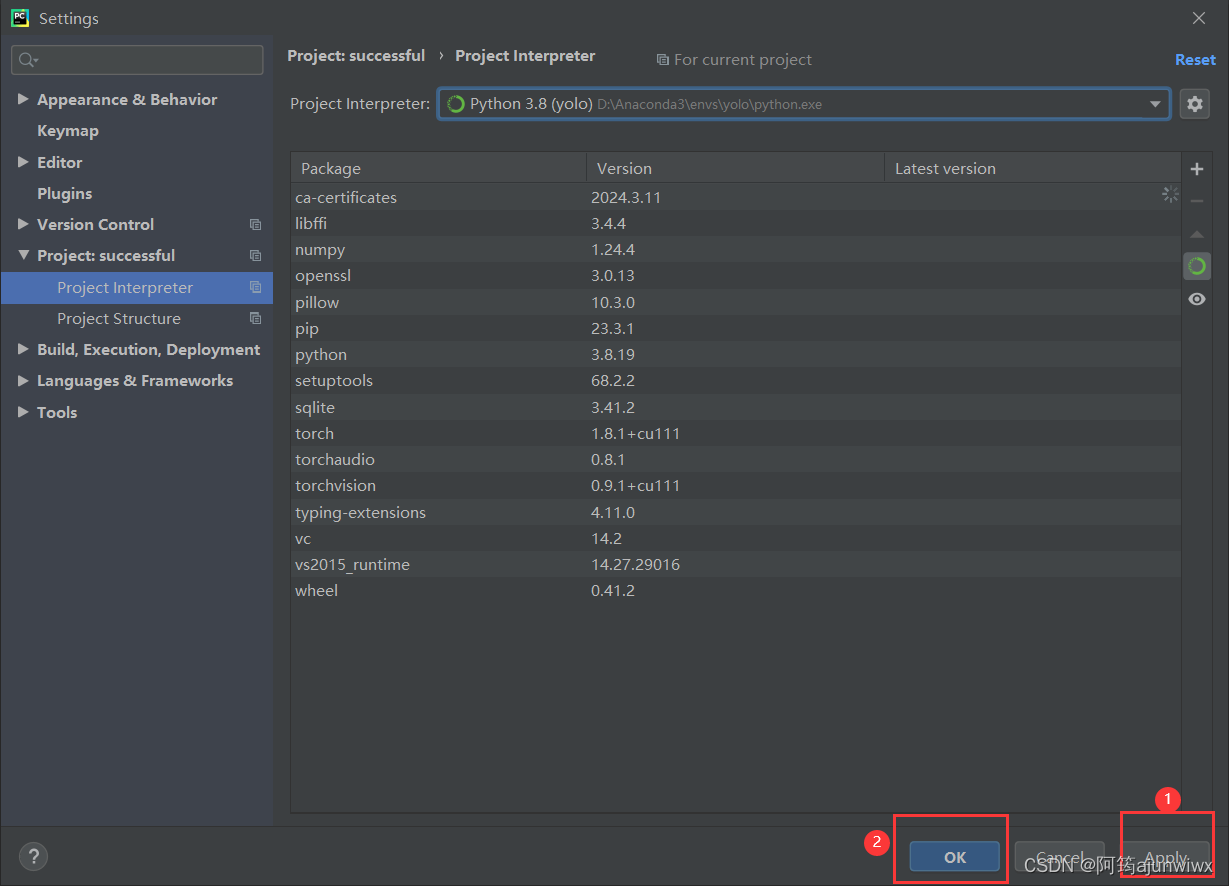

2.4 先点击“apply” ,再“确定”,这样我们就配置后我们需要的环境啦

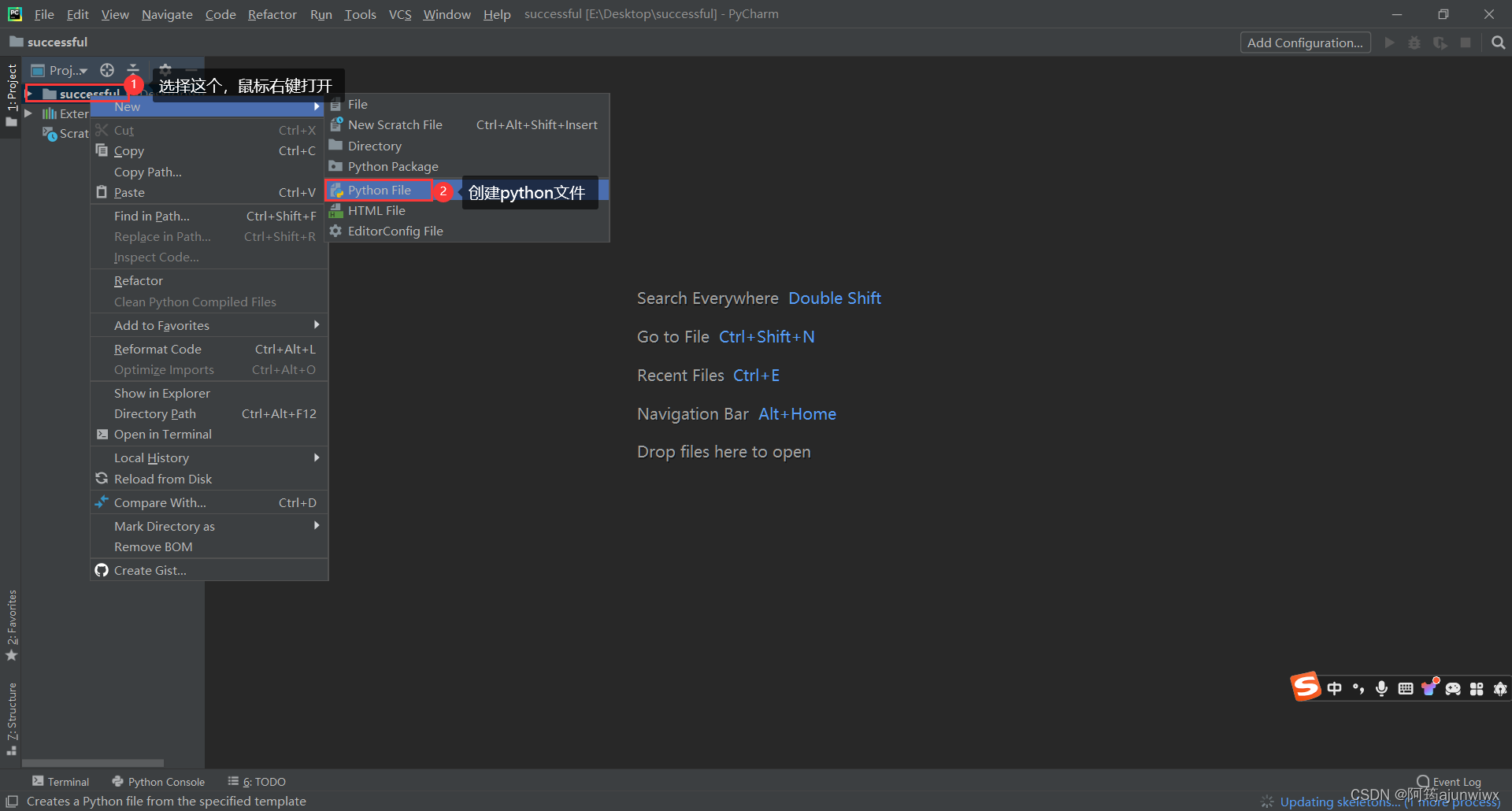

2.5 创建一个python文件;

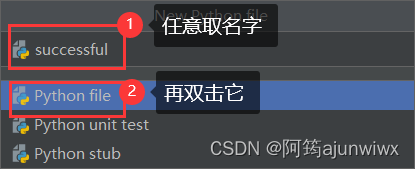

2.6 任意取名~

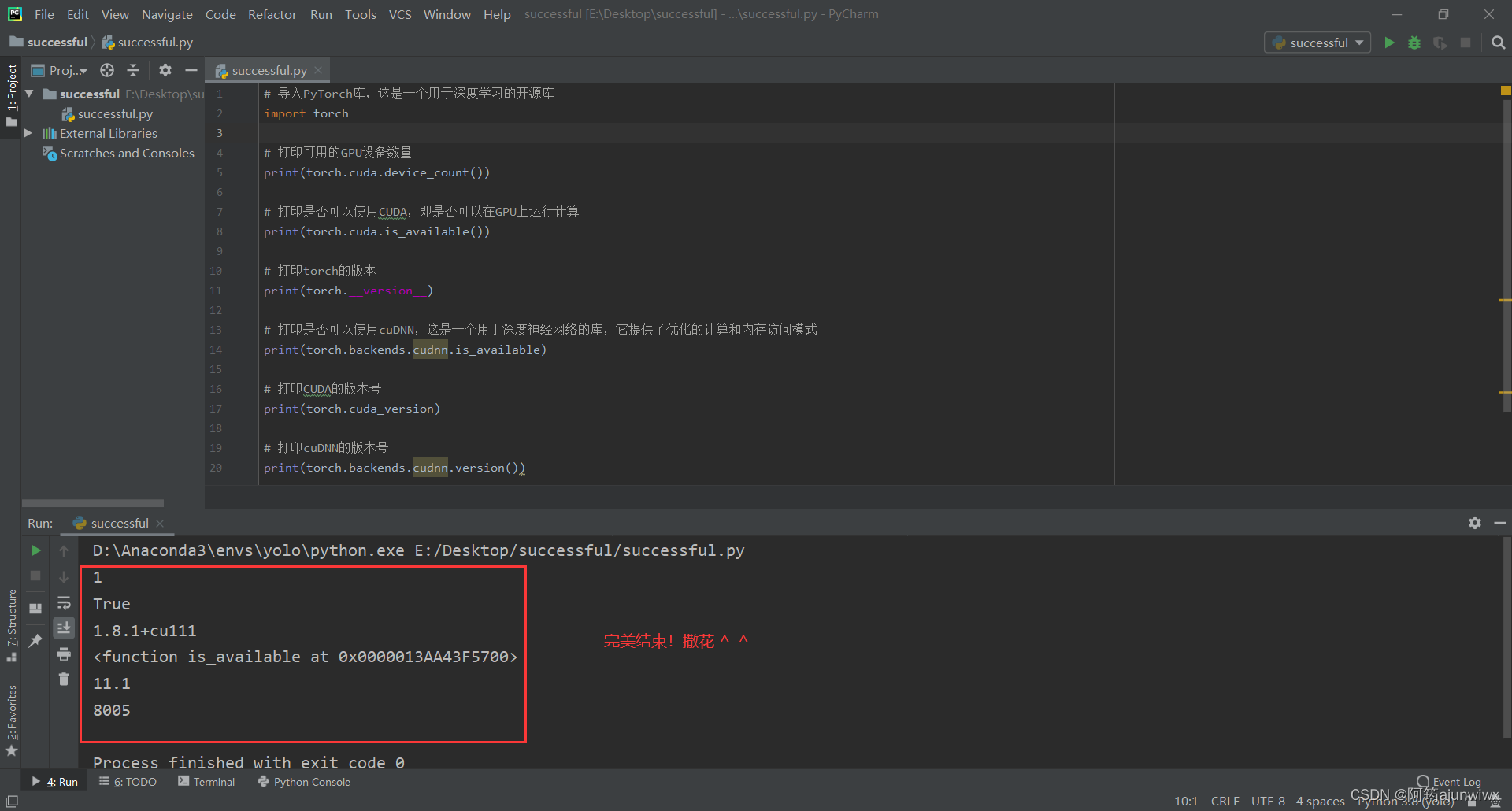

3. 输入代码

# 导入pytorch库

import torch

# 打印可用的gpu设备数量

print(torch.cuda.device_count())

# 打印是否可以使用cuda,即是否可以在gpu上运行计算

print(torch.cuda.is_available())

# 打印torch的版本

print(torch.__version__)

# 打印是否可以使用cudnn,这是一个用于深度神经网络的库,它提供了优化的计算和内存访问模式

print(torch.backends.cudnn.is_available)

# 打印cuda的版本号

print(torch.cuda_version)

# 打印cudnn的版本号

print(torch.backends.cudnn.version())

4. 成功界面 ^_^

九、下载github项目-yolov5项目克隆

1. 内容太多了,放到另外的csdn里啦 ^_^

链接:部署yolov5项目的工作空间----以及如何下载github项目-csdn博客

发表评论