前言:

ollama工具的出现让大语言模型的部署变得格外的轻松,但是在windows系统部署之后发现无法使用gpu进行加速,通过多方面查找资料发现可以在docker中使用命令启用gpu加速。另外通过docker也可以快速部署open webui,于是本文基于docker实现ollama模型的部署,以及webui部署。

最终部署成功后可以实现公网访问本地大语言模型功能。

目录:

安装docker

在docker中安装ollama

在docker中安装webui

内网穿透实现公网访问本地大语言模型

环境:

系统:windows10

cpu:i5-9400

gpu:gtx1050ti

内容

安装docker

第一步:启动hyper-v

如果之前没有安装过docker,需要先进行设置一下。

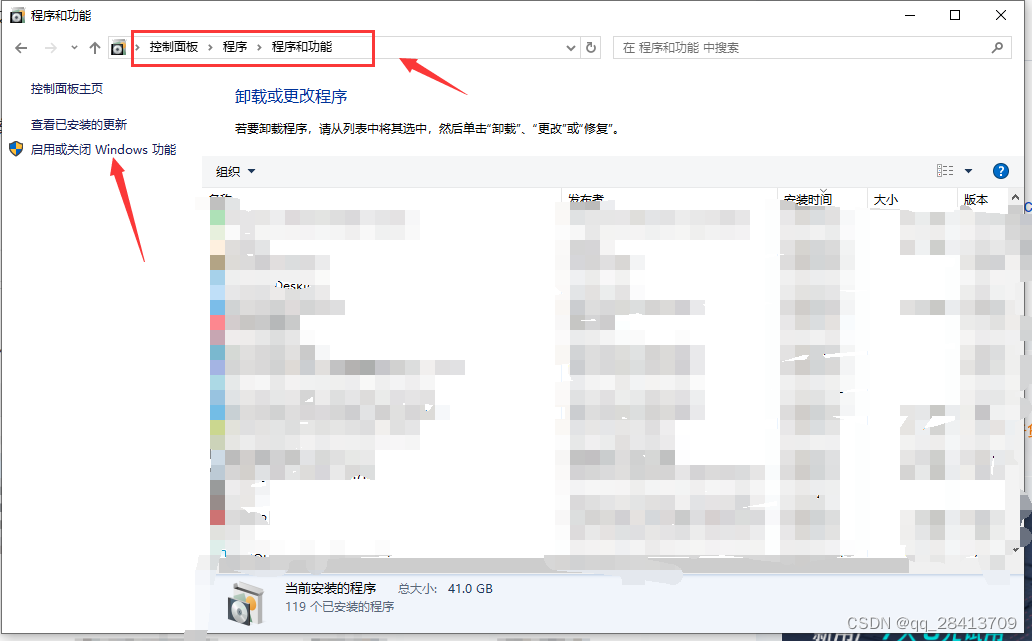

依次打开 控制面板>程序>程序和功能>启用或关闭windows功能

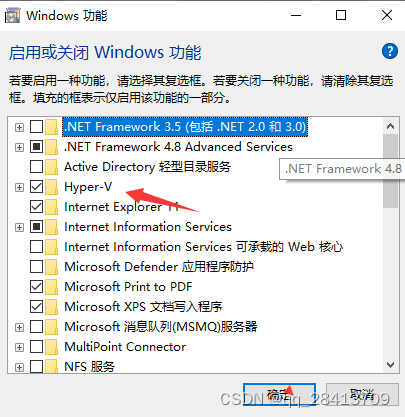

勾选hyper-v、虚拟机平台、linux子系统并点击确认

确认后重启计算机

第二步:安装wsl

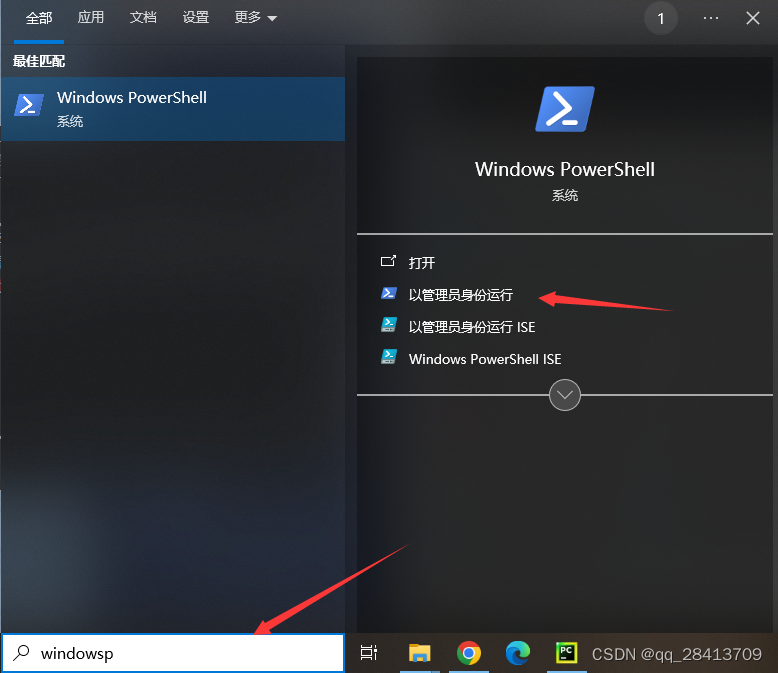

打开 powershell,以管理员的身份启动命令窗口

输入

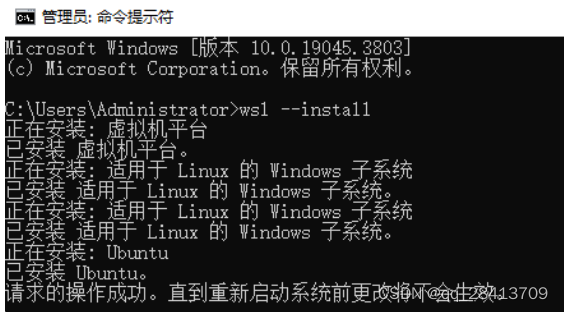

wsl --update安装

wsl --install

安装成功后重启电脑

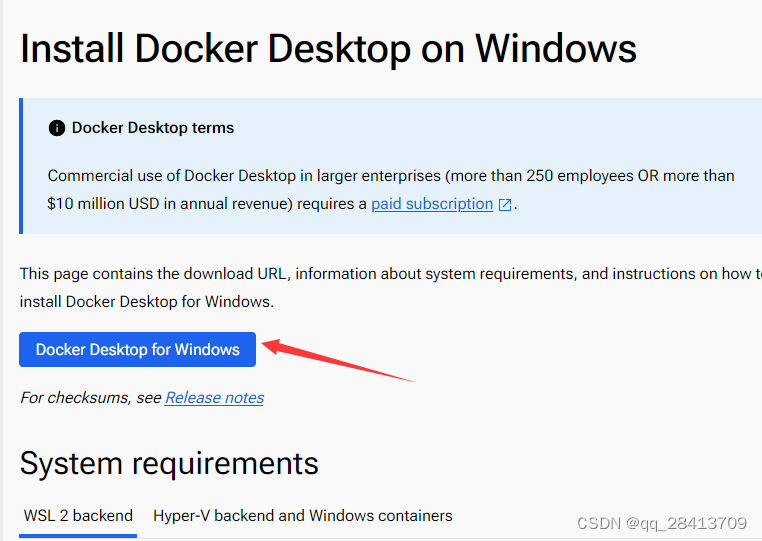

第三步:访问docker官网进行下载

点击下载链接:https://docs.docker.com/desktop/install/windows-install/

下载完成后,双击安装程序进行安装,如果是第一次安装,安装后会提示重启电脑,重启后点击桌面的docker desktop图标:选择先不注册直接登录即可。

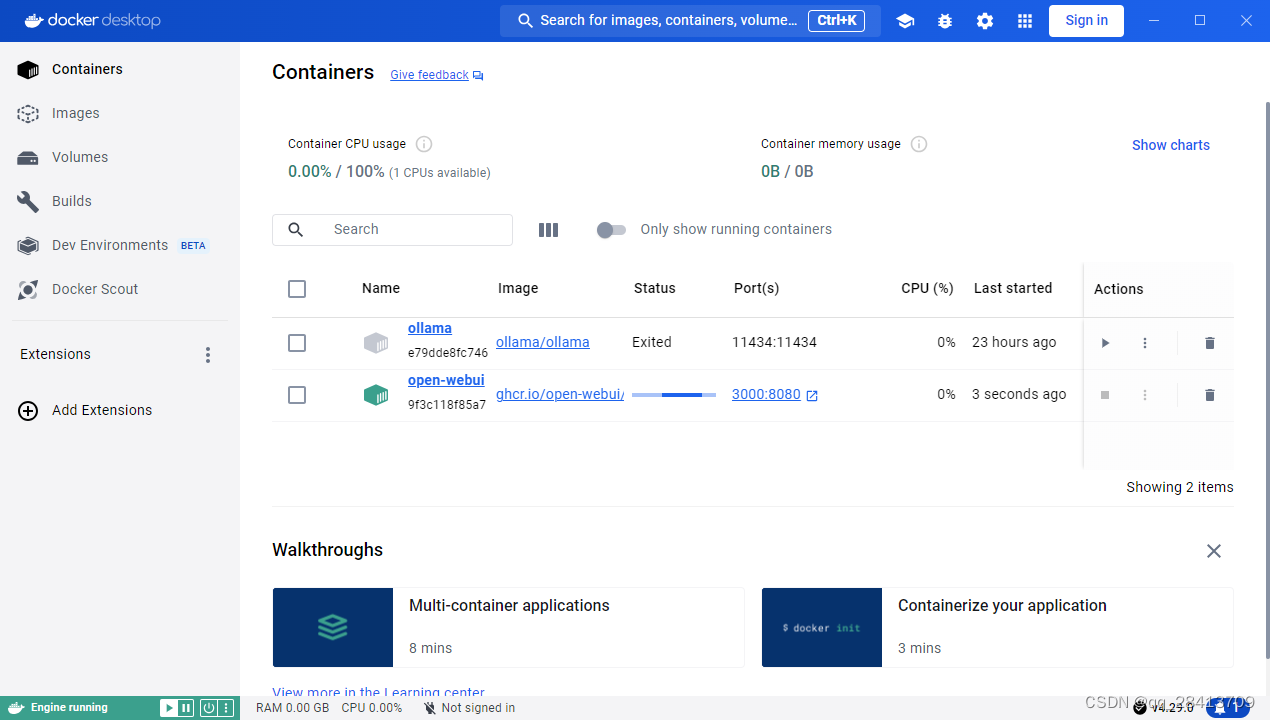

打开docker desktop后,左下角显示是绿色的running就代表我们成功了:

在docker中使用gpu运行ollama

第一步:安装英伟达容器安装包

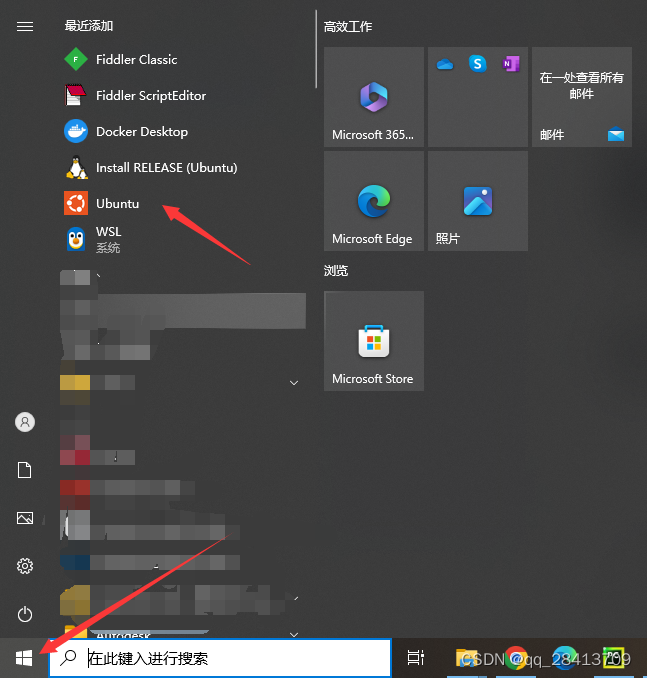

打开之前安装的ubuntu

依次将一下命令输入ubuntu

配置apt源

curl -fssl https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \

&& curl -s -l https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list更新源

sudo apt-get update安装工具包

sudo apt-get install -y nvidia-container-toolkit第二步:使用gpu运行ollama

docker run --gpus all -d -v /opt/ai/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama第三步:使用ollama下载模型

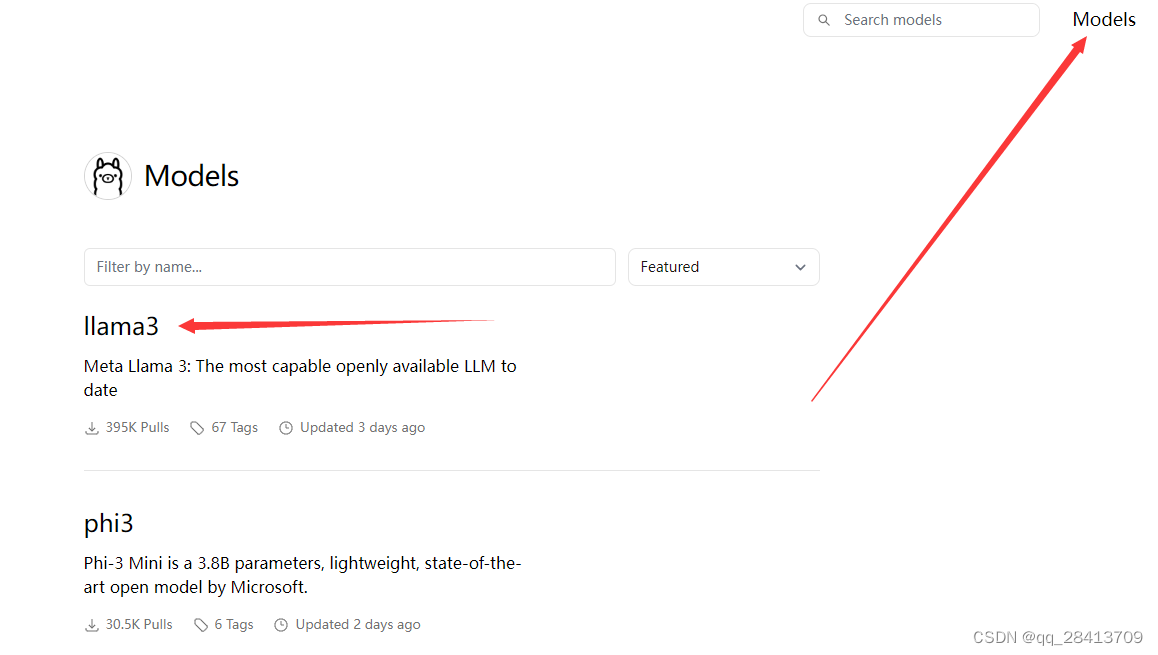

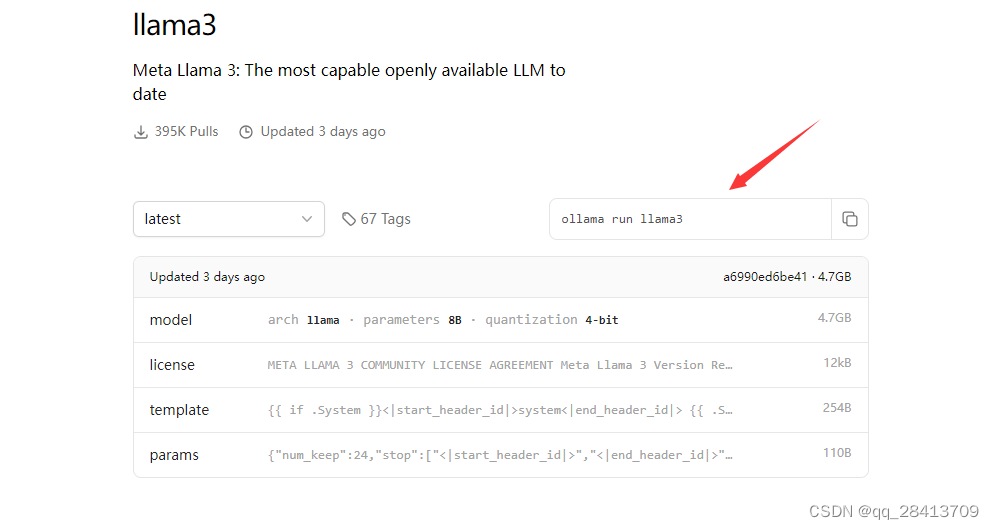

docker exec -it ollama ollama run qwen:7b如果想要下载其他的模型,点击连接:library,选择并于同的模型

选择不同的模型复制下载命令

docker exec -it ollama ollama run llama3在docker中安装webui

github开源地址:

https://github.com/open-webui/open-webui

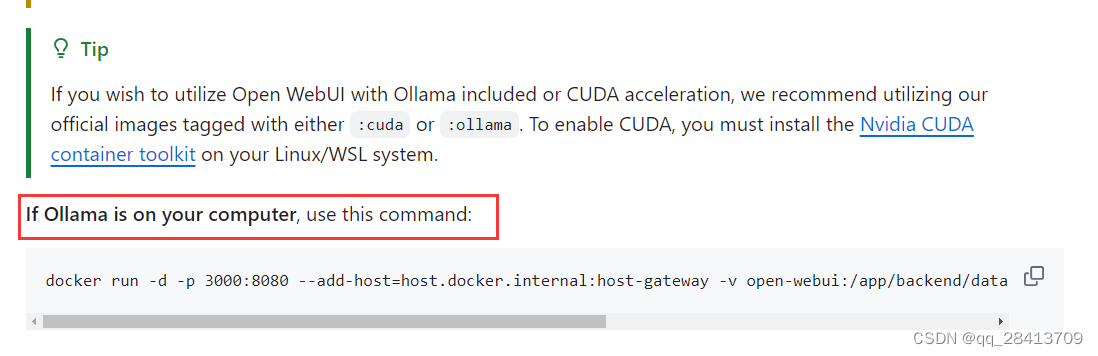

直接复制命令在windows powershell中运行

直接复制命令在windows powershell中运行

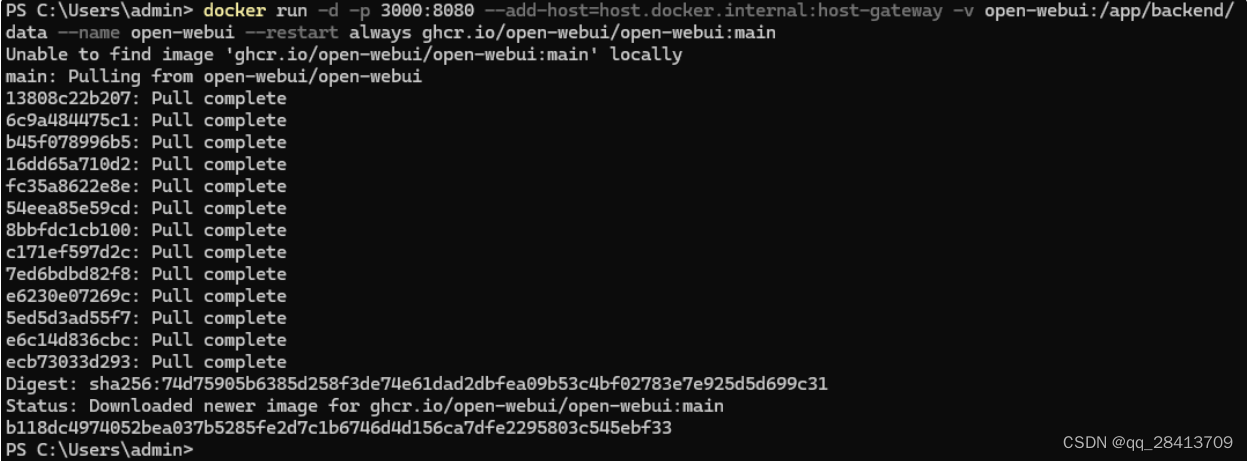

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main等待安装完毕

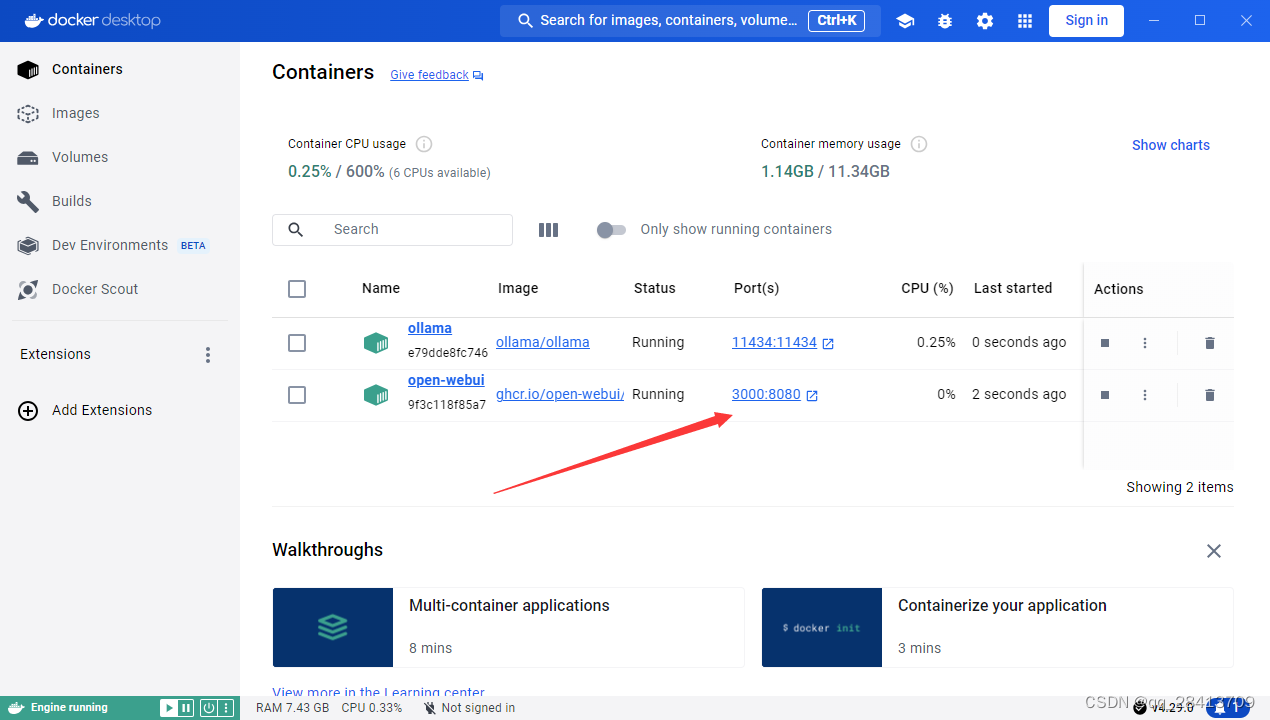

安装完毕后打开docker,点击地址

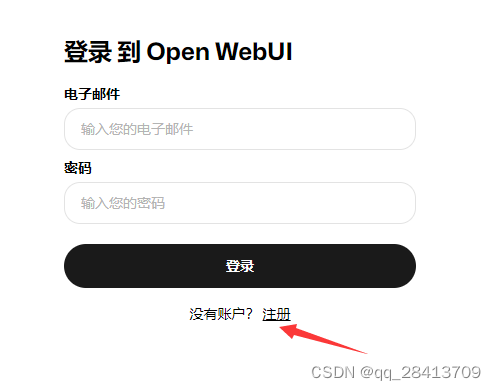

点击注册管理员账号

创建账户后登录

内网穿透实现公网访问本地大语言模型

第一步:下载cpolar

cpolar官网地址: https://www.cpolar.com

点击免费注册,注册一个账号

注册登录后下载cpolar

安装成功后在浏览器访问http://localhost:9200 ,使用已经注册好的账号登录

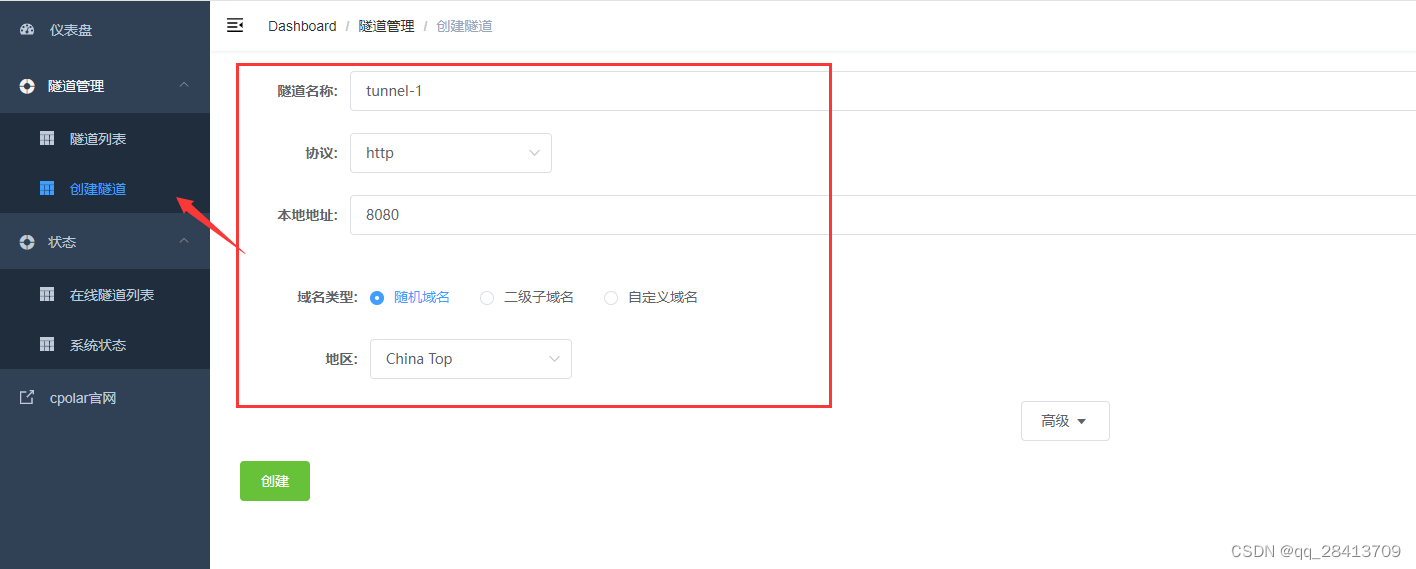

点击创建隧道,并配置

创建一个 ollama1 的公网http地址隧道:

- 隧道名称:ollama(可自定义命名,注意不要与已有的隧道名称重复)

- 协议:选择http

- 本地地址:3000 (本地访问的地址)

- 域名类型:免费选择随机域名

- 地区:选择china top

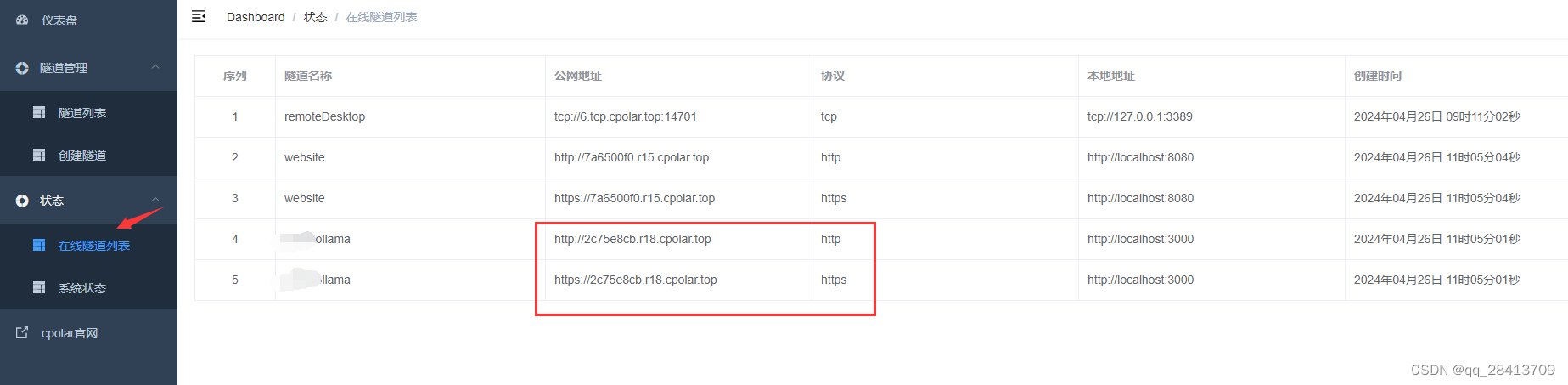

创建好后可以选择在线隧道列表,复制公网网址即可实现公网访问本地模型

本文参考

windows本地部署ollama+qwen本地大语言模型web交互界面并实现公网访问-腾讯云开发者社区-腾讯云https://github.com/1panel-dev/maxkb/wiki/%e5%a6%82%e4%bd%95%e8%ae%a9ollama%e4%bd%bf%e7%94%a8gpu%e8%bf%90%e8%a1%8cllm%e6%a8%a1%e5%9e%8b

windows安装使用docker,方便你的开发和部署(dockerdesktop篇)_windows安装docker-csdn博客

发表评论