问题背景

在使用 jmeter 压测时,发现同一后端服务,在单机 500 并发下,http 和 https 协议压测 rt 差距非常大。同时观测后端服务各监控指标水位都很低,因此怀疑性能瓶颈在 jmeter 施压客户端。

问题分析

切入点:垃圾回收

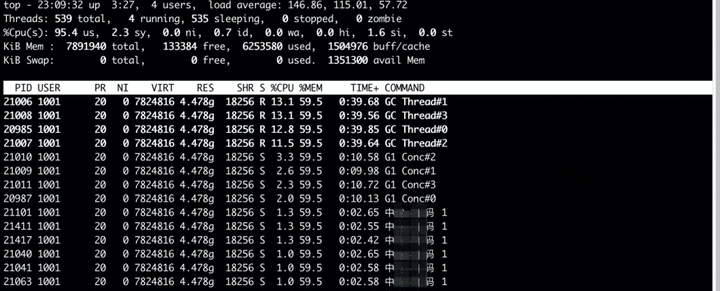

首先在施压机观察到 cpu 使用率和内存使用率都很高,详细看下各线程 cpu、内存使用情况:

top -hp {pid}发现进程的 cpu 使用率将近打满,其中 gc 线程 cpu 使用率很高

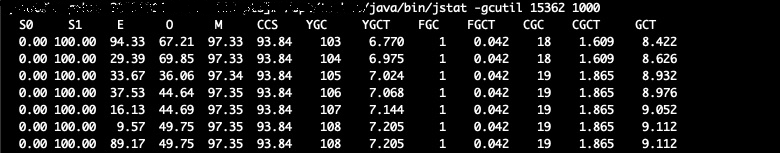

再看下 gc 的频率和耗时,发现每秒都有 younggc,且累计耗时比较长,因此先从频繁 gc 入手,定位问题。

java/bin/jstat -gcutil {pid} 1000

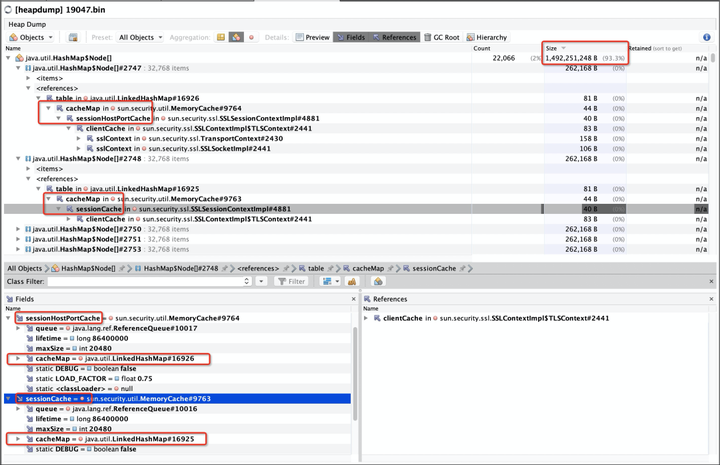

在压测过程中,对 jmeter 的运行进程做了 heapdump 后,分析下堆内存:

可以看到 cachemap 对象占用了 93.3%的内存,而它又被 sslsessioncontextimpl 类引用,分析下源码,可以看出,每个 sslsessioncontextimpl 对象构造时,都会初始化 sessionhostportcache 和 sessioncache 两个软引用 cache。因为是软引用,所以在内存不足时 jvm 才会回收此类对象。

-

// 默认缓存大小 -

private final static int default_max_cache_size = 20480; -

// package private -

sslsessioncontextimpl() { -

cachelimit = getdefaultcachelimit(); // default cache size,这里默认是20480 -

timeout = 86400; // default, 24 hours -

// use soft reference -

// 这里初始化了2个默认大小20480的缓存,是频繁gc的原因 -

sessioncache = cache.newsoftmemorycache(cachelimit, timeout); -

sessionhostportcache = cache.newsoftmemorycache(cachelimit, timeout); -

} -

// 获取默认缓存大小 -

private static int getdefaultcachelimit() { -

try { -

int defaultcachelimit = getintegeraction.privilegedgetproperty( -

"javax.net.ssl.sessioncachesize", default_max_cache_size); -

if (defaultcachelimit >= 0) { -

return defaultcachelimit; -

} else if (ssllogger.ison && ssllogger.ison("ssl")) { -

ssllogger.warning( -

"invalid system property javax.net.ssl.sessioncachesize, " + -

"use the default session cache size (" + -

default_max_cache_size + ") instead"); -

} -

} catch (exception e) { -

// unlikely, log it for safe -

if (ssllogger.ison && ssllogger.ison("ssl")) { -

ssllogger.warning( -

"the system property javax.net.ssl.sessioncachesize is " + -

"not available, use the default value (" + -

default_max_cache_size + ") instead"); -

} -

} -

return default_max_cache_size; -

}

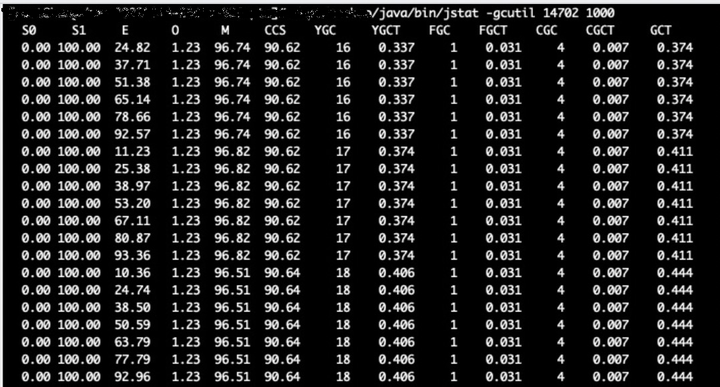

通过上述代码,发现 sessioncache 和 sessionhostportcache 缓存默认大小是 default_max_cache_size,也就是 20480。对于我们压测的场景来说,如果每次请求重新建立连接,那么就根本不需要这块缓存。再看下代码逻辑,发现其实可以通过 javax.net.ssl.sessioncachesize 来设置缓存的大小,在 jmeter 启动时,添加 jvm 参数-djavax.net.ssl.sessioncachesize=1,将缓存大小设置为 1,重新压测验证,观察 gc。

可以看出,ygc 明显变少了,从 1 秒 1 次,变成了 5-6 秒 1 次。那么观察下压测的 rt,结果。。。竟然还是 1800ms,本来 100ms 的服务被压成 1800ms,看来问题不在于 sslsession 的缓存。再回到 gc 的耗时分析部分,仔细看下,其实 full gc 只有 1 次,阻塞性的耗时并不多,young gc 虽然频繁,但阻塞时间很短,也不至于将 ssl 加解密的 cpu 计算时间片全部抢占。看起来压力就是单纯的 ssl 握手次数多,造成了性能瓶颈。

调整思路:为什么频繁 ssl 握手

回到问题背景,我们是在做压力测试,单机会跑很高的并发模拟用户量,出于性能考虑,完全可以一次握手后共享 ssl 连接,后续不再握手,为什么 jmeter 会如此频繁握手呢?

带着这个问题,看了下 jmeter 官方文档,果然有惊喜!

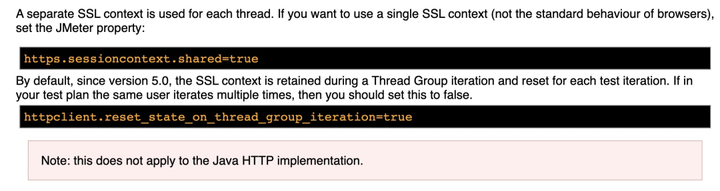

原来 jmeter 有 2 个开关在控制是否重置 ssl 上下文的选项,首先是 https.sessioncontext.shared 控制是否全局共享同一个 sslcontext,如果设为 true,则各线程共享同一个 ssl 上下文,这样对施压机性能压力最低,但不能模拟真实多用户 ssl 握手的情况。

第二个开关 httpclient.reset_state_on_thread_group_iteration 是线程组每次循环是否重置 ssl 上下文,5.0 之后默认为true,也就是说每次循环都会重置 ssl 上下文,看来这就是导致 ssl 频繁握手的原因。

问题验证

回归测试

在 jmeter.properties 中将配置每个线程循环时,不重置 ssl 上下文,在 pts 控制台再次启动压测,rt 直接下降 10 倍。

httpclient.reset_state_on_thread_group_iteration=false

修改前

修改后

源码验证

下面从源码层面分析下 jmeter 是怎么实现循环重置 ssl 上下文的,代码如下:

-

/** -

* whether ssl state/context should be reset -

* shared state for any hc based implementation, because ssl contexts are the same -

*/ -

protected static final threadlocal<boolean> resetstateonthreadgroupiteration = -

threadlocal.withinitial(() -> boolean.false); -

/** -

* reset ssl state. <br/> -

* in order to do that we need to: -

* <ul> -

* <li>call resetcontext() on sslmanager</li> -

* <li>close current idle or expired connections that hold ssl state</li> -

* <li>remove httpclientcontext.user_token from {@link httpclientcontext}</li> -

* </ul> -

* @param jmetervariables {@link jmetervariables} -

* @param clientcontext {@link httpclientcontext} -

* @param maphttpclientperhttpclientkey map of {@link pair} holding {@link closeablehttpclient} and {@link poolinghttpclientconnectionmanager} -

*/ -

private void resetstateifneeded(jmetervariables jmetervariables, -

httpclientcontext clientcontext, -

map<httpclientkey, pair<closeablehttpclient, poolinghttpclientconnectionmanager>> maphttpclientperhttpclientkey) { -

if (resetstateonthreadgroupiteration.get()) { -

// 关闭当前线程对应连接池的超时、空闲连接,重置连接池状态 -

closecurrentconnections(maphttpclientperhttpclientkey); -

// 移除token -

clientcontext.removeattribute(httpclientcontext.user_token); -

// 重置ssl上下文 -

((jssesslmanager) sslmanager.getinstance()).resetcontext(); -

// 标记置为false,保证一次循环中,只有第一个采样器走进此逻辑 -

resetstateonthreadgroupiteration.set(false); -

} -

} -

@override -

protected void notifyfirstsampleafterlooprestart() { -

log.debug("notifyfirstsampleafterlooprestart called " -

+ "with config(httpclient.reset_state_on_thread_group_iteration={})", -

reset_state_on_thread_group_iteration); -

resetstateonthreadgroupiteration.set(reset_state_on_thread_group_iteration); -

}

在每次基于 apache httpclient4 的 http 采样器执行时,都会调用 resetstateifneeded 方法,在进入方法时读取 httpclient.reset_state_on_thread_group_iteration 配置,即 resetstateonthreadgroupiteration。如果是 true,重置当前线程的连接池状态、重置 ssl 上下文,然后再将 resetstateonthreadgroupiteration 置为 false。

因为 jmeter 的并发是基于线程实现的,resetstateonthreadgroupiteration 这个开关放在 threadlocal 里,在每次循环开始时,会调用 notifyfirstsampleafterlooprestart 方法,重置开关,运行一次后,强制把开关置为 false。这保证了每次循环只有第一个采样器进入此逻辑,也就是每次循环只执行一次。

总结

本次解决了 jmeter5.0 版本以上压测 https 协议的性能问题,经验总结如下:

- 如果希望施压机发挥最大性能,可以将 https.sessioncontext.shared 设为 true,这样所有线程会共享同一个 ssl 上下文,不会频繁握手,但是不能模拟真实情况下多用户的场景。

- 如果希望模拟多个用户,不停循环执行某一个动作,也就是一个线程组每次循环模拟同一个用户的行为,可以将 httpclient.reset_state_on_thread_group_iteration 设置为 false,这样也可以很大的提高单机压测 https 的性能。

- 如果希望每个线程组每次循环模拟不同用户,那需要设置 httpclient.reset_state_on_thread_group_iteration=true,此时压测会模拟多用户频繁 ssl 握手,施压机性能最低,从经验来看,单机上限 50 并发左右。这也是 jmeter5.0 版本之后的默认设置。

阿里云 jmeter 压测

阿里云 pts 压测工具[1]支持原生 jmeter 脚本,并且在 https 的压测中已将 httpclient.reset_state_on_thread_group_iteration 默认设置为 false,极大提高压测 https 时施压机性能,节省压测成本。如果模拟最真实的用户访问情况来压测,可以通过修改 jmeter 环境中的自定义 properties 配置[2],将 httpclient.reset_state_on_thread_group_iteration 设置为 true。

除此以外,阿里云 jmeter 压测有以下优势:

- 零运维成本支持分布式压测,即压即用

- 压测中查看秒级监控,实时观测系统性能水位

- 支持 rps 模式,直观衡量系统吞吐量

- 全球地域发起百万级并发流量,模拟真实用户分布

- 支持阿里云 vpc 压测,一键打通云上内网环境

- 支持 jmeter 客户端插件,本地快速发起云端压测

总结:

感谢每一个认真阅读我文章的人!!!

作为一位过来人也是希望大家少走一些弯路,如果你不想再体验一次学习时找不到资料,没人解答问题,坚持几天便放弃的感受的话,在这里我给大家分享一些自动化测试的学习资源,希望能给你前进的路上带来帮助。

视频文档获取方式:

这份文档和视频资料,对于想从事【软件测试】的朋友来说应该是最全面最完整的备战仓库,这个仓库也陪伴我走过了最艰难的路程,希望也能帮助到你!以上均可以分享,点下方小卡片即可自行领取

发表评论