chattts(chat text to speech)是专为对话场景设计的文本生成语音(tts)模型,特别适用于大型语言模型(llm)助手的对话任务,以及诸如对话式音频和视频介绍等应用。它支持中文和英文,还可以穿插笑声、说话间的停顿、以及语气词等,听起来很真实自然,在语音合成中表现出高质量和自然度(chattts团队声称:突破开源天花板)。

同时,chattts模型文件总大小1.1gb左右,常用的个人笔记本电脑均可部署,因此涉及到文本转语音场景,均可以自己操作转换了!

chattts特点

由于chattts以下极具吸引人的特点,使得它一经推出就成为了爆款:

- 多语言支持:chattts的一个关键特性是支持多种语言,包括英语和中文。这使其能够为广泛用户群提供服务,并克服语言障碍。

- 大规模数据训练:chattts使用了大量数据进行训练,大约有1000万小时的中文和英文数据。这样的大规模训练使其声音合成质量高,听起来自然。

- 对话任务兼容性:chattts很适合处理通常分配给大型语言模型llms的对话任务。它可以为对话生成响应,并在集成到各种应用和服务时提供更自然流畅的互动体验。

- 开源计划:chattts团队目前开源一个经过训练的基础模型。

- 控制和安全性:chattts致力于提高模型的可控性,添加水印,并将其与llms集成。这些努力确保了模型的安全性和可靠性。

- 易用性:chattts为用户提供了易于使用的体验。它只需要文本信息作为输入,就可以生成相应的语音文件。这样的简单性使其方便有语音合成需求的用户。

下载chattts模型文件

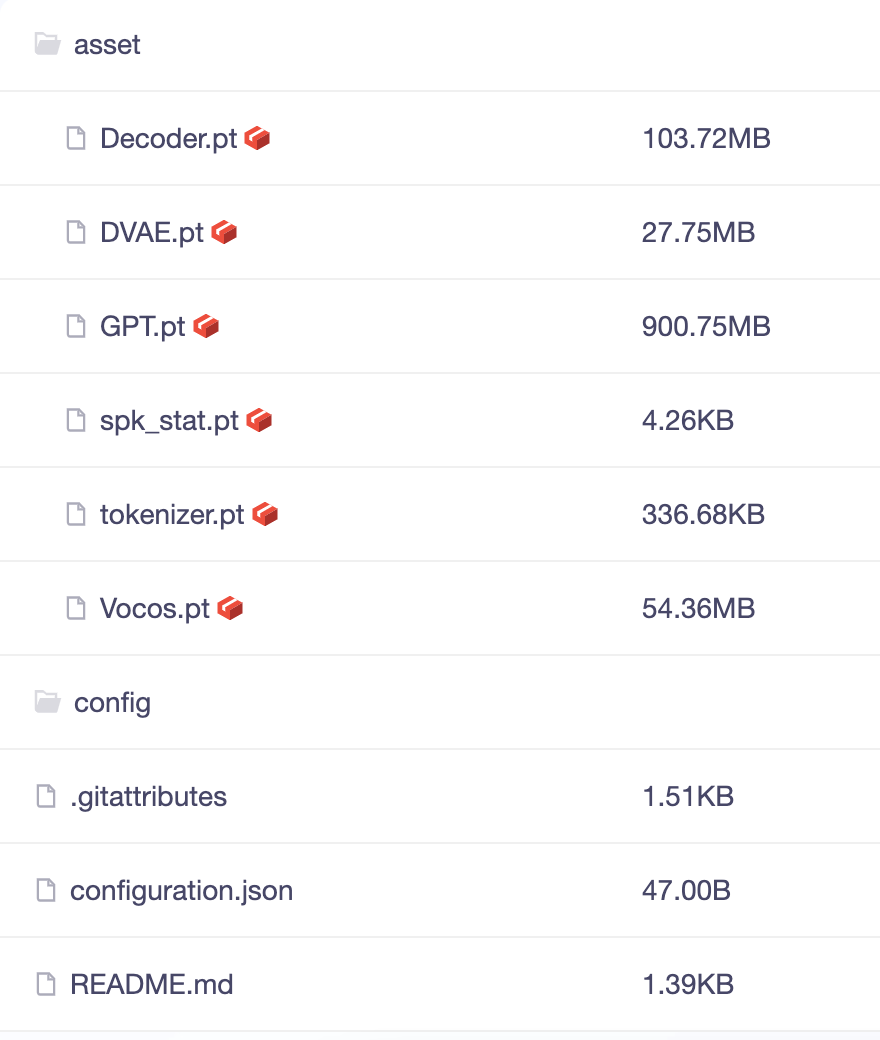

因最大模型文件超过900mb,为了防止使用git无法直接下载到本地,我们通过git-lfs工具包下载:

brew install git-lfs

通过git复制模型文件到笔记本电脑(文件夹:chattts-model):

git lfs install

git clone https://www.modelscope.cn/pzc163/chattts.git chattts-model

如果因网络不佳等原因,下载中断,我们可以通过以下命令在中断后继续下载:

git lfs pull

安装chattts依赖包列表

下载chattts官网github源码:

git clone https://gitcode.com/2noise/chattts.git chattts

进入源码目录,批量安装python依赖包:

pip install -r requirements.txt

特别注意:如果下载过程中,若出现找不到torch的2.1.0版本错误,请修改requirements.txt文件,把torch的版本修改为2.2.2后再次执行安装:

python依赖包列表requirements.txt文件如下,我们也可以手工一个一个的进行安装,无需下载整个源码(注意:torch的版本号为2.2.2):

omegaconf~=2.3.0

torch~=2.2.2

tqdm

einops

vector_quantize_pytorch

transformers~=4.41.1

vocos

ipython

chattts中文文本转音频文件

特别注意:经老牛同学的验证,chattts官网的样例代码api已经过时,无法直接运行,特别是chat.load_models方法入参是错误的,下面是老牛同学通过阅读api入参且验证的可执行代码。

# chattts-01.py

import chattts

import torch

import torchaudio

# 第一步下载的chattts模型文件目录,请按照实际情况替换

model_path = '/users/obullxl/pythonspace/chattts-model'

# 初始化并加载模型,特别注意加载模型参数,官网样例代码已经过时,请使用老牛同学验证代码

chat = chattts.chat()

chat.load_models(

vocos_config_path=f'{model_path}/config/vocos.yaml',

vocos_ckpt_path=f'{model_path}/asset/vocos.pt',

gpt_config_path=f'{model_path}/config/gpt.yaml',

gpt_ckpt_path=f'{model_path}/asset/gpt.pt',

decoder_config_path=f'{model_path}/config/decoder.yaml',

decoder_ckpt_path=f'{model_path}/asset/decoder.pt',

tokenizer_path=f'{model_path}/asset/tokenizer.pt',

)

# 需要转化为音频的文本内容

text = '大家好,我是老牛,微信公众号:老牛同学。很高兴与您相遇,专注于编程技术、大模型及人工智能等相关技术分享,欢迎关注和转发,让我们共同启程智慧之旅!'

# 文本转为音频

wavs = chat.infer(text, use_decoder=true)

# 保存音频文件到本地文件(采样率为24000hz)

torchaudio.save("./output/output-01.wav", torch.from_numpy(wavs[0]), 24000)

运作python代码:python chattts-01.py

$ python chattts-01.py

warning:chattts.utils.gpu_utils:no gpu found, use cpu instead

info:chattts.core:use cpu

info:chattts.core:vocos loaded.

info:chattts.core:gpt loaded.

info:chattts.core:decoder loaded.

info:chattts.core:tokenizer loaded.

warning:chattts.core:dvae not initialized.

info:chattts.core:all initialized.

20%|██████████████████████████▌ | 76/384 [00:08<00:35, 8.62it/s]

26%|██████████████████████████████████▌ | 536/2048 [00:48<02:17, 10.98it/s]

上述文本转音频程序执行完成,在本地目录生成了./output/output-01.wav音频文件,打开该音频文件,就可以听到非常自然流畅的语音了!

我们也可以在文本转换成语音之后,直接播放语音内容:

# …… 其他包引用省略

from ipython.display import audio

# …… 其他部分代码省略

# 播放生成的音频(autoplay=true 代表自动播放)

audio(wavs[0], rate=24000, autoplay=true)

快速搭建webui界面

上面我们通过python代码生成了音频文件,操作起来比较麻烦,现在我们构建一个webui可视化界面:

首先安装python依赖包,列表如下:

pip install omegaconf~=2.3.0 transformers~=4.41.1

pip install tqdm einops vector_quantize_pytorch vocos

pip install modelscope gradio

运行python程序,即可看到可视化界面,我们可以随意输入文本来生成音频文件了:

# chattts-webui.py

import random

import chattts

import gradio as gr

import numpy as np

import torch

from chattts.infer.api import refine_text, infer_code

print('启动chattts webui......')

# webui设置

web_host = '127.0.0.1'

web_port = 8089

model_path = '/users/obullxl/pythonspace/chattts-model'

chat = chattts.chat()

chat.load_models(

vocos_config_path=f'{model_path}/config/vocos.yaml',

vocos_ckpt_path=f'{model_path}/asset/vocos.pt',

gpt_config_path=f'{model_path}/config/gpt.yaml',

gpt_ckpt_path=f'{model_path}/asset/gpt.pt',

decoder_config_path=f'{model_path}/config/decoder.yaml',

decoder_ckpt_path=f'{model_path}/asset/decoder.pt',

tokenizer_path=f'{model_path}/asset/tokenizer.pt',

)

def generate_seed():

new_seed = random.randint(1, 100000000)

return {

"__type__": "update",

"value": new_seed

}

def generate_audio(text, temperature, top_p, top_k, audio_seed_input, text_seed_input, refine_text_flag):

torch.manual_seed(audio_seed_input)

rand_spk = torch.randn(768)

params_infer_code = {

'spk_emb': rand_spk,

'temperature': temperature,

'top_p': top_p,

'top_k': top_k,

}

params_refine_text = {'prompt': '[oral_2][laugh_0][break_6]'}

torch.manual_seed(text_seed_input)

text_tokens = refine_text(chat.pretrain_models, text, **params_refine_text)['ids']

text_tokens = [i[i < chat.pretrain_models['tokenizer'].convert_tokens_to_ids('[break_0]')] for i in text_tokens]

text = chat.pretrain_models['tokenizer'].batch_decode(text_tokens)

# result = infer_code(chat.pretrain_models, text, **params_infer_code, return_hidden=true)

print(f'chattts微调文本:{text}')

wav = chat.infer(text,

params_refine_text=params_refine_text,

params_infer_code=params_infer_code,

use_decoder=true,

skip_refine_text=true,

)

audio_data = np.array(wav[0]).flatten()

sample_rate = 24000

text_data = text[0] if isinstance(text, list) else text

return [(sample_rate, audio_data), text_data]

def main():

with gr.blocks() as demo:

default_text = "大家好,我是老牛同学,微信公众号:老牛同学。很高兴与您相遇,专注于编程技术、大模型及人工智能等相关技术分享,欢迎关注和转发,让我们共同启程智慧之旅!"

text_input = gr.textbox(label="输入文本", lines=4, placeholder="please input text...", value=default_text)

with gr.row():

refine_text_checkbox = gr.checkbox(label="文本微调开关", value=true)

temperature_slider = gr.slider(minimum=0.00001, maximum=1.0, step=0.00001, value=0.8, label="语音温度参数")

top_p_slider = gr.slider(minimum=0.1, maximum=0.9, step=0.05, value=0.7, label="语音top_p采样参数")

top_k_slider = gr.slider(minimum=1, maximum=20, step=1, value=20, label="语音top_k采样参数")

with gr.row():

audio_seed_input = gr.number(value=42, label="语音随机数")

generate_audio_seed = gr.button("\u0001f3b2")

text_seed_input = gr.number(value=42, label="文本随机数")

generate_text_seed = gr.button("\u0001f3b2")

generate_button = gr.button("文本生成语音")

text_output = gr.textbox(label="微调文本", interactive=false)

audio_output = gr.audio(label="语音")

generate_audio_seed.click(generate_seed,

inputs=[],

outputs=audio_seed_input)

generate_text_seed.click(generate_seed,

inputs=[],

outputs=text_seed_input)

generate_button.click(generate_audio,

inputs=[text_input, temperature_slider, top_p_slider, top_k_slider, audio_seed_input, text_seed_input, refine_text_checkbox],

outputs=[audio_output, text_output, ])

# 启动webui

demo.launch(server_name='127.0.0.1', server_port=8089, share=false, show_api=false, )

if __name__ == '__main__':

main()

最后,运行webui程序,就可以享受可视化文本生成语音功能了:python chattts-webui.py

关注本公众号,我们共同学习进步👇🏻👇🏻👇🏻

我的本博客原地址:https://mp.weixin.qq.com/s/rl3vyj_xej7ggokaxuh8_a

部署llama 3 8b开源大模型:玩转 ai,笔记本电脑安装属于自己的 llama 3 8b 大模型和对话客户端

部署llama 3 8bweb版对话机器人:一文彻底整明白,基于 ollama 工具的 llm 大语言模型 web 可视化对话机器人部署指南

部署中文版llama 3(llama3-chinese-chat) 大模型:基于llama 3搭建中文版(llama3-chinese-chat)大模型对话聊天机器人

发表评论