![]()

安装的版本如上:三台电脑都需要统一安装

首先安装hadoop

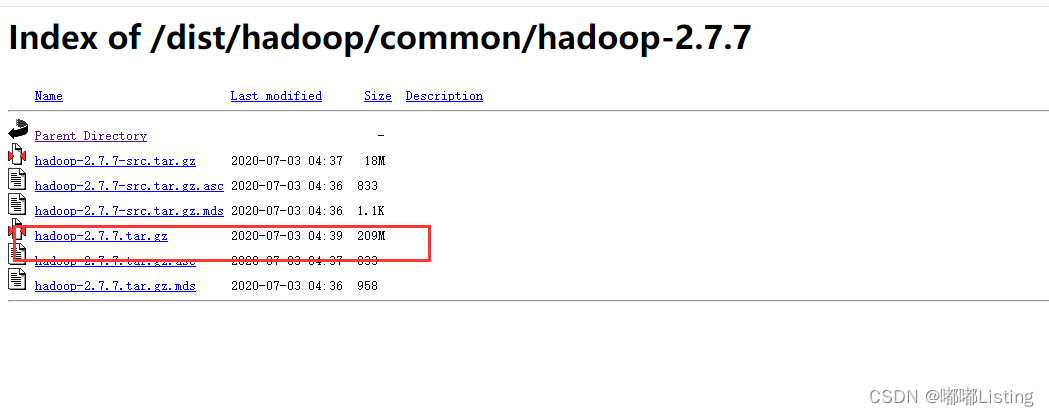

下载:index of /dist/hadoop/common/hadoop-2.7.7

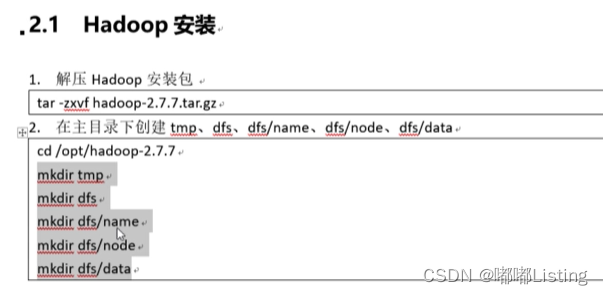

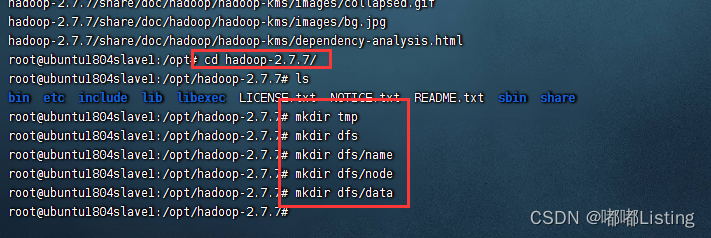

上传文件,并解压

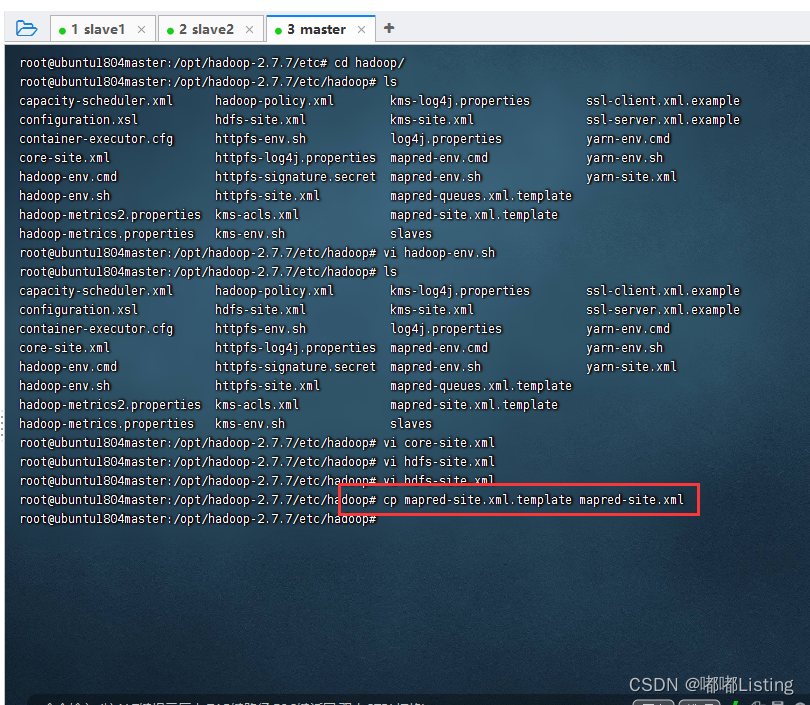

cd到haddop目标,创建目录

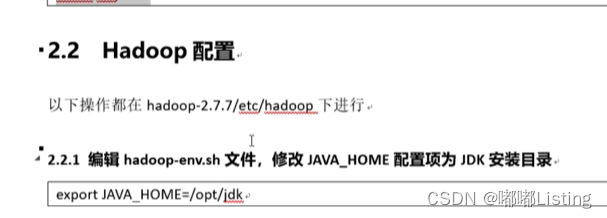

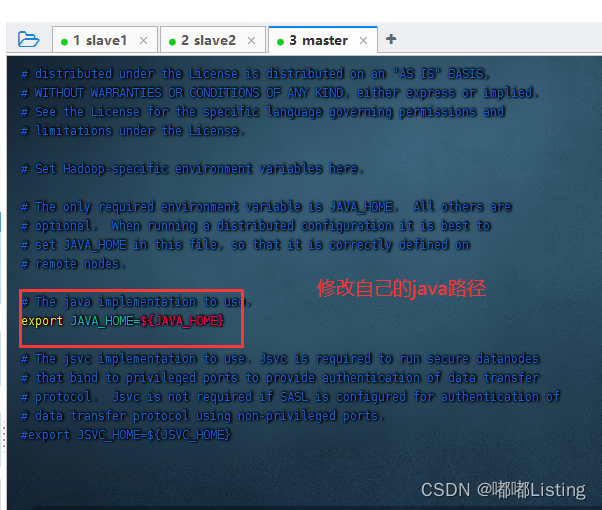

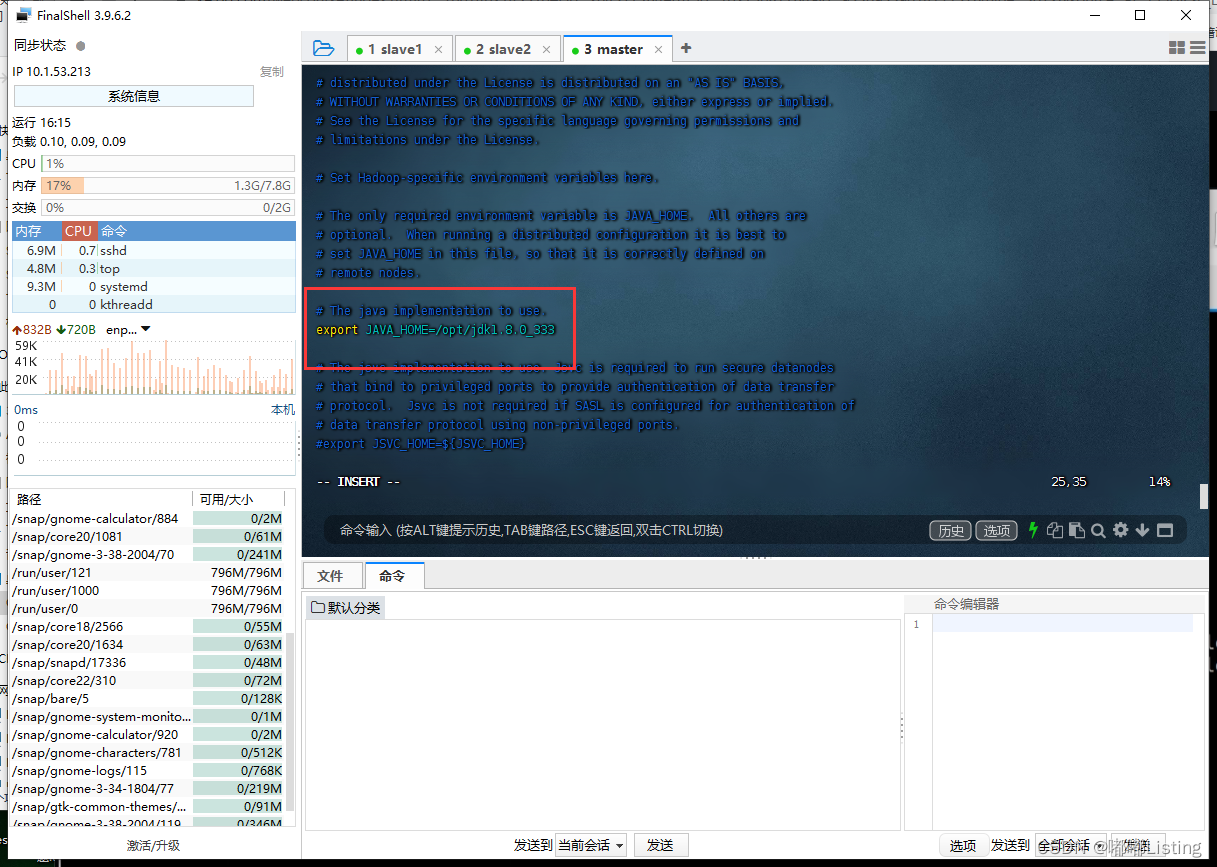

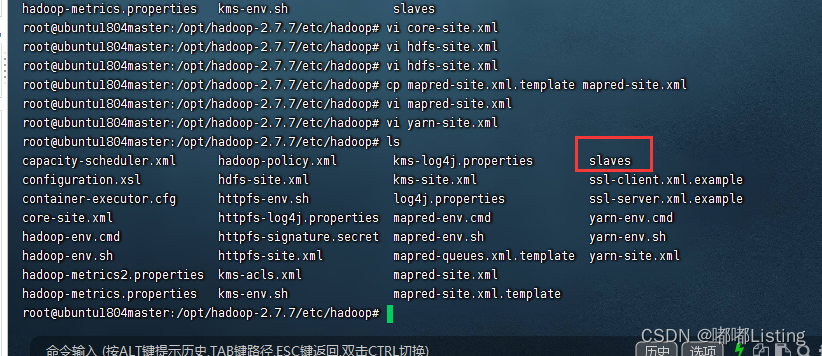

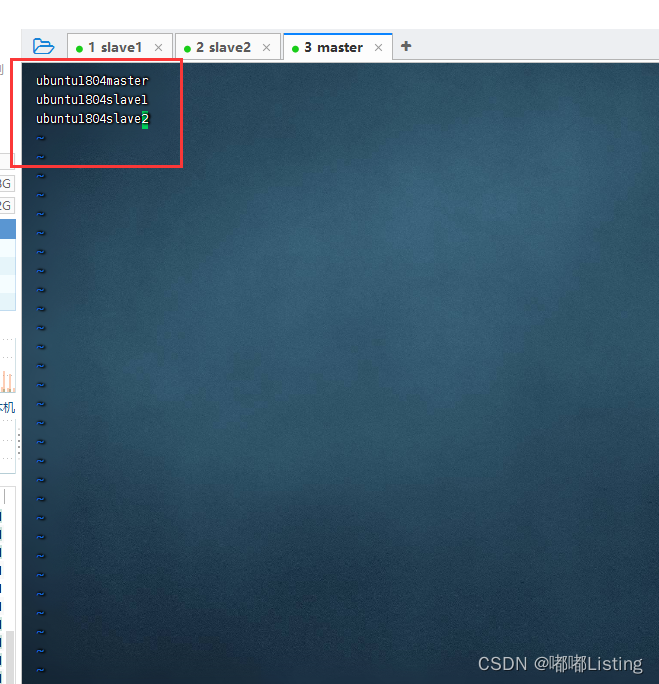

haddop配置:

保存退出:

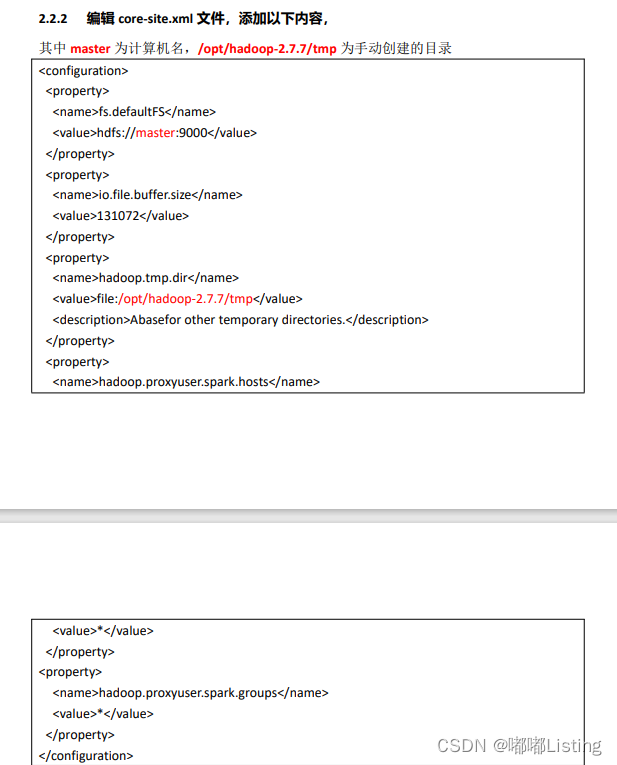

<configuration>

<property>

<name>fs.defaultfs</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/opt/hadoop-2.7.7/tmp</value>

<description>abasefor other temporary directories.</description>

</property>

<property>

<name>hadoop.proxyuser.spark.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.spark.groups</name>

<value>*</value>

</property>

</configuration>

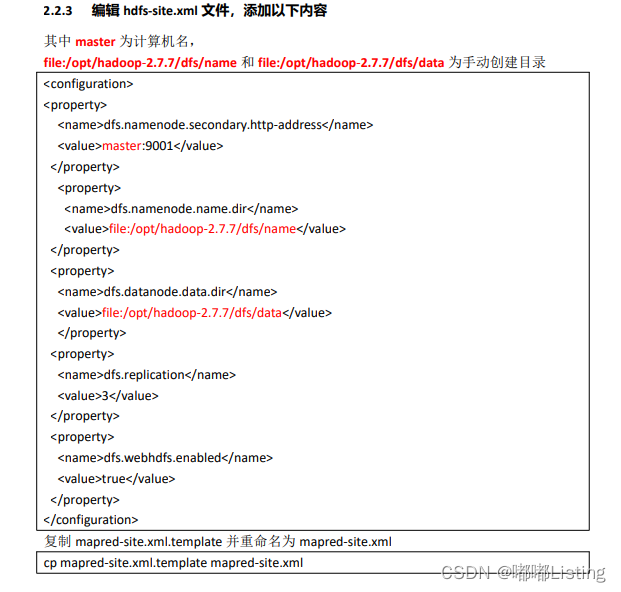

<configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>master:9001</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/hadoop-2.7.7/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/hadoop-2.7.7/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

</configuration>

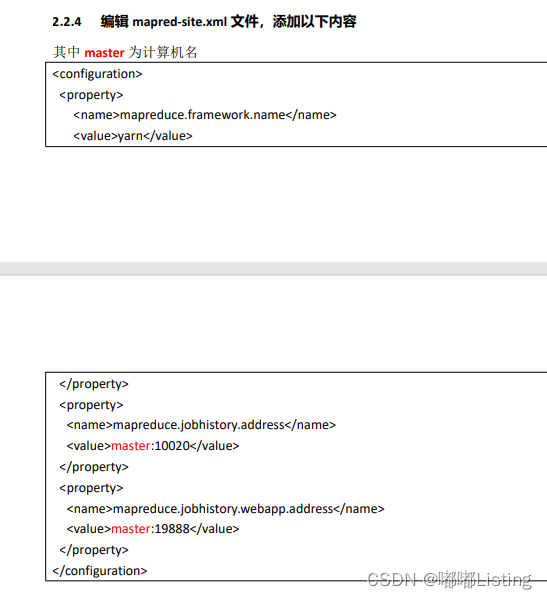

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

</configuration>

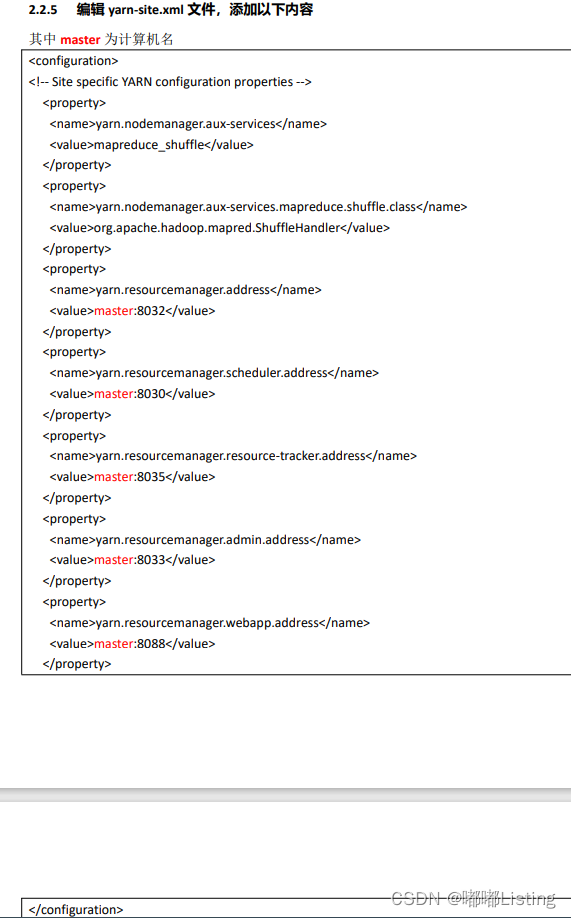

<configuration>

<!-- site specific yarn configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.shufflehandler</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>master:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:8035</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:8088</value>

</property>

</configuration>

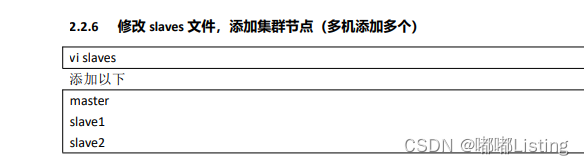

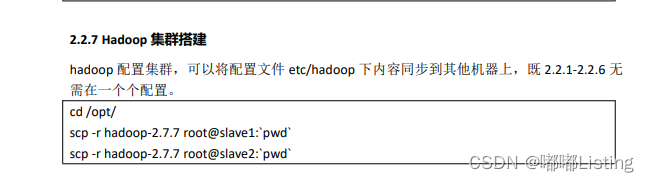

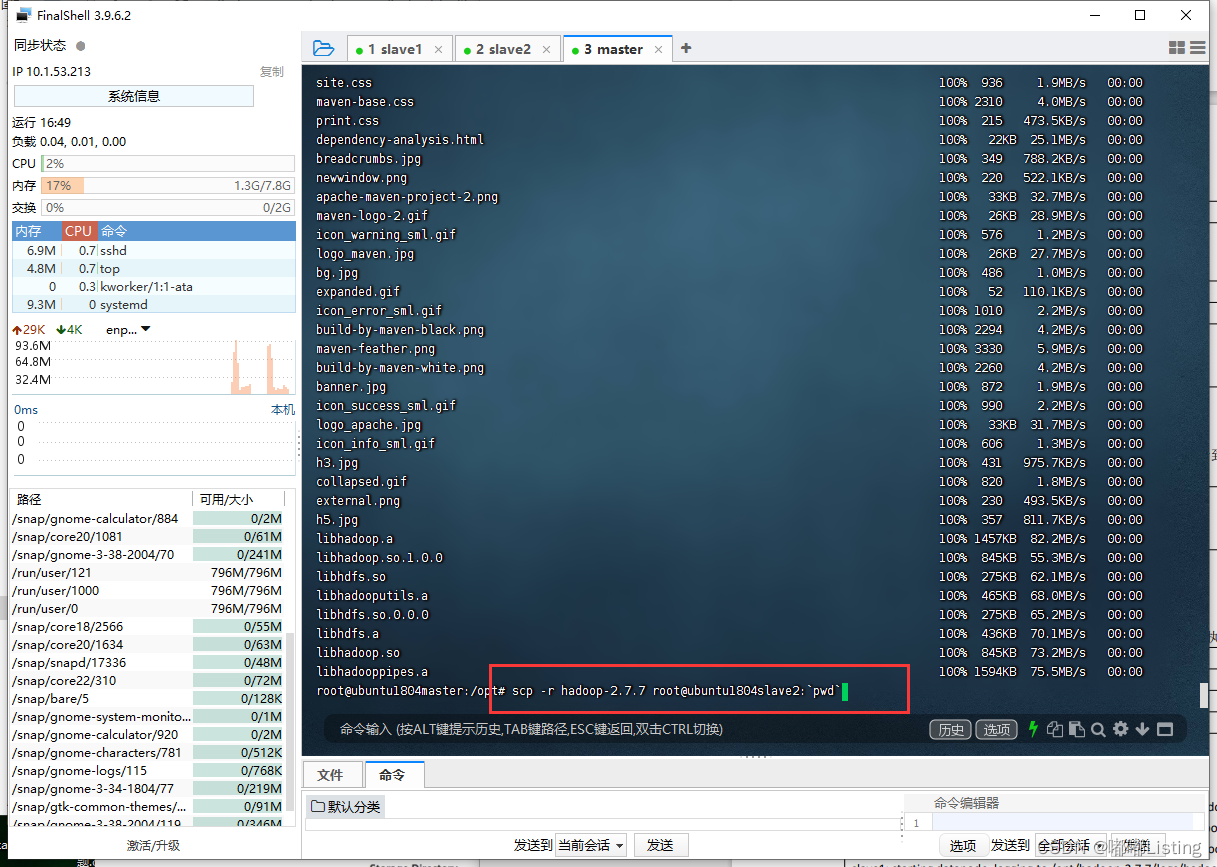

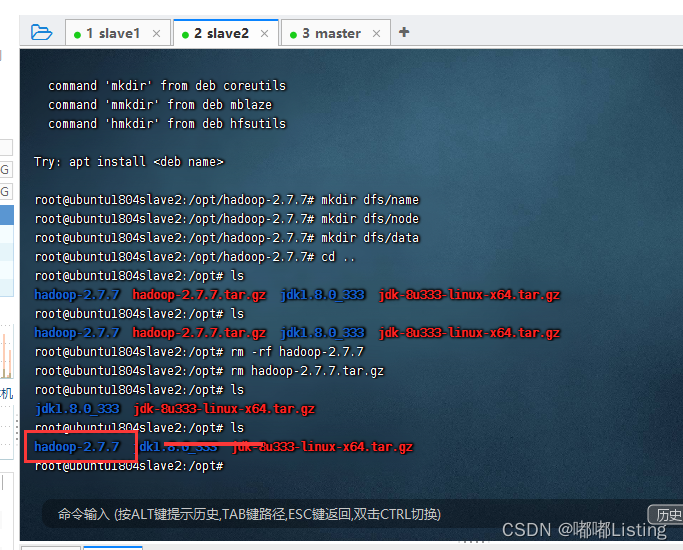

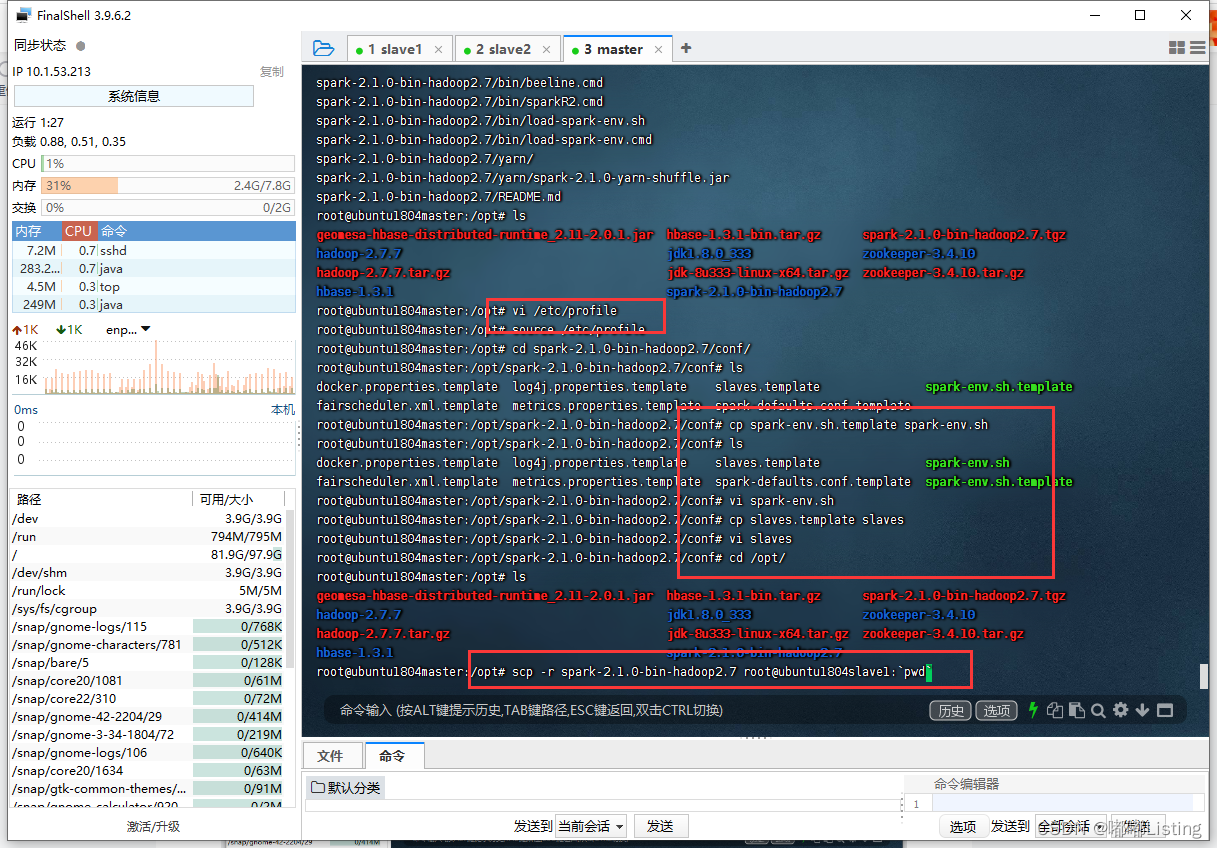

将master配置好的haddop,远程复制到另外两台电脑

scp -r hadoop-2.7.7 root@ubuntu1804slave1:`pwd`

scp -r hadoop-2.7.7 root@ubuntu1804slave2:`pwd`

检查是否传输成功:存在!

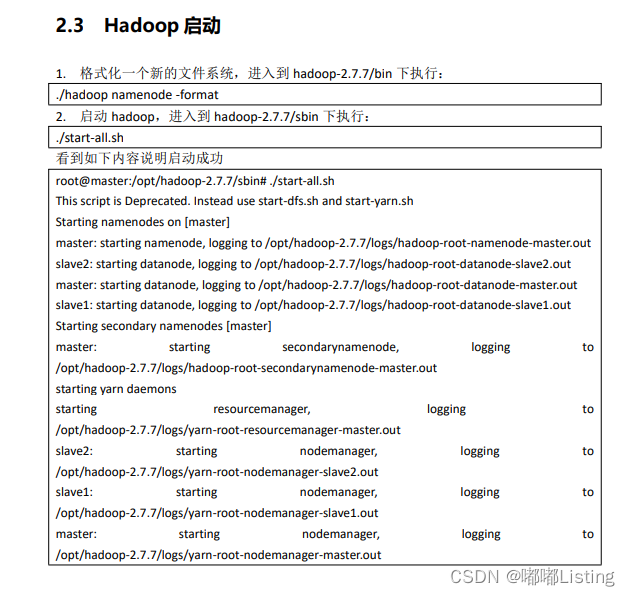

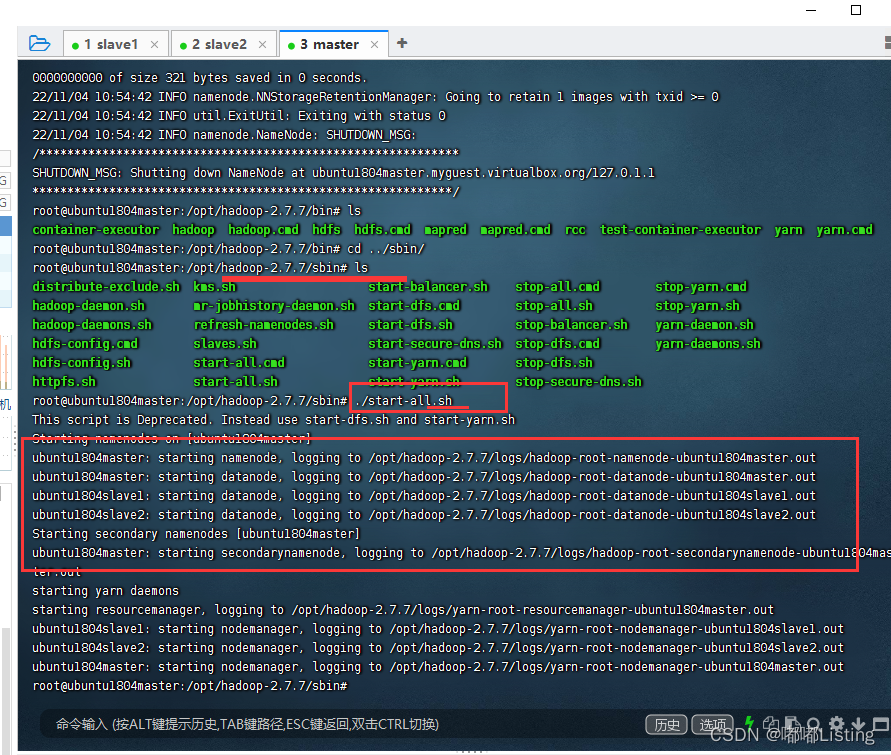

hadoop启动:

hadoop启动:

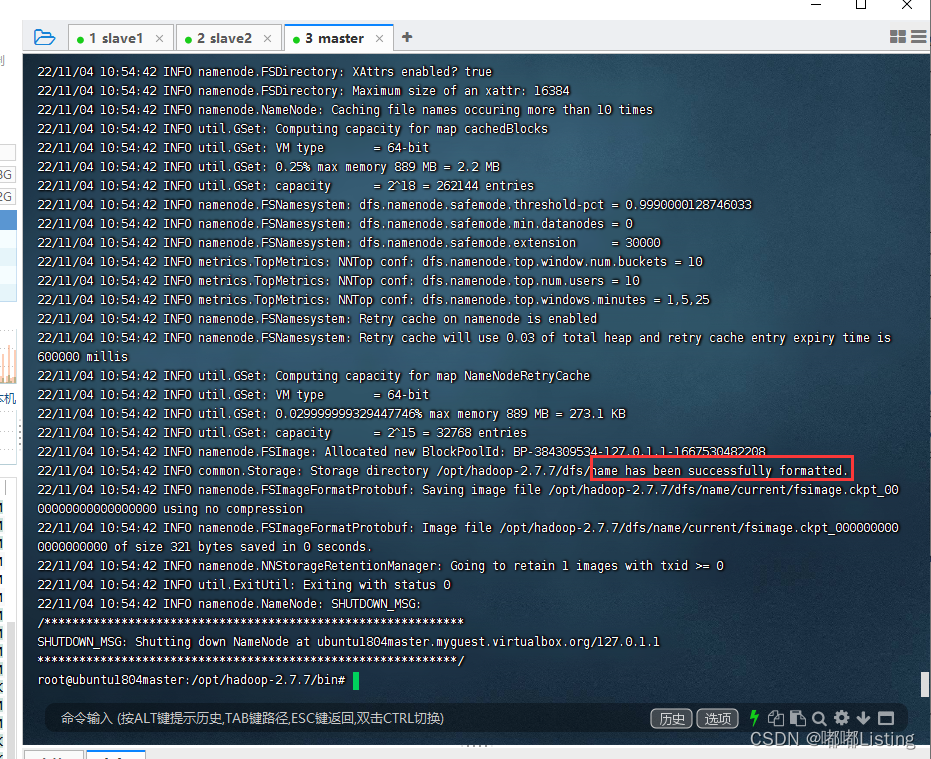

./hadoop namenode -format

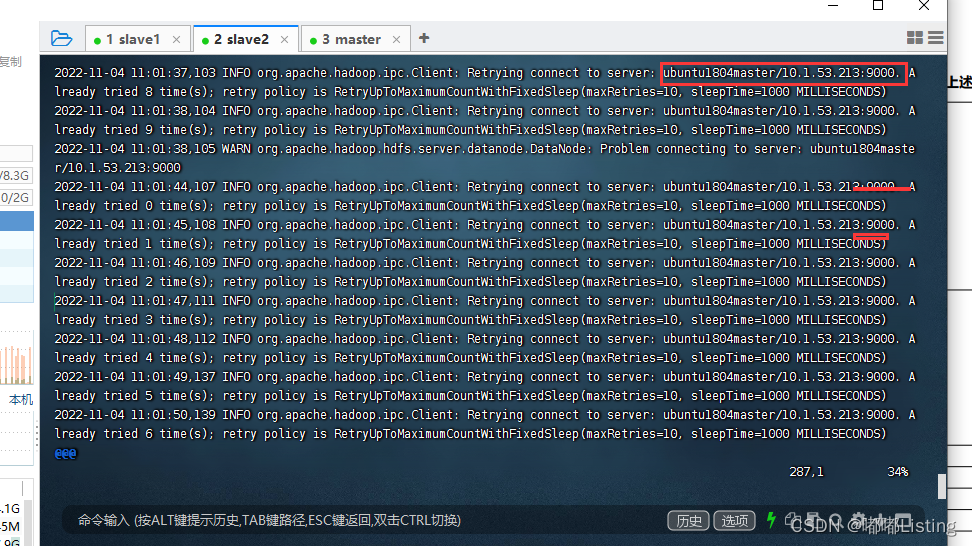

记一下;这里我的节点只有一个,另外两个节点没有连接;

解决错误:

查看日志:

9000端口拒绝访问!

仔细思考,可能是防火墙,配置文件换成ip地址;等等;

我的解决方式如下:

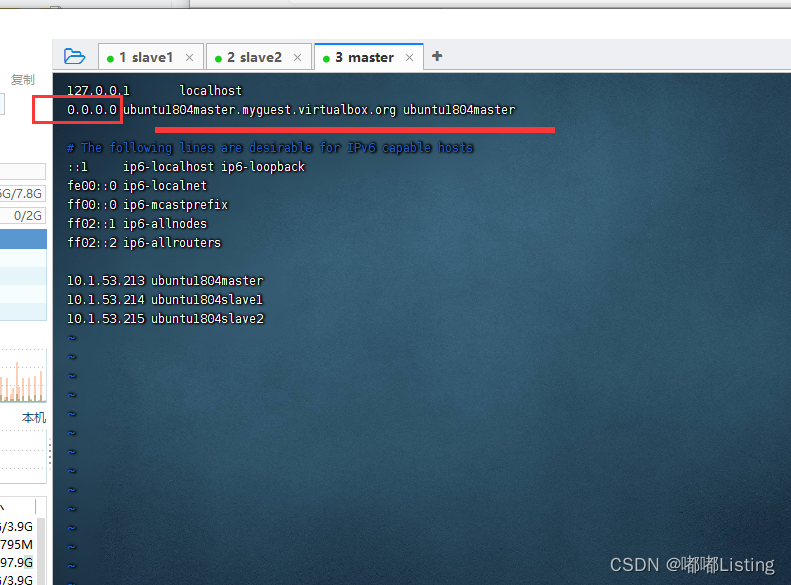

netstat -tlpn 检查主节点9000端口是否打开,发现是127.0.0.1;原来这是只允许自己访问9000,肯定其他两个电脑没法访问呗,那么修改master中的host不就行了;0.0.0.0 允许所有电脑访问;如下图 vi /etc/hosts

重启电脑:reboot

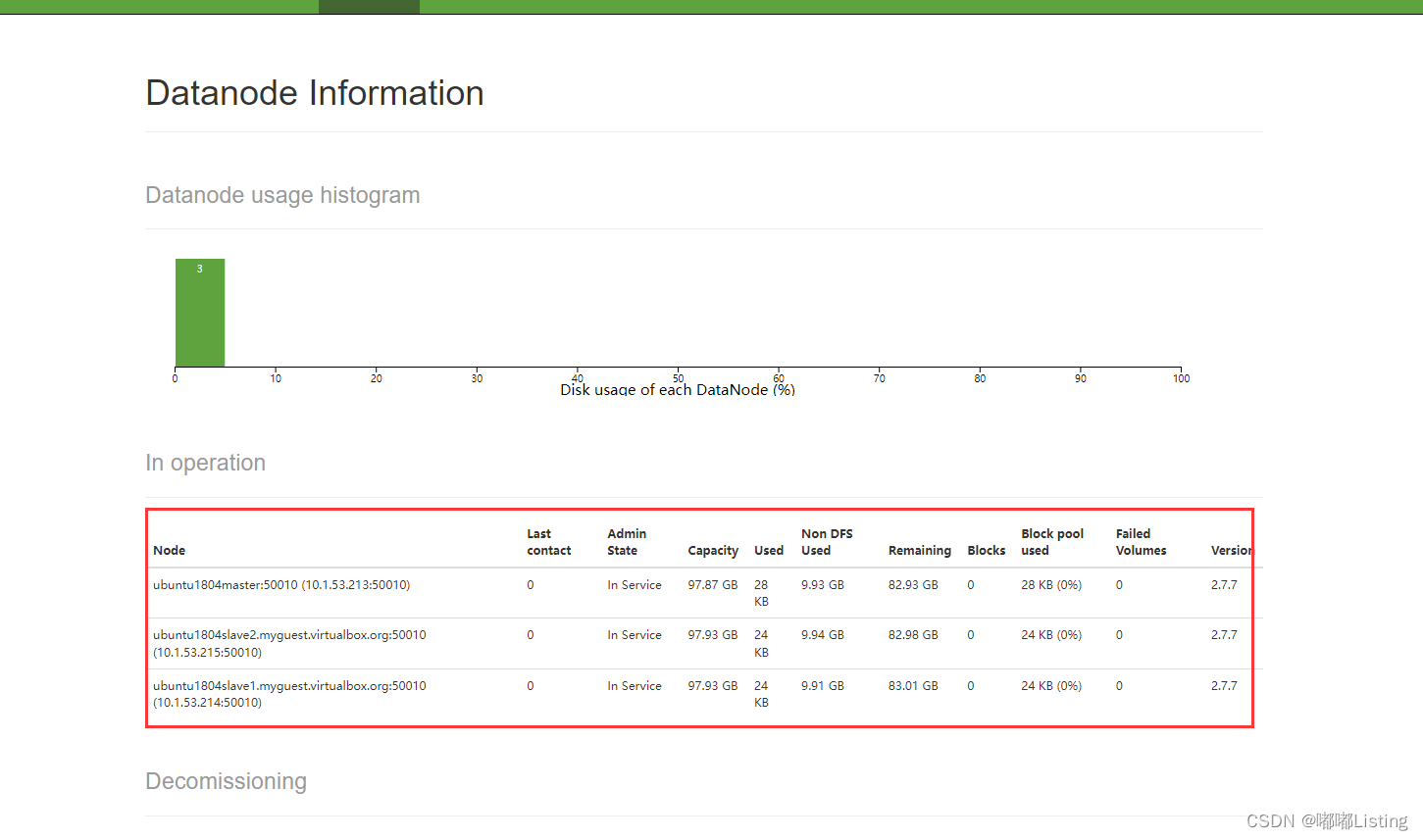

测试如下:成功!

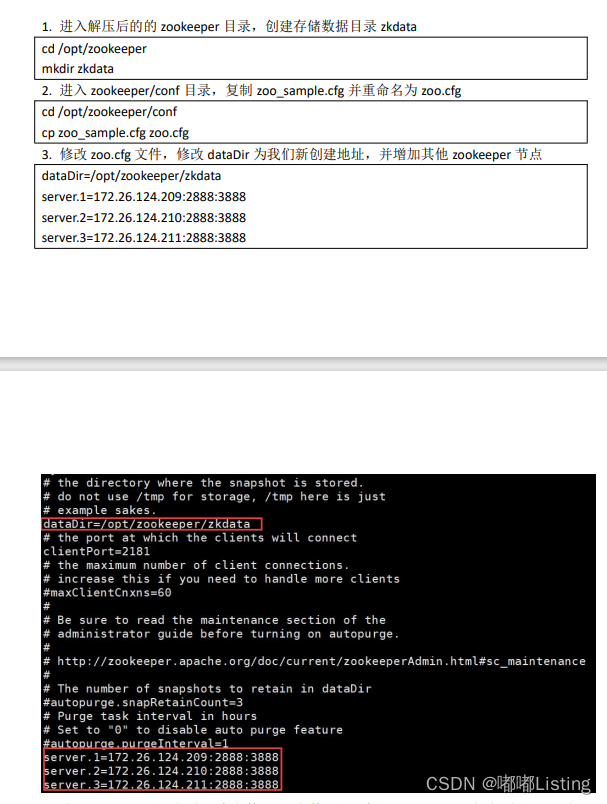

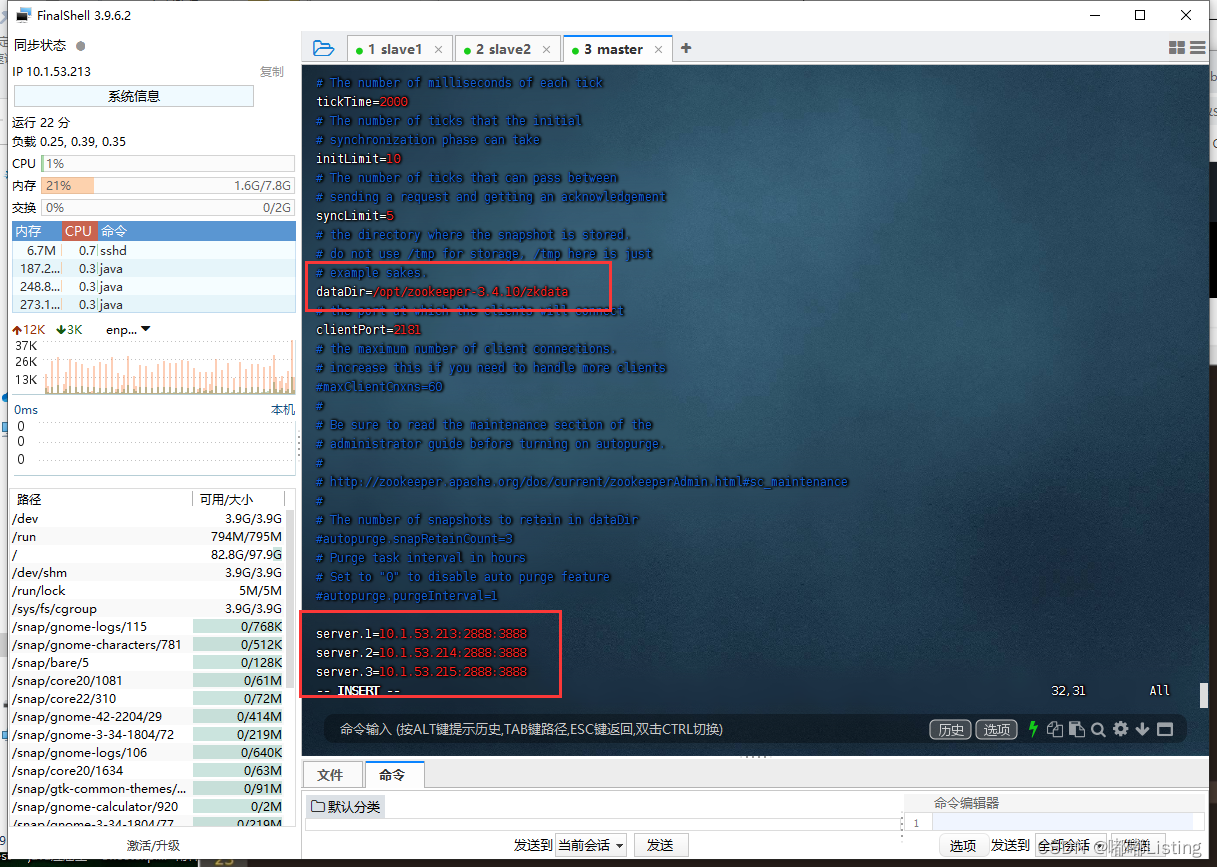

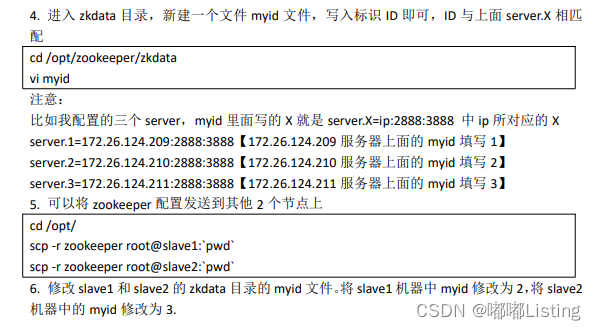

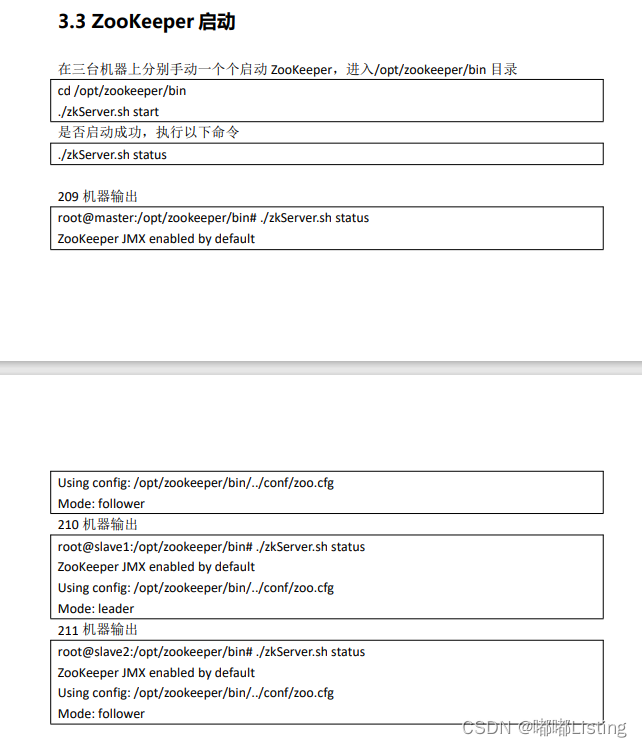

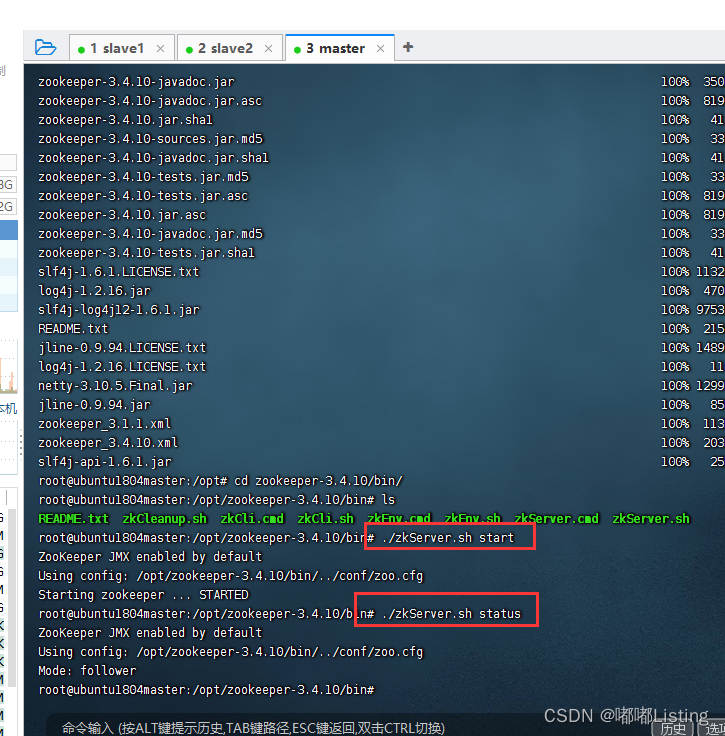

zookeeper集群部署

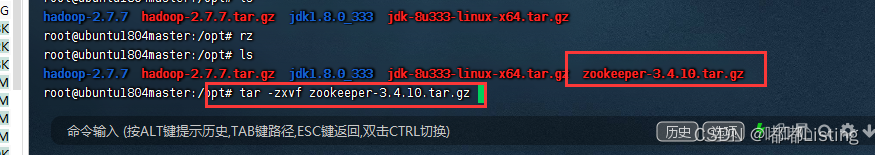

上传解压:

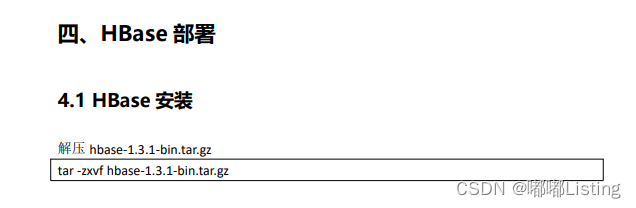

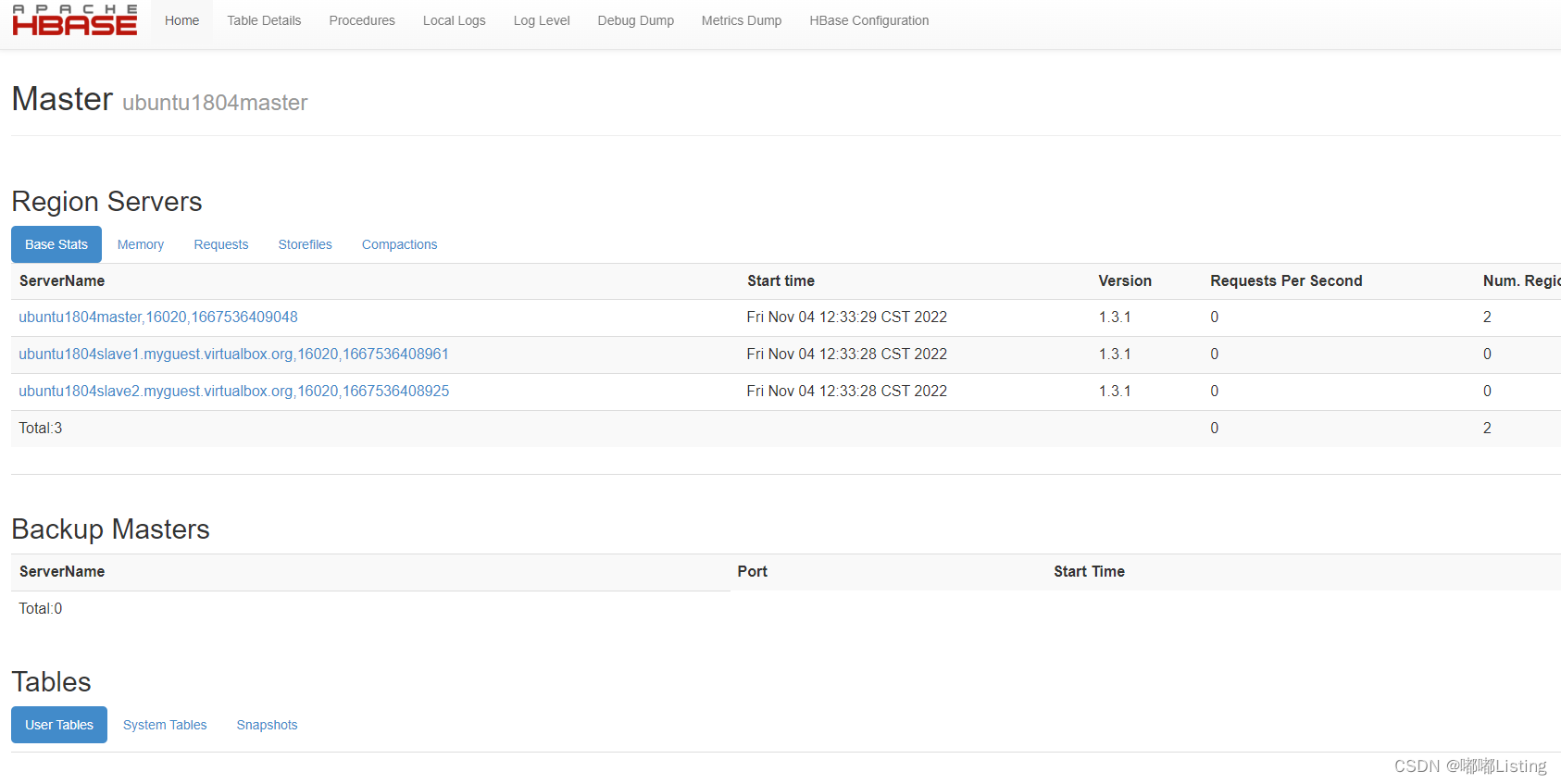

hbase部署

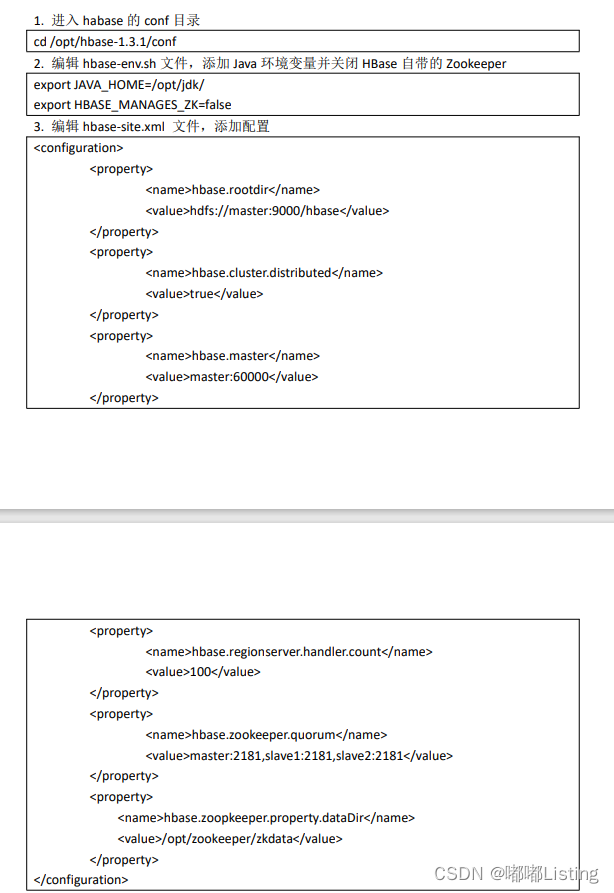

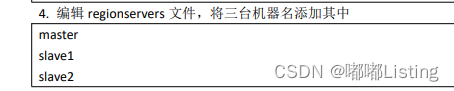

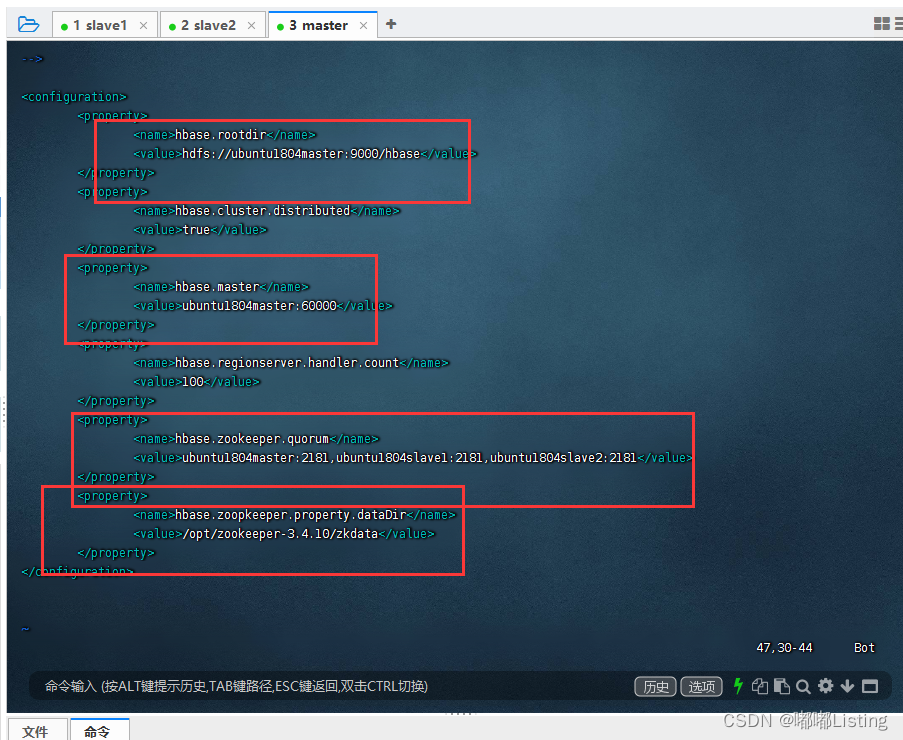

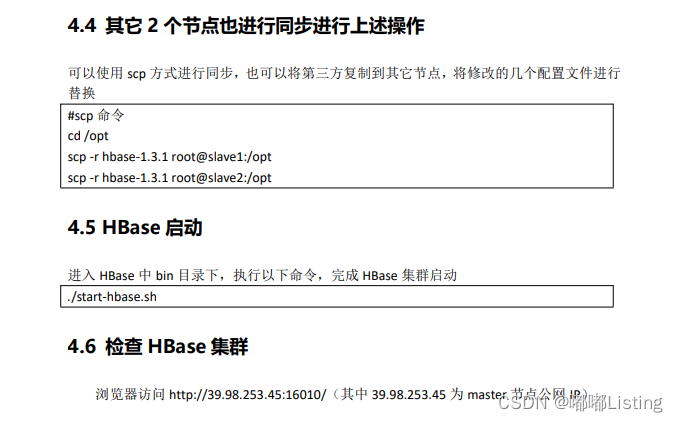

hbase 配置

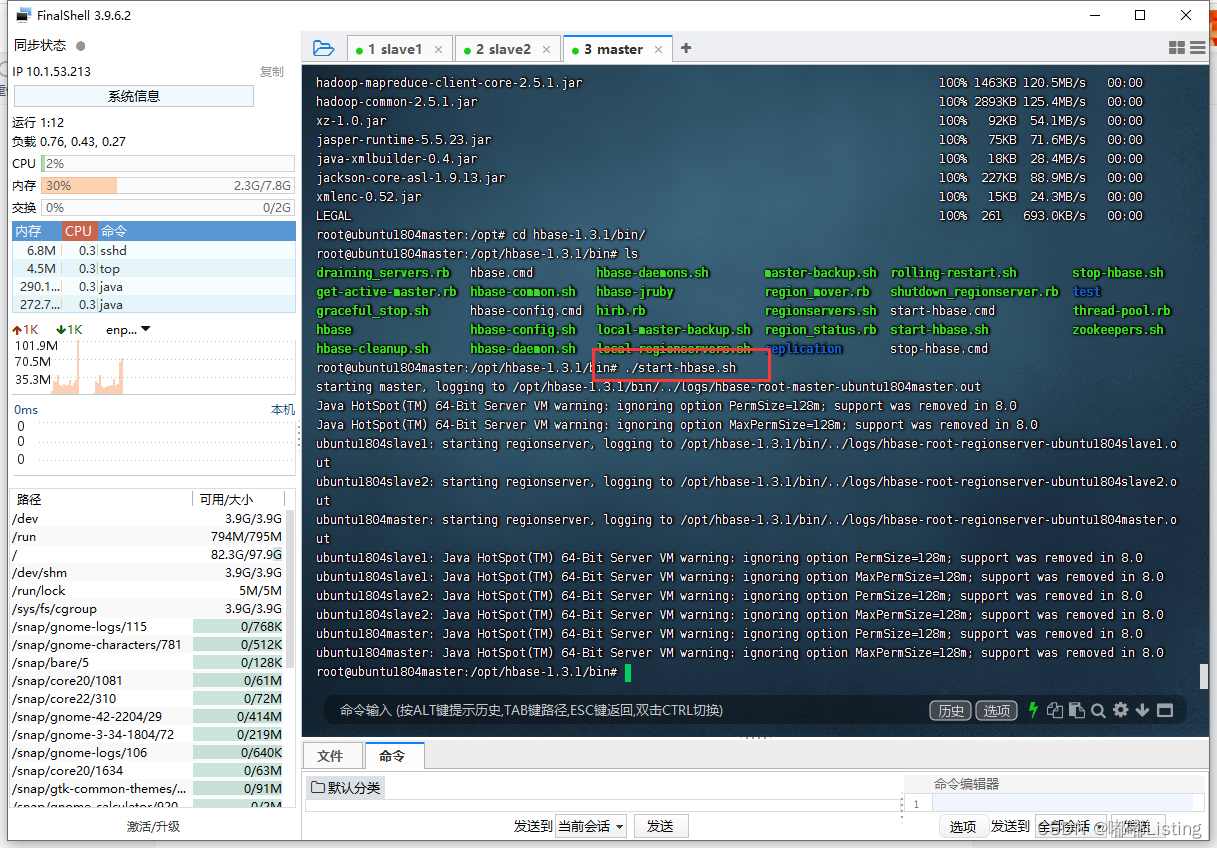

启动:成功!

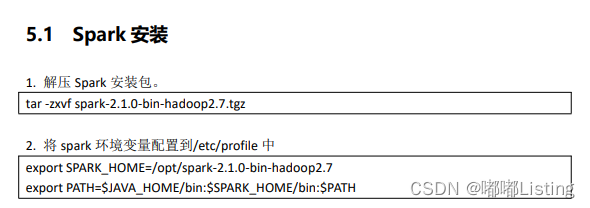

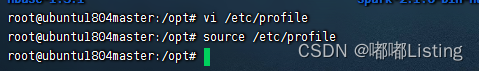

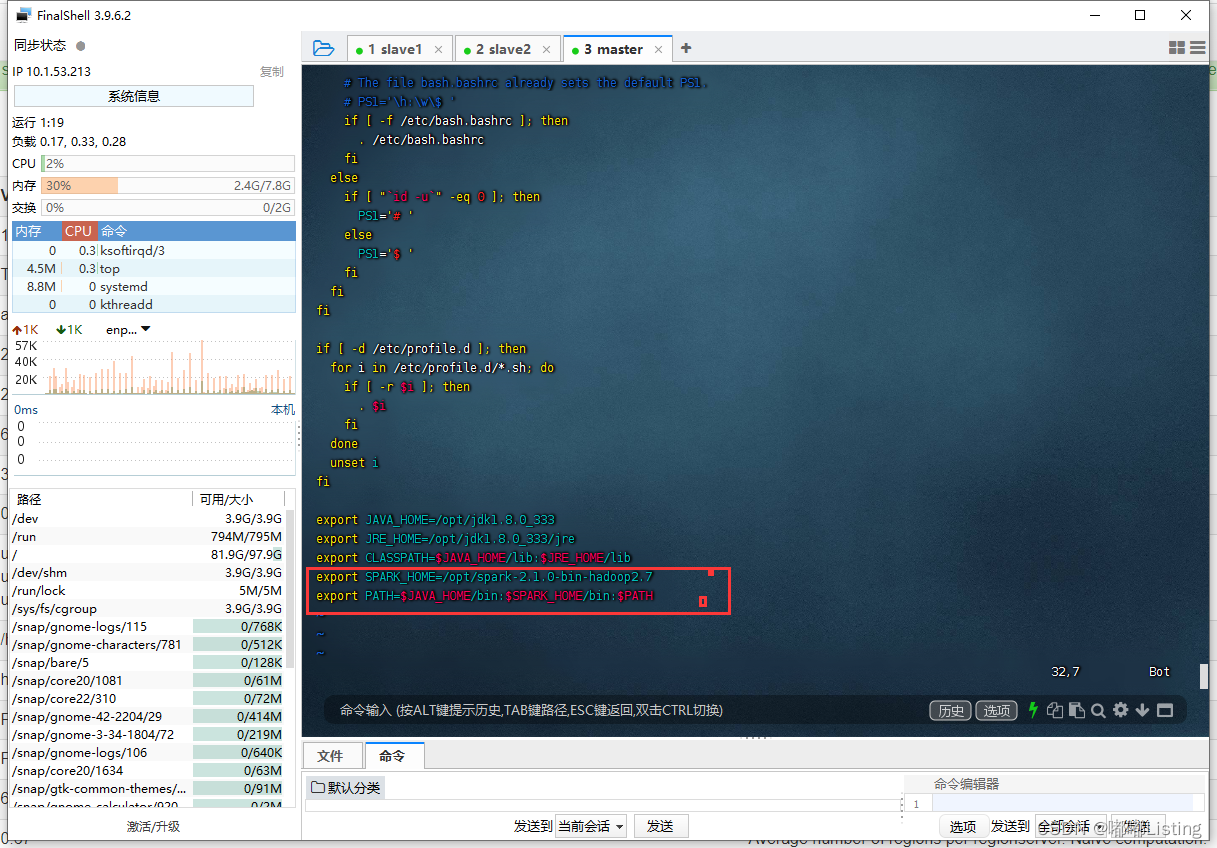

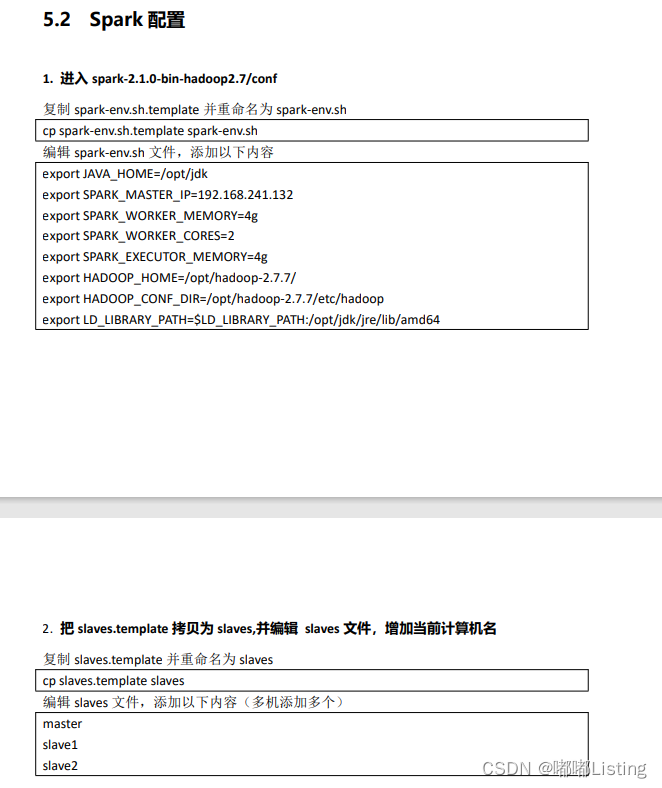

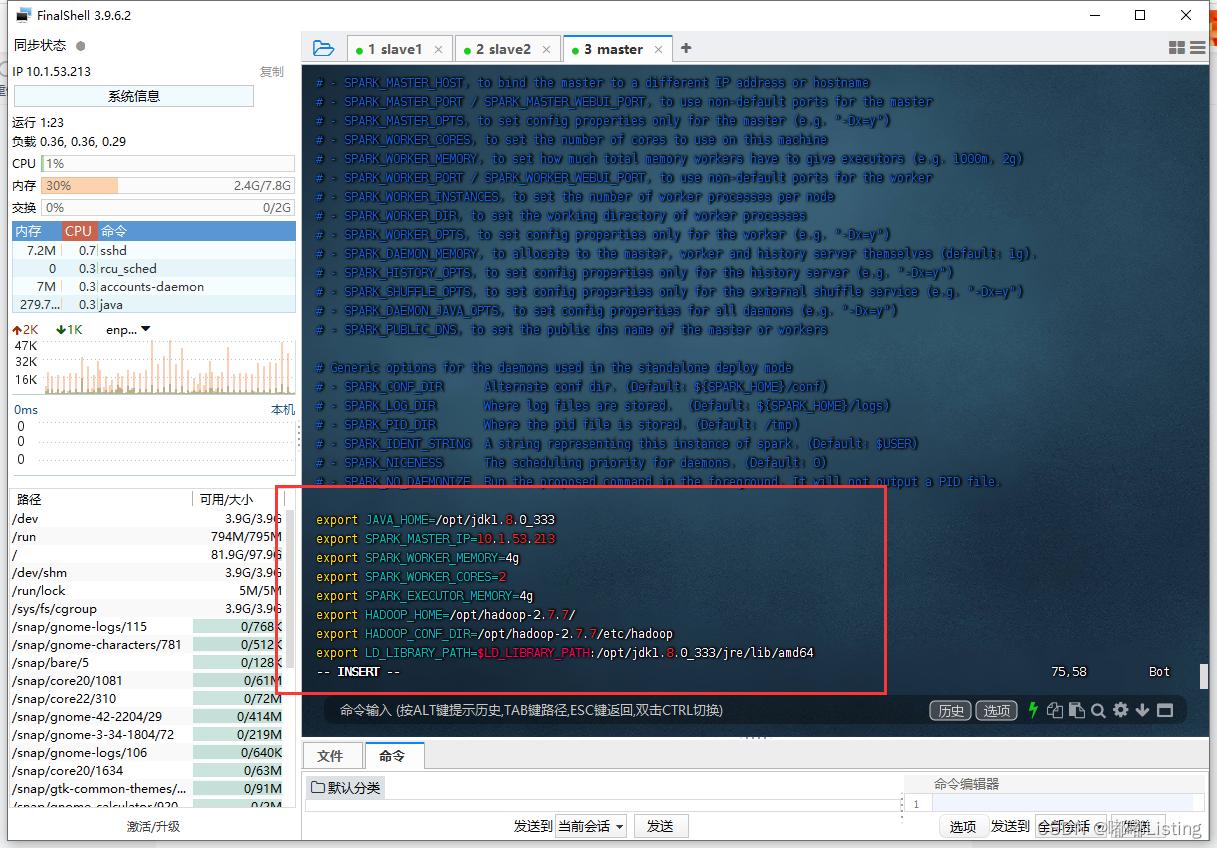

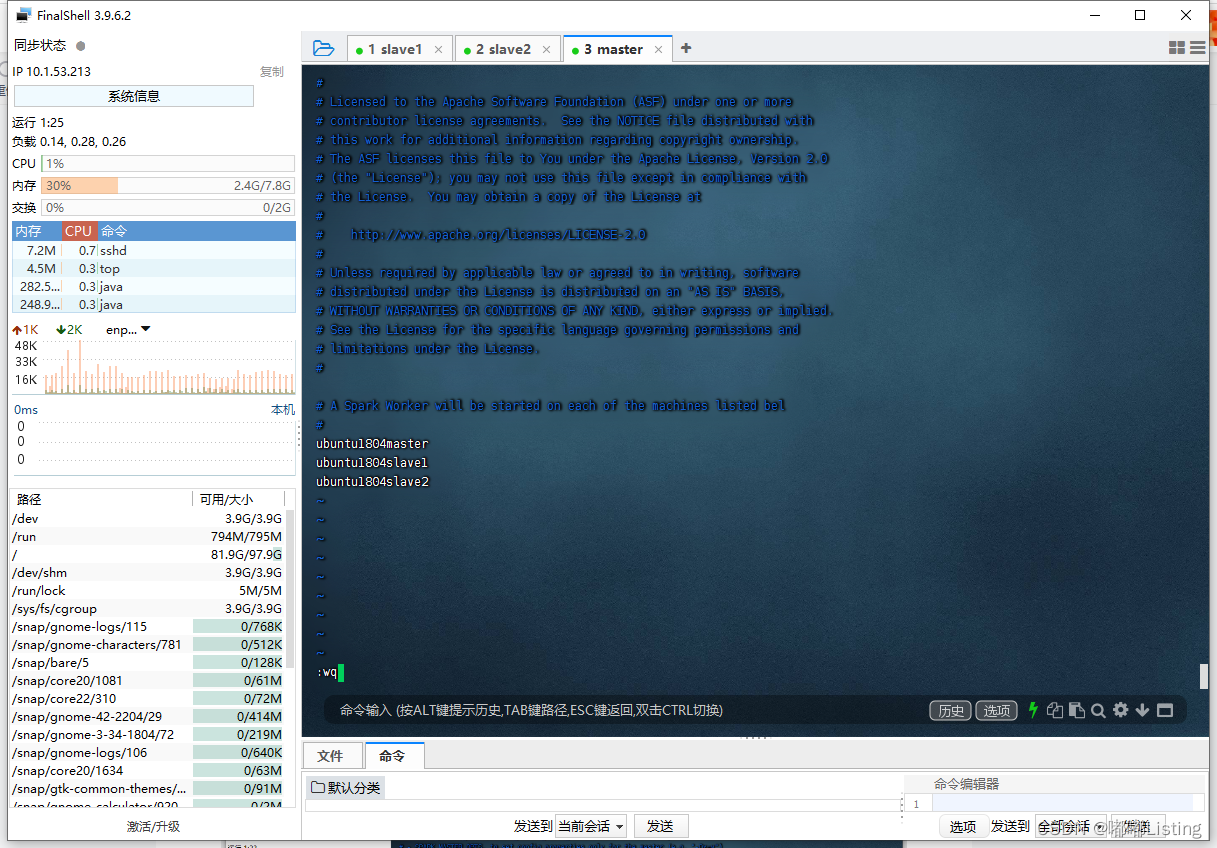

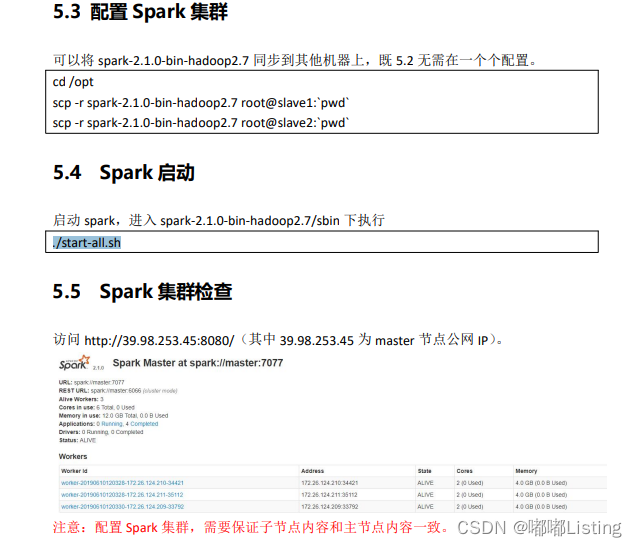

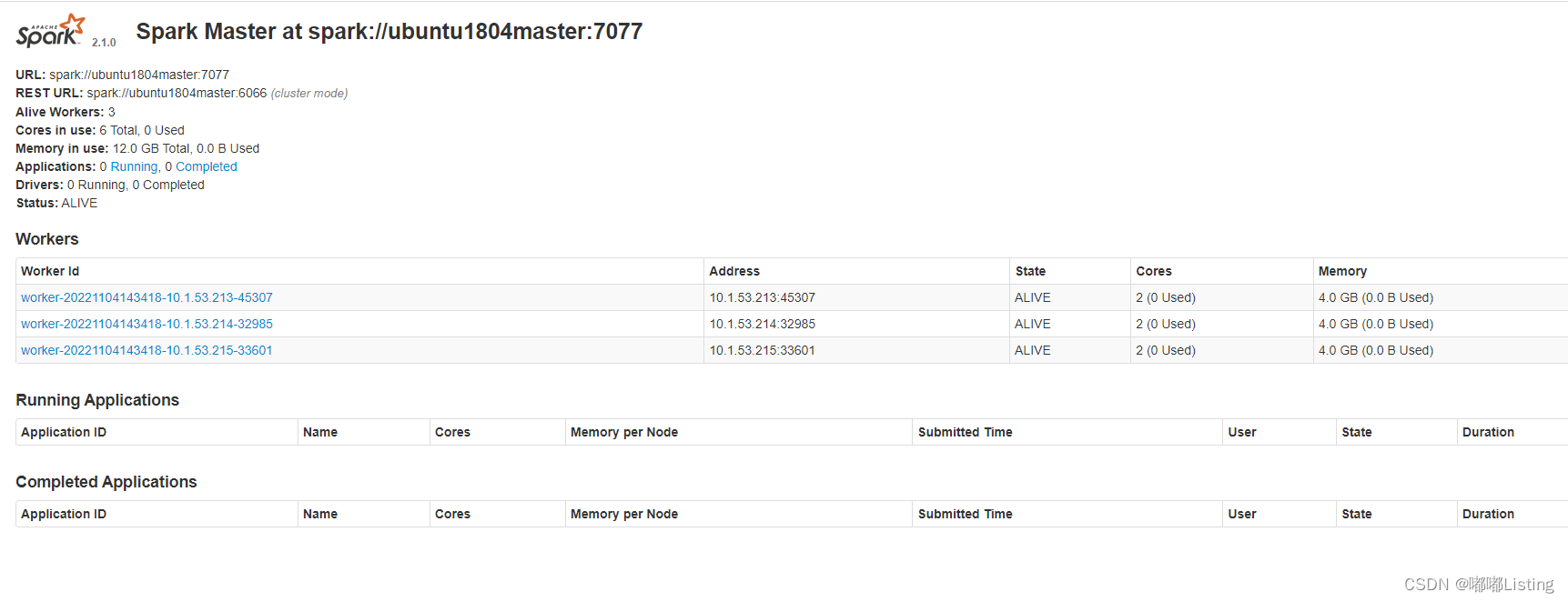

spark 部署

export java_home=/opt/jdk1.8.0_333

export spark_master_ip=10.1.53.213

export spark_worker_memory=4g

export spark_worker_cores=2

export spark_executor_memory=4g

export hadoop_home=/opt/hadoop-2.7.7/

export hadoop_conf_dir=/opt/hadoop-2.7.7/etc/hadoop

export ld_library_path=$ld_library_path:/opt/jdk1.8.0_333/jre/lib/amd64

至此, haddop、zookeeper、hbase安装成功!

发表评论