欢迎来到文思源想的ai空间,这是技术老兵重学ai以及成长思考的第13篇分享!

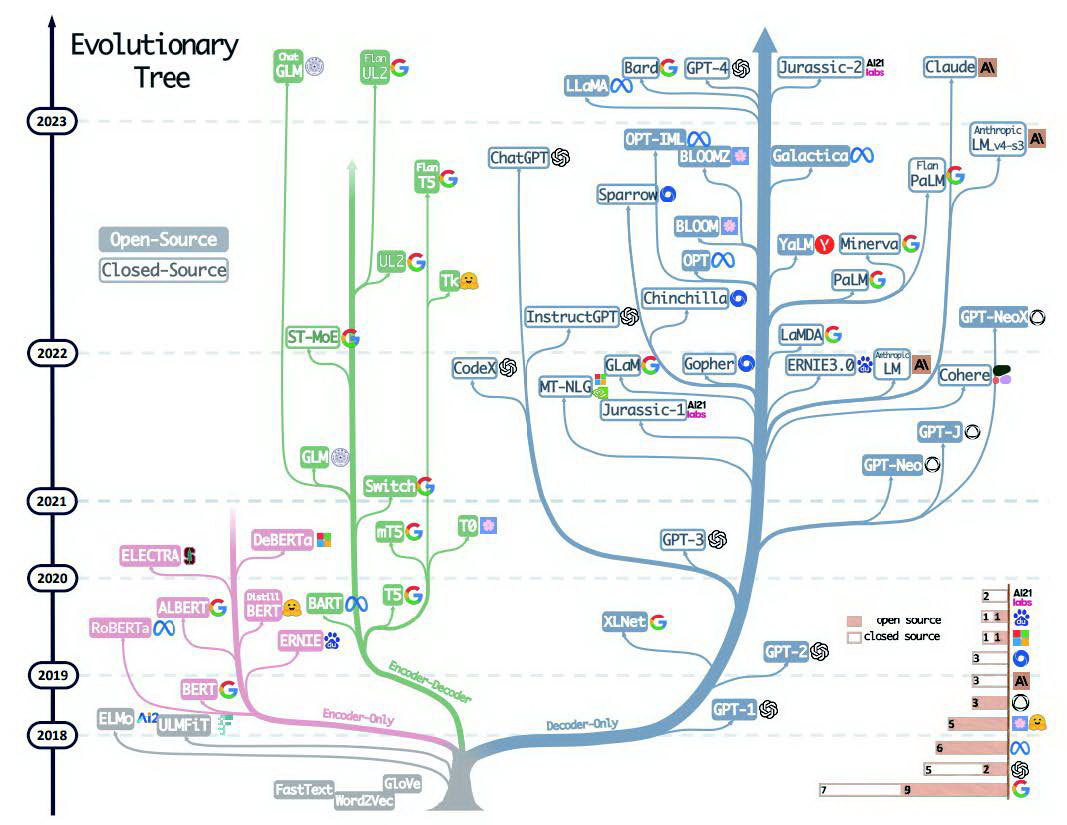

最近看完《这就是chatgpt》对于大语言模型的三种架构演进图印象颇深,今日就专题盘点一下三种大模型架构理论,同时做一个简单对比。

1 encoder-only架构

encoder-only 架构,也被称为单向架构,仅包含编码器部分。它主要适用于不需要生成序列的任务,只需要对输入进行编码和处理的单向任务场景,如文本分类、情感分析等。这种架构的代表是 bert 相关的模型,例如 bert、robert 和 albert 等。

encoder-only 架构的核心思想是利用神经网络对输入文本进行编码,提取其特征和语义信息,并将编码结果传递给后续的处理模块。这种架构的优点是能够更好地理解输入文本的语义和上下文信息,从而提高文本分类和情感分析等任务的准确性。缺点是它无法直接生成文本输出,因此在需要生成文本的任务中不太适用。

encoder-only架构的大模型有谷歌的bert、智谱ai发布的第四代基座大语言模型glm4等。其中,bert是基于encoder-only架构的预训练语言模型。glm4是智谱ai发布的第四代基座大语言模型,该模型在ifeval评测集上,在prompt提示词跟随(中文)方面,glm-4达到了gpt-4 88%的水平。

2 decoder-only架构

decoder-only 架构,也被称为生成式架构,仅包含解码器部分。它通常用于序列生成任务,如文本生成、机器翻译等。这种架构的模型适用于需要生成序列的任务,可以从输入的编码中生成相应的序列。同时,decoder-only 架构还有一个重要特点是可以进行无监督预训练。在预训练阶段,模型通过大量的无标注数据学习语言的统计模式和语义信息。

decoder-only 架构的优点是擅长创造性的写作,比如写小说或自动生成文章。它更多关注于从已有的信息(开头)扩展出新的内容。其缺点是需要大量的训练数据来提高生成文本的质量和多样性。

decoder-only架构的大模型的代表有gpt系列、llama、opt、bloom等。这类模型采用预测下一个词进行训练,常见下游任务有文本生成、问答等,因此被称为alm(autoregressive language model)。

国内采用decoder-only架构研发的大模型有妙想金融大模型、xverse-13b大模型等。其中,妙想金融大模型是东方财富旗下自主研发的金融行业大语言模型,目前已经覆盖了7b、13b、34b、66b及104b参数。而xverse-13b大模型是由前腾讯副总裁、腾讯ai lab创始人姚星创立的明星独角兽元象研发的,该模型支持40多种语言、8192上下文长度,在多项中英文测评中,性能超过了同尺寸(130亿参数)的liama2、baichuan等。

3 encoder-decoder架构

encoder-decoder 架构,也被称为序列到序列架构,同时包含编码器和解码器部分。它通常用于序列到序列(seq2seq)任务,如机器翻译、对话生成等。这种架构的代表是以 google 训练出来的 t5 为代表的相关大模型。

encoder-decoder 架构的核心思想是利用编码器对输入序列进行编码,提取其特征和语义信息,并将编码结果传递给解码器。然后,解码器根据编码结果生成相应的输出序列。这种架构的优点是能够更好地处理输入序列和输出序列之间的关系,从而提高机器翻译和对话生成等任务的准确性。缺点是模型复杂度较高,训练时间和计算资源消耗较大。

encoder-decoder架构的大模型有很多,例如google的t5模型、华为的盘古nlp大模型等。

其中,华为的盘古nlp大模型首次使用encoder-decoder架构,兼顾nlp大模型的理解能力和生成能力,保证了模型在不同系统中的嵌入灵活性。在下游应用中,仅需少量样本和可学习参数即可完成千亿规模大模型的快速微调和下游适配,这一模型在智能舆论以及智能营销方面都有不错的表现。

4 架构分析

以上三种架构各有优劣,其应用场景和前景也不尽相同。encoder-only 架构适用于文本分类和情感分析等任务,其前景主要取决于其在这些任务中的性能和准确性。decoder-only 架构适用于文本生成和机器翻译等任务,其前景主要取决于其生成文本的质量和多样性。encoder-decoder 架构适用于机器翻译和对话生成等任务,其前景主要取决于其在这些任务中的性能和准确性。

总的来说,这三种架构都有其独特的优势和应用场景,未来的发展前景也非常广阔。随着技术的不断进步和应用场景的不断拓展,这三种架构将会得到更广泛的应用和发展。

发表评论