dall·e 2

clip的一半的反过程

clip是 text–> text feature

image --> image fueture

对比找相似的,就能进行分类任务,将给定的图像与给定的text对应起来。

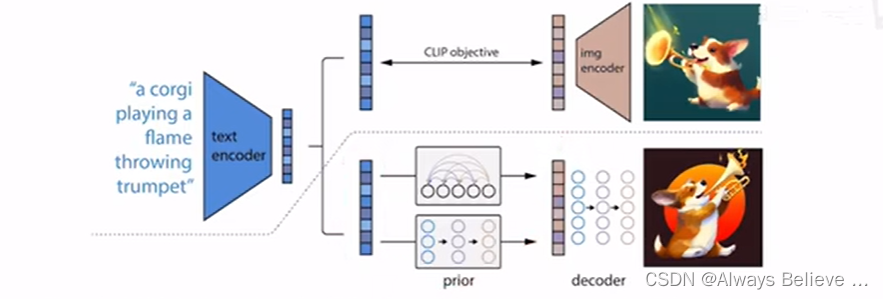

dall e2是

text – > text feature --> image feature -->(扩散模型)–> image

就能进行图像生成了,就是从text到图像。其中image feature是使用clip监督的。

dall·e2原文讨论了五六个它自己的局限性/可能的发展方向,但这不影响它很强

有意思的局限:

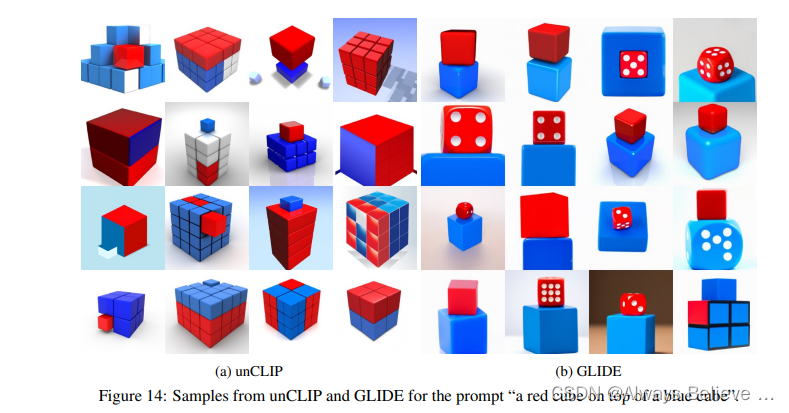

无法理解 逻辑关系,可能是因为clip就是找图片-文本对,找文字描述的具有某些物体所对应的图像,而不能理解上下左右等关系?

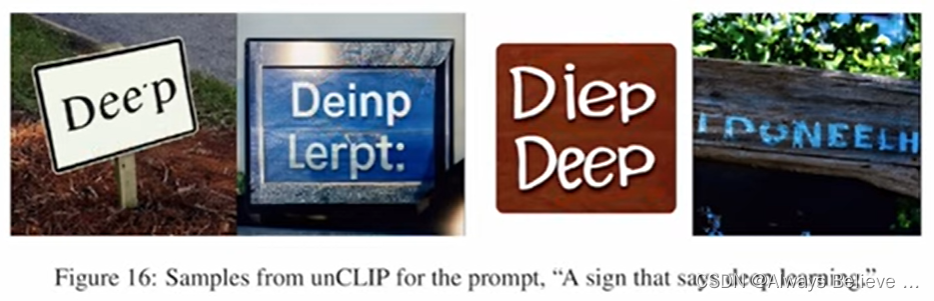

图片中的文字没有逻辑。生成的图中的文字是逻辑混乱的。

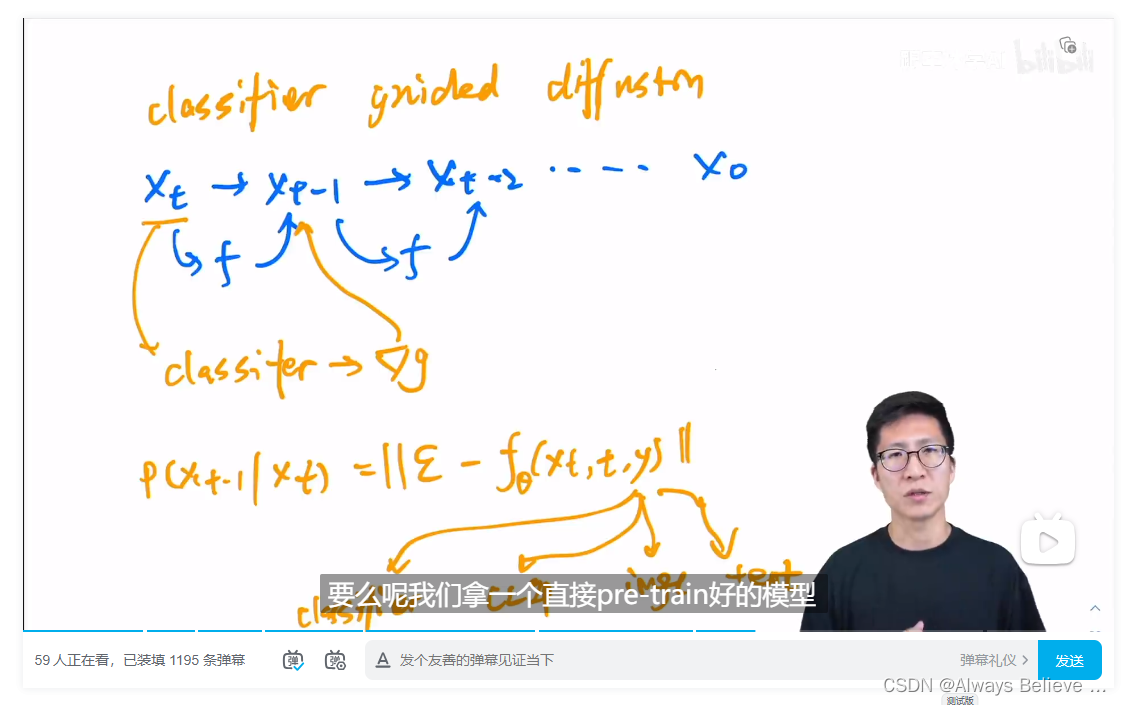

扩散模型讲解

gan:

训练不够稳定

尽可能的真实,但是多样性不高,主要是来自于噪声

不是一个概率模型(?),生成都是隐式的,不知道数据的内在分布

ae: auto-encoder

dae: denoising auto-encoder

类似的还有mae:masked auto-encoder

主要就是去学习bottleneck那个特征,拿特征图/向量去做检测分割等任务

但是这个不是随机噪声,是用来重建的一个特征,没办法做生成任务,为什么?

vae: variational auto-encoder

待仔细研读,怎么将其转化为概率模型的?

vqvae: vector quantised variational auto-encoder

diffusion model

再从噪声恢复回去,就是图像生成。

ddpm 思想类似resnet,预测噪声而不是每一步中的图像

扩散模型的分数是

inception score:

is score:

fid score:

improved ddpm

diffusion model beats gan

发表评论