概述

在深度学习领域,gpu已成为pytorch框架的核心计算引擎。无论是训练复杂神经网络还是进行模型推理,有效的gpu资源监控与管理对开发者至关重要。本文将系统介绍gpu监控的实用方法,深入分析pytorch运行时资源特性,帮助开发者优化计算性能。

一、命令行监控:nvidia-smi 专业工具

实时进程监控

通过nvidia-smi工具精准监控pytorch相关gpu活动:

nvidia-smi -l1 | grep -i python

此命令可自动筛选python进程(通常为pytorch程序)的gpu使用情况,快速定位目标进程。

进程级详细监控

查看详细显存占用情况:

nvidia-smi --query-compute-apps=pid,process_name,used_memory --format=csv -l1

此方法提供进程级详细数据,助力开发者精确分析内存使用模式。

二、windows任务管理器实战监控

gpu架构解析

- gpu0:独立显卡(高性能计算)

- gpu1:集成显卡(一般显示任务)

内存结构说明

| 内存类型 | 说明 | 特点 |

|---|---|---|

| 专用gpu内存 | 显卡自带高速显存(vram) | 高性能,优先使用 |

| 共享gpu内存 | 系统内存划分的备用空间 | 速度较慢,应急使用 |

pytorch引擎使用分析

运行pytorch时,任务管理器显示特定gpu引擎使用特征:

| 引擎类型 | 核心功能 | pytorch应用场景 |

|---|---|---|

| 3d引擎 | 图形计算 | 张量计算、前向/反向传播、优化器更新 |

| copy引擎 | 数据拷贝 | dataloader数据加载、.to(device)操作 |

| video decode | 视频解码 | 视频数据集处理(偶尔使用) |

| video encode | 视频编码 | 计算机视觉任务(偶尔使用) |

| ofa_0引擎 | ai加速 | 特定ai操作加速 |

监控重点:使用pytorch时主要关注gpu0的3d、copy引擎及专用gpu内存使用情况

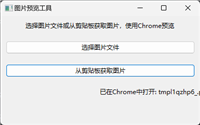

示例如下:

三、pytorch内置监控工具

实时内存监控

import torch

# 实时显存监控

current_memory = torch.cuda.memory_allocated() / 1024**2

max_memory = torch.cuda.max_memory_allocated() / 1024**2

print(f"当前显存使用: {current_memory:.2f} mb")

print(f"最大显存使用: {max_memory:.2f} mb")

# 重置统计计数

torch.cuda.reset_max_memory_allocated()高级内存分析

if torch.cuda.is_available():

stats = torch.cuda.memory_stats()

print(f"内存分配尝试次数: {stats['num_alloc_retries']}")

print(f"内存不足错误次数: {stats['num_ooms']}")四、最佳实践建议

- 定期监控:训练过程中实时关注gpu使用情况

- 性能分析:使用多种工具交叉验证监控结果

- 异常预警:设置内存使用阈值,及时发现潜在问题

- 优化策略:根据监控数据调整batch size和模型结构

总结

通过系统掌握命令行工具、任务管理器和pytorch内置监控功能,开发者可以全面了解gpu资源使用情况,及时发现内存泄漏和性能瓶颈。这些监控技能将帮助您更高效地利用gpu资源,提升深度学习项目的开发效率和运行性能。

以上就是pytorch框架下监控与管理gpu资源的使用方法的详细内容,更多关于pytorch监控与管理gpu资源的资料请关注代码网其它相关文章!

发表评论