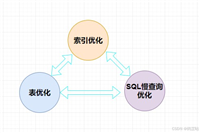

sql 优化是提升数据库查询性能的核心技能,其核心思路是 “减少数据处理量、缩短执行时间”,涵盖从表设计到 sql 语句编写、索引优化、执行计划分析等多个层面。以下从 “基础优化原则”“具体优化方向”“实战技巧” 三个维度,详解 sql 优化的完整思路。

一、sql 优化的核心原则:从 “为什么慢” 出发

查询变慢的本质通常是 **“处理的数据量过大” 或 “执行路径低效”**,优化需围绕两个核心原则:

- 减少数据扫描范围:让数据库只处理必要的数据(如通过索引定位、提前过滤)。

- 简化执行逻辑:避免复杂的关联、排序、聚合操作,或让这些操作更高效(如合理使用索引、调整关联顺序)。

二、具体优化方向与实操方法

1. 表设计优化:从源头减少性能问题

表是数据存储的基础,设计不合理会导致后续查询必然低效。

- 合理拆分大表:

- 垂直拆分:将大表按字段关联性拆分为小表(如用户表拆分为

user_base(基本信息)和user_detail(详细信息),避免查询时加载冗余字段)。 - 水平拆分:按时间、地域等维度拆分(如订单表按

order_date拆分为每月一张表,查询近 3 个月数据时仅扫描 3 个分区)。

- 垂直拆分:将大表按字段关联性拆分为小表(如用户表拆分为

- 选择合适的数据类型:

- 用

int代替varchar存储数字(如用户 id),用date/datetime存储日期(避免字符串比较)。 - 避免过度使用

text/blob(大字段会增加 i/o 开销,可单独存表)。

- 用

- 添加必要的约束:

- 主键(

primary key):确保每行唯一,数据库会自动为其创建索引,加速查询。 - 外键(

foreign key):保证关联表数据一致性,避免无效关联查询。

- 主键(

2. 索引优化:加速数据定位(最核心手段)

索引是 “数据的目录”,能让数据库跳过全表扫描,直接定位目标数据。但索引并非越多越好(会拖慢写入速度),需精准设计。

- 哪些场景需要建索引?

where子句中频繁过滤的字段(如order_status、user_id)。join关联的字段(如orders.user_id与users.id,需在两个表的关联字段上建索引)。order by/group by的字段(避免排序时全表扫描)。

- 索引设计技巧:

- 联合索引(复合索引):多字段查询时,按 “字段区分度高→低” 的顺序创建(如

where a=? and b=?,联合索引(a,b)比(b,a)更高效,因a区分度更高)。

- 联合索引(复合索引):多字段查询时,按 “字段区分度高→低” 的顺序创建(如

- 避免索引失效:

- 不在索引字段上做计算(如

where substr(phone, 1, 3) = '138'会导致索引失效,改为phone like '138%')。 - 避免

or连接非索引字段(如where a=? or b=?,若b无索引,会导致全表扫描)。 - 避免

not in/!=/is null(可能导致索引失效,改用in/=/is not null)。

- 不在索引字段上做计算(如

- 定期清理冗余索引:用工具(如 mysql 的

sys.schema_unused_indexes)识别未使用的索引,及时删除。

3. sql 语句优化:让查询更 “简洁高效”

同一份需求,不同的 sql 写法性能可能相差 10 倍以上,核心是 “让优化器看懂你的意图”。

- 简化查询逻辑:

- 避免

select *:只查询需要的字段(减少数据传输和 i/o)。 - 拆分复杂查询:将多表关联 + 聚合的复杂查询拆分为子查询或临时表,分步执行(如先过滤再关联,而非关联后过滤)。

- 避免

- 优化过滤条件:

- 优先使用

where而非having:where在数据聚合前过滤,having在聚合后过滤(如where amount>100 group by user_id比group by user_id having amount>100更高效)。 - 合理使用

limit:分页查询必须加limit,避免返回全量数据(如limit 10 offset 20)。

- 优先使用

- 优化关联查询:

- 小表驱动大表:

join时,让小表作为驱动表(如select * from 小表 join 大表 on ...,减少外层循环次数)。 - 避免笛卡尔积:确保

join有有效的on条件(无on时会产生m*n条数据,性能极差)。

- 小表驱动大表:

- 优化排序与聚合:

- 排序字段建索引:

order by的字段若有索引,可避免额外排序(using filesort)。 - 用

count(*)代替count(字段):count(*)统计行数,不忽略null,性能更优;count(字段)需过滤null,效率低。

- 排序字段建索引:

4. 执行计划分析:定位低效瓶颈

数据库的 “执行计划” 是优化的 “导航图”,能显示查询的执行步骤(如是否用索引、关联方式、排序方式等)。

- 如何查看执行计划?

- mysql:

explain + sql语句(如explain select * from orders where user_id=1;)。 - postgresql:

explain analyze + sql语句(更详细,包含实际执行时间)。 - sql server:通过 “包括实际执行计划” 按钮或

set statistics profile on。

- mysql:

- 关键指标解读:

- type(mysql):表示访问类型,从优到差为

system > const > eq_ref > ref > range > index > all。all表示全表扫描,需优化(通常是缺少索引)。

- type(mysql):表示访问类型,从优到差为

- extra(mysql):

using index:使用覆盖索引(无需回表查数据),性能优。using filesort:需额外排序(未用到索引排序),需优化order by字段的索引。using temporary:使用临时表(如group by无索引),需优化group by字段。

5. 数据库配置与硬件优化:提供支撑

- 调整数据库参数:

- 增大

innodb_buffer_pool_size(mysql):让更多数据缓存到内存,减少磁盘 i/o(建议设为物理内存的 50%-70%)。 - 调整

join_buffer_size:优化多表关联的缓存(过大可能浪费内存)。

- 增大

- 硬件与存储优化:

- 使用 ssd 代替 hdd:提升磁盘读写速度(随机 i/o 性能提升 10 倍以上)。

- 增加内存:减少磁盘交换(内存访问速度远快于磁盘)。

三、实战优化案例:从慢查询到高效查询

案例 1:未加索引导致全表扫描

慢查询:

-- 查询用户id=100的所有订单(orders表有100万行,无user_id索引) select * from orders where user_id = 100;

问题:type=all(全表扫描),需遍历 100 万行。

优化:在user_id上建索引:

create index idx_orders_user_id on orders(user_id);

优化后:type=ref(使用索引定位),扫描行数从 100 万→几十行。

案例 2:select *与冗余字段

慢查询:

-- 查询订单时返回所有字段(包括大字段detail_text) select * from orders where order_id = 500;

问题:detail_text是text类型,占用大量 i/o 和内存。

优化:只查询需要的字段:

select order_id, user_id, amount, order_date from orders where order_id = 500;

优化后:数据传输量减少 80%,查询时间缩短。

案例 3:复杂关联未优化

慢查询:

-- 多表关联未加索引,且先关联后过滤 select u.name, o.amount from users u join orders o on u.id = o.user_id join order_details d on o.id = d.order_id where o.order_date >= '2023-01-01' and d.quantity > 5;

问题:orders和order_details未在关联字段和过滤字段上建索引,导致全表关联后过滤。

优化:

- 在

orders.user_id、order_details.order_id上建关联索引。 - 在

orders.order_date、order_details.quantity上建过滤索引。 - 调整逻辑:先过滤

orders和order_details,再关联:

select u.name, o.amount from users u join (select * from orders where order_date >= '2023-01-01') o on u.id = o.user_id join (select * from order_details where quantity > 5) d on o.id = d.order_id;

优化后:关联的数据量减少 90%,执行时间从 10 秒→0.5 秒。

四、总结:sql 优化的 “黄金流程”

- 监控慢查询:开启数据库慢查询日志(如 mysql 的

slow_query_log),收集执行时间超过阈值的 sql。 - 分析执行计划:对慢查询用

explain查看执行计划,定位瓶颈(如全表扫描、无索引排序)。 - 针对性优化:

- 缺索引则补索引,冗余索引则删除。

- 语句不合理则重构(如拆分查询、避免

select *)。 - 表设计问题则考虑拆分或调整字段类型。

- 验证效果:优化后重新执行,对比执行时间和扫描行数,确保性能提升。

sql 优化的核心不是 “记住规则”,而是 “理解原理”—— 知道每一步操作的开销(如全表扫描 vs 索引查找、内存排序 vs 磁盘排序),才能写出高效的 sql。同时,优化需平衡 “查询性能” 和 “写入性能”(索引会拖慢插入 / 更新),根据业务场景(读多写少 vs 写多读少)灵活调整。

到此这篇关于sql从慢查询到高效查询实战优化案例的文章就介绍到这了,更多相关sql从慢查询到高效查询内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论