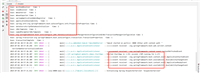

1. 使用正则表达式(简单场景)

适用于简单的 html 标签识别和提取:

import java.util.regex.matcher;

import java.util.regex.pattern;

public class htmltagextractor {

public static void main(string[] args) {

string html = "<div><p>hello <b>world</b></p><a href='example.com'>link</a></div>";

// 匹配所有标签

pattern tagpattern = pattern.compile("<[^>]+>");

matcher tagmatcher = tagpattern.matcher(html);

system.out.println("所有html标签:");

while (tagmatcher.find()) {

system.out.println(tagmatcher.group());

}

// 匹配特定标签(如<a>标签)

pattern atagpattern = pattern.compile("<a\\b[^>]*>(.*?)</a>");

matcher atagmatcher = atagpattern.matcher(html);

system.out.println("\n所有<a>标签:");

while (atagmatcher.find()) {

system.out.println("完整标签: " + atagmatcher.group(0));

system.out.println("标签内容: " + atagmatcher.group(1));

}

// 匹配标签属性

pattern attrpattern = pattern.compile("\\b(href|src)=['\"]([^'\"]*)['\"]");

matcher attrmatcher = attrpattern.matcher(html);

system.out.println("\n所有href/src属性:");

while (attrmatcher.find()) {

system.out.println(attrmatcher.group(1) + " = " + attrmatcher.group(2));

}

}

}注意:正则表达式不适合处理复杂的、嵌套的 html 结构。

2. 使用 jsoup(推荐)

jsoup 是一个强大的 java html 解析库:

import org.jsoup.jsoup;

import org.jsoup.nodes.document;

import org.jsoup.nodes.element;

import org.jsoup.select.elements;

public class jsoupexample {

public static void main(string[] args) {

string html = "<html><head><title>sample</title></head>"

+ "<body><div id='content'><p class='text'>first paragraph</p>"

+ "<p>second <b>paragraph</b></p><a href='example.com'>link</a></div></body></html>";

// 解析html

document doc = jsoup.parse(html);

// 获取标题

system.out.println("标题: " + doc.title());

// 获取所有段落

elements paragraphs = doc.select("p");

system.out.println("\n所有段落:");

for (element p : paragraphs) {

system.out.println(p.text());

}

// 获取特定id的元素

element contentdiv = doc.getelementbyid("content");

system.out.println("\nid为content的div:");

system.out.println(contentdiv.html());

// 获取特定class的元素

elements textelements = doc.getelementsbyclass("text");

system.out.println("\nclass为text的元素:");

for (element el : textelements) {

system.out.println(el.text());

}

// 获取所有链接

elements links = doc.select("a[href]");

system.out.println("\n所有链接:");

for (element link : links) {

system.out.println("文本: " + link.text() + ", 链接: " + link.attr("href"));

}

// 获取元素的父级和子级

element firstp = paragraphs.first();

system.out.println("\n第一个段落的父元素: " + firstp.parent().tagname());

system.out.println("第一个段落的子元素数量: " + firstp.children().size());

}

}3. 使用 jdk 内置的 xml 解析器(适用于 xhtml)

对于格式良好的 xhtml,可以使用 jdk 内置的 xml 解析器:

import javax.xml.parsers.documentbuilder;

import javax.xml.parsers.documentbuilderfactory;

import org.w3c.dom.document;

import org.w3c.dom.nodelist;

public class xmlparserexample {

public static void main(string[] args) throws exception {

string xhtml = "<html><body><p>paragraph 1</p><p>paragraph 2</p></body></html>";

documentbuilderfactory factory = documentbuilderfactory.newinstance();

documentbuilder builder = factory.newdocumentbuilder();

document doc = builder.parse(new inputsource(new stringreader(xhtml)));

// 获取所有段落

nodelist paragraphs = doc.getelementsbytagname("p");

system.out.println("找到 " + paragraphs.getlength() + " 个段落:");

for (int i = 0; i < paragraphs.getlength(); i++) {

system.out.println(paragraphs.item(i).gettextcontent());

}

}

}4. 使用 htmlcleaner

htmlcleaner 是另一个轻量级的 html 解析库:

import org.htmlcleaner.htmlcleaner;

import org.htmlcleaner.tagnode;

public class htmlcleanerexample {

public static void main(string[] args) throws exception {

string html = "<html><body><div><p>hello</p><p>world</p></div></body></html>";

htmlcleaner cleaner = new htmlcleaner();

tagnode rootnode = cleaner.clean(html);

// 获取所有段落

tagnode[] paragraphs = rootnode.getelementsbyname("p", true);

system.out.println("找到 " + paragraphs.length + " 个段落:");

for (tagnode p : paragraphs) {

system.out.println(p.gettext().tostring());

}

}

}5. 处理 html 文本(去除标签)

如果只需要提取文本内容而不需要标签结构:

import org.jsoup.jsoup;

public class htmltextextractor {

public static void main(string[] args) {

string html = "<div><p>hello <b>world</b></p><a href='example.com'>link</a></div>";

// 使用jsoup提取文本

string text = jsoup.parse(html).text();

system.out.println("纯文本内容:\n" + text);

// 简单正则方法去除标签(不推荐用于复杂html)

string textonly = html.replaceall("<[^>]+>", "");

system.out.println("\n简单去除标签后的文本:\n" + textonly);

}

}最佳实践建议

- 推荐使用 jsoup:它功能强大、api友好,适合大多数html处理场景

- 避免使用正则处理复杂html:正则表达式难以正确处理嵌套标签和格式不规范的html

- 注意html清理:当处理用户输入的html时,应该清理潜在的恶意内容

- 考虑性能:对于大量html处理,jsoup的性能通常足够好

- 处理编码问题:确保正确处理html文档的字符编码

安全注意事项

当处理用户提供的html内容时,务必考虑安全风险:

import org.jsoup.jsoup;

import org.jsoup.safety.safelist;

public class htmlsanitizer {

public static void main(string[] args) {

string unsafehtml = "<div onclick='alert(\"xss\")'>hello<script>alert('xss')</script><a href='javascript:alert(1)'>link</a></div>";

// 基本清理,只允许文本

string safetext = jsoup.clean(unsafehtml, safelist.none());

system.out.println("仅文本:\n" + safetext);

// 允许基本格式和安全的链接

string basichtml = jsoup.clean(unsafehtml, safelist.basic());

system.out.println("\n基本html:\n" + basichtml);

// 自定义白名单

safelist customlist = safelist.basic()

.addtags("div", "span")

.addattributes("div", "class");

string customclean = jsoup.clean(unsafehtml, customlist);

system.out.println("\n自定义清理:\n" + customclean);

}

}到此这篇关于java识别和处理html标签内容的常用方法的文章就介绍到这了,更多相关java识别和处理html内容内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论