机器人精准抓取透明物体难题攻克!仅需单张图像,单目视觉即可实现!

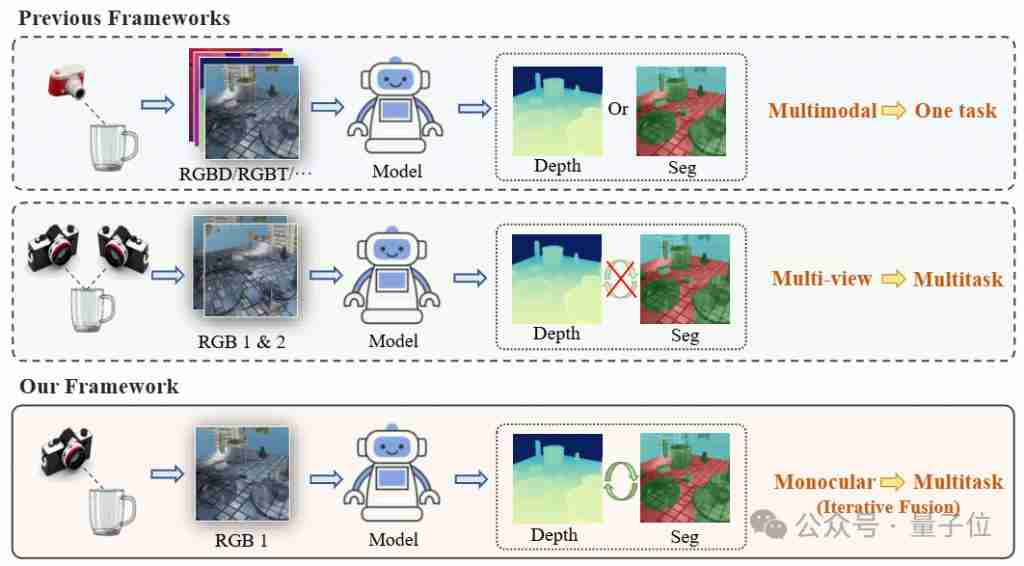

这项突破性成果由地瓜机器人和中科院自动化所等单位合作完成,其核心是名为modest的新型算法框架。该框架是一个多任务模型,能够同时进行透明物体的深度估计和语义分割。

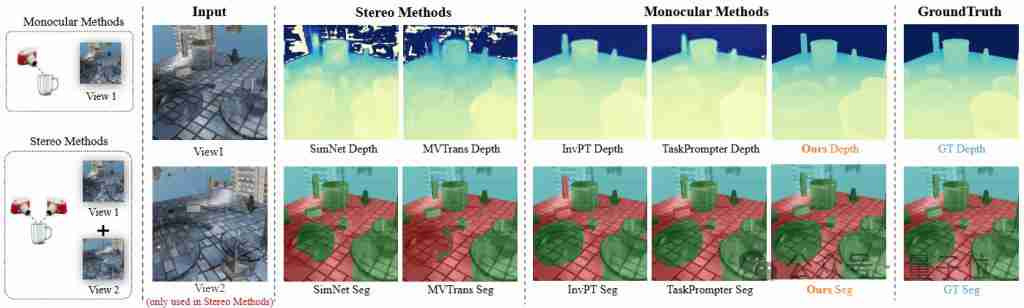

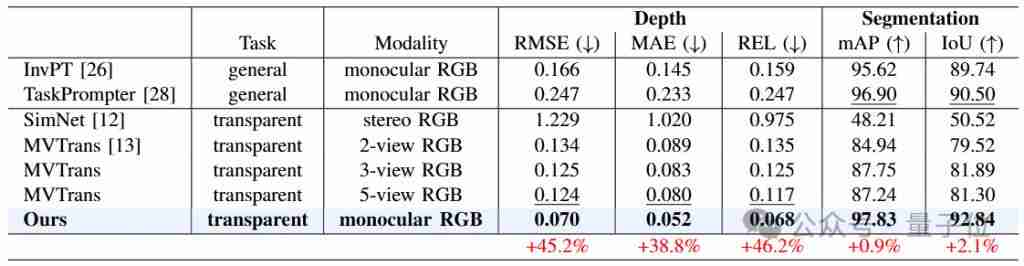

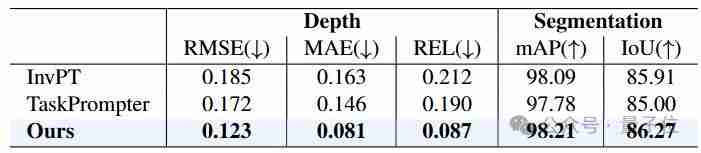

modest作为通用抓取模型的前端模块,无需额外传感器,即可高效、灵活地实现透明物体的抓取。相比其他双目或多视图方法,其效果更佳。

这项技术可广泛应用于智能制造、实验室自动化和智慧家居等领域,显著提升机器人操作透明物体的能力,并降低设备成本。modest已入选icra 2025(ieee机器人与自动化国际会议)。

挑战与突破

透明物体抓取的难点在于获取其准确的深度信息。传统方法依赖深度传感器或多视角重建,成本高且效率低。透明物体的折射和反射特性,以及在图像中缺乏清晰纹理等问题,都增加了感知难度。

modest框架创新性地解决了这些问题,它通过结合语义和几何信息的多任务框架,准确获取透明物体的深度信息,并结合点云抓取网络实现抓取。

算法详解

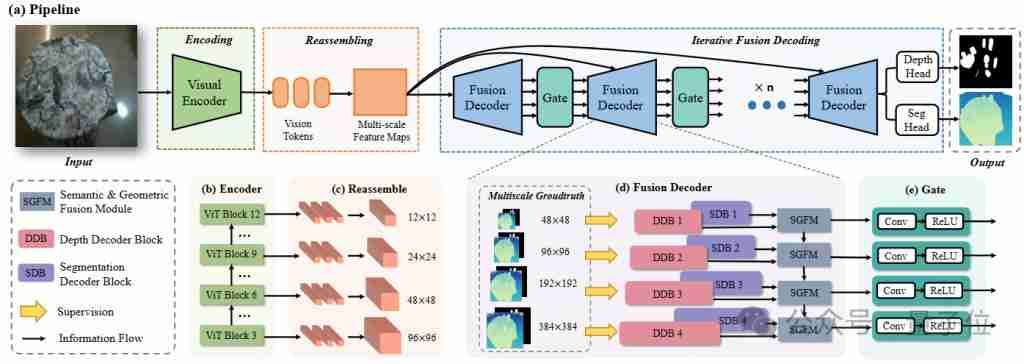

modest模型以单目rgb图像为输入,输出透明物体的分割结果和场景深度预测。其核心由编码、重组、语义几何融合和迭代解码四个模块构成。

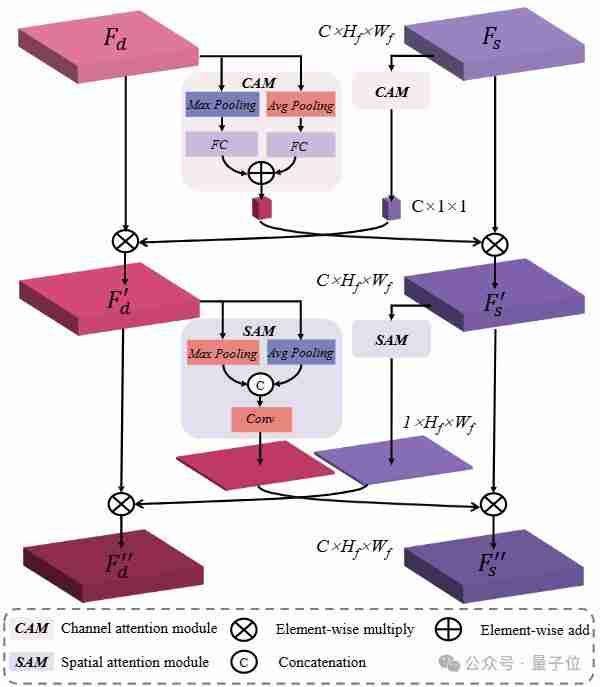

基于注意力机制的语义几何融合模块,充分利用语义分割和深度估计任务间的互补信息,提升了整体性能。 此外,受人眼视觉启发,modest采用由粗到细的特征更新策略,进一步提高了预测精度。

实验结果

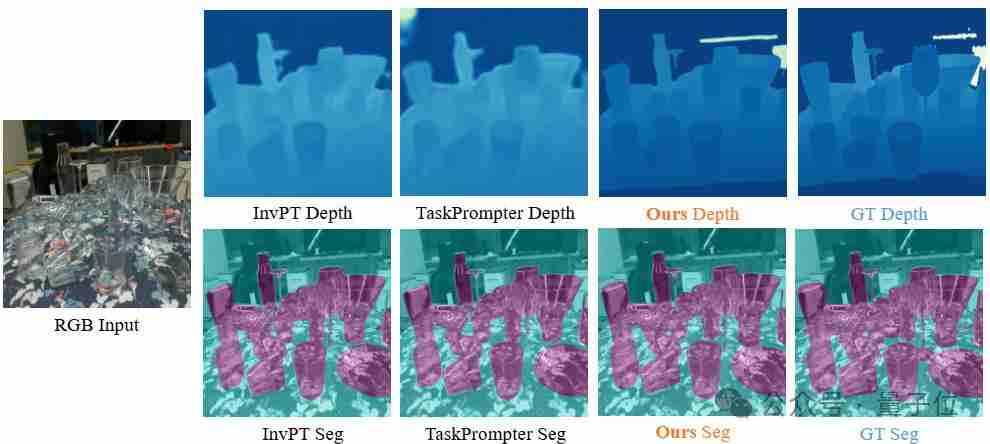

在syn-todd和clearpose两个公开数据集上的实验表明,modest在深度估计和语义分割方面均显著优于其他先进方法,即使在人眼难以判断的场景下也能产生清晰的预测结果。

真实机器人平台的抓取实验也验证了modest的鲁棒性和泛化性。

其他成果及资源

除了modest,地瓜机器人研发的dosod开放词汇目标检测算法也入选icra 2025。 感兴趣的读者可访问以下链接了解更多信息:

modest文章地址:https://www.php.cn/link/6b45cf467a9c88001159a826e92c7437 modest代码地址:https://www.php.cn/link/6b45cf467a9c88001159a826e92c7437 dosod文章地址:https://www.php.cn/link/6b45cf467a9c88001159a826e92c7437 dosod代码地址:https://www.php.cn/link/6b45cf467a9c88001159a826e92c7437

以上就是透明物体也能被机器人抓起来了,单目的那种的详细内容,更多请关注代码网其它相关文章!

发表评论