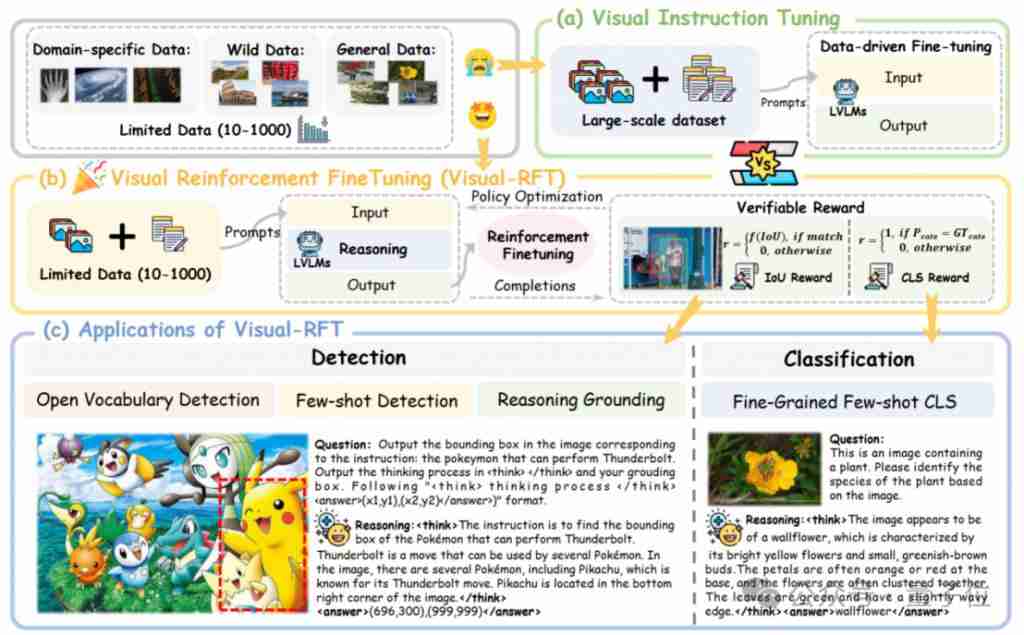

上海交大、上海ai lab和港中文大学的研究人员推出visual-rft(视觉强化微调)开源项目,该项目仅需少量数据即可显著提升视觉语言大模型(lvlm)性能。visual-rft巧妙地将deepseek-r1的基于规则奖励的强化学习方法与openai的强化微调(rft)范式相结合,成功地将这一方法从文本领域扩展到视觉领域。

通过为视觉细分类、目标检测等任务设计相应的规则奖励,visual-rft克服了deepseek-r1方法仅限于文本、数学推理等领域的局限性,为lvlm训练提供了新的途径。

visual-rft的优势:

与传统的视觉指令微调(sft)方法相比,visual-rft具有以下显著优势:

- 少样本学习能力: 仅需10到1000条数据即可实现有效微调。

- 更强的泛化性: 在数据有限的场景下,性能优于sft。

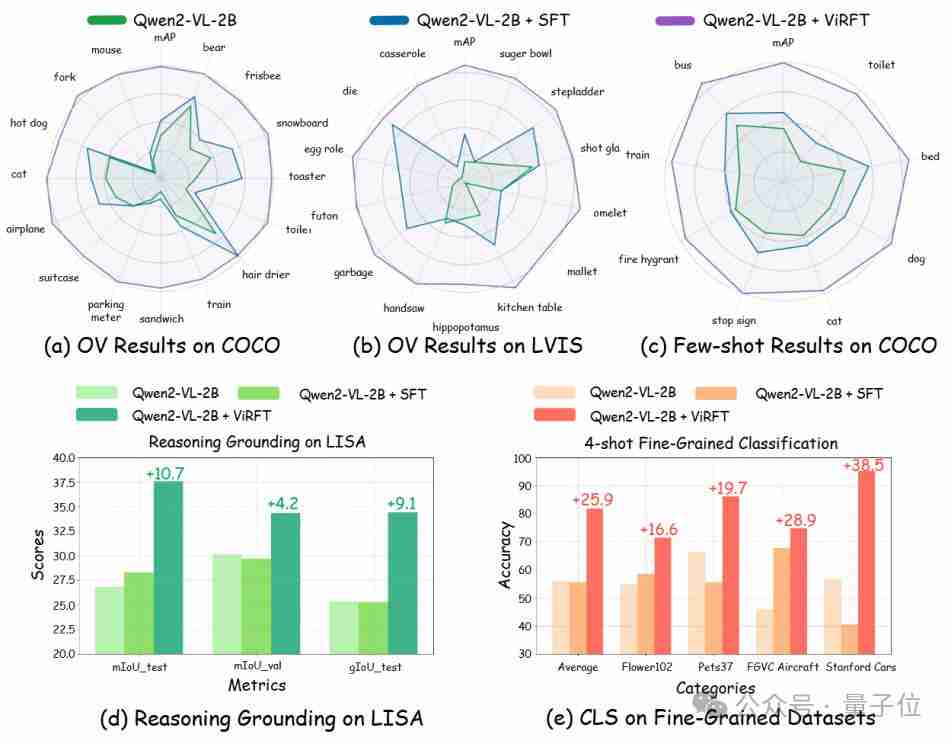

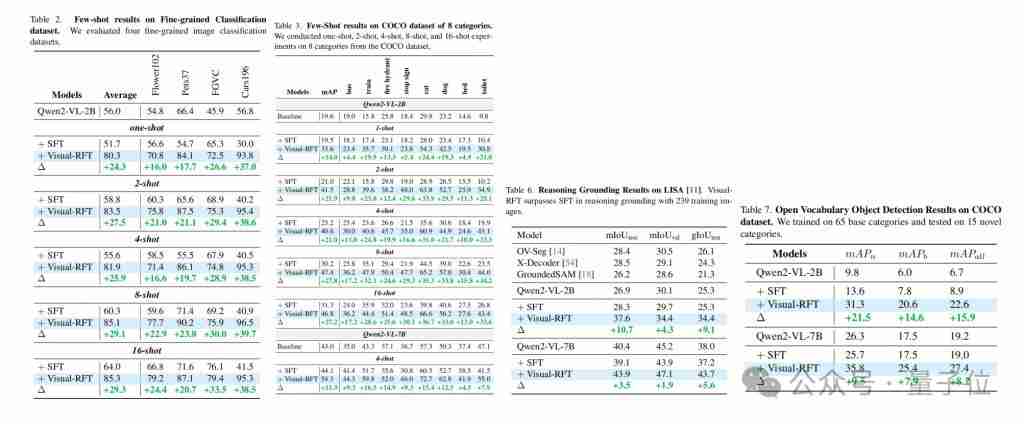

研究人员在多个视觉感知任务(检测、分类、定位等)上对visual-rft进行了验证,结果表明,即使在开放词汇和少样本学习的设定下,visual-rft也能取得显著的性能提升,轻松实现能力迁移。

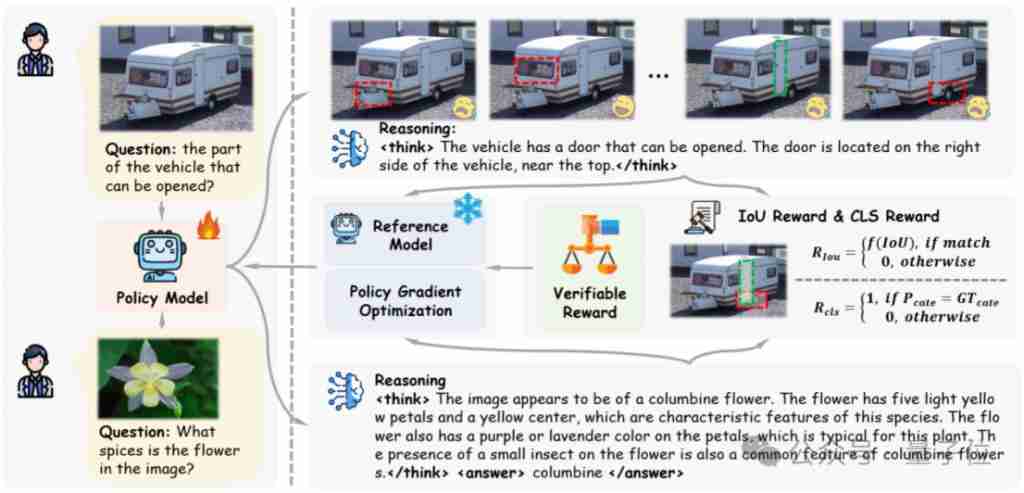

研究人员针对不同的任务设计了相应的可验证奖励:基于iou的奖励用于检测和定位任务,基于分类正确性的奖励用于分类任务。

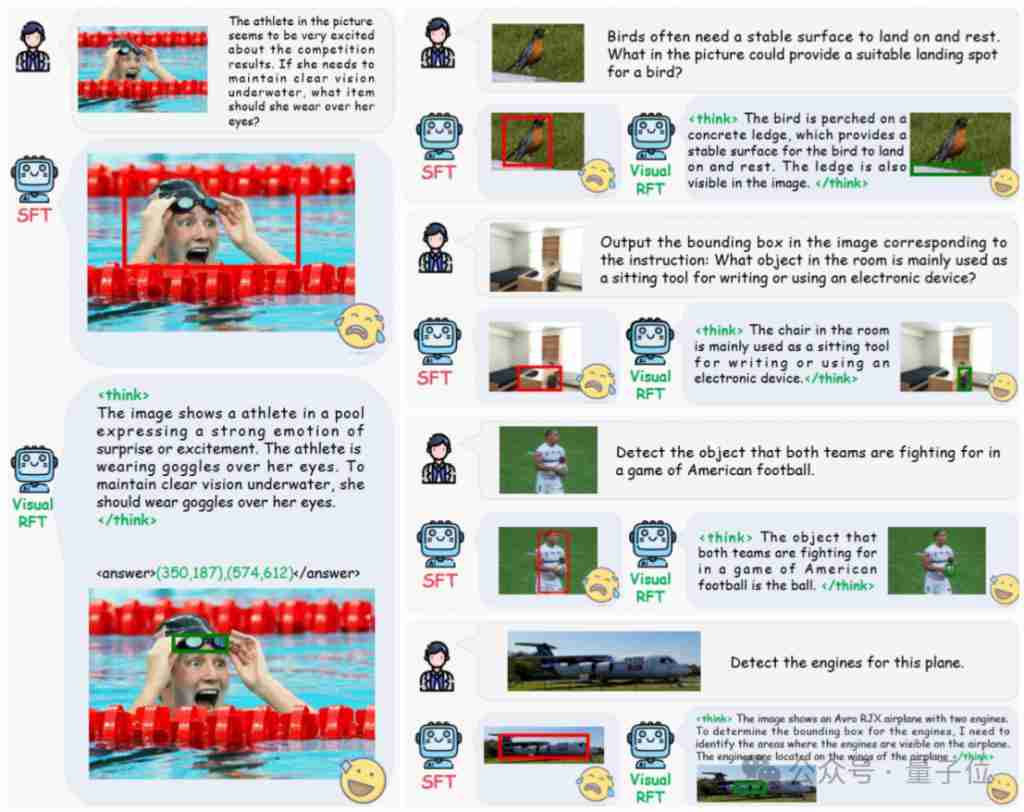

在推理定位任务中,visual-rft展现出强大的视觉推理能力,例如,准确识别图片中运动员需要佩戴的防水眼镜。

实验结果:

基于qwen2-vl 2b/7b模型进行的实验表明,visual-rft在开放目标检测、少样本检测、细粒度分类和推理定位任务上均优于sft。 即使是检测特定动漫角色(例如史莱姆),visual-rft也只需少量数据即可实现。

开源信息:

visual-rft项目已开源,包含训练、评测代码和数据。

项目地址:https://www.php.cn/link/b2c1a4c8e4f9c3f8efe19a903a005149

以上就是显著超越 sft,o1/deepseek-r1 背后秘诀也能用于多模态大模型了的详细内容,更多请关注代码网其它相关文章!

发表评论