pdf(可移植文档格式)文件是由adobe创建的一种灵活的文件格式,它允许文档在不同的软件、硬件和操作系统中一致地显示。每个pdf文件都包含对固定布局文档的全面描述,包括文本、字体、图形和其他必要的显示元素。pdf通常用于文档共享,因为它们能够保持原始格式。然而,以编程方式解析和解释pdf内容可能是一项挑战。这些困难包括pdf的复杂结构、不同的文本编码、复杂的布局、压缩的内容和嵌入的字体等问题。

我们最近评估了几个流行的python pdf库,如pypdf/pypdf2, pdfminer.six, pymupdf, pdfplumber2,等。有些库适合提取文本,有些适合提取图像,有些速度很快,等等。在本文中,我们将重点介绍如何开始使用pdfminer.six。最新信息请随时关注官方网站。

环境准备

安装依赖包:

pip install pdfminer.six pip install 'pdfminer.six[image]'

示例pdf文件可以在这里找到,当然你也可以自己准备。让我们看看如何使用这些api:

从pdf中提取文本

从pdf中提取图像

迭代pdf中的所有对象

从pdf中提取tableofcontent (toc)

抽取文本

通过高级api可用于从pdf中提取文本。

from pdfminer.high_level import extract_text from os import path path = path.abspath(path.dirname(__file__)) print(path) pdf_file = path + '/sample01.pdf' text = extract_text(pdf_file) print(text)

抽取每一页

from io import stringio

from pdfminer.converter import textconverter

from pdfminer.layout import laparams

from pdfminer.pdfinterp import pdfresourcemanager, pdfpageinterpreter

from pdfminer.pdfpage import pdfpage

from pdfminer.utils import open_filename

from os import path

path = path.abspath(path.dirname(__file__))

print(path)

def iter_text_per_page(pdf_file, password='', page_numbers=none, maxpages=0,

caching=true, codec='utf-8', laparams=none):

if laparams is none:

laparams = laparams()

with open_filename(pdf_file, "rb") as fp:

rsrcmgr = pdfresourcemanager(caching=caching)

idx = 1

for page in pdfpage.get_pages(

fp,

page_numbers,

maxpages=maxpages,

password=password,

caching=caching,

):

with stringio() as output_string:

device = textconverter(rsrcmgr, output_string, codec=codec,

laparams=laparams)

interpreter = pdfpageinterpreter(rsrcmgr, device)

interpreter.process_page(page)

yield idx, output_string.getvalue()

idx += 1

def main():

pdf_file = path + '/sample02.pdf'

for count, page_text in iter_text_per_page(pdf_file):

print(f'page# {count}:\n{page_text}')

print()

if __name__ == "__main__":

main()

输出内容截取如下:

page# 1:

产品主要功能包括数据采集、数据治理以及数据产品应用。企业典型应用场景利用 ai 算法实现业务分类、聚类、回归预测以及时间序列预测等。在销售领域基于历史数据实现销售预测,基于用户特征数据对客户分类实现精准营销;在采购领域利用历史数据预测采购价格,基于多维度指标实现供应商综合评价模型等。

page# 2:

各类政策法规进行整理和归纳,帮助用户更加方便快捷地获取所需的政策信息。。。。

抽取图像

提取图像的最简单方法是调用命令行工具pdf2txt.py。它是在安装pdfminer时安装的,并且位于python可执行文件的相同位置。使用的操作系统。可执行文件’查找python二进制文件的位置。

下面是示例用法:

usage: pdf2txt.py [-h] [--version] [--debug] [--disable-caching] [--page-numbers page_numbers [page_numbers ...]]

[--pagenos pagenos] [--maxpages maxpages] [--password password] [--rotation rotation] [--no-laparams]

[--detect-vertical] [--line-overlap line_overlap] [--char-margin char_margin] [--word-margin word_margin]

[--line-margin line_margin] [--boxes-flow boxes_flow] [--all-texts] [--outfile outfile]

[--output_type output_type] [--codec codec] [--output-dir output_dir] [--layoutmode layoutmode]

[--scale scale] [--strip-control]

files [files ...]

to extract all text from pdf:

pdf2txt.py --all-texts ../samples/manual.pdf

to extract all images from pdf:

pdf2txt.py --output-dir images ../sample03.pdf

如果希望将其集成到应用程序中,只需从pdf2txt.py复制源代码即可.

获取页数

from pdfminer.pdfdocument import pdfdocument

from pdfminer.pdfparser import pdfparser

from pdfminer.pdftypes import resolve1

pdf_file = '../samples/brocher1.pdf'

with open(pdf_file, 'rb') as f:

parser = pdfparser(f)

doc = pdfdocument(parser)

parser.set_document(doc)

pages = resolve1(doc.catalog['pages'])

pages_count = pages.get('count', 0)

print(pages_count)

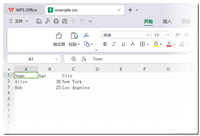

抽取表格数据

pdfminer抽取表格的输出看起来比pypdf2好得多,我们可以很容易地使用regex或split()提取所需的数据。但是在现实世界中,pdf文档包含很多噪声,id可以是不同的格式等等。我无法想象一个算法会考虑所有的事情。为了简化和加快我们的工作,我建议将pdf文件转换为html格式:

from io import stringio

from pdfminer.high_level import extract_text_to_fp

from pdfminer.layout import laparams

output = stringio()

with open('example.pdf', 'rb') as pdf_file:

extract_text_to_fp(pdf_file, output, laparams=laparams(), output_type='html', codec=none)

with open('example.html', 'a') as html_file:

html_file.write(output.getvalue())

然后再利用html标签处理库抽取文本,这种方法准确率应该能得到保障。

到此这篇关于python使用pdfminer.six解析pdf数据详解的文章就介绍到这了,更多相关python解析pdf内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论