在现代计算任务中,尤其是在深度学习、图像处理和科学计算等领域,gpu(图形处理单元)已经成为不可或缺的加速工具。与传统的 cpu 计算相比,gpu 能够显著提升计算效率,尤其是在处理并行任务时。本文将详细介绍如何在 python 中调用 gpu 算力的基本步骤。

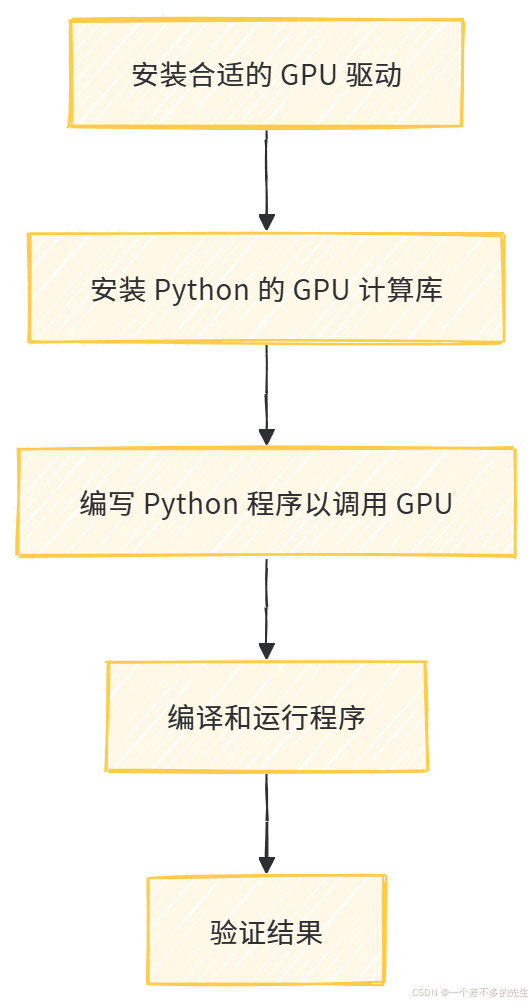

流程概述

以下是实现 python 调用 gpu 算力的基本步骤:

| 步骤 | 描述 |

|---|---|

| 1 | 安装合适的 gpu 驱动 |

| 2 | 安装 python 的 gpu 计算库 |

| 3 | 编写 python 程序以调用 gpu |

| 4 | 编译和运行程序 |

| 5 | 验证结果 |

流程图

每一步的详细操作

步骤 1: 安装合适的 gpu 驱动

在调用 gpu 算力之前,确保你的系统已经安装了合适的 gpu 驱动。对于 nvidia gpu,建议从 nvidia 官网下载并安装最新的驱动程序。驱动程序的版本需要与你的 gpu 和后续使用的 cuda 版本兼容。

步骤 2: 安装 python 的 gpu 计算库

在 python 中,常用的 gpu 计算库有 cuda 和 cudnn(用于深度学习),以及 opencl(适用于非 nvidia gpu)。对于 nvidia gpu,cuda 是最常用的选择。以下以 cuda 为例,介绍如何安装相关库。

安装 cuda toolkit从 nvidia cuda 官网下载并安装 cuda toolkit。确保选择与你的 gpu 驱动和操作系统版本兼容的版本。

安装 cudnn如果你计划进行深度学习任务,还需要安装 cudnn。cudnn 是 nvidia 提供的深度神经网络加速库,可以从 nvidia cudnn 官网下载。

安装 python 的 cuda 绑定库在 python 中,

cupy和torch是两个常用的库,分别用于通用计算和深度学习。以下以cupy为例,展示如何安装:pip install cupy-cudaxx # 替换 xx 为你的 cuda 版本号,例如 cupy-cuda113

步骤 3: 编写 python 程序以调用 gpu

以下是一个简单的示例,展示如何使用 cupy 进行矩阵乘法:

import cupy as cp

def matrix_multiplication():

# 定义矩阵的大小

n = 2 # 矩阵的行或列数

a = cp.array([[1, 2], [3, 4]]) # 矩阵 a

b = cp.array([[5, 6], [7, 8]]) # 矩阵 b

# 执行矩阵乘法

c = cp.matmul(a, b)

# 将结果从 gpu 内存复制回主机内存

result = cp.asnumpy(c)

# 输出结果

print("result c:")

print(result)

if __name__ == "__main__":

matrix_multiplication()

代码说明:

- 使用

cupy创建矩阵,并将其存储在 gpu 内存中。 - 使用

cp.matmul执行矩阵乘法。 - 使用

cp.asnumpy将结果从 gpu 内存复制回主机内存。

步骤 4: 编译和运行程序

python 是一种解释型语言,因此不需要编译。直接运行程序即可:

python matrix_multiplication.py

步骤 5: 验证结果

检查程序的输出结果,确保计算结果正确。例如,矩阵 a 和 b 的乘积结果应为:

result c:

[[19 22]

[43 50]]

结尾

通过以上步骤,你可以在 python 程序中调用 gpu 算力,显著提升计算效率。如果你在实现过程中遇到困难,建议查阅相应的文档及社区资源,获取更详细的技术支持。希望这篇文章能帮助你快速上手 python 调用 gpu 的开发工作!

到此这篇关于python调用gpu算力的实现步骤的文章就介绍到这了,更多相关python调用gpu算力内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论