deepseek-r1 通过其强大的推理能力和灵活的训练机制,已经火爆了整个春节。

deepseek-r1 是一款高性能 ai 推理模型,旨在通过强化学习技术提升模型在复杂任务场景下的推理能力。

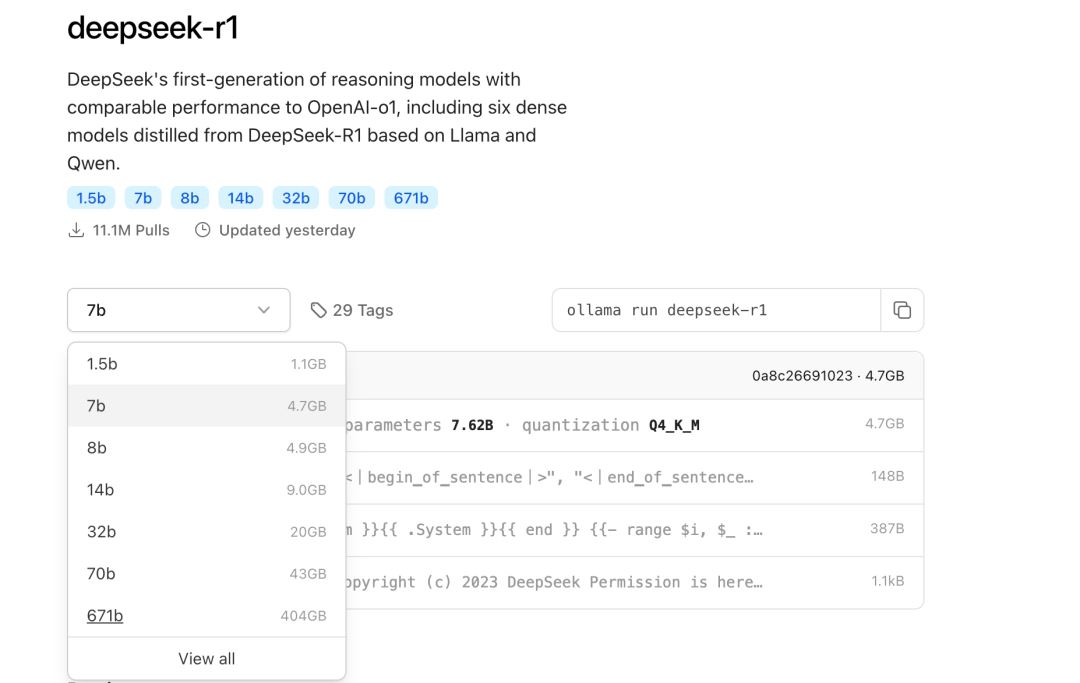

本地部署 deepseek-r1 硬件需求要求还是挺高的,特别是满血 671b 参数版本:

下表说明了各个版本的特点及适用场景:

其中最强悍的 671b 版本部署需要极高的硬件配置:64 核以上的服务器集群、512gb 以上的内存、300gb 以上的硬盘以及多节点分布式训练(如 8x a100/h100),还需高功率电源(1000w+)和散热系统。

不同模型版本对应的需求如下:

1、小型模型

deepseek-r1-1.5b

cpu:最低 4 核

内存:8gb+

硬盘:256gb+(模型文件约 1.5-2gb)

显卡:非必需(纯 cpu 推理)。

适用场景:本地测试,自己电脑上可以配合 ollama 轻松跑起来。

预计费用:2000~5000,这个版本普通人是能够得着的。

2. 中型模型

deepseek-r1-7b

cpu:8 核+

内存:16gb+

硬盘:256gb+(模型文件约 4-5gb)

显卡:推荐 8gb+ 显存(如 rtx 3070/4060)。

适用场景:本地开发和测试,可以处理一些中等复杂度的自然语言处理任务,比如文本摘要、翻译、轻量级多轮对话系统等。

预计费用:5000~10000,这个版本普通人也行。

deepseek-r1-8b

cpu:8 核+

内存:16gb+

硬盘:256gb+(模型文件约 4-5gb)

显卡:推荐 8gb+ 显存(如 rtx 3070/4060)。

适用场景:适合需要更高精度的轻量级任务,比如代码生成、逻辑推理等。

预计费用:5000~10000,这个版本咬咬牙也能上。

3. 大型模型

deepseek-r1-14b

cpu:12 核+

内存:32gb+

硬盘:256gb+

显卡:16gb+ 显存(如 rtx 4090 或 a5000)。

适用场景:适合企业级复杂任务,比如长文本理解与生成。

预计费用:20000~30000,这个对 3000 工资的小编来说还是算了。

deepseek-r1-32b

cpu:16 核+

内存:64gb+

硬盘:256gb+

显卡:24gb+ 显存(如 a100 40gb 或双卡 rtx 3090)。

适用场景:适合高精度专业领域任务,比如多模态任务预处理。这些任务对硬件要求非常高,需要高端的 cpu 和显卡,适合预算充足的企业或研究机构使用。

预计费用:40000~100000,算了。

4. 超大型模型

deepseek-r1-70b

cpu:32 核+

内存:128gb+

硬盘:256gb+

显卡:多卡并行(如 2x a100 80gb 或 4x rtx 4090)。

适用场景:适合科研机构或大型企业进行高复杂度生成任务。

预计费用:400000+,这是老板考虑的,不该我去考虑。

deepseek-r1-671b

cpu:64 核+

内存:512gb+

硬盘:512gb+

显卡:多节点分布式训练(如 8x a100/h100)。

适用场景:适合超大规模 ai 研究或通用人工智能(agi)探索。

预计费用:20000000+,这是投资人考虑的,不该我去考虑。

发表评论