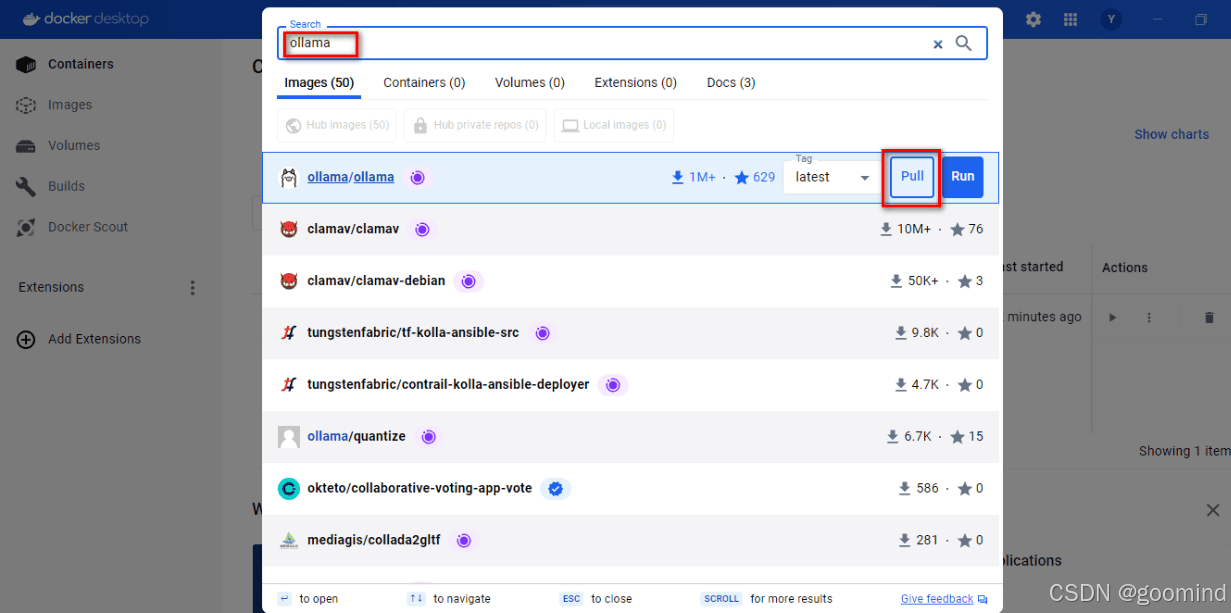

一、拉取 ollama 镜像

方式一:docker 软件在可视化界面中搜索并下载

方式二:官网推荐直接使用下面的指令拉取下载镜像,本项目只需在cpu上即可运行。

# cpu 或者 nvidia gpu docker pull ollama/ollama # amd gpu docker pull ollama/ollama:rocm

注:如果读者想要使用具体的版本的镜像,明确运行环境,可以使用下面的指令:

# cpu 或 nvidia gpu下载ollama 0.3.0 docker pull ollama/ollama:0.3.0 # amd gpu下载ollama 0.3.0 docker pull ollama/ollama:0.3.0-rocm

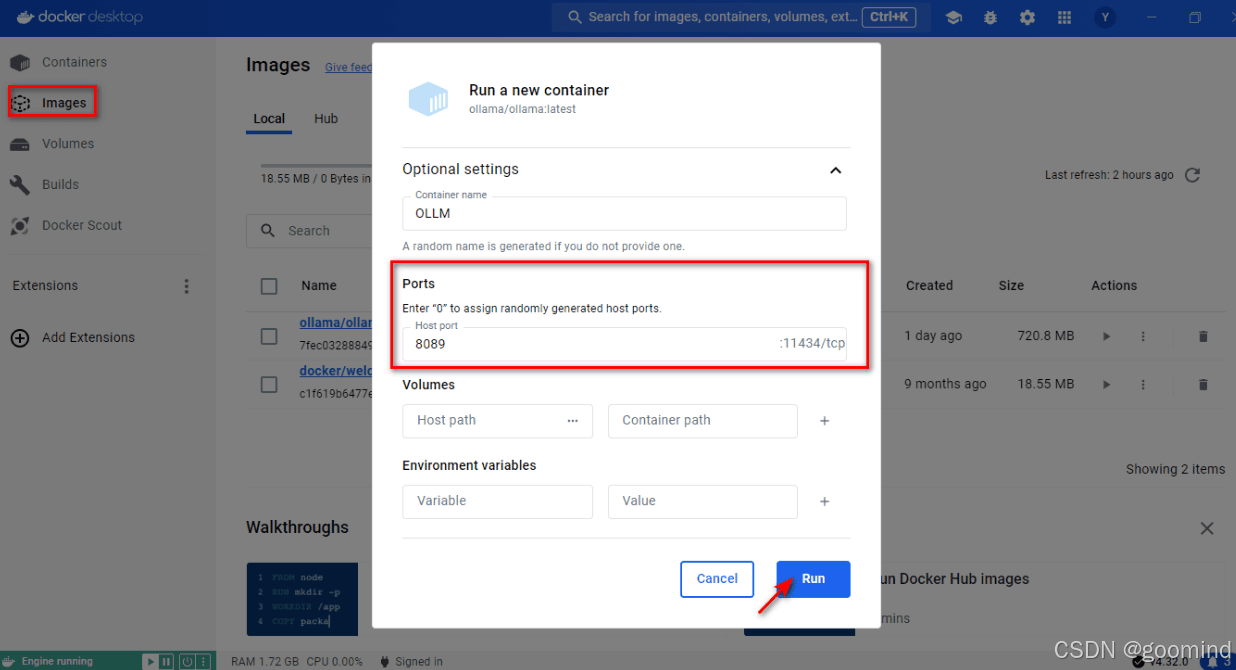

二、运行ollama镜像

方式一:docker在可视化界面中运行镜像

- 下载完成后,可以在

images中找到ollama镜像,点击run标识即可运行,注意运行前在弹出的可选设置里面,选定一个端口号(如8089)。

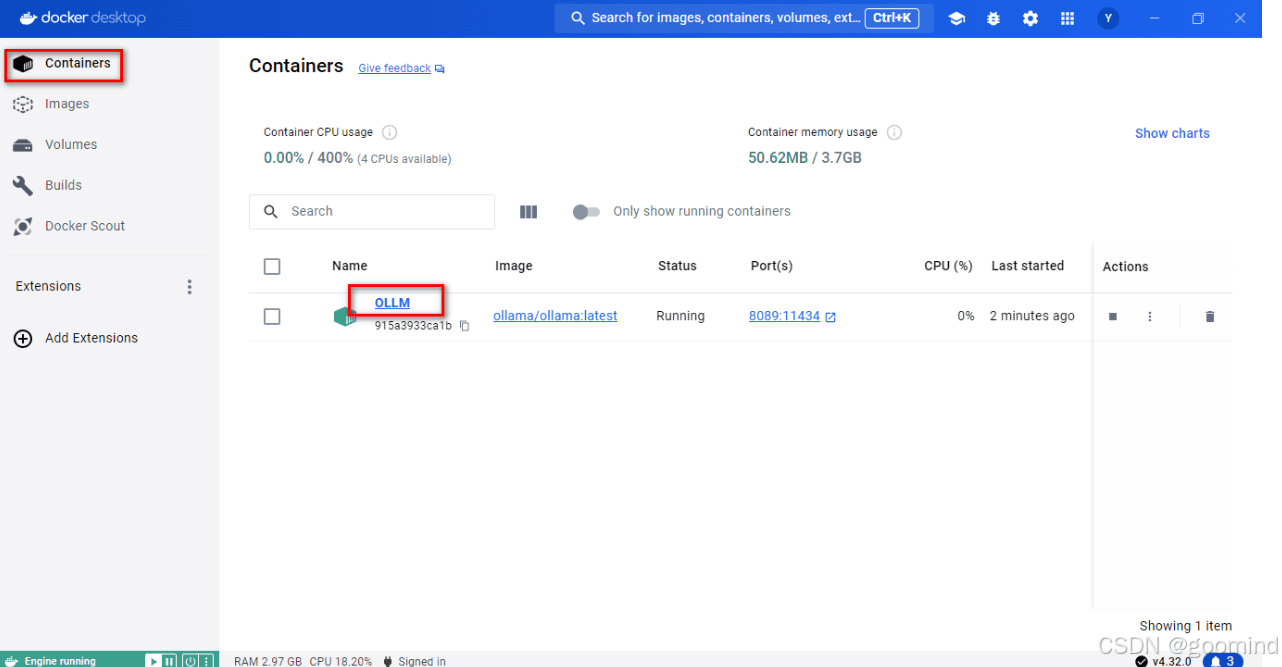

- 在

containers中找到该镜像,点击ollm即可进入 ollama 界面

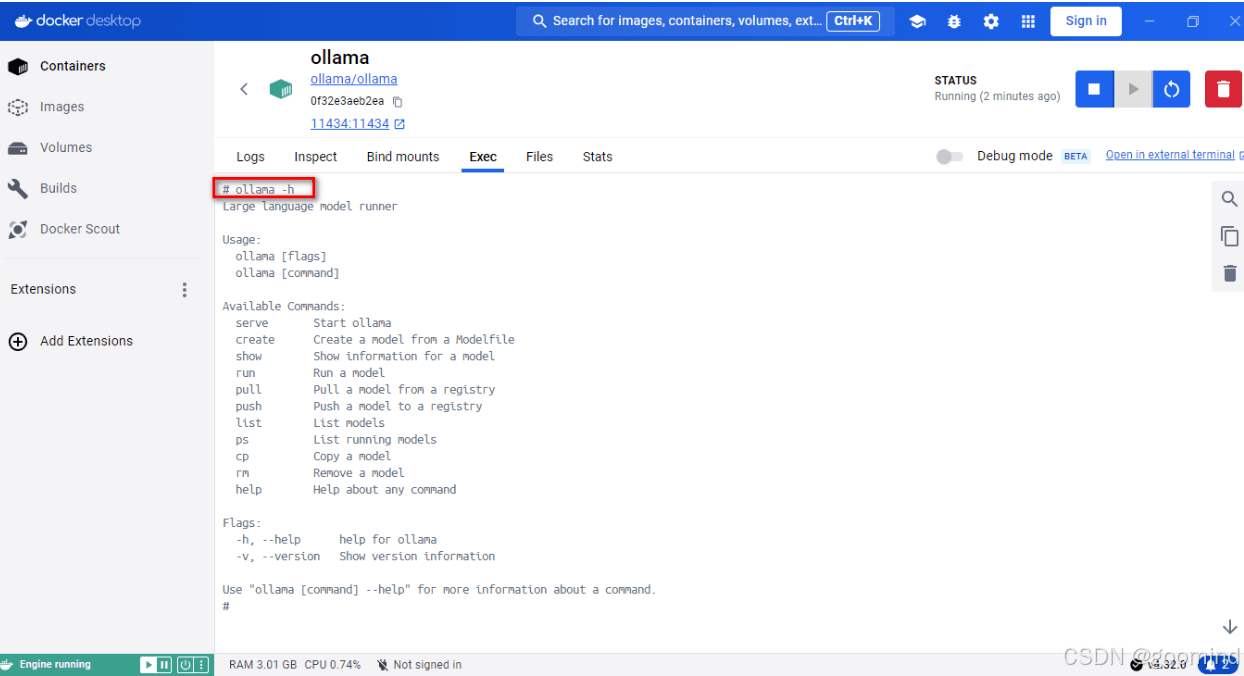

- 验证安装完成,在

exec处输入:

ollama -h

输出如下:即表示安装成功🎉

large language model runner usage: ollama [flags] ollama [command] available commands: serve start ollama create create a model from a modelfile show show information for a model run run a model pull pull a model from a registry push push a model to a registry list list models ps list running models cp copy a model rm remove a model help help about any command flags: -h, --help help for ollama -v, --version show version information

- 终端使用 ollama :

以下是 ollama 使用常见的指令:

ollama serve #启动ollama ollama create #从模型文件创建模型 ollama show #显示模型信息 ollama run #运行模型 ollama pull #从注册表中拉取模型 ollama push #将模型推送到注册表 ollama list #列出模型 ollama cp #复制模型 ollama rm #删除模型 ollama help #获取有关任何命令的帮助信息

ollama run llama3

下载速度取决于你的带宽,下载完毕即可使用✌记得使用

control + d退出聊天

方式二:命令行启动

- cpu 版本:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

总结

到此这篇关于ollama在docker下的安装与配置的文章就介绍到这了,更多相关ollama在docker下安装与配置内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论