人工智能正加速向着边缘计算领域发展,copilot+ pc 在其中扮演着重要角色。随着 deepseek r1 出现,微软也意识到了这一模型可能会带来了一系列变革。

微软今日发文,宣布推出针对 npu 优化的 deepseek-r1(我们注:已在 azure ai foundry 和 github 上提供),首批将面向搭载高通骁龙 x 芯片的 copilot+ pc 推出,随后是英特尔酷睿 ultra 200v 等平台。

微软表示,首个版本 deepseek-r1-distill-qwen-1.5b 将在 ai toolkit 中提供,7b 和 14b 版本也将很快推出,从而帮助开发者充分利用 copilot+ pc 中强大的 npu 配置。

微软表示,copilot+ pc 上的 npu 开启了一种新的范式。在这种范式下,生成式 ai 不仅可以在被调用时执行,还可以支持半连续运行的服务。这使开发者能够利用 ai 推理引擎来构建主动和持续的体验。微软表示:

通过我们在 phi silica 上的工作,我们实现了高效的推理 —— 在首次生成 token 的时间和吞吐率方面表现出色,同时对电池续航和 pc 资源消耗的影响降至最低。针对 npu 优化的 deepseek 模型借鉴了该项目的多项关键经验和技术,包括如何分离模型的各个部分以实现性能与效率的最佳平衡、低比特率量化以及将 transformer 映射到 npu。此外,我们还利用 windows copilot runtime(wcr)通过 onnx qdq 格式在多样化的 windows 生态系统中实现扩展。

微软表示,要想在 copilot+ pc 上体验 deepseek 只需下载 ai toolkit vs code 扩展即可;以 onnx qdq 格式优化的 deepseek 模型将很快出现在 ai toolkit 的模型目录中(直接从 azure ai foundry 中拉取)。

用户可以通过点击“下载”按钮将其下载到本地。下载完成后,只需打开 playground 加载“deepseek_r1_1_5”模型,并给出提示词即可开始实验。

除了为 copilot+ pc 优化的 onnx 模型外,您还可以通过点击“deepseek r1”下的“try in playground”按钮,在 azure foundry 中尝试云托管的源模型。

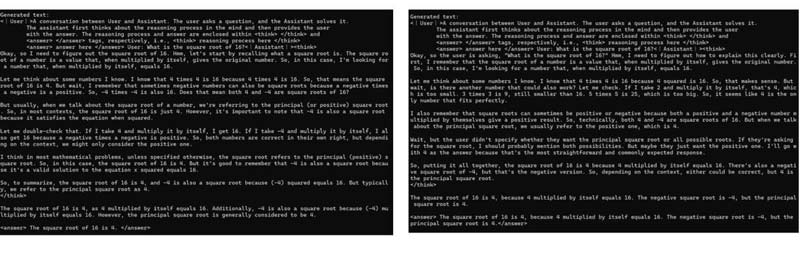

如下图所示,微软还展示了原始模型和量化模型的示例,以展现两者之间微小但确实存在的差异:

▲ 相同提示下原始模型(左)与 npu 优化模型(右)的响应示例,包括模型的推理能力

发表评论