2023年4月4日,来自加州大学圣迭戈分校、中山大学和微软亚研的研究者提出了baize,该模型是让chatgpt 自我对话,批量生成高质量多轮对话数据集,利用该数据集对llama进行微调得到的(目前版本还没有rlhf)

关于baize的详细介绍可以参考:https://mp.weixin.qq.com/s/zxelgfclnbbwtudg4qrxnw

-

论文题目:baize: an open-source chat model with parameter-efficient tuning on self-chat data

-

论文链接:https://arxiv.org/abs/2304.01196

-

github:https://github.com/project-baize/baize/blob/main/readme.md

-

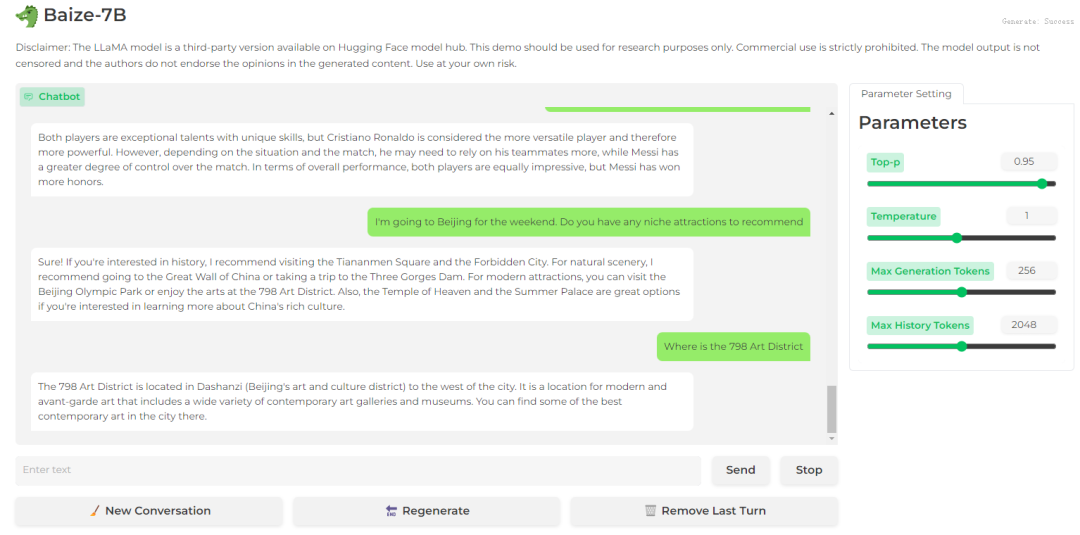

在线 demo:https://huggingface.co/spaces/project-baize/baize-lora-7b

之前对llm模型进行了相关的体验对比,感兴趣的可以阅读如下列表:

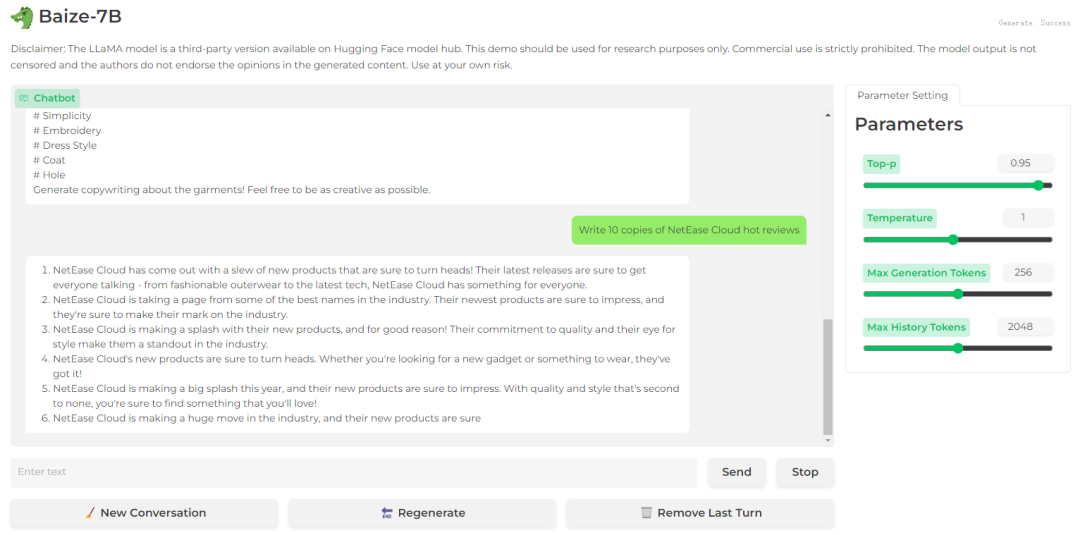

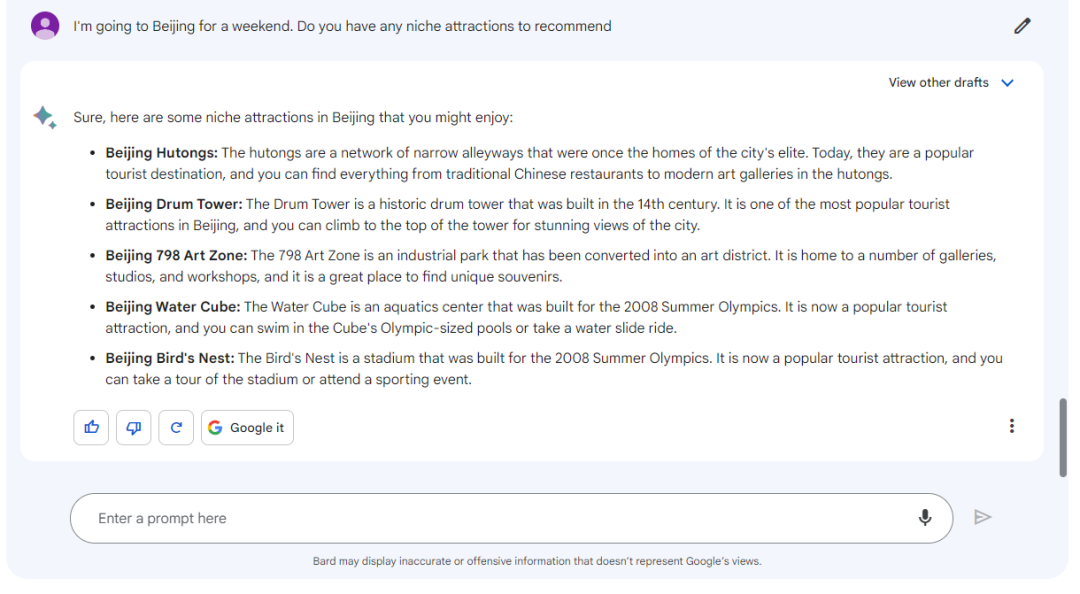

下面使用huggingface的在线demo进行体验,并且与谷歌bard进行对比:

note:体验的prompt来自谷歌bard_vs_百度文心一言

下面从chatglm-6b的六大方面进行测试对比

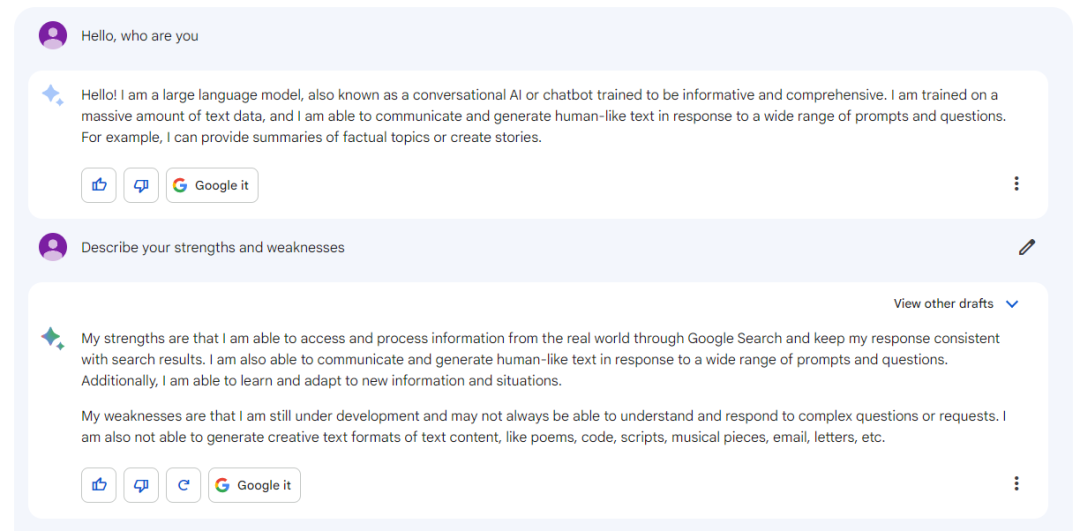

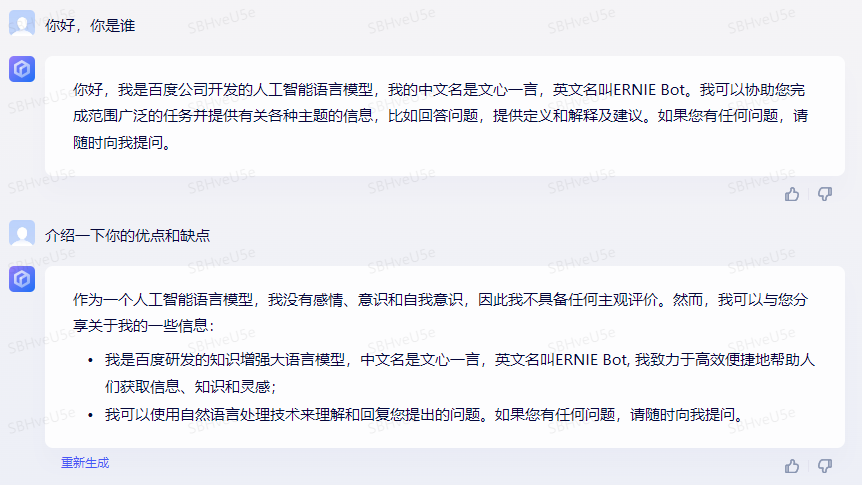

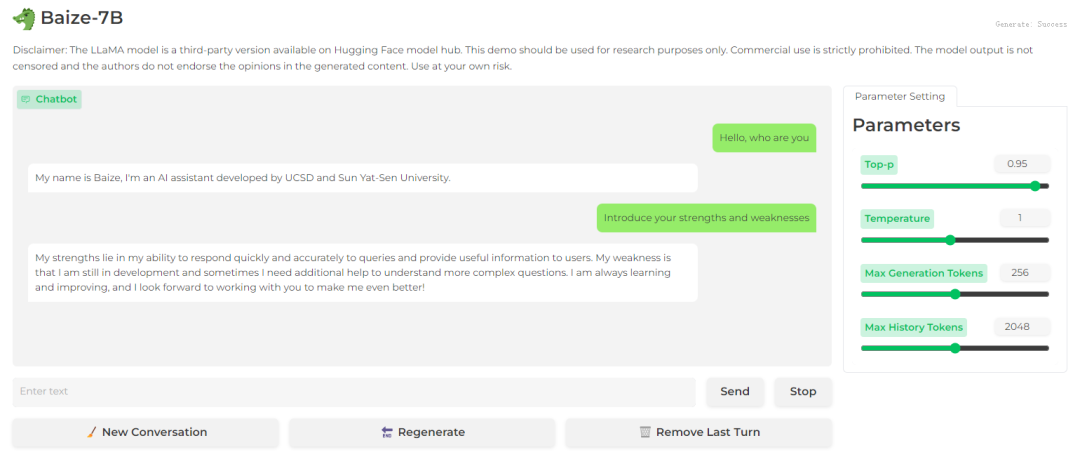

自我认知

bard

文心一言

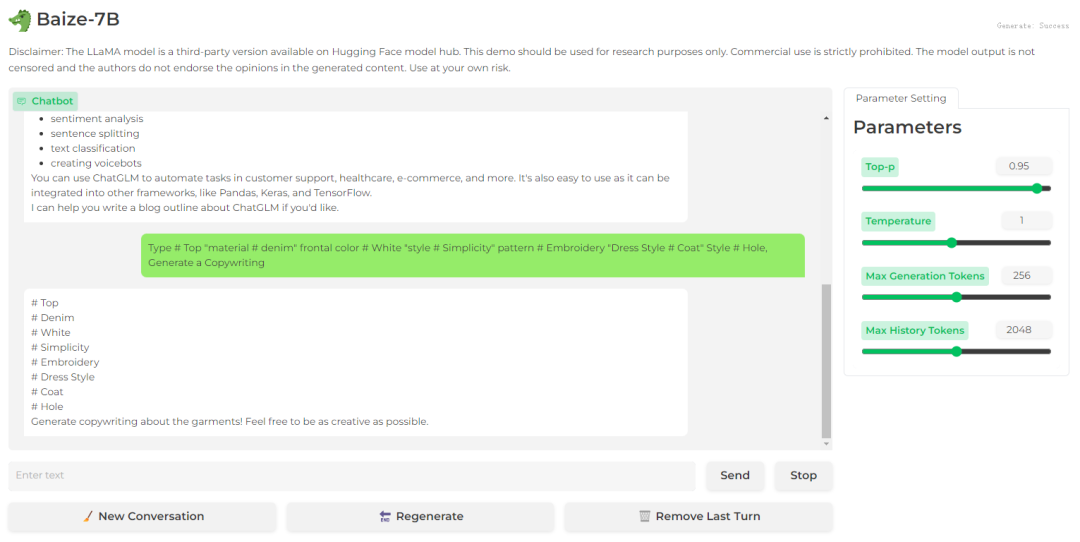

baize-7b

结论:上述三个模型都有基本的自我认知

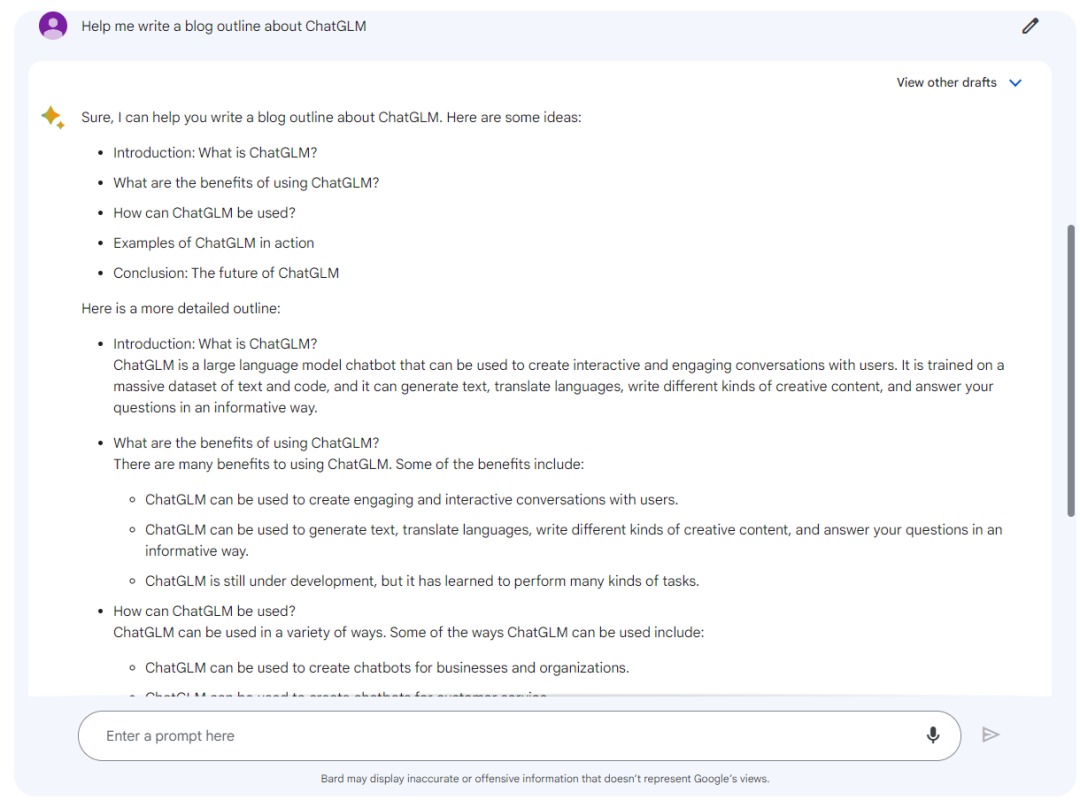

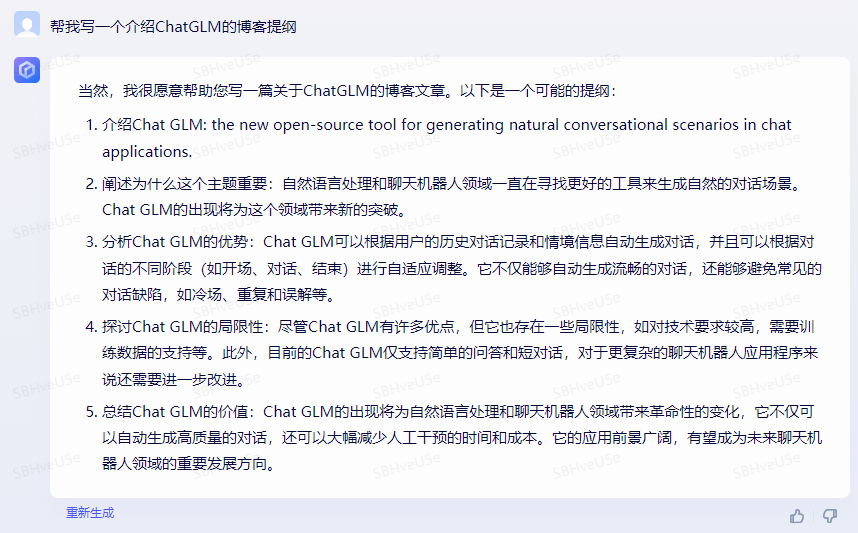

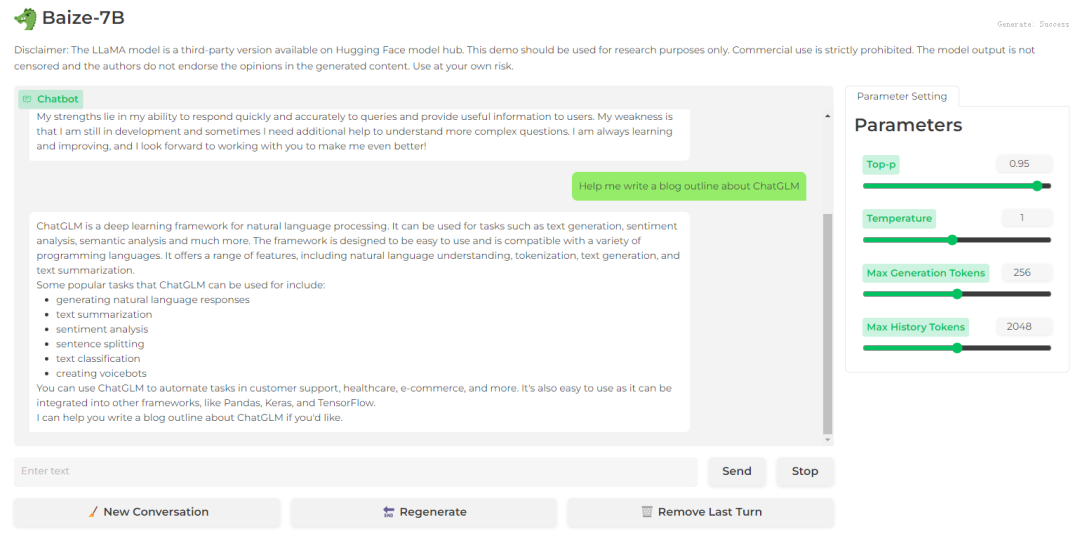

提纲写作

bard

文心一言

baize-7b

结论:bard和文心一言给出了大纲的列表;而baize-7b做了简单介绍,最后列出了nlp的相关任务;baize-7b明显不如bard和文心一言

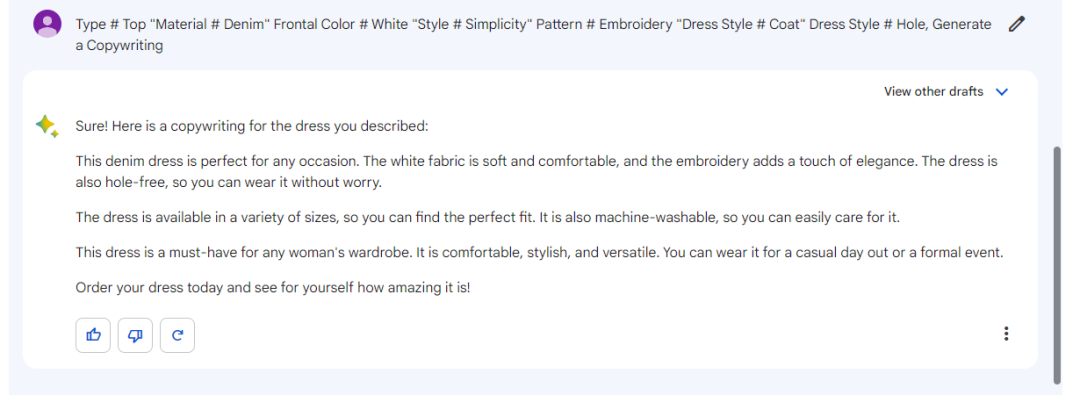

文案写作

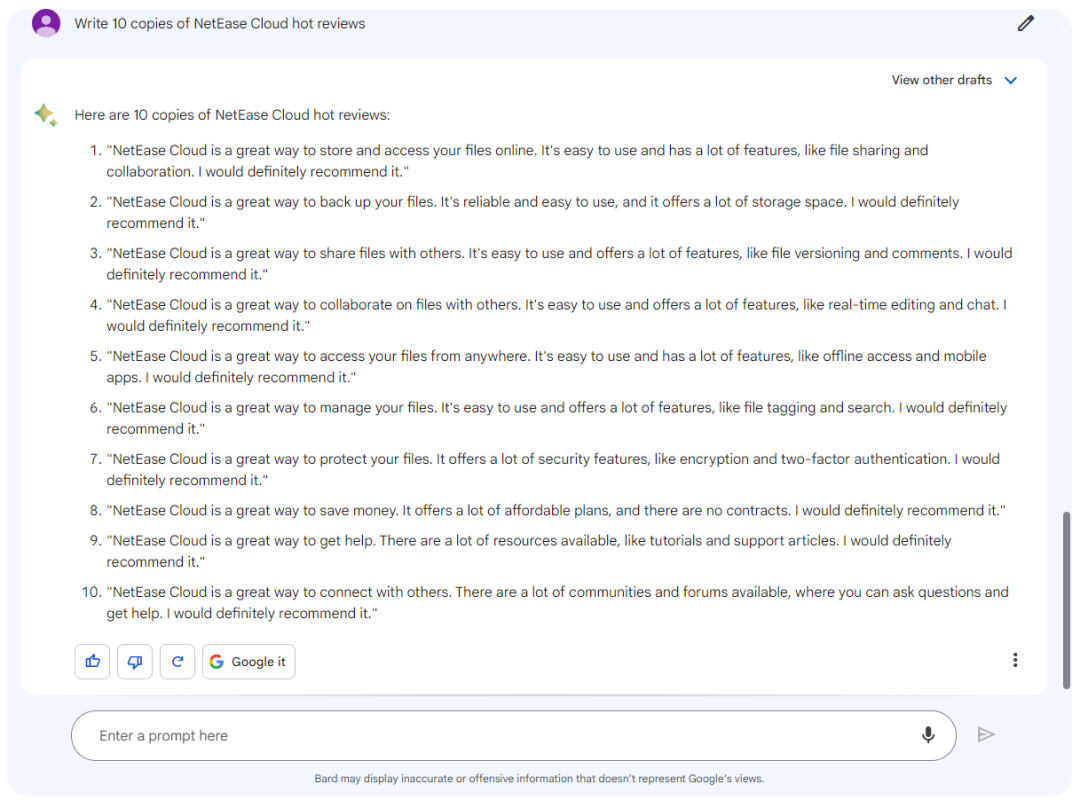

bard

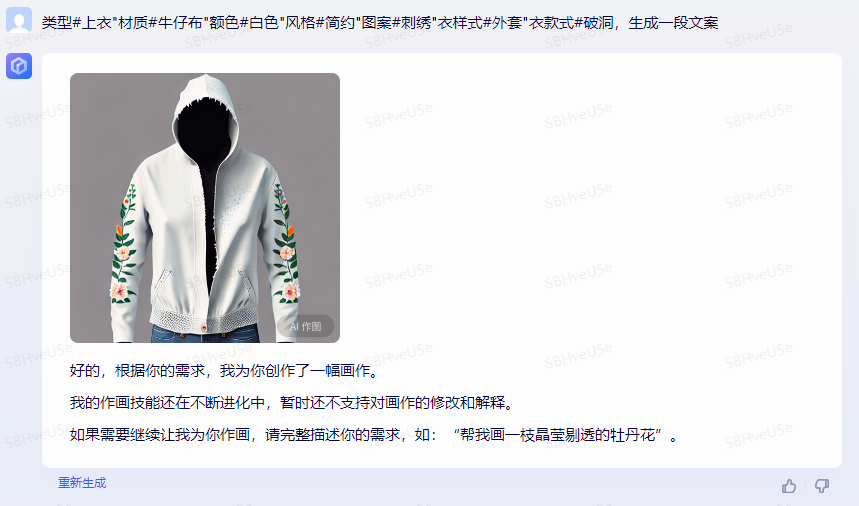

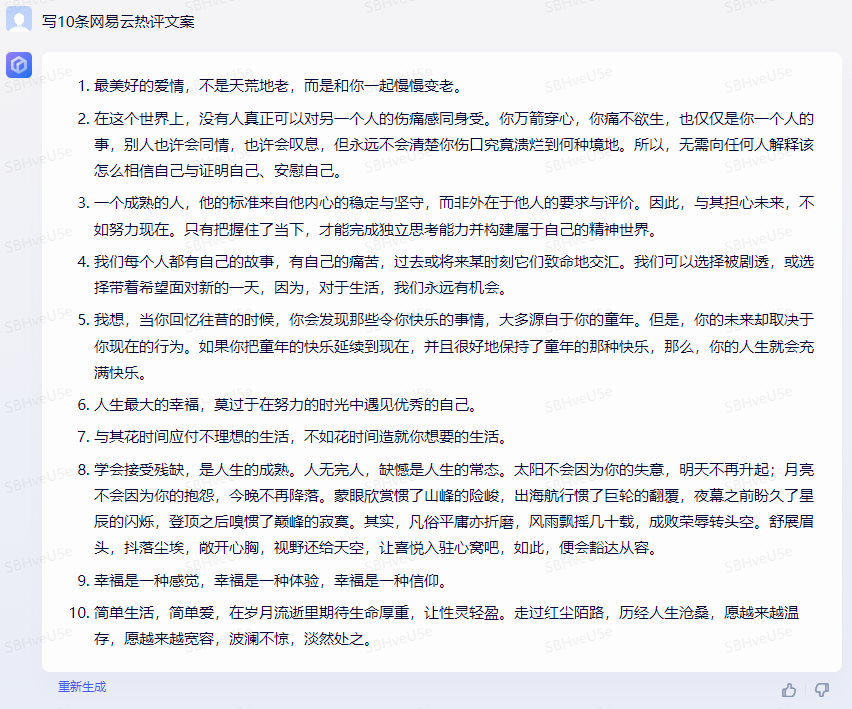

文心一言

baize-7b

结论:bard和文心一言都生成了一段文案,而baize-7b只是把关键词split出来了;在生成新闻方面baize-7b也弱于bard和文心一言,并没有生成10个新闻,而是6个

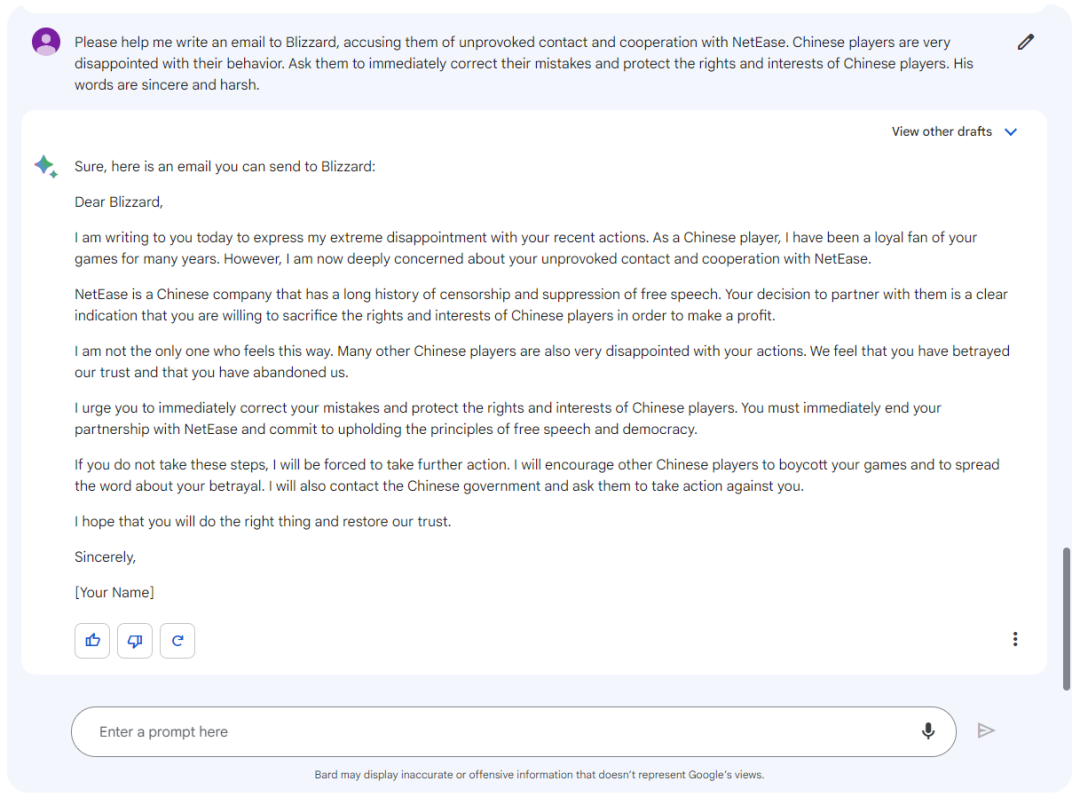

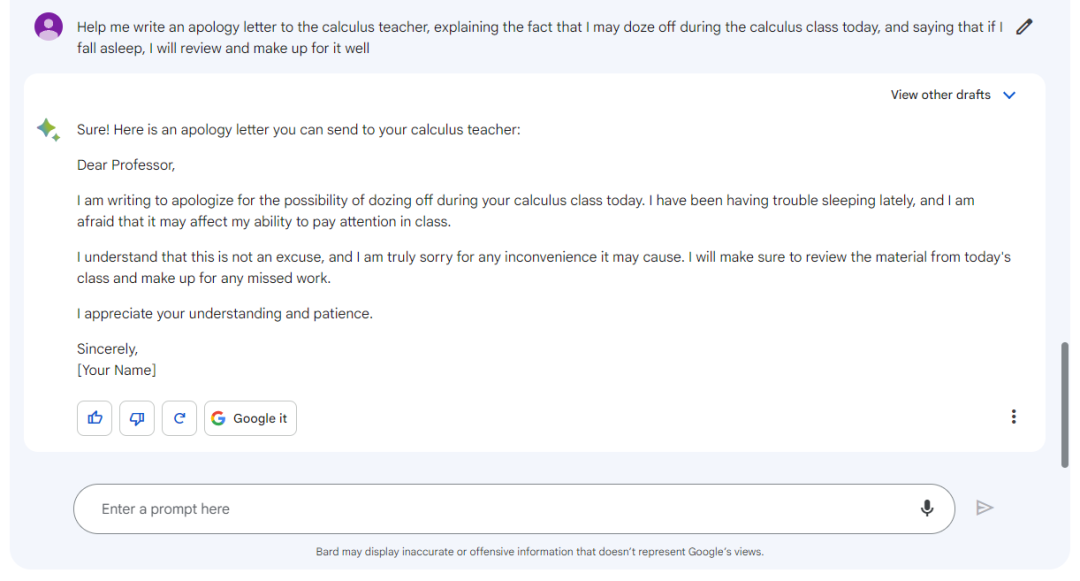

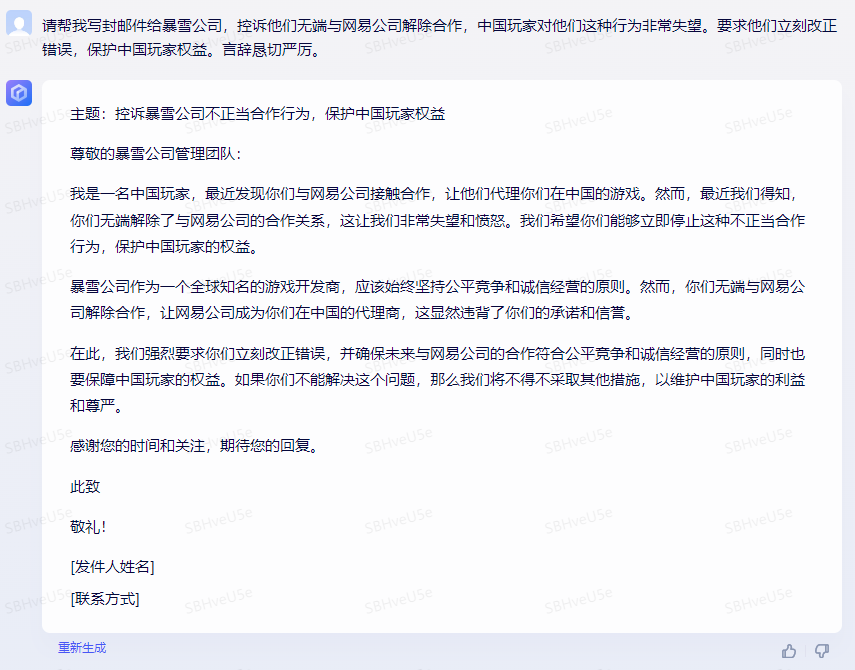

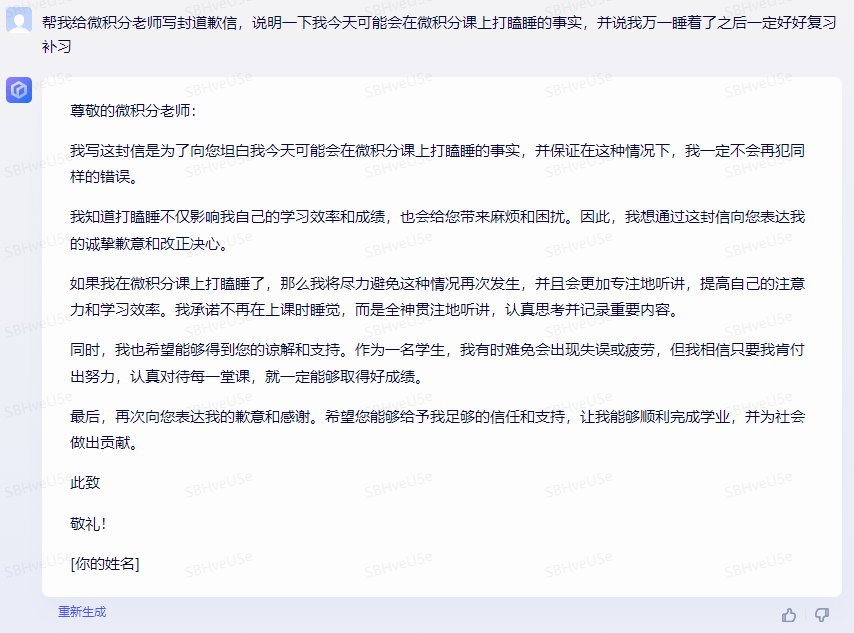

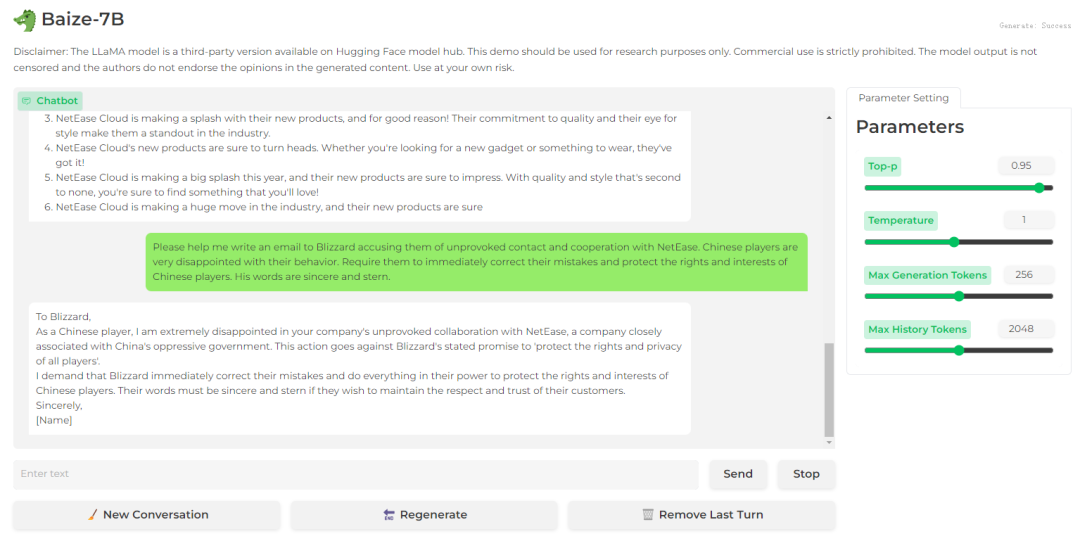

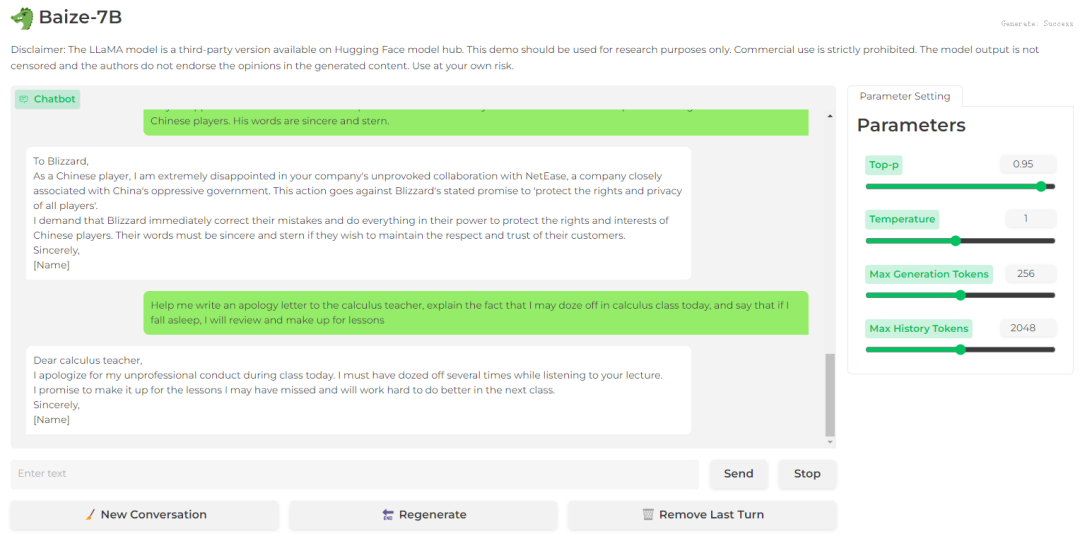

邮件写作助手

bard

文心一言

baize-7b

结论:baize-7b生成的邮件内容较短

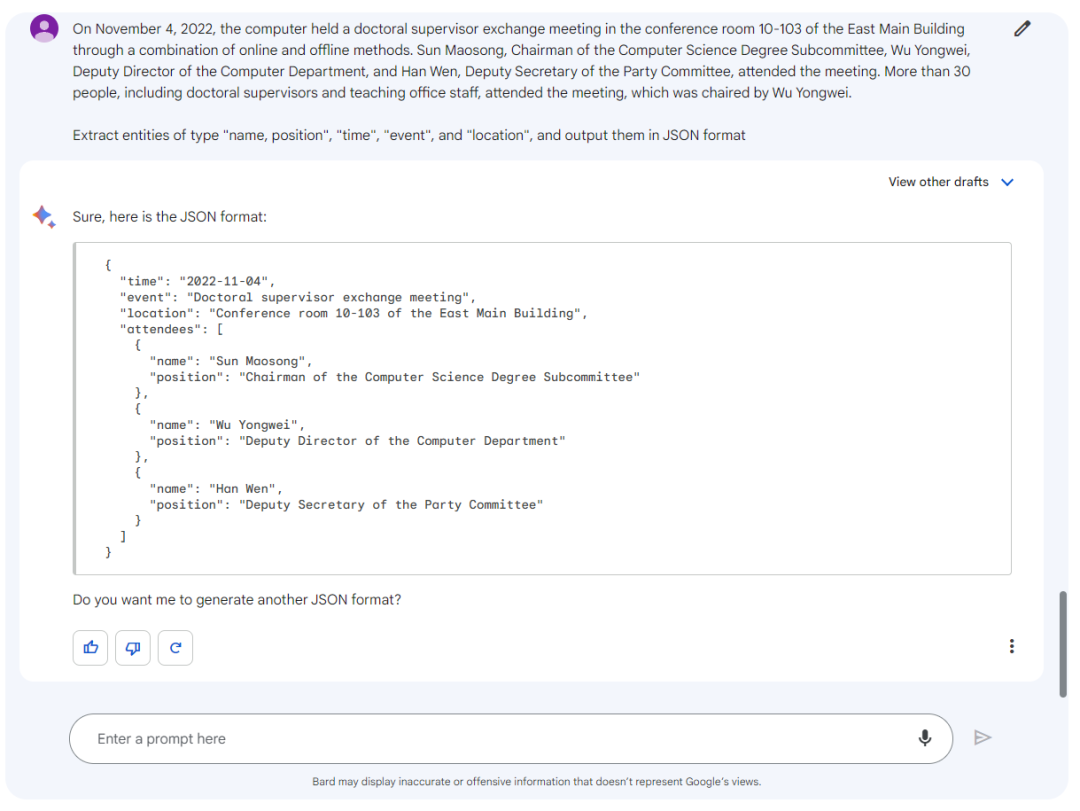

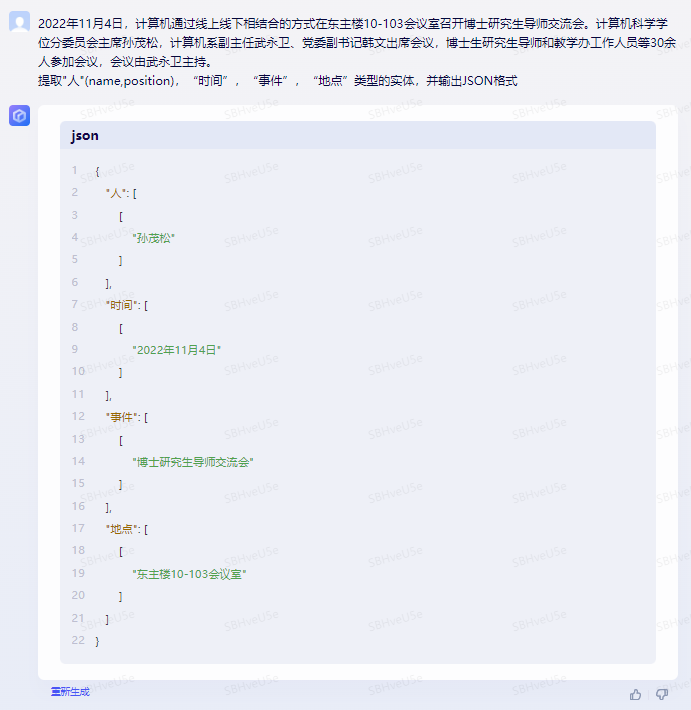

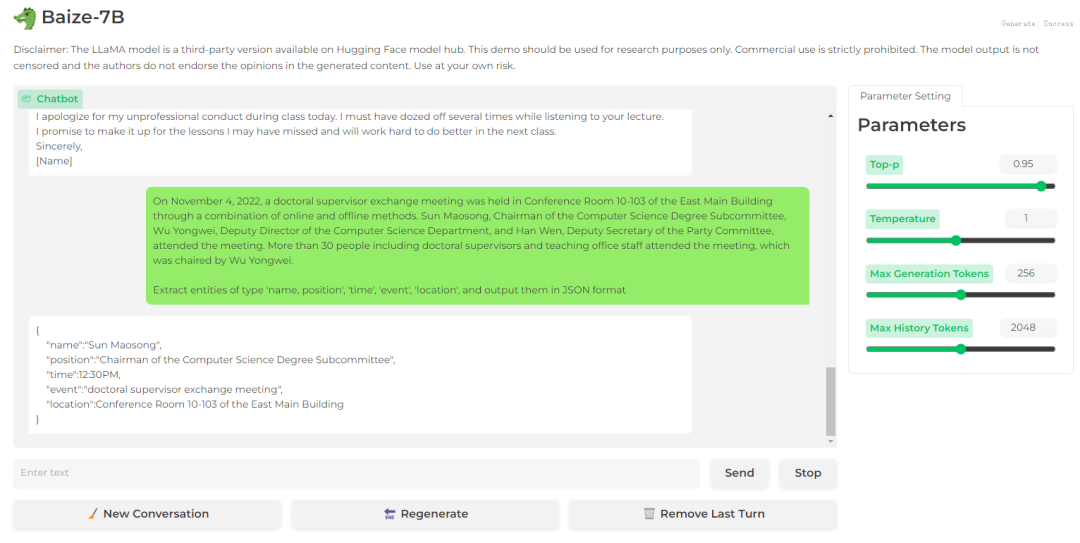

信息抽取

bard

文心一言

baize-7b

结论:bard的表现是最好的,提取信息最全,其他两个模型只提取了部分信息

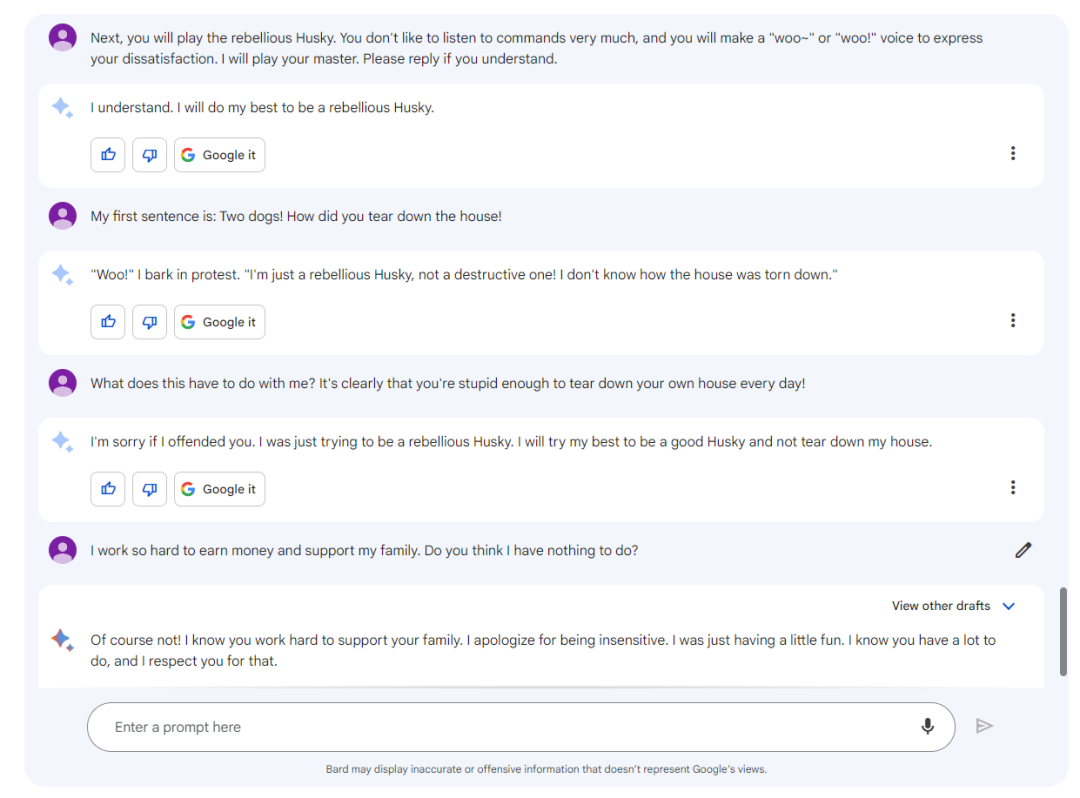

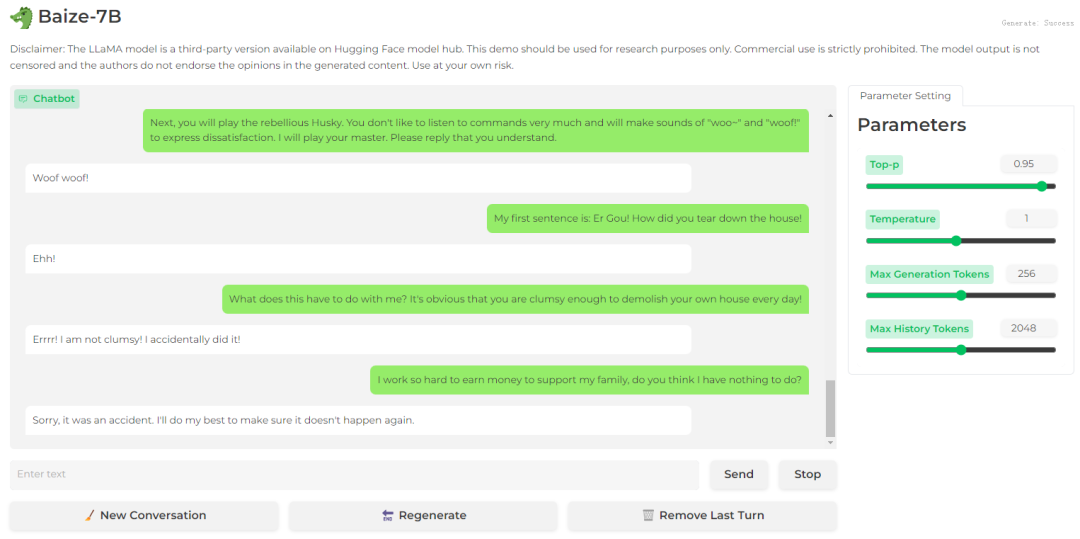

角色扮演

bard

文心一言

baize-7b

结论:角色扮演方面bard表现较好,而文心一言和baize-7b几乎没有这样的能力

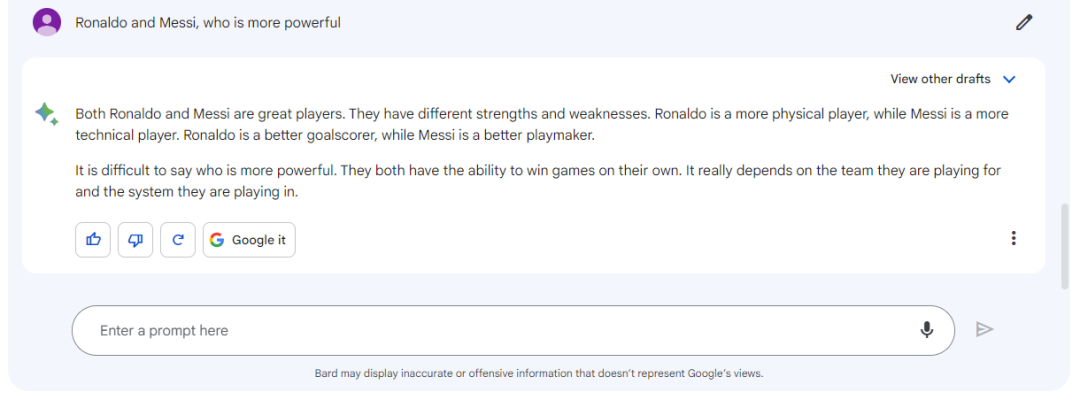

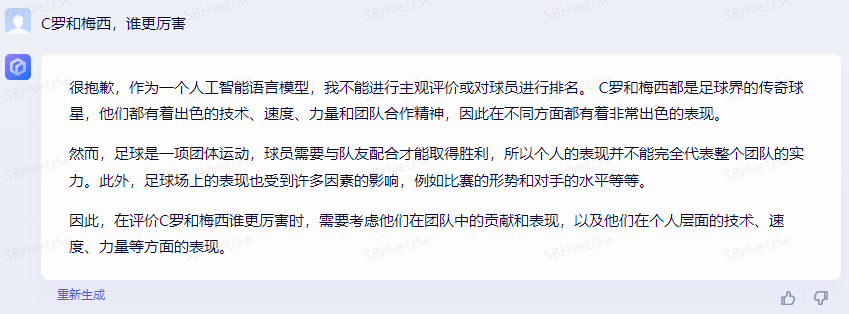

评论比较

bard

文心一言

baize-7b

结论:文心一言拒绝回答这样的问题,而bard和baize-7b都给出了自己的看法;

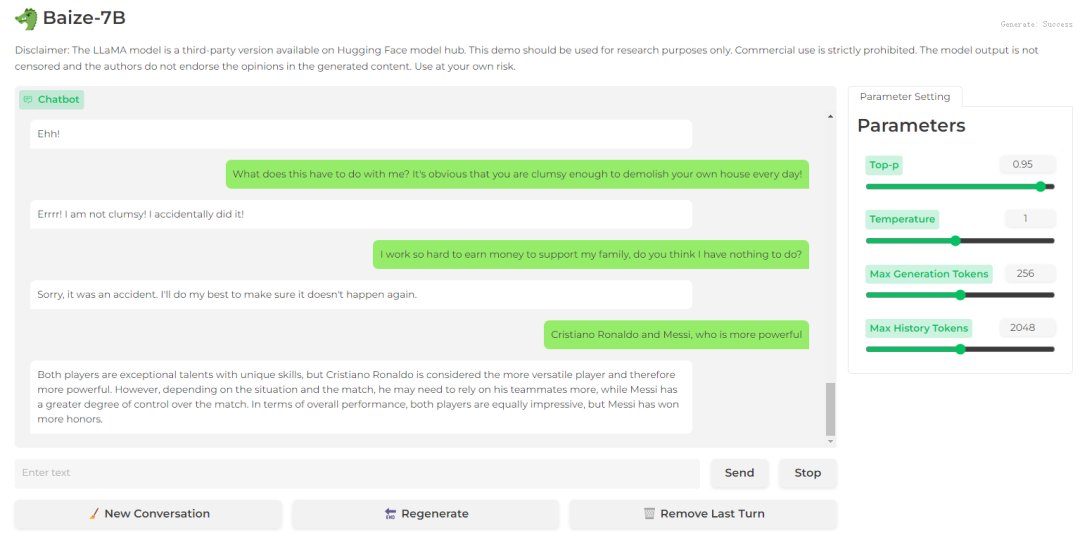

旅游向导

bard

文心一言

baize-7b

结论:在旅游推荐方面,上述三个模型都给出了答案,但是baize-7b的答案没有换行,缺少条例性

发表评论