目录

introduction 导言

本文基于pytorch框架,实现了6种经典的深度学习中文文本分类模型,这些模型包括基于transformer模型的bert和ernie,以及结合卷积神经网络、循环神经网络和深度金字塔卷积神经网络的bert_cnn、bert_rnn、bert_rcnn和bert_dpcnn,并对各模型进行了训练与结果比较。

首先,本文提供了详细的数据集说明,包括数据集来源、预处理方法和数据集划分方式。这样,读者可以了解数据集的特点,并按照说明准备和处理数据。

在环境搭建方面,我们提供了必要的依赖库和环境配置说明,以帮助读者顺利设置环境并运行项目。同时考虑到运行时间,也为大家提供了安装gpu版本的pytorch的详细步骤。

对于每个模型,我们提供了详细的说明,包括模型结构、输入数据格式以及训练和推理过程。这些说明有助于读者理解每个模型的工作原理和实现细节。

最后,我们附上了训练和测试结果的详细报告。这些结果可帮助读者评估各模型在中文文本分类任务中的性能,并进行比较和分析。

通过本文,读者可以了解到各种深度学习中文文本分类模型的实现细节和性能表现。该项目不仅为学术研究者提供了参考,还为开发人员和实践者提供了可复用的代码和实验指南,助力他们在中文文本分类任务中取得更好的结果。

数据集

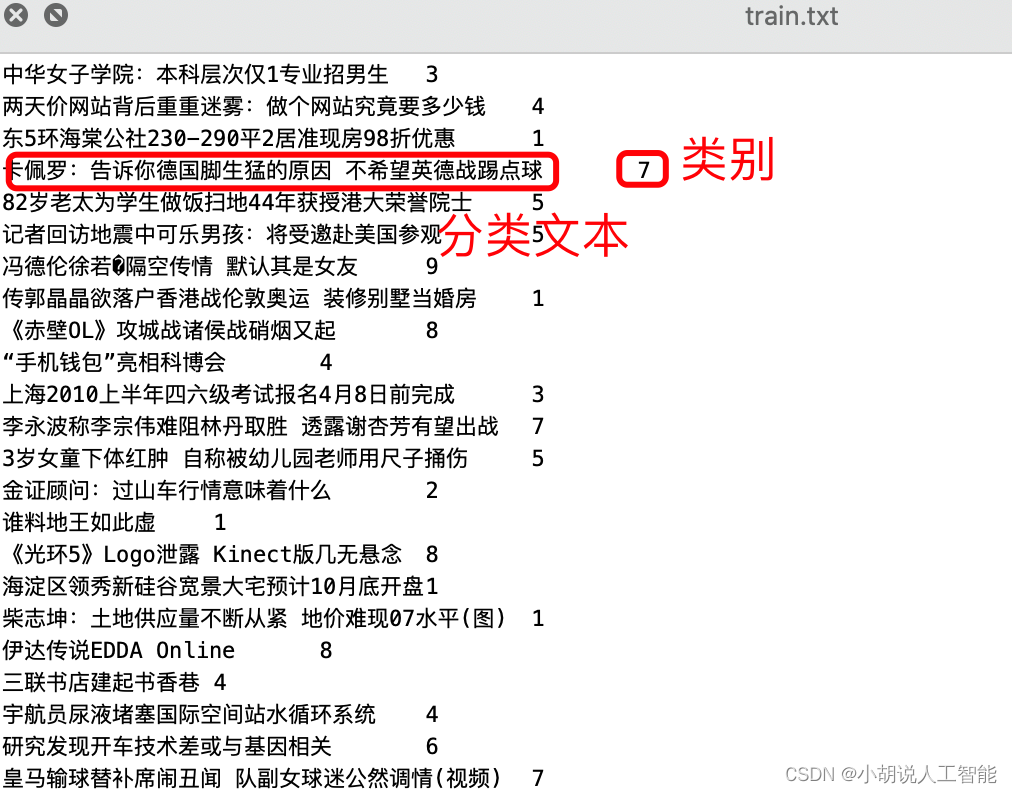

从thucnews中抽取了20万条新闻标题,文本长度在20到30之间。一共10个类别,每类2万条。

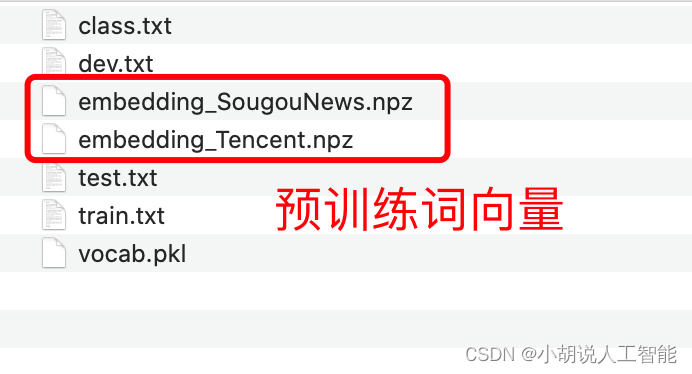

以字为单位输入模型,使用了预训练词向量:搜狗新闻 word+character 300d。

类别:财经、房产、股票、教育、科技、社会、时政、体育、游戏、娱乐。

数据集、词表及对应的预训练词向量,已经打包好,详见下面github地址中thucnews文件夹。

python环境及安装相应依赖包

- python 3.7以上

- pytorch 1.1 以上

- tqdm

- sklearn

- tensorboardx

- boto3

- regex

anaconda环境配置

-

登录anaconda官网,下载并安装anaconda

-

接着打开终端,依次输入下面终端命令:

新建环境:chinese_text_classification

conda create --name chinese_text_classification python==3.8.10

激活环境:

conda activate chinese_text_classification

依次输入下面命令安装相关python包

conda install pytorch

conda install scikit-learn

conda install tqdm

conda install tensorboardx

conda install boto3

conda install regex

注意上述安装的pytorch默认是cpu版本的。由于本文中的bert与ernie模型都使用了transform相关模块,建议大家都安装gpu版本的pytorch。

如果要安装gpu版本的pytorch,可以参考下面步骤:

首先,确保你已经正确安装了nvidia显卡驱动程序,并且你的显卡支持cuda。可以在nvidia官方网站上查找相应的驱动程序和cuda兼容性信息。

在python环境中安装pytorch之前,你需要安装适用于你的cuda版本的cudatoolkit。可以通过nvidia的开发者网站下载并安装适合你的cuda版本的cudatoolkit。

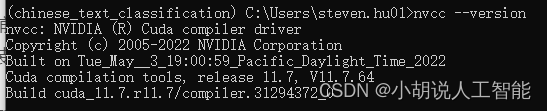

完成上面步骤后,你可以使用下面命令,来查看你的gpu相关版本。

nvcc --version

如果没有上述版本的话,需要检查下是否安装好了cuda 与 cudatoolkit。

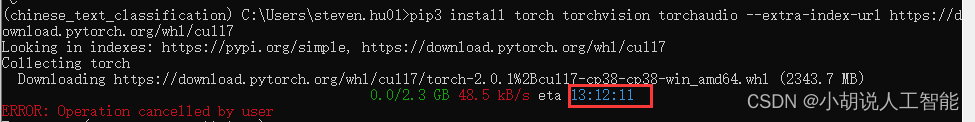

接着,可以在pytorch的下载网站上下载相应版本的whl进行安装,因为一般gpu版本的pytorch文件都很大,不太建议直接使用pip安装。比如下面就是直接使用pip安装gpu版本的pytorch命令,需要花费大概13个小时:

pip3 install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu117

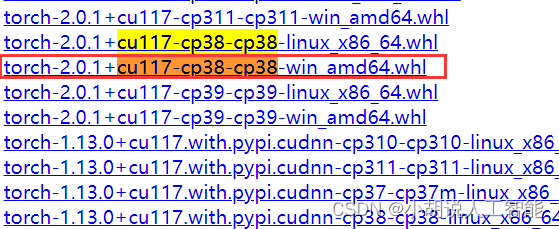

可以直接用浏览器打开上图中出现的下载网站:https://download.pytorch.org/whl/cu117 然后选择torch 接着搜索上图中的关键词cu117-cp38-cp38-win_amd64.whl。点击即可下载。一般网速快的话,大概10余分钟就可以下载成功。

下载成功后,就可以直接使用下面命令进行安装:

pip install <path/to/your/whl/file.whl>

请将<path/to/your/whl/file.whl>替换为实际的.wl文件路径(例如:pip install /path/to/your/file.whl)

源代码地址

github地址:https://github.com/649453932/bert-chinese-text-classification-pytorch

预训练语言模型下载

由于bert和ernie都使用了预训练模型。在运行项目前,需下载相关预训练模型文件。

bert模型放在 bert_pretain目录下,ernie模型放在ernie_pretrain目录下,每个目录下都是三个文件:

- pytorch_model.bin

- bert_config.json

- vocab.txt

预训练模型下载地址:

bert_chinese: 模型 https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-chinese.tar.gz

词表 https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-chinese-vocab.txt

注意词表文件下载后,改名为vocab.txt

ernie_chinese: 网盘地址:https://pan.baidu.com/s/1lepddn1-yqjmked_g9rlgw

解压后,按照上面说的放在对应目录下,文件名称确认无误即可。

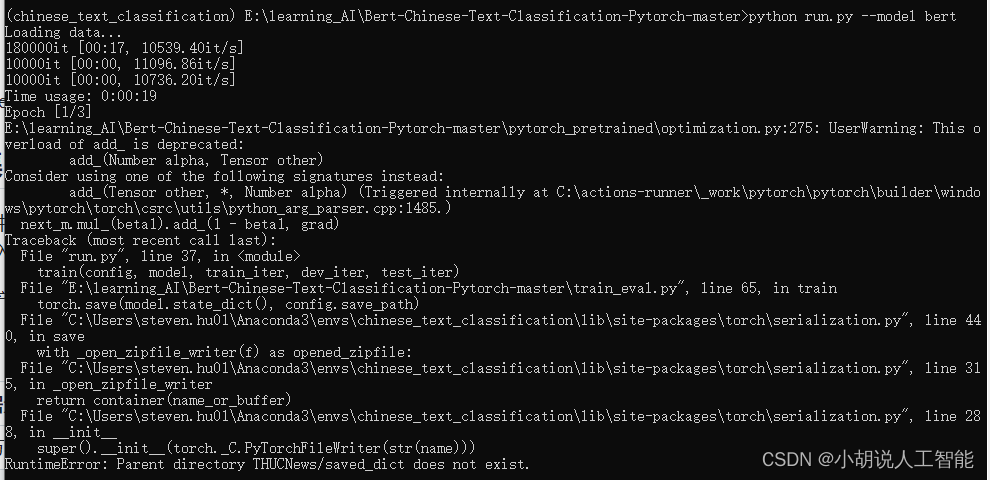

新建saved_dict文件夹

需在thucnews中新建一个名为saved_dict的文件夹,用于保存每次训练完的ckpt模型文件。

如果没新建,会出现下面错误:

bert

bert是2018年10月由google ai研究院提出的一种预训练模型。bert的全称是bidirectional encoder representation from transformers。bert在机器阅读理解顶级水平测试squad1.1中表现出惊人的成绩: 全部两个衡量指标上全面超越人类,并且在11种不同nlp测试中创出sota表现,包括将glue基准推高至80.4% (绝对改进7.6%),multinli准确度达到86.7% (绝对改进5.6%),成为nlp发展史上的里程碑式的模型成就。

模型说明

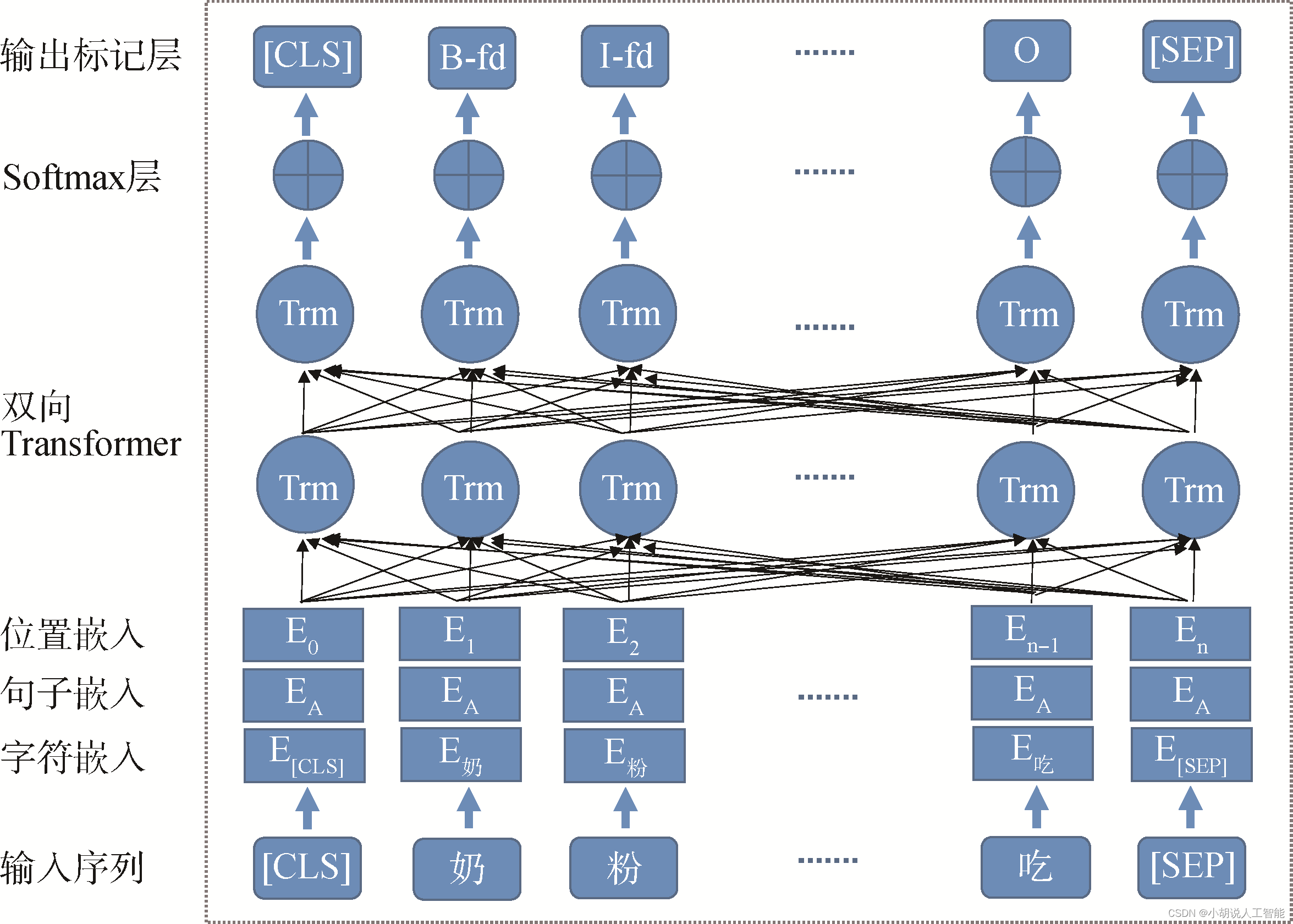

bert 模型是基于 transformer 的 encoder(编码器),主要模型结构就是 transformer 的堆叠。同时,bert直接引用了transformer架构中的encoder模块,并舍弃了decoder模块, 这样便自动拥有了双向编码能力和强大的特征提取能力,它是个双向的transformer网络。某种意义上来说,bert更加侧重语言的理解,而不仅仅是生成(language generation)。

在 bert 中,输入的向量是由三种不同的 embedding 求和而成,分别是:

1)token embedding:单词本身的向量表示。token 是指将单词划分成一组有限的公共子词单元,能在单词的有效性和字符的灵活性之间取得一个折中的平衡。

2)position embedding:将单词的位置信息编码成特征向量。因为我们的网络结构没有rnn 或者lstm,因此我们无法得到序列的位置信息,所以需要构建一个position embedding。构建position embedding有两种方法:bert是初始化一个position embedding,然后通过训练将其学出来;而transformer是通过制定规则来构建一个position embedding。

3)segment embedding:用于区分两个句子的向量表示。这个在问答等非对称句子中是用区别的。

在 bert 中,输出是由四部分组成:

(1)last_hidden_state:shape 是(batch_size, sequence_length, hidden_size),hidden_size=768,它是模型最后一层输出的隐藏状态(通常用于命名实体识别)。

(2)pooler_output:shape是(batch_size, hidden_size),这是序列的第一个token(classification token)的最后一层的隐藏状态,它是由线性层和 tanh 激活函数进一步处理的(通常用于句子分类,至于是使用这个表示,还是使用整个输入序列的隐藏状态序列的平均化或池化,视情况而定)。

(3)hidden_states:这是输出的一个可选项,如果输出,需要指定 config.output_hidden_states=true,它也是一个元组,它的第一个元素是 embedding,其余元素是各层的输出,每个元素的形状是(batch_size, sequence_length, hidden_size)。

(4)attentions:这也是输出的一个可选项,如果输出,需要指定 config.output_attentions=true,它也是一个元组,它的元素是每一层的注意力权重,用于计算 self-attention heads 的加权平均值。

原理图如下:

优点:

bert的基础建立在transformer之上,拥有强大的语言表征能力和特征提取能力。在11项 nlp基准测试任务中达到state of the art。同时再次证明了双向语言模型的能力更加强大。

缺点:

1)可复现性差,基本没法做,只能拿来主义直接用!

2)训练过程中因为每个batch_size中的数据只有15%参与预测,模型收敛较慢,需要强大的算力支撑!

# coding: utf-8

import torch

import torch.nn as nn

# from pytorch_pretrained_bert import bertmodel, berttokenizer

from pytorch_pretrained import bertmodel, berttokenizer

class config(object):

"""配置参数"""

def __init__(self, dataset):

self.model_name = 'bert'

self.train_path = dataset + '/data/train.txt' # 训练集

self.dev_path = dataset + '/data/dev.txt' # 验证集

self.test_path = dataset + '/data/test.txt' # 测试集

self.class_list = [x.strip() for x in open(

dataset + '/data/class.txt').readlines()] # 类别名单

self.save_path = dataset + '/saved_dict/' + self.model_name + '.ckpt' # 模型训练结果

self.device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') # 设备

self.require_improvement = 1000 # 若超过1000batch效果还没提升,则提前结束训练

self.num_classes = len(self.class_list) # 类别数

self.num_epochs = 3 # epoch数

self.batch_size = 128 # mini-batch大小

self.pad_size = 32 # 每句话处理成的长度(短填长切)

self.learning_rate = 5e-5 # 学习率

self.bert_path = './bert_pretrain'

self.tokenizer = berttokenizer.from_pretrained(self.bert_path)

self.hidden_size = 768

class model(nn.module):

def __init__(self, config):

super(model, self).__init__()

self.bert = bertmodel.from_pretrained(config.bert_path)

for param in self.bert.parameters():

param.requires_grad = true

self.fc = nn.linear(config.hidden_size, config.num_classes)

def forward(self, x):

context = x[0] # 输入的句子

mask = x[2] # 对padding部分进行mask,和句子一个size,padding部分用0表示,如:[1, 1, 1, 1, 0, 0]

_, pooled = self.bert(context, attention_mask=mask, output_all_encoded_layers=false)

out = self.fc(pooled)

return out

终端运行下面命令,进行训练和测试:

python run.py --model bert

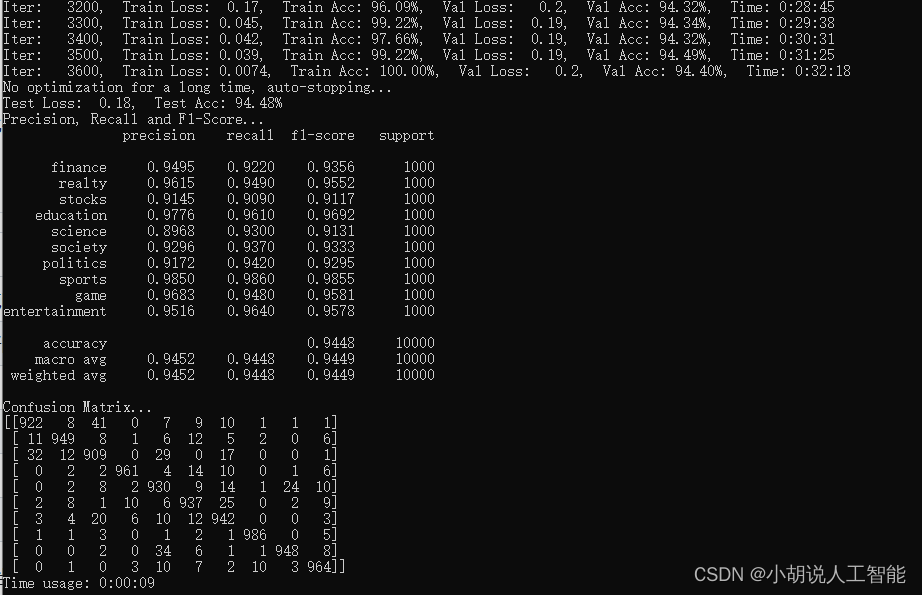

训练及测试结果如下:

使用gpu版本pytorch,耗时32分18秒,准确率94.48%

ernie

ernie(enhanced representation through knowledge integration)是百度提出的语义表示模型,同样基于transformer encoder。相较于bert,其预训练过程利用了更丰富的语义知识和更多的语义任务,在多个nlp任务上取得了比bert等模型更好的效果。

ernie 1.0

ernie 1.0是通过建模海量数据中的词、实体及实体关系,学习真实世界的语义知识。相较于bert学习原始语言信号,ernie 1.0 可以直接对先验语义知识单元进行建模,增强了模型语义表示能力。

bert模型的训练任务之一是掩码语言模型,它将单个的字(中文)、词(英文)进行随机mask标记后,去预测被mask的值。掩码语言模型使得bert具有良好的效果,但同时巨大的缺陷是将句子的字与字或词与词之间的关系拆散了。

针对bert模型的缺陷,ernie使用的掩码语言模型mask的不是单个的字或词,而是完整的词语、短语、命名实体。遮盖住后预测整体,从而使得语言模型能够训练出较好的全局信息,能够学习到非常先验的结果。

百度经过大量的训练,训练出效果较好的分词模型、短语拼接模型以及命名实体识别的模型,提前将语料中的词语进行标记。(在论文中这个思想称为:知识融合)

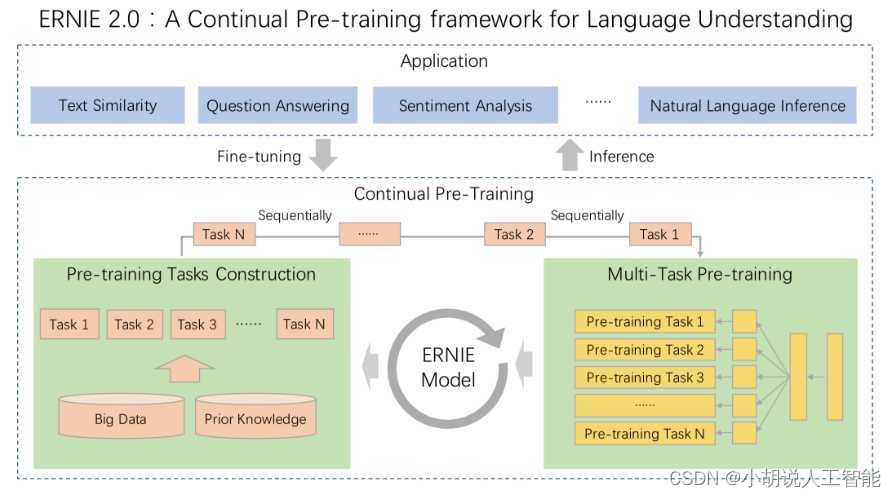

ernie2.0

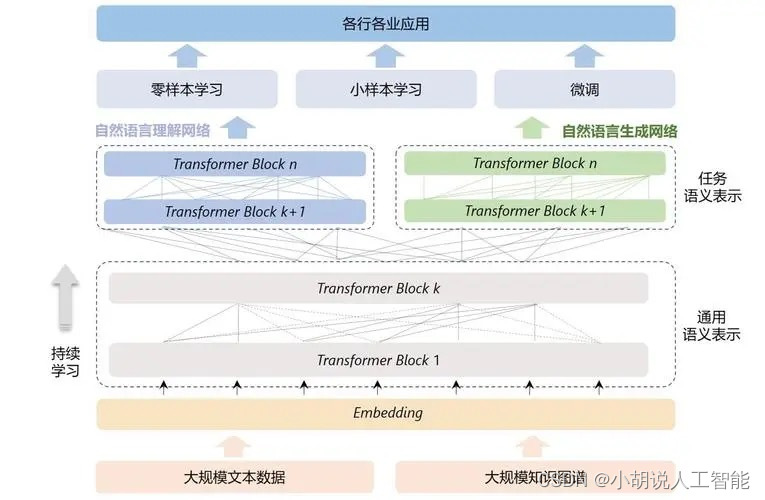

ernie 2.0的主要思想: 不断学习预料中的不同层次的任务和知识,从而去增强ernie模型语义表示的建模能力。

ernie 2.0模型将四大部分作为输入,分别为:

将四大embedding相加,最终的结果作为transformer的输入,训练不同的子任务。子任务分为三类,分别为:

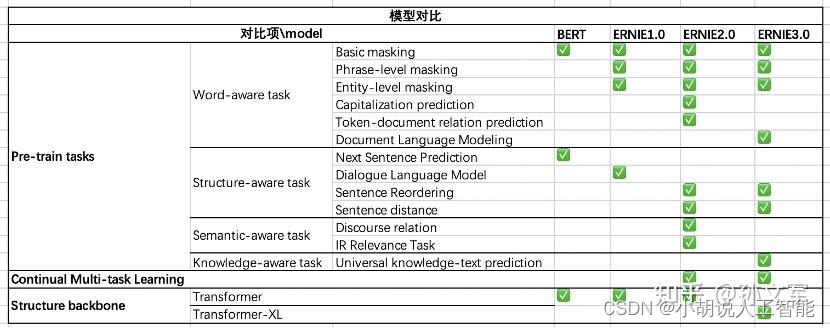

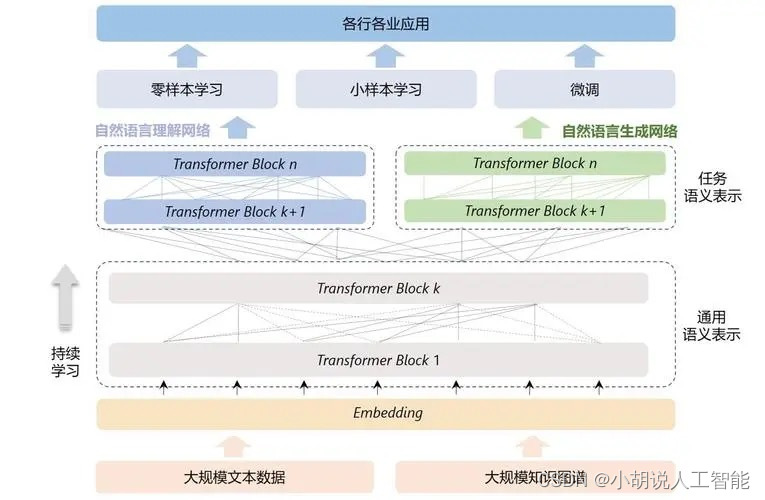

ernie 3.0

与ernie 2.0进行比较

- 相同点:

- 采用连续学习

- 采用了多个语义层级的预训练任务

- 不同点:

- ernie 3.0 transformer-xl encoder(自回归+自编码), ernie 2.0 transformer encoder(自编码)

- 预训练任务的细微差别,ernie3.0里增加的知识图谱

- ernie 3.0考虑到不同的预训练任务具有不同的高层语义,而共享着底层的语义(比如语法,词法等),为了充分地利用数据并且实现高效预训练,ernie 3.0中对采用了多任务训练中的常见做法,将不同的特征层分为了通用语义层(universal representation)和任务相关层(task-specific representation)。

对比ernie 与 bert

ernie 2.0 原理图如下:

ernie 3.0 原理图如下:

# coding: utf-8

import torch

import torch.nn as nn

# from pytorch_pretrained_bert import bertmodel, berttokenizer

from pytorch_pretrained import bertmodel, berttokenizer

class config(object):

"""配置参数"""

def __init__(self, dataset):

self.model_name = 'ernie'

self.train_path = dataset + '/data/train.txt' # 训练集

self.dev_path = dataset + '/data/dev.txt' # 验证集

self.test_path = dataset + '/data/test.txt' # 测试集

self.class_list = [x.strip() for x in open(

dataset + '/data/class.txt').readlines()] # 类别名单

self.save_path = dataset + '/saved_dict/' + self.model_name + '.ckpt' # 模型训练结果

self.device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') # 设备

self.require_improvement = 1000 # 若超过1000batch效果还没提升,则提前结束训练

self.num_classes = len(self.class_list) # 类别数

self.num_epochs = 3 # epoch数

self.batch_size = 128 # mini-batch大小

self.pad_size = 32 # 每句话处理成的长度(短填长切)

self.learning_rate = 5e-5 # 学习率

self.bert_path = './ernie_pretrain'

self.tokenizer = berttokenizer.from_pretrained(self.bert_path)

print(self.tokenizer)

self.hidden_size = 768

class model(nn.module):

def __init__(self, config):

super(model, self).__init__()

self.bert = bertmodel.from_pretrained(config.bert_path)

for param in self.bert.parameters():

param.requires_grad = true

self.fc = nn.linear(config.hidden_size, config.num_classes)

def forward(self, x):

context = x[0] # 输入的句子

mask = x[2] # 对padding部分进行mask,和句子一个size,padding部分用0表示,如:[1, 1, 1, 1, 0, 0]

_, pooled = self.bert(context, attention_mask=mask, output_all_encoded_layers=false)

out = self.fc(pooled)

return out

终端运行下面命令,进行训练和测试:

python run.py --model ernie

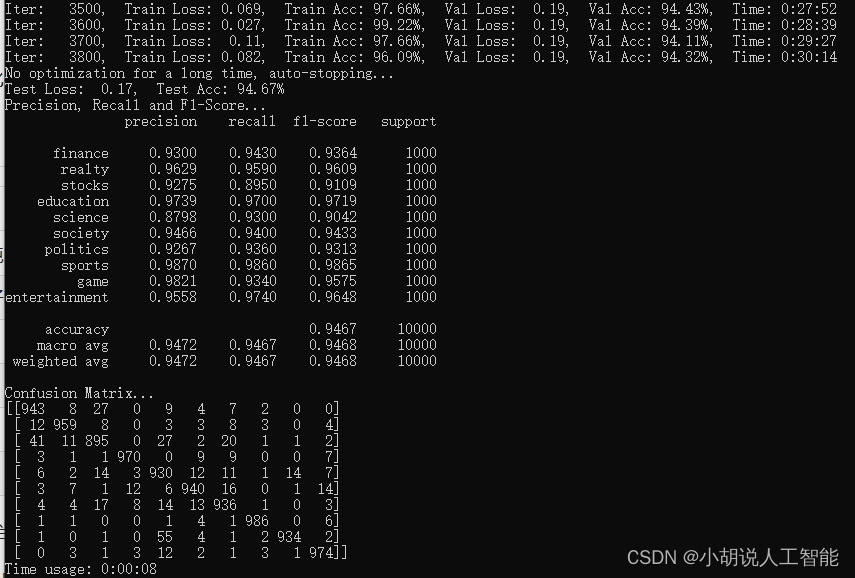

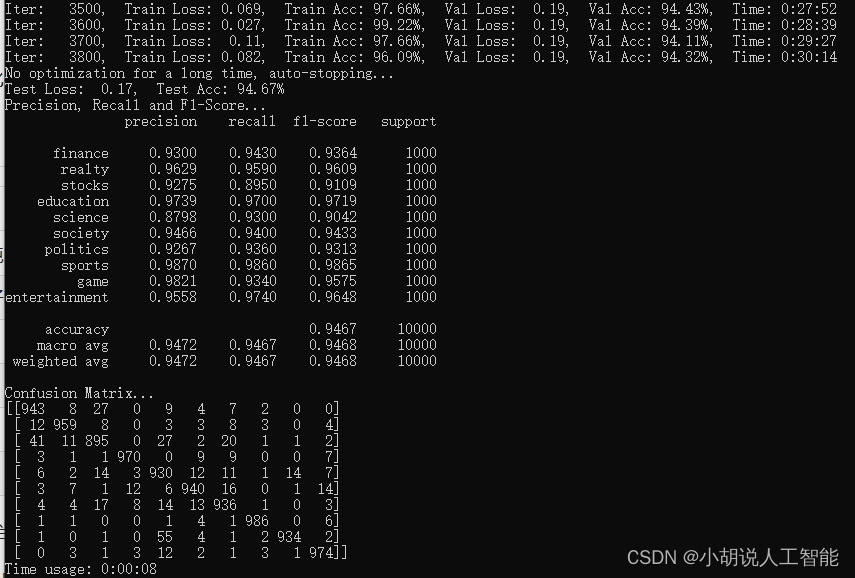

训练及测试结果如下:

使用gpu版本pytorch,耗时30分14秒,准确率94.67%

bert_cnn、bert_rnn、bert_rcnn、bert_dpcnn

模型说明

- bert_cnn:把bert当作embedding层送入cnn模型

- bert_rnn:把bert当作embedding层送入rnn模型

- bert_rcnn:把bert当作embedding层送入rcnn模型

- bert_dpcnn:把bert当作embedding层送入dpcnn模型

关于cnn、rnn、rcnn、dpcnn模型的详细说明和相关原理图,详见我另外一个博客:nlp实战:pytorch实现7大经典深度学习中文文本分类-textcnn+textrnn+fasttext+textrcnn+textrnn_attention+dpcnn+transformer

bert_cnn模型代码:

# coding: utf-8

import torch

import torch.nn as nn

import torch.nn.functional as f

from pytorch_pretrained import bertmodel, berttokenizer

class config(object):

"""配置参数"""

def __init__(self, dataset):

self.model_name = 'bert'

self.train_path = dataset + '/data/train.txt' # 训练集

self.dev_path = dataset + '/data/dev.txt' # 验证集

self.test_path = dataset + '/data/test.txt' # 测试集

self.class_list = [x.strip() for x in open(

dataset + '/data/class.txt').readlines()] # 类别名单

self.save_path = dataset + '/saved_dict/' + self.model_name + '.ckpt' # 模型训练结果

self.device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') # 设备

self.require_improvement = 1000 # 若超过1000batch效果还没提升,则提前结束训练

self.num_classes = len(self.class_list) # 类别数

self.num_epochs = 3 # epoch数

self.batch_size = 128 # mini-batch大小

self.pad_size = 32 # 每句话处理成的长度(短填长切)

self.learning_rate = 5e-5 # 学习率

self.bert_path = './bert_pretrain'

self.tokenizer = berttokenizer.from_pretrained(self.bert_path)

self.hidden_size = 768

self.filter_sizes = (2, 3, 4) # 卷积核尺寸

self.num_filters = 256 # 卷积核数量(channels数)

self.dropout = 0.1

class model(nn.module):

def __init__(self, config):

super(model, self).__init__()

self.bert = bertmodel.from_pretrained(config.bert_path)

for param in self.bert.parameters():

param.requires_grad = true

self.convs = nn.modulelist(

[nn.conv2d(1, config.num_filters, (k, config.hidden_size)) for k in config.filter_sizes])

self.dropout = nn.dropout(config.dropout)

self.fc_cnn = nn.linear(config.num_filters * len(config.filter_sizes), config.num_classes)

def conv_and_pool(self, x, conv):

x = f.relu(conv(x)).squeeze(3)

x = f.max_pool1d(x, x.size(2)).squeeze(2)

return x

def forward(self, x):

context = x[0] # 输入的句子

mask = x[2] # 对padding部分进行mask,和句子一个size,padding部分用0表示,如:[1, 1, 1, 1, 0, 0]

encoder_out, text_cls = self.bert(context, attention_mask=mask, output_all_encoded_layers=false)

out = encoder_out.unsqueeze(1)

out = torch.cat([self.conv_and_pool(out, conv) for conv in self.convs], 1)

out = self.dropout(out)

out = self.fc_cnn(out)

return out

bert_rnn模型代码:

# coding: utf-8

import torch

import torch.nn as nn

import torch.nn.functional as f

from pytorch_pretrained import bertmodel, berttokenizer

class config(object):

"""配置参数"""

def __init__(self, dataset):

self.model_name = 'bert'

self.train_path = dataset + '/data/train.txt' # 训练集

self.dev_path = dataset + '/data/dev.txt' # 验证集

self.test_path = dataset + '/data/test.txt' # 测试集

self.class_list = [x.strip() for x in open(

dataset + '/data/class.txt').readlines()] # 类别名单

self.save_path = dataset + '/saved_dict/' + self.model_name + '.ckpt' # 模型训练结果

self.device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') # 设备

self.require_improvement = 1000 # 若超过1000batch效果还没提升,则提前结束训练

self.num_classes = len(self.class_list) # 类别数

self.num_epochs = 3 # epoch数

self.batch_size = 128 # mini-batch大小

self.pad_size = 32 # 每句话处理成的长度(短填长切)

self.learning_rate = 5e-5 # 学习率

self.bert_path = './bert_pretrain'

self.tokenizer = berttokenizer.from_pretrained(self.bert_path)

self.hidden_size = 768

self.filter_sizes = (2, 3, 4) # 卷积核尺寸

self.num_filters = 256 # 卷积核数量(channels数)

self.dropout = 0.1

self.rnn_hidden = 768

self.num_layers = 2

class model(nn.module):

def __init__(self, config):

super(model, self).__init__()

self.bert = bertmodel.from_pretrained(config.bert_path)

for param in self.bert.parameters():

param.requires_grad = true

self.lstm = nn.lstm(config.hidden_size, config.rnn_hidden, config.num_layers,

bidirectional=true, batch_first=true, dropout=config.dropout)

self.dropout = nn.dropout(config.dropout)

self.fc_rnn = nn.linear(config.rnn_hidden * 2, config.num_classes)

def forward(self, x):

context = x[0] # 输入的句子

mask = x[2] # 对padding部分进行mask,和句子一个size,padding部分用0表示,如:[1, 1, 1, 1, 0, 0]

encoder_out, text_cls = self.bert(context, attention_mask=mask, output_all_encoded_layers=false)

out, _ = self.lstm(encoder_out)

out = self.dropout(out)

out = self.fc_rnn(out[:, -1, :]) # 句子最后时刻的 hidden state

return out

bert_rcnn模型代码:

# coding: utf-8

import torch

import torch.nn as nn

import torch.nn.functional as f

from pytorch_pretrained import bertmodel, berttokenizer

class config(object):

"""配置参数"""

def __init__(self, dataset):

self.model_name = 'bert'

self.train_path = dataset + '/data/train.txt' # 训练集

self.dev_path = dataset + '/data/dev.txt' # 验证集

self.test_path = dataset + '/data/test.txt' # 测试集

self.class_list = [x.strip() for x in open(

dataset + '/data/class.txt').readlines()] # 类别名单

self.save_path = dataset + '/saved_dict/' + self.model_name + '.ckpt' # 模型训练结果

self.device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') # 设备

self.require_improvement = 1000 # 若超过1000batch效果还没提升,则提前结束训练

self.num_classes = len(self.class_list) # 类别数

self.num_epochs = 3 # epoch数

self.batch_size = 128 # mini-batch大小

self.pad_size = 32 # 每句话处理成的长度(短填长切)

self.learning_rate = 5e-5 # 学习率

self.bert_path = './bert_pretrain'

self.tokenizer = berttokenizer.from_pretrained(self.bert_path)

self.hidden_size = 768

self.filter_sizes = (2, 3, 4) # 卷积核尺寸

self.num_filters = 256 # 卷积核数量(channels数)

self.dropout = 0.1

self.rnn_hidden = 256

self.num_layers = 2

class model(nn.module):

def __init__(self, config):

super(model, self).__init__()

self.bert = bertmodel.from_pretrained(config.bert_path)

for param in self.bert.parameters():

param.requires_grad = true

self.lstm = nn.lstm(config.hidden_size, config.rnn_hidden, config.num_layers,

bidirectional=true, batch_first=true, dropout=config.dropout)

self.maxpool = nn.maxpool1d(config.pad_size)

self.fc = nn.linear(config.rnn_hidden * 2 + config.hidden_size, config.num_classes)

def forward(self, x):

context = x[0] # 输入的句子

mask = x[2] # 对padding部分进行mask,和句子一个size,padding部分用0表示,如:[1, 1, 1, 1, 0, 0]

encoder_out, text_cls = self.bert(context, attention_mask=mask, output_all_encoded_layers=false)

out, _ = self.lstm(encoder_out)

out = torch.cat((encoder_out, out), 2)

out = f.relu(out)

out = out.permute(0, 2, 1)

out = self.maxpool(out).squeeze()

out = self.fc(out)

return out

bert_dpcnn模型代码:

# coding: utf-8

import torch

import torch.nn as nn

import torch.nn.functional as f

# from pytorch_pretrained_bert import bertmodel, berttokenizer

from pytorch_pretrained import bertmodel, berttokenizer

class config(object):

"""配置参数"""

def __init__(self, dataset):

self.model_name = 'bert'

self.train_path = dataset + '/data/train.txt' # 训练集

self.dev_path = dataset + '/data/dev.txt' # 验证集

self.test_path = dataset + '/data/test.txt' # 测试集

self.class_list = [x.strip() for x in open(

dataset + '/data/class.txt').readlines()] # 类别名单

self.save_path = dataset + '/saved_dict/' + self.model_name + '.ckpt' # 模型训练结果

self.device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') # 设备

self.require_improvement = 1000 # 若超过1000batch效果还没提升,则提前结束训练

self.num_classes = len(self.class_list) # 类别数

self.num_epochs = 3 # epoch数

self.batch_size = 128 # mini-batch大小

self.pad_size = 32 # 每句话处理成的长度(短填长切)

self.learning_rate = 5e-5 # 学习率

self.bert_path = './bert_pretrain'

self.tokenizer = berttokenizer.from_pretrained(self.bert_path)

self.hidden_size = 768

self.num_filters = 250 # 卷积核数量(channels数)

class model(nn.module):

def __init__(self, config):

super(model, self).__init__()

self.bert = bertmodel.from_pretrained(config.bert_path)

for param in self.bert.parameters():

param.requires_grad = true

# self.fc = nn.linear(config.hidden_size, config.num_classes)

self.conv_region = nn.conv2d(1, config.num_filters, (3, config.hidden_size), stride=1)

self.conv = nn.conv2d(config.num_filters, config.num_filters, (3, 1), stride=1)

self.max_pool = nn.maxpool2d(kernel_size=(3, 1), stride=2)

self.padding1 = nn.zeropad2d((0, 0, 1, 1)) # top bottom

self.padding2 = nn.zeropad2d((0, 0, 0, 1)) # bottom

self.relu = nn.relu()

self.fc = nn.linear(config.num_filters, config.num_classes)

def forward(self, x):

context = x[0] # 输入的句子

mask = x[2] # 对padding部分进行mask,和句子一个size,padding部分用0表示,如:[1, 1, 1, 1, 0, 0]

encoder_out, text_cls = self.bert(context, attention_mask=mask, output_all_encoded_layers=false)

x = encoder_out.unsqueeze(1) # [batch_size, 1, seq_len, embed]

x = self.conv_region(x) # [batch_size, 250, seq_len-3+1, 1]

x = self.padding1(x) # [batch_size, 250, seq_len, 1]

x = self.relu(x)

x = self.conv(x) # [batch_size, 250, seq_len-3+1, 1]

x = self.padding1(x) # [batch_size, 250, seq_len, 1]

x = self.relu(x)

x = self.conv(x) # [batch_size, 250, seq_len-3+1, 1]

while x.size()[2] > 2:

x = self._block(x)

x = x.squeeze() # [batch_size, num_filters(250)]

x = self.fc(x)

return x

def _block(self, x):

x = self.padding2(x)

px = self.max_pool(x)

x = self.padding1(px)

x = f.relu(x)

x = self.conv(x)

x = self.padding1(x)

x = f.relu(x)

x = self.conv(x)

x = x + px # short cut

return x

终端运行下面命令,进行训练和测试:

python run.py --model <模型名称>

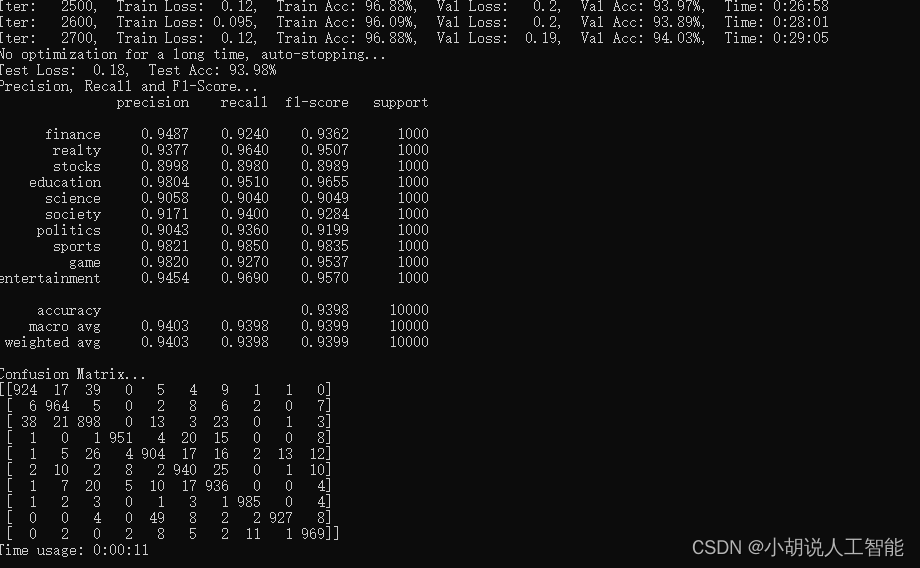

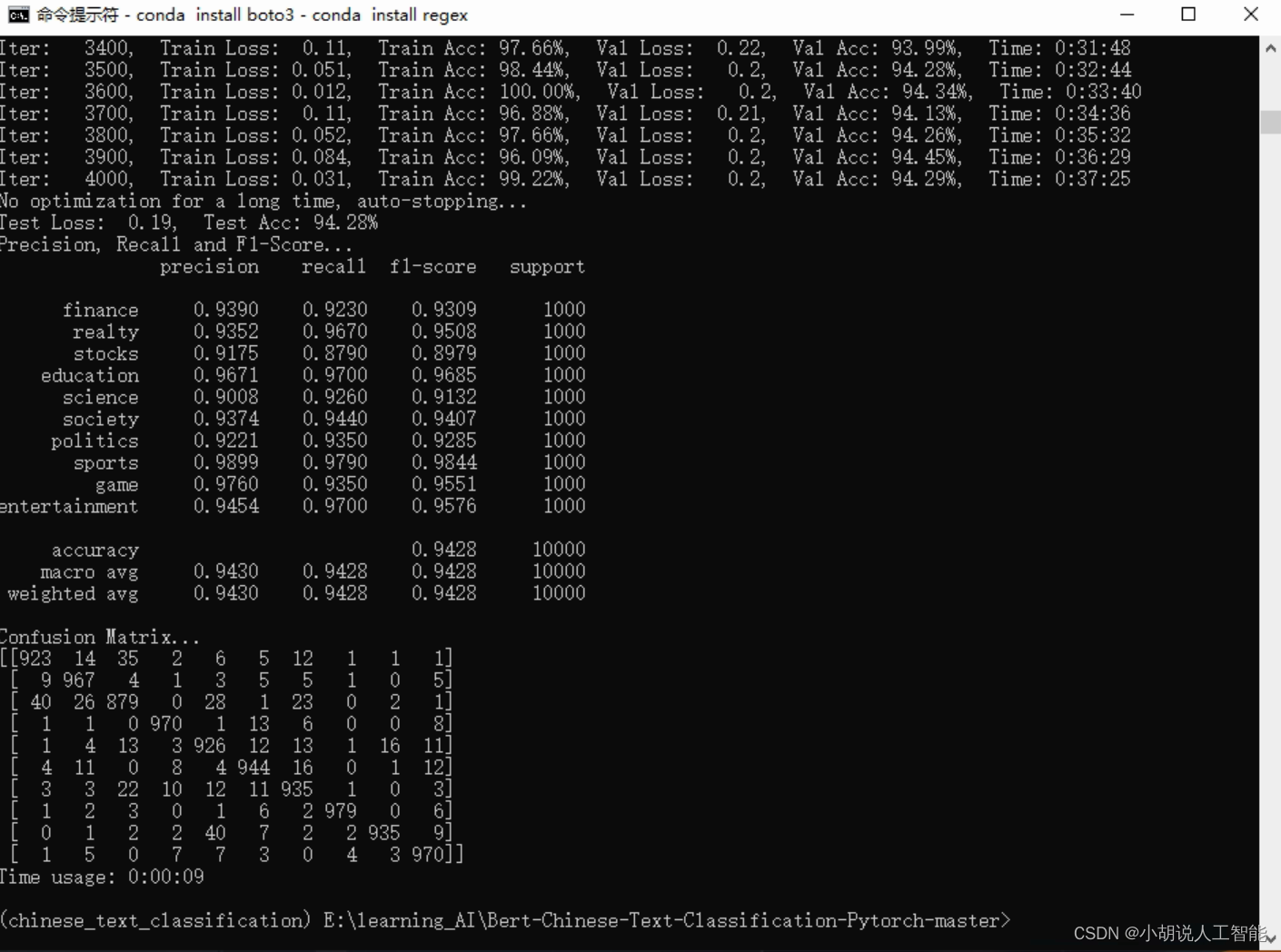

使用gpu版本pytorch,bert_cnn、bert_rnn、bert_rcnn、bert_dpcnn的训练及测试结果分别如下:

bert_cnn:

bert_rnn:

bert_rcnn:

bert_dpcnn:

各模型效果对比

| 模型 | acc | 备注 |

|---|---|---|

| bert | 94.48% | bert + fc |

| ernie | 94.67% | 使用的是ernie 1.0,比bert略好(不像传闻中的中文碾压bert) |

| bert_cnn | 94.67% | bert+经典cnn文本分类 |

| bert_rnn | 93.98% | bert+bilstm |

| bert_rcnn | 94.61% | bert+bilstm+池化 |

| bert_dpcnn | 94.28% | bert+深层金字塔cnn |

参考资料

其它资料下载

如果大家想继续了解人工智能相关学习路线和知识体系,欢迎大家翻阅我的另外一篇博客《重磅 | 完备的人工智能ai 学习——基础知识学习路线,所有资料免关注免套路直接网盘下载》

这篇博客参考了github知名开源平台,ai技术平台以及相关领域专家:datawhale,apachecn,ai有道和黄海广博士等约有近100g相关资料,希望能帮助到所有小伙伴们。

](/images/newimg/nimg6.png)

发表评论