华为云耀云服务器l实例-spark的配置-中下

产品官网:云耀云服务器l实例 _【最新】_轻量云服务器_轻量服务器_轻量应用服务器-华为云

今天我们采用可靠更安全、智能不卡顿、价优随心用、上手更简单、管理特省心的华为云耀云服务器l实例为例,继续教程的介绍。

项目源代码地址:https://github.com/lenve/vhr

apache spark 是一个快速、通用的大数据处理引擎,旨在提供简单、高效、通用的数据处理平台。spark 提供了一种基于内存的计算模型,支持复杂的数据处理任务,包括批处理、交互式查询、流处理和机器学习。

以下是 apache spark 的主要特点和组件:

1. 快速性能: spark 使用内存计算和弹性分布式数据集(resilient distributed dataset,简称 rdd)来提供高性能的数据处理。它支持迭代计算,适用于需要多次迭代的机器学习算法。

2. 通用性: spark 提供了统一的数据处理平台,支持多种数据处理任务,包括批处理(spark core)、交互式查询(spark sql)、流处理(spark streaming)和机器学习(mllib)。

3. 易用性: spark 提供了丰富的 api,包括 scala、java、python 和 r,使开发者能够使用自己熟悉的编程语言进行大数据处理。它还提供了交互式的 shell 界面(spark shell)用于实时测试和调试。

4. 弹性分布式数据集(rdd): rdd 是 spark 中的核心抽象,代表了可并行操作的不可变分布式集合。rdd 具有容错性,如果节点发生故障,可以重新计算丢失的数据。

5. spark生态系统: spark 生态系统包括许多附加组件,如 spark sql(用于结构化数据处理)、spark streaming(用于实时数据处理)、mllib(用于机器学习)、graphx(用于图处理)等,丰富了 spark 的功能。

6. 分布式调度器: spark 使用自己的分布式调度器,称为 standalone 调度器,也可以与其他调度器集成,如 apache mesos、hadoop yarn。

7. 开源社区: spark 是一个开源项目,拥有庞大的用户社区和活跃的开发者社区,不断推动 spark 的发展和改进。

apache spark 在大规模数据处理、机器学习和图计算等方面都取得了显著的成功,成为大数据处理领域的主要工具之一。其灵活性、性能和丰富的功能使得它适用于各种大数据处理场景。

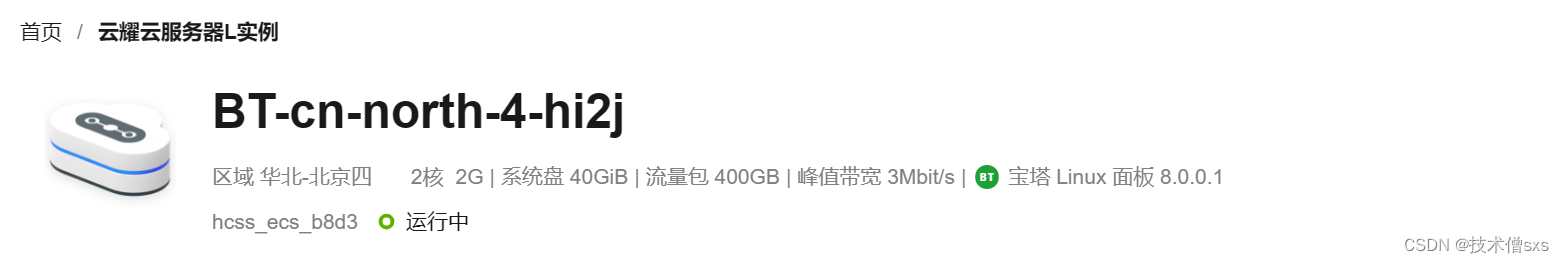

以下是在华为云耀云服务器l实例上配置完毕spark后,在 单机模式上运行wordcount。请注意,这里提供的步骤是基于spark 2.12.8版本,你可以根据实际情况修改版本号。

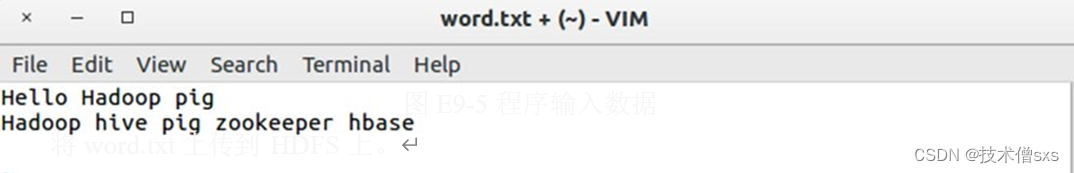

首先创建 word.txt 文件,其内容如下:

(1)wordcount 的 scala 版本,进入 spark 目录。

[yhadoop@主机名 spark-z-bin-hadoop1]$ ./bin/spark-shell --master local[2] scala>val file=sc.textfile("hdfs://node1:9000/wordcount/word.txt")

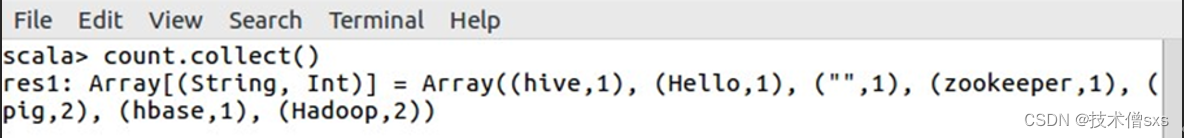

scala>valcount=file.flatmap(line=>line.split(" ")).map(word=>(word,1)).reducebykey(_+_)

运行结果如下:

rest0: array[(string,int)]=aray((hello,1),(hadoop,2),(hive,1),(zookeeper,1),(pig,2),(hbase,1))

【控制台运行结果】

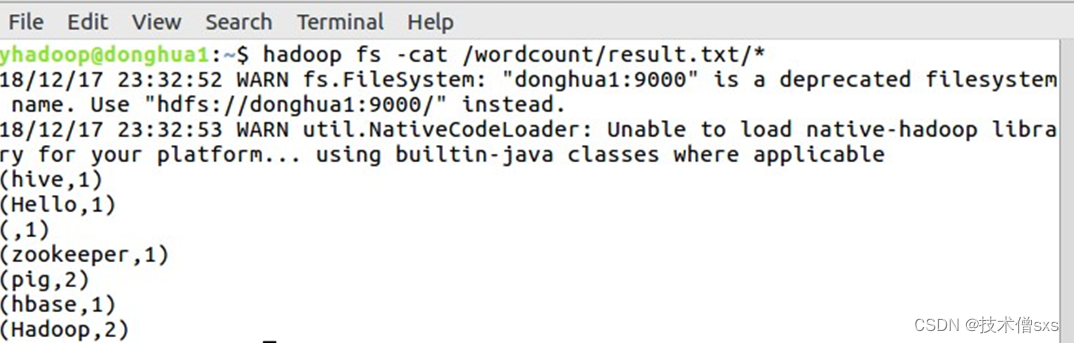

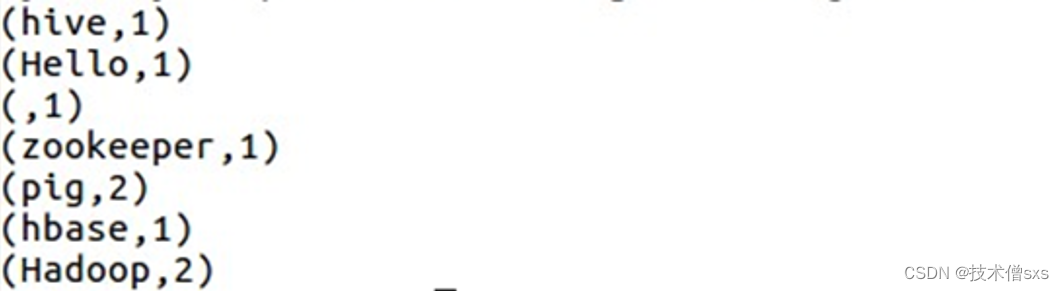

scala>count.saveastextfile("hdfs://node1:9000/wordcount/result.txt")

【运行结果保存到文件中】

【scala 运行结果】

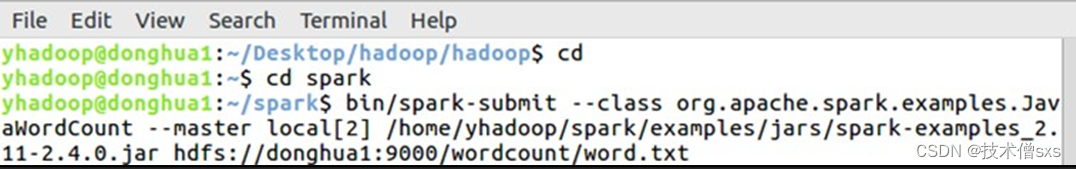

(2)wordcount 的java 版本

执行下面命令,其中--class 指定主类,--master 指定 spark master 地址,后面是执行的jar 和需要的参数,这里指定输入文件从hdfs 里读取,也可以从本地读取。

使用以下命令:

bin/spark-submit --master spark://node1:7077 /home/yhadoop/spark/examples/jars/spark- examples_2.11-2.4.0.jarhdfs://node1:9000/wordcount/word.txt

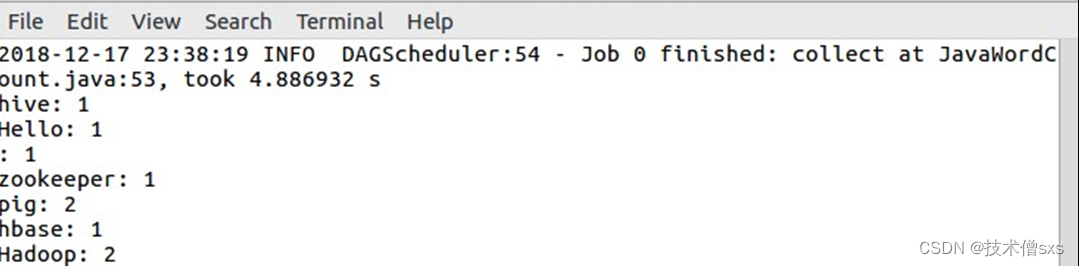

控制台结果如下:

本次记录中,我们在华为云耀云服务器l实例上完成了spark最基础的计数功能程序的运行,这是绝大多数大数据基础服务在云服务器上运行的基础。接下来,我们将顺带了解一下spark的集群部署步骤,在有多台条件的前提下能够完成集群的部署。

发表评论