第1关:配置开发环境 - javajdk的配置

第2关:配置开发环境 - hadoop安装与伪分布式集群搭建

第3关:hdfs系统初体验

第1关:配置开发环境 - javajdk的配置:

解压:

mkdir /app

cd /opt

tar -zxvf jdk-8u171-linux-x64.tar.gz

mv jdk1.8.0_171/ /app配置环境变量:

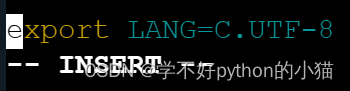

vim /etc/profile细节:vi/vim是一个全屏幕的文本编辑器。输入i进入插入模式(图1)。!!!输入完成后!!!,我们先按esc退出,输入 :wq (保存退出)然后enter就行了(图2)。

图1:

图2:

详细可看:linux文本编辑器---vim详解_llinux vim_卖寂寞的小男孩的博客-csdn博客

输入内容如下:输入位置为文本内容末尾另起一行

java_home=/app/jdk1.8.0_171

classpath=.:$java_home/lib/tools.jar

path=$java_home/bin:$path

export java_home classpath path通过下面的命令行:使上面的配置生效

source /etc/profilejava -version评测!

第2关:配置开发环境 - hadoop安装与伪分布式集群搭建:

cd /opt ll

tar -zxvf hadoop-3.1.0.tar.gz -c /app

cd /app

mv hadoop-3.1.0/ hadoop3.1

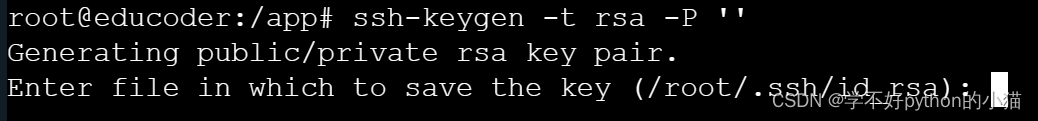

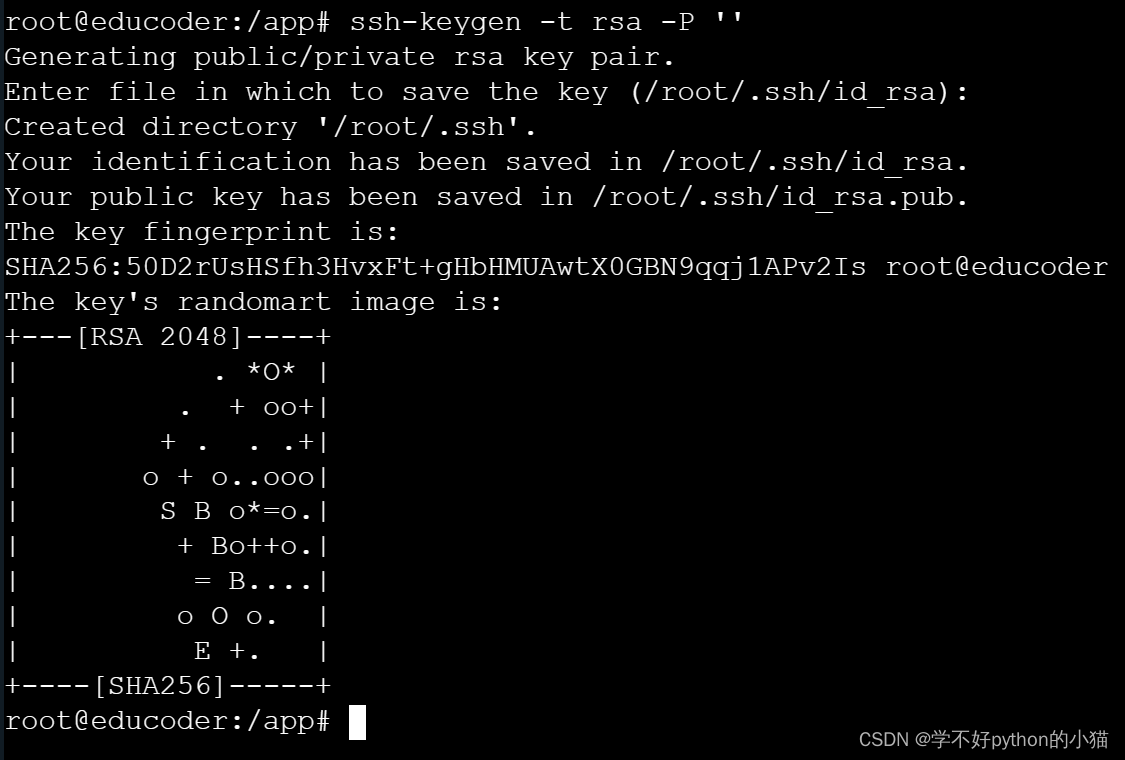

ssh-keygen -t rsa -p ''

#两次回车 图3 图4图3:

图4:

图4:

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keysvim /etc/ssh/sshd_config

rsaauthentication yes # 启用 rsa 认证

pubkeyauthentication yes # 启用公钥私钥配对认证方式

authorizedkeysfile %h/.ssh/authorized_keys # 公钥文件路径

cd /app/hadoop3.1/etc/hadoop

vim hadoop-env.sh

export java_home=/app/jdk1.8.0_171

vim yarn-env.sh

export java_home=/app/jdk1.8.0_171

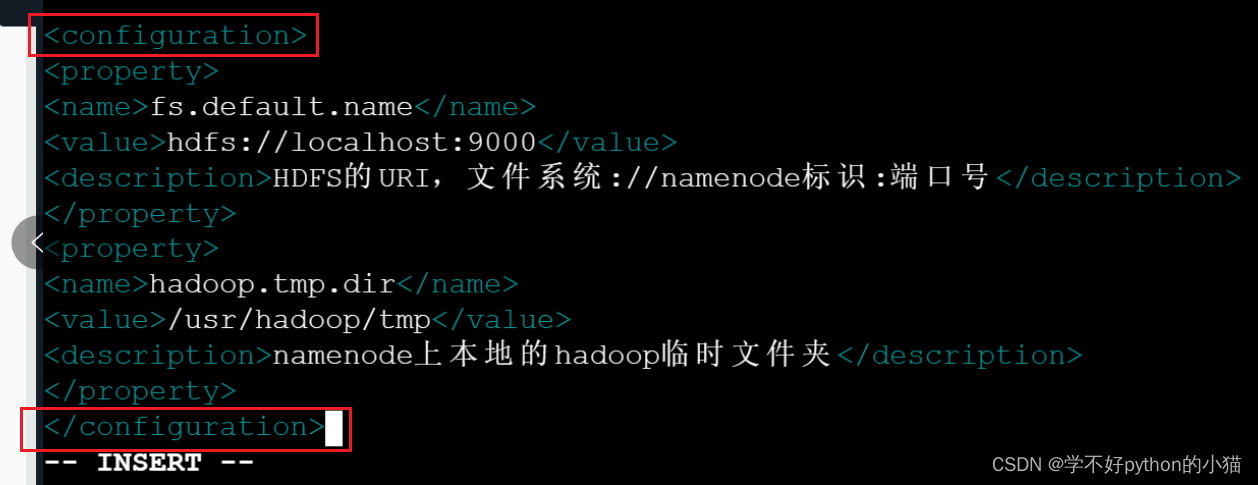

vim core-site.xml

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

<description>hdfs的uri,文件系统://namenode标识:端口号</description>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/tmp</value>

<description>namenode上本地的hadoop临时文件夹</description>

</property>

vim hdfs-site.xml

<property>

<name>dfs.name.dir</name>

<value>/usr/hadoop/hdfs/name</value>

<description>namenode上存储hdfs名字空间元数据 </description>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/hadoop/hdfs/data</value>

<description>datanode上数据块的物理存储位置</description>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

vim mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

vim yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>192.168.2.10:8099</value>

<description>这个地址是mr管理界面的</description>

</property>

将hadoop添加到环境变量中并设置root用户可以启动hadoop

mkdir /usr/hadoop

mkdir /usr/hadoop/tmp

mkdir /usr/hadoop/hdfs

mkdir /usr/hadoop/hdfs/data

mkdir /usr/hadoop/hdfs/namevim /etc/profile

# 在文件末尾插入下面代码:

#set hadoop environment

export hadoop_home=/app/hadoop3.1

export path=$path:$hadoop_home/bin:$hadoop_home/sbin

source /etc/profilehadoop namenode -format

cd /app/hadoop3.1/sbin

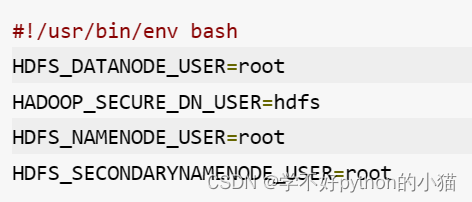

vim start-dfs.sh

hdfs_datanode_user=root

hadoop_secure_dn_user=hdfs

hdfs_namenode_user=root

hdfs_secondarynamenode_user=root vim stop-dfs.sh

hdfs_datanode_user=root

hadoop_secure_dn_user=hdfs

hdfs_namenode_user=root

hdfs_secondarynamenode_user=rootvim start-yarn.sh

yarn_resourcemanager_user=root

hadoop_secure_dn_user=yarn

yarn_nodemanager_user=rootvim stop-yarn.sh

yarn_resourcemanager_user=root

hadoop_secure_dn_user=yarn

yarn_nodemanager_user=root原神启动,不对hadoop启动:

start-dfs.sh

jps

评测!

第3关:hdfs系统初体验:

start-dfs.sh

hadoop fs -mkdir /task

hadoop fs -ls /

touch task.txtvim task.txt

hello educoderhello educoder输入完后,退出vim文本编辑器后再输入下面的内容

hadoop fs -put task.txt /task

hadoop fs -cat /task/task.txt评测!

辛苦了家人们,通过了请点点赞吧(・゚・(。>ω<。)・゚・)

参考链接:http://t.csdn.cn/u6tei 不过他没我的细哦(>_<)

发表评论