目录

三、nvidia显卡a100、rtx a6000和rtx 4090对比

一、关键术语

tensor cores (张量核心)

tensor core 可实现混合精度计算,并能根据精度的降低动态调整算力,在保持准确性的同时提高吞吐量。新一代 tensor core 扩大了这种加速的应用范围,覆盖 ai 和 hpc 领域的各种工作负载。

cuda cores(cuda内核)

cuda核心(compute unified device architecture core)是nvidia图形处理器(gpu)上的计算单元,用于执行并行计算任务。每个cuda核心可以执行单个线程的指令,包括算术运算、逻辑操作和内存访问等。

memory bandwidth(内存带宽)

内存带宽是处理器可以从内存读取数据或将数据存储到内存的速率。内存带宽通常以字节/秒为单位表示,但对于自然数据大小不是8位的倍数的系统,这可能会有所不同。

二、深度学习的显卡硬件要求

深度学习的显卡硬件要求包括高cuda核心数量、大容量显存、高内存带宽等。以下从多个方面详细分析这些要求:

- 高cuda核心数量:cuda核心是nvidia gpu中用于并行处理的核心,对于深度学习任务来说,更多的cuda核心意味着更高的并行计算能力,从而能够提高模型训练和推理的速度。

- 大容量显存:深度学习模型通常需要处理大量数据,因此显存容量至关重要。足够的显存不仅可以存储更大的模型和数据集,还可以支持更大的批量大小,从而提高训练效率。

- 高内存带宽:显存带宽决定了gpu访问数据的速度。高带宽有利于提高数据处理速度,尤其是在处理大规模数据时。例如,nvidia rtx a6000拥有768gb/s的显存带宽,可以高效处理复杂数据集。

- 支持高精度浮点运算:深度学习模型训练通常需要单精度(fp32)或半精度(fp16)浮点运算能力。一些新一代gpu还支持混合精度训练,可以进一步加速训练过程。

- 良好的散热系统:深度学习训练时,gpu会产生大量热量,因此需要一个有效的散热系统来保持硬件在合理温度下运行,以保障系统稳定及性能发挥。使用pcie扩展器为多gpu系统创造更多空间可以有效改善散热效果。

- 功耗与电源需求:高性能gpu需要足够功率的电源支持,并且需要确保电源有合适的接口。正确的电源连接可以避免像rtx 40系列那样的电源连接器问题。

三、nvidia显卡a100、rtx a6000和rtx 4090对比

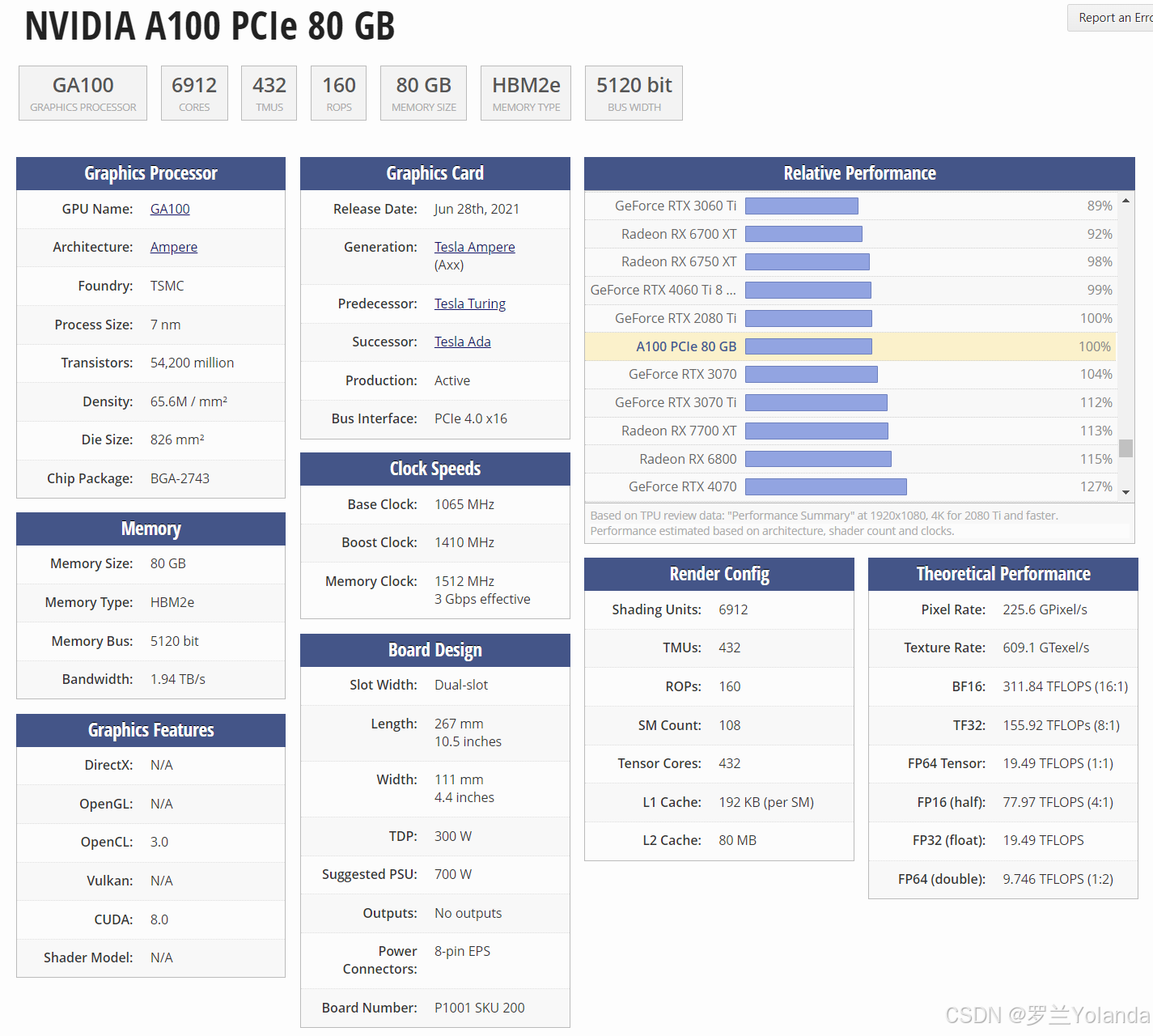

1、nvidia a100

-ampere架构:a100基于nvidia的ampere体系结构,与前几代相比,性能有了显著提高。它具有先进的张量核心,可以加速深度学习计算,从而加快训练和推理时间。

-高性能:a100是一款高性能gpu,具有大量cuda内核、张量内核和内存带宽。它可以处理复杂的深度学习模型和大型数据集,为训练和推理工作负载提供卓越的性能。

-增强型混合精度训练:a100支持混合精度训练,它结合了不同的数字精度(如fp16和fp32),以优化性能和内存利用率。这可以在保持准确性的同时加速深度学习训练。

-高内存容量:由于采用了hbm2内存技术,a100可提供高达80gb的超大内存容量。这允许在不受内存限制的情况下处理大型模型和处理大型数据集。

-多实例gpu(mig)功能:a100引入了多实例gpu技术,该技术允许将单个gpu划分为多个较小的实例,每个实例都有专用的计算资源。此功能使gpu能够高效利用,同时运行多个深度学习工作负载。

这些功能使nvidia a100成为深度学习任务的绝佳选择。它提供了高性能、先进的人工智能能力、大内存容量和计算资源的高效利用,所有这些对于训练和运行复杂的深度神经网络都至关重要。

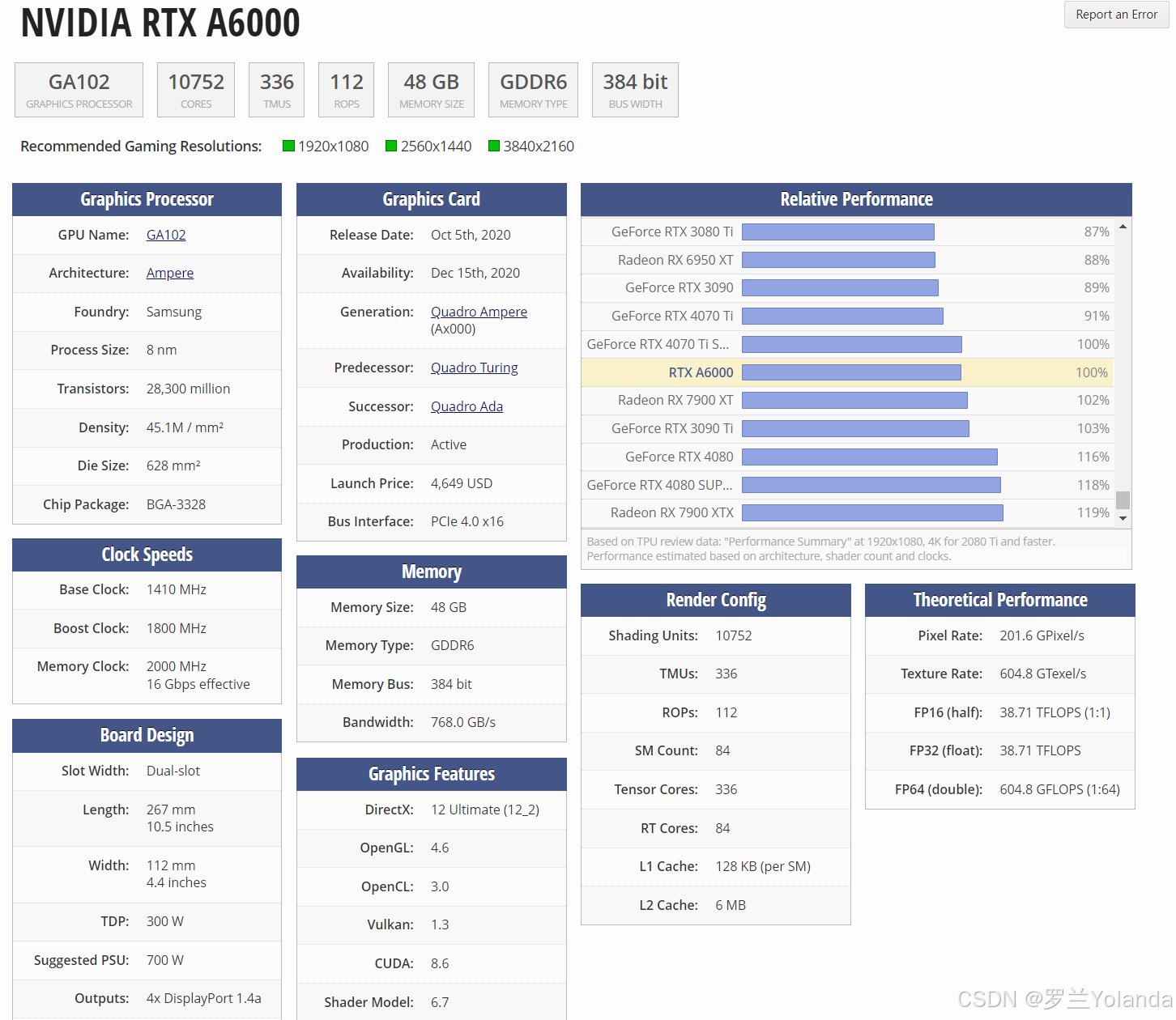

2、nvidia rtx a6000

-ampere架构:rtx a6000基于nvidia的ampere体系结构,与前几代相比,性能有了显著提高。它具有用于ai加速的高级张量核心、增强的光线跟踪功能和增加的内存带宽。

-高性能:rtx a6000提供大量cuda内核、张量内核和光线跟踪内核,从而实现快速高效的深度学习性能。它可以处理大规模的深度学习模型和训练神经网络所需的复杂计算。

-大内存容量:rtx a6000配备48 gb gddr6内存,为存储和处理大型数据集提供充足的内存空间。具有大的内存容量有利于训练需要大量内存的深度学习模型。

-人工智能功能:rtx a6000包括专用张量核心,可加速人工智能计算并实现混合精度训练。这些张量核可以通过加速执行矩阵乘法等运算,显著加快深度学习工作负载。

虽然rtx a6000主要是为专业应用程序设计的,但它肯定可以有效地用于深度学习任务。其高性能、内存容量和人工智能特有的功能使其成为训练和运行深度神经网络的强大选择。

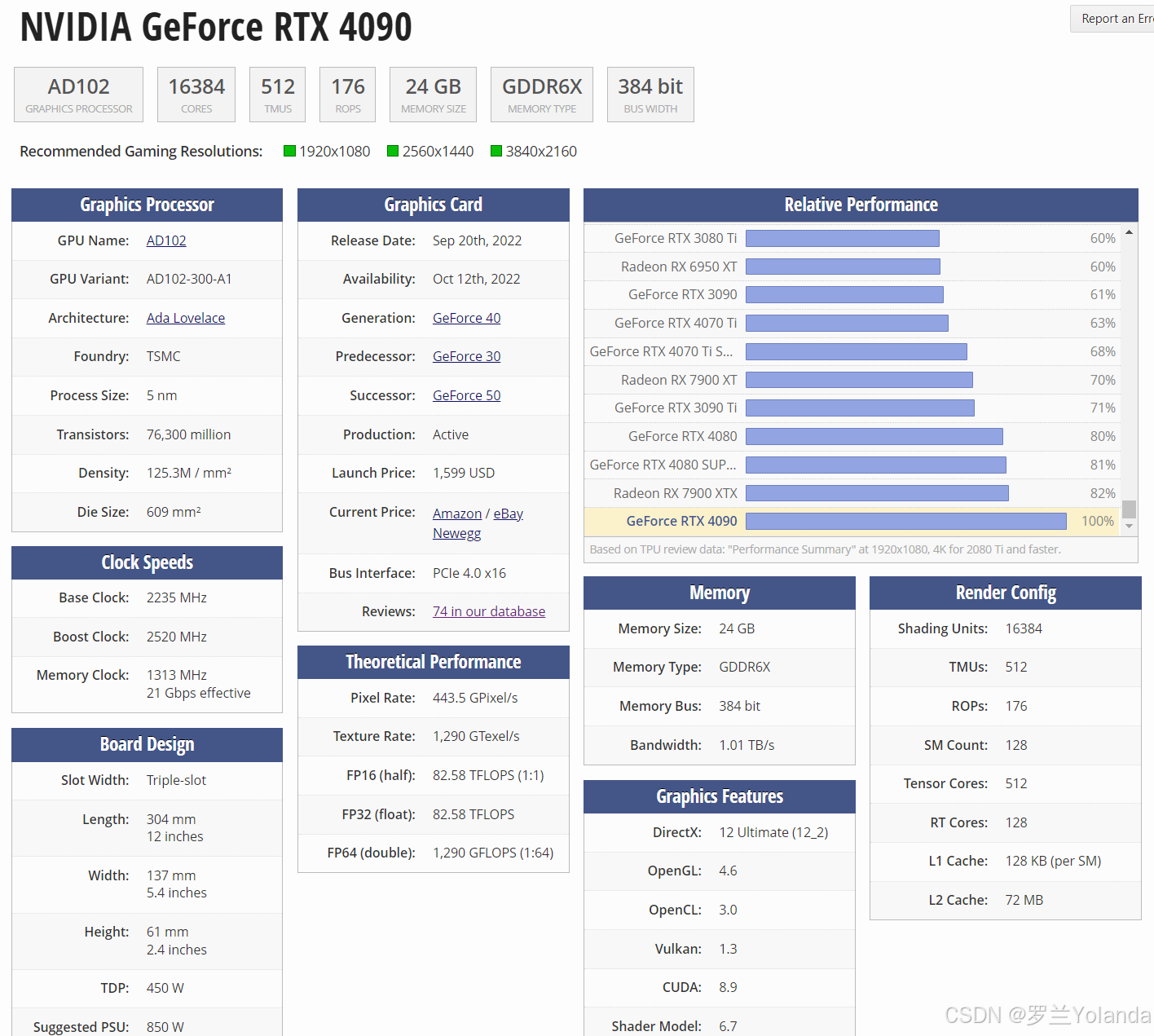

3、nvidia rtx 4090

nvidia geforce rtx 4090是一款功能强大的消费级显卡,可用于深度学习,但它不像英伟达a100或rtx a6000等专业gpu那样适合这项任务。

rtx 4090用于深度学习的优势:

-大量的cuda内核:rtx 4090有16384个cuda内核,这些内核是负责执行深度学习计算的处理单元。

-高内存带宽:rtx 4090的内存带宽为1 tb/s,可以快速在内存之间传输数据。

-大内存容量:rtx 4090具有24gb的gddr6x内存,足以训练中小型深度学习模型。

-对cuda和cudnn的支持:rtx 4090完全由nvidia的cuda和cudnn库支持,这对开发和优化深度学习模型至关重要。

rtx 4090用于深度学习的缺点:

-内存容量较低:rtx 4090的24gb内存对于中小型模型来说是足够的,但对于训练大型模型或使用大型数据集来说可能会受到限制。

-缺乏nvlink支持:rtx 4090不支持nvlink,这是一种高速互连技术,允许多个gpu连接在一起以扩展性能。这使得rtx 4090不太适合构建大规模深度学习集群。

-功耗高达450w:由于其高功耗,通常需要更强的冷却系统来保持稳定运行。游戏显卡在设计时重视成本效益,因此其散热器和供电设计虽然能满足日常需求,但在极端条件下可能不如专业显卡稳定。

总体而言,rtx 4090是一款能够进行深度学习的gpu,但它不如英伟达a100或rtx a6000等专业gpu那样适合这项任务。如果你认真对待深度学习并要求尽可能高的性能,专业gpu是更好的选择。然而,如果你有预算,或者只需要训练中小型型号,rtx 4090可能是一个不错的选择。

声明:(内容仅供参考,具体请咨询厂商)

发表评论